Oleh Jawad

Dalam posting blog ini, kita akan menjelajahi cara menyiapkan dan menjalankan model Qwen 0.5 Sumber Terbuka Alibaba Cloud menggunakan Ollama dan Open WebUI di instans ECS. Setelah selesai, kita akan dapat menggunakan kemampuan model Qwen melalui antarmuka web yang ramah pengguna. Berikut adalah videonya:

Untuk demo sederhana ini, saya menggunakan ecs.g7.large (2 Core, RAM 8 GB). Namun, ketika memilih instans ECS, pertimbangkan faktor utama untuk beban kerja AI ini:

• CPU/GPU: Cari instans dengan jumlah vCPU yang lebih tinggi dan gunakan GPU untuk komputasi model yang efisien.

• Memory: Model seperti Qwen bisa jadi perlu memori yang besar; cari yang lebih besar dari yang saya gunakan di sini.

• Penyimpanan: Penyimpanan berbasis SSD akan meningkatkan kecepatan baca/tulis yang sangat penting untuk pemuatan model.

• Bandwidth: Pastikan bandwidth yang memadai agar interaksi melalui Open-WebUI berjalan lancar.

Ikuti langkah-langkah ini untuk membuat instans Anda:

Gunakan SSH untuk terhubung:

ssh root@<your-instance-public-ip>Perbarui dan instal Docker:

apt update

apt install docker.io

apt install docker-composeBuat file docker-compose.yml menggunakan editor nano atau vi:

version: '3.8'

services:

ollama:

image: ollama/ollama

container_name: ollama

volumes:

- ollama:/root/.ollama

ports:

- "11434:11434"

restart: always

open-webui:

image: ghcr.io/open-webui/open-webui:ollama

container_name: open-webui

volumes:

- ollama:/root/.ollama

- open-webui:/app/backend/data

ports:

- "3000:8080"

restart: always

volumes:

ollama:

open-webui:Simpan ini di atas ke dalam file bernama docker-compose.yml di direktori dan layanan yang Anda inginkan menggunakan:

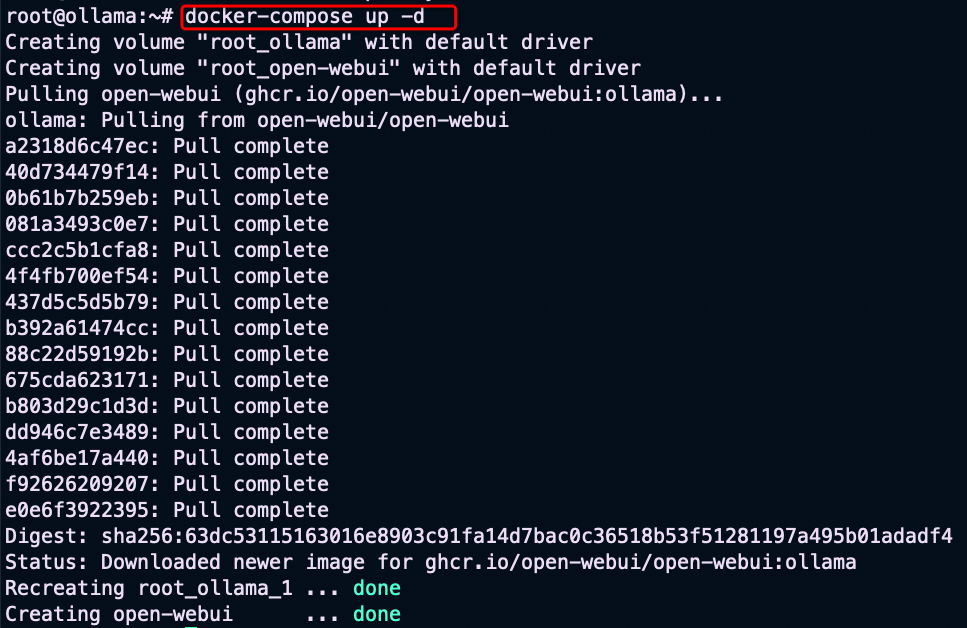

docker-compose up -d

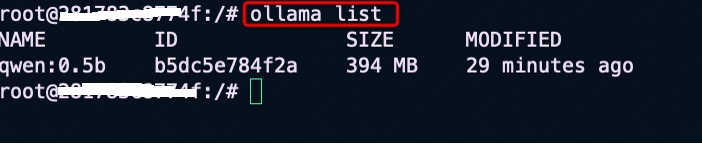

Untuk mengakses Ollama Container dan menarik model Qwen 0.5, masuk dahulu ke kontainer Ollama dengan mengetikkan yang berikut:

docker exec -it ollama /bin/bashSetelah berada di dalam kontainer, jalankan perintah berikut untuk menarik model Qwen 0.5:

ollama pull qwen:0.5Setelah selesai, pastikan model Qwen tersedia, gunakan daftar ollama.

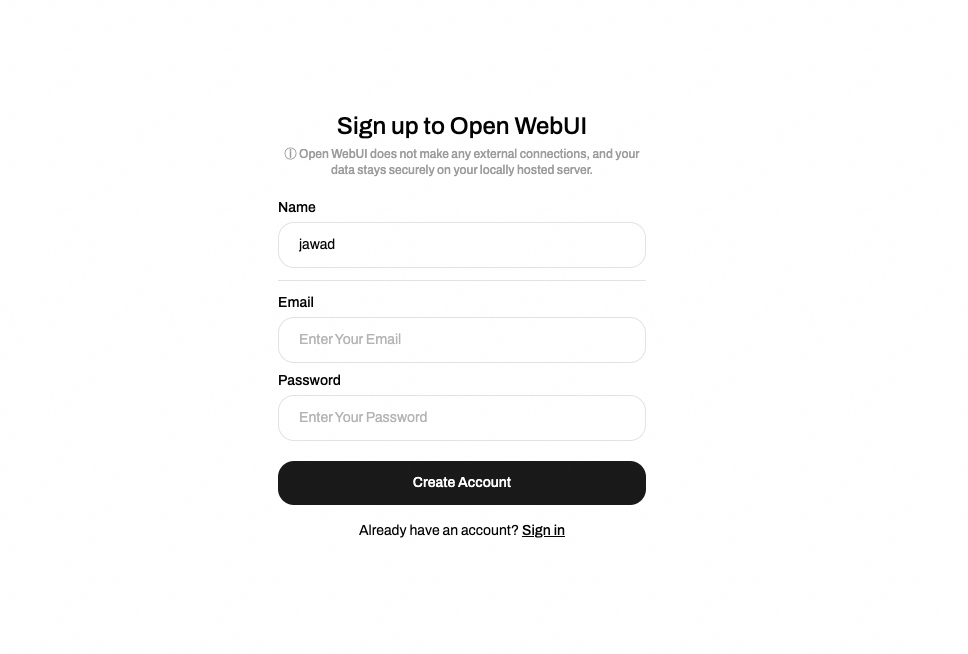

• Akses Publik ECS: Dengan IP publik dan aturan grup keamanan tersedia, siapa pun dapat mengakses Open-WebUI Anda dengan membuka http://:3000`. Gunakan pendaftaran dengan memasukkan Nama, Email, dan Kata Sandi seperti yang ditunjukkan di bawah ini:

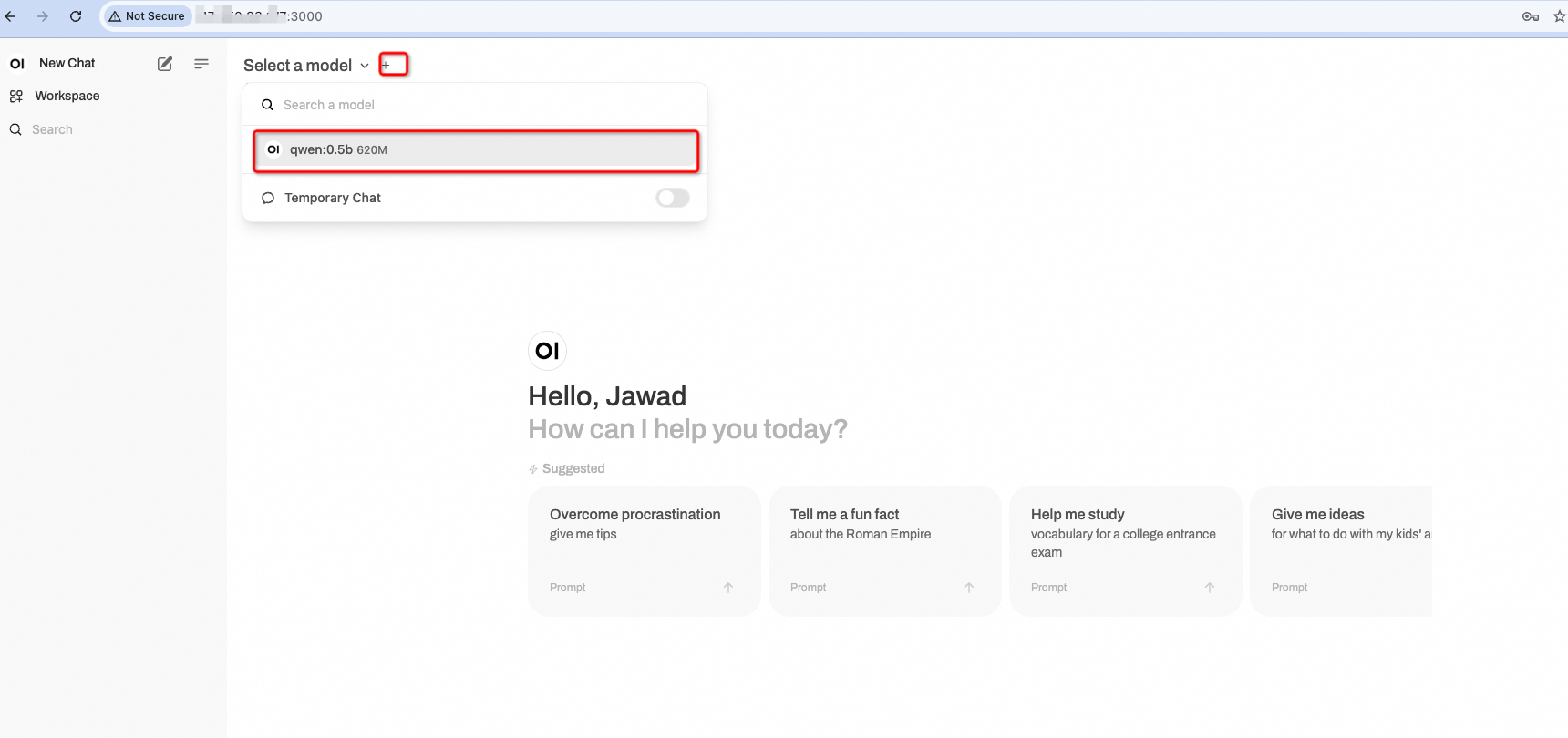

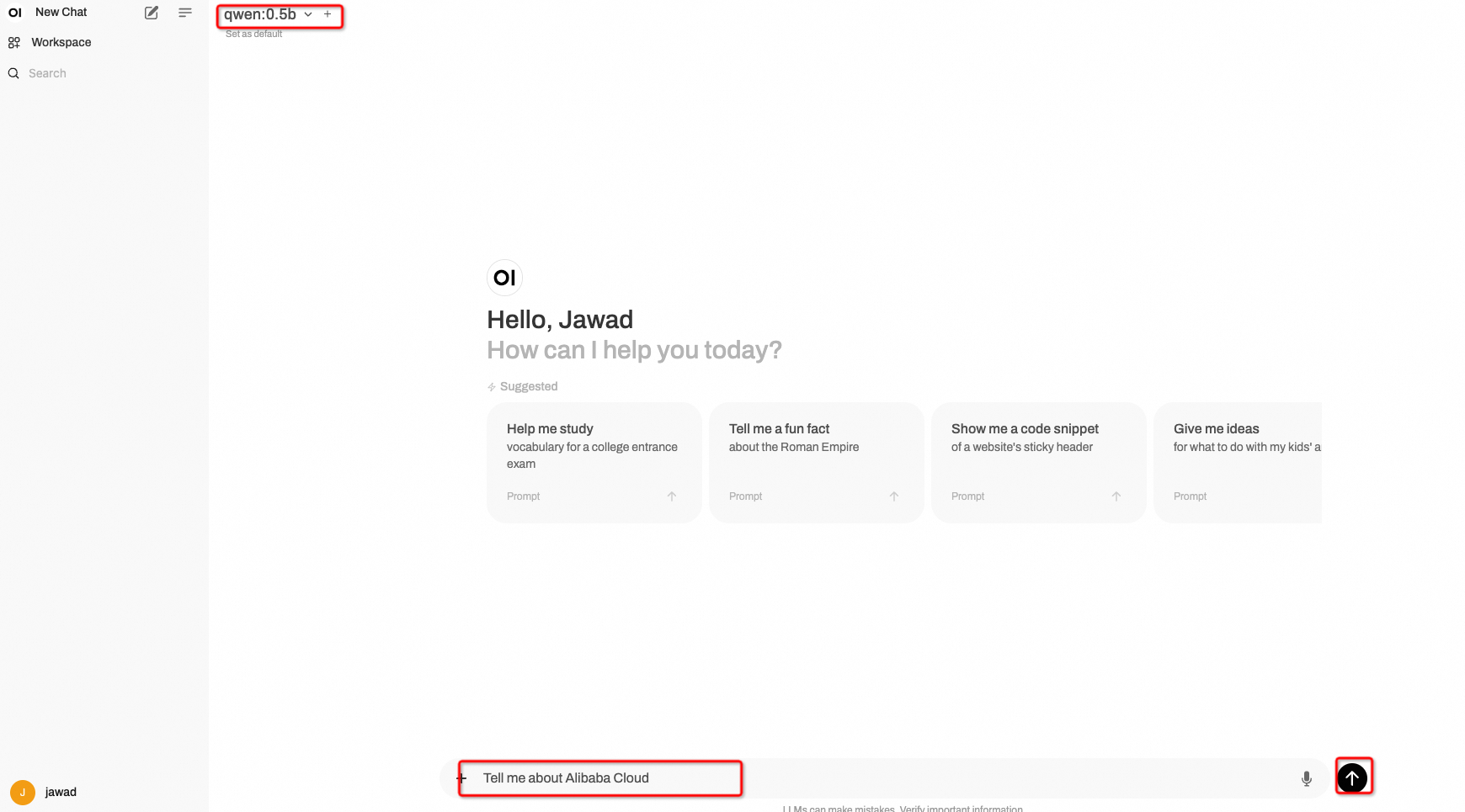

• Penggunaan Model: Setelah membuat akun, berinteraksilah dengan model Alibaba Cloud Qwen:0.5b:

Sekarang kita dapat menyediakan perintah yang berbeda kepada model untuk mendapatkan jawaban:

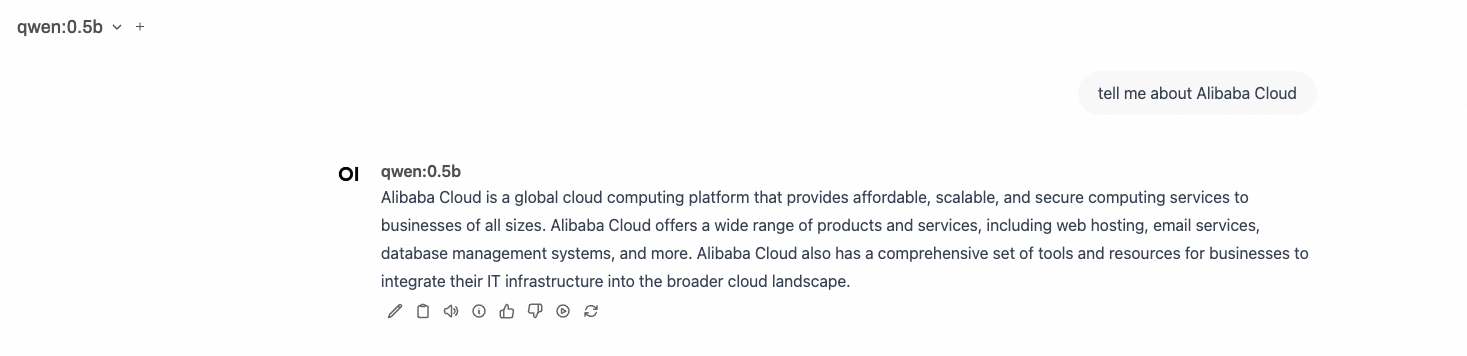

Berikut adalah output model tersebut:

Anda sekarang berhasil menyiapkan Ollama dan Open WebUI di instans Alibaba Cloud ECS Anda, menarik model Qwen 0.5, dan mengakses antarmuka web untuk interaksi yang mudah. Penyiapan ini tidak hanya menyederhanakan penyebaran model tetapi juga meningkatkan pengalaman pengguna dengan antarmuka yang intuitif. Nikmati eksperimen dengan model Qwen dan menjelajahi kemampuannya!

Terakhir, memang tepat untuk menyebutkan bahwa jika Anda perlu respons yang lebih akurat, maka lebih baik gunakan LLM Alibaba Cloud seperti Qwen 4b dll. yang tersedia di https://ollama.com/library/qwen yang mungkin membutuhkan spesifikasi perangkat keras yang lebih tinggi untuk respons yang lebih baik.

Jika Anda punya pertanyaan atau mengalami masalah apa pun, jangan ragu untuk meninggalkan komentar di bawah ini.

Artikel ini diterjemahkan dari bahasa Inggris, lihat artikel aslinya di sini.

99 posts | 4 followers

FollowRegional Content Hub - August 19, 2024

Regional Content Hub - July 15, 2024

Regional Content Hub - April 1, 2024

Regional Content Hub - October 21, 2024

Regional Content Hub - September 2, 2024

Regional Content Hub - September 2, 2024

99 posts | 4 followers

Follow Tongyi Qianwen (Qwen)

Tongyi Qianwen (Qwen)

Top-performance foundation models from Alibaba Cloud

Learn More Alibaba Cloud for Generative AI

Alibaba Cloud for Generative AI

Accelerate innovation with generative AI to create new business success

Learn More Alibaba Cloud Model Studio

Alibaba Cloud Model Studio

A one-stop generative AI platform to build intelligent applications that understand your business, based on Qwen model series such as Qwen-Max and other popular models

Learn More AI Acceleration Solution

AI Acceleration Solution

Accelerate AI-driven business and AI model training and inference with Alibaba Cloud GPU technology

Learn MoreMore Posts by Regional Content Hub

Start building with 50+ products and up to 12 months usage for Elastic Compute Service

Get Started for Free Get Started for Free