Oleh Jawad

Tongyi Qianwen-7B (Qwen-7B) adalah model skala parameter 7 miliar dari seri model besar Tongyi Qianwen yang dikembangkan oleh Alibaba Cloud.

Qwen-7B adalah model bahasa besar (LLM) yang didasarkan pada Transformer, yang dilatih tentang data pra-pelatihan berskala sangat besar. Jenis data pra-pelatihan beragam dan mencakup berbagai area, termasuk sejumlah besar teks online, buku profesional, kode, dll.

Untuk melihat deskripsi terperinci tentang model ini, kunjungi yang berikut ini:

https://www.modelscope.cn/models/qwen/Qwen-7B-Chat/files

Dalam artikel ini, kami akan mengeksplorasi dua pendekatan untuk berinteraksi dengan model Tongyi Qianwen-7B, satu menggunakan Antarmuka Pengguna Grafis (GUI) dan yang lainnya melalui Antarmuka Baris Perintah (CLI).

Harap perhatikan:

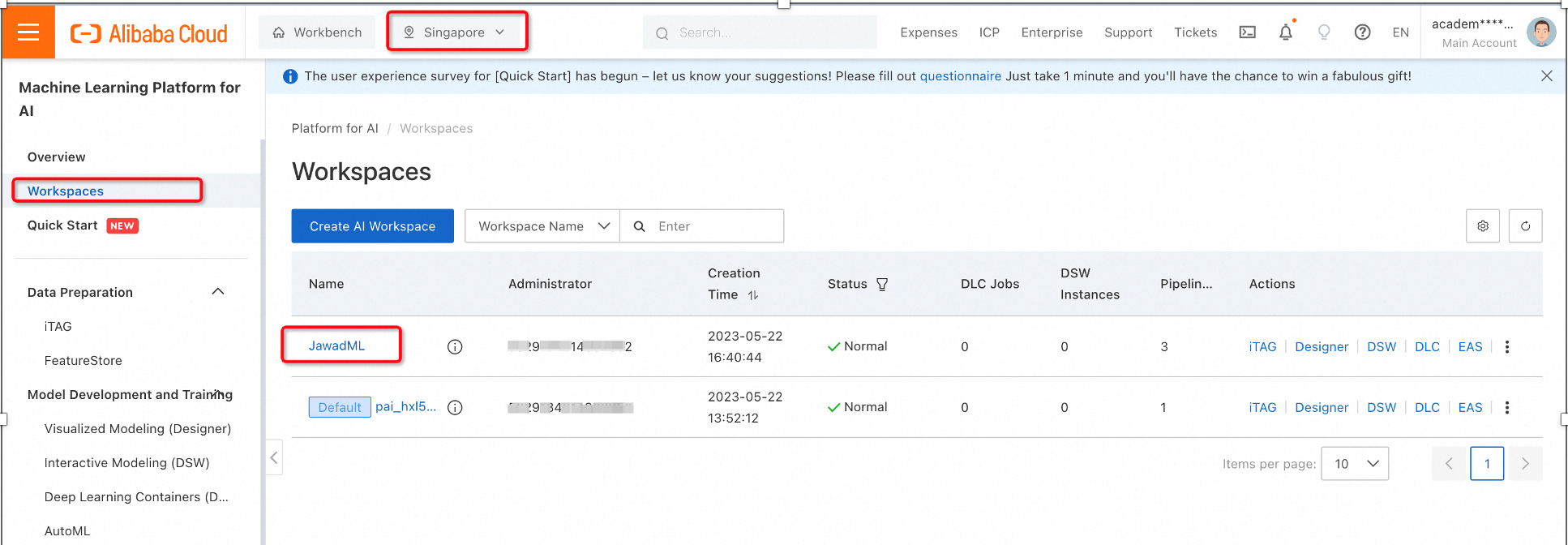

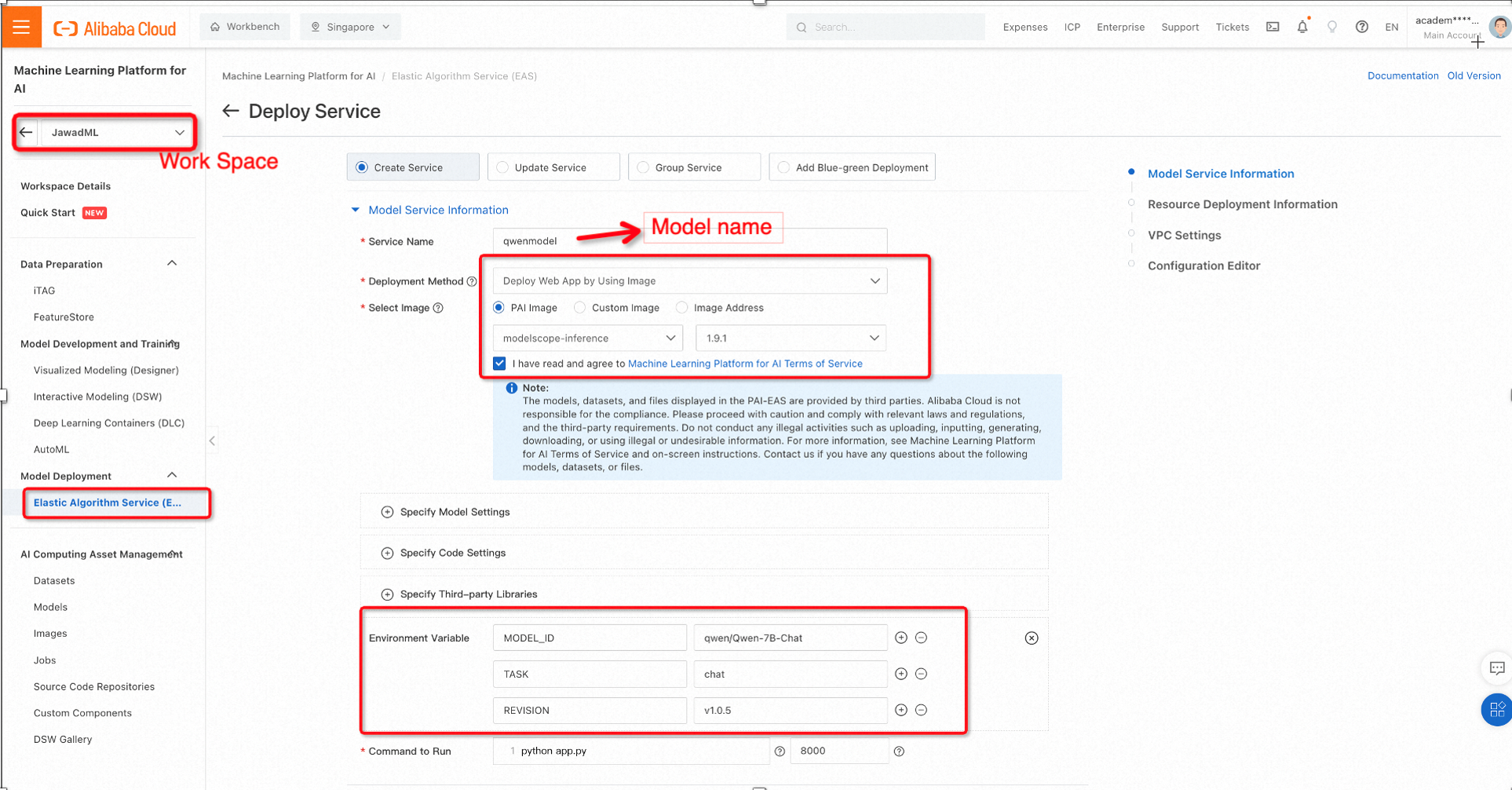

1. Di platform PAI, pilih ruang kerja Anda dan di bawah Penyebaran Model, pilih Elastic Algorithm Service (EAS) lalu klik Sebarkan Layanan.

2. Kita akan menggunakan model pralatih dari ModelScope menggunakan konfigurasi berikut untuk memilih variabel gambar dan lingkungan.

ModelScope adalah platform Model as-a-Service (MaaS) sumber terbuka, yang dikembangkan oleh Alibaba Cloud, yang dilengkapi dengan ratusan Model AI, termasuk model pralatih besar untuk pengembang dan peneliti global.

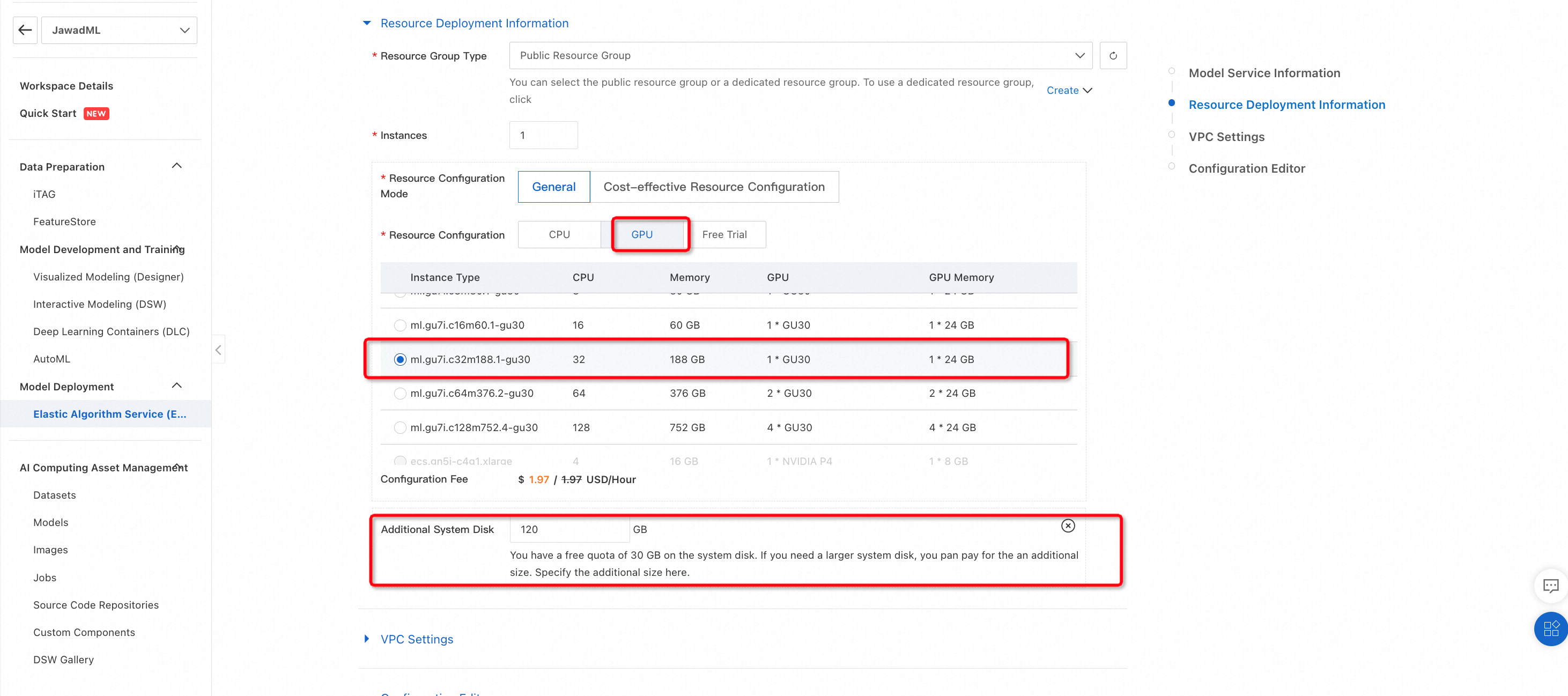

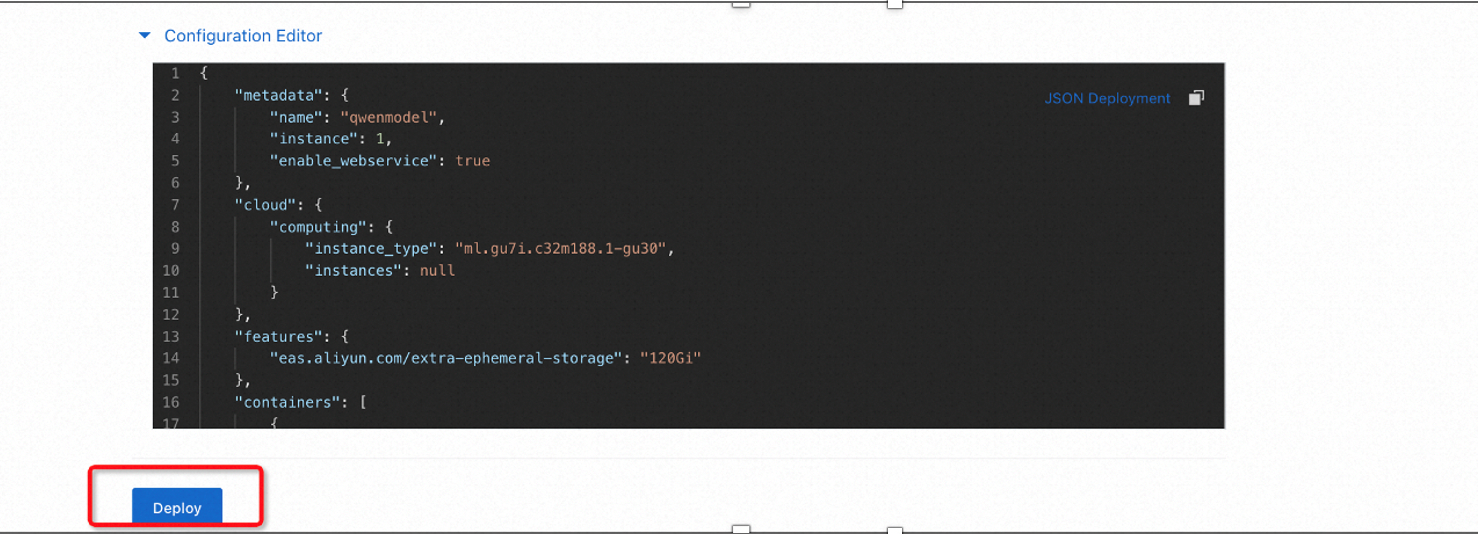

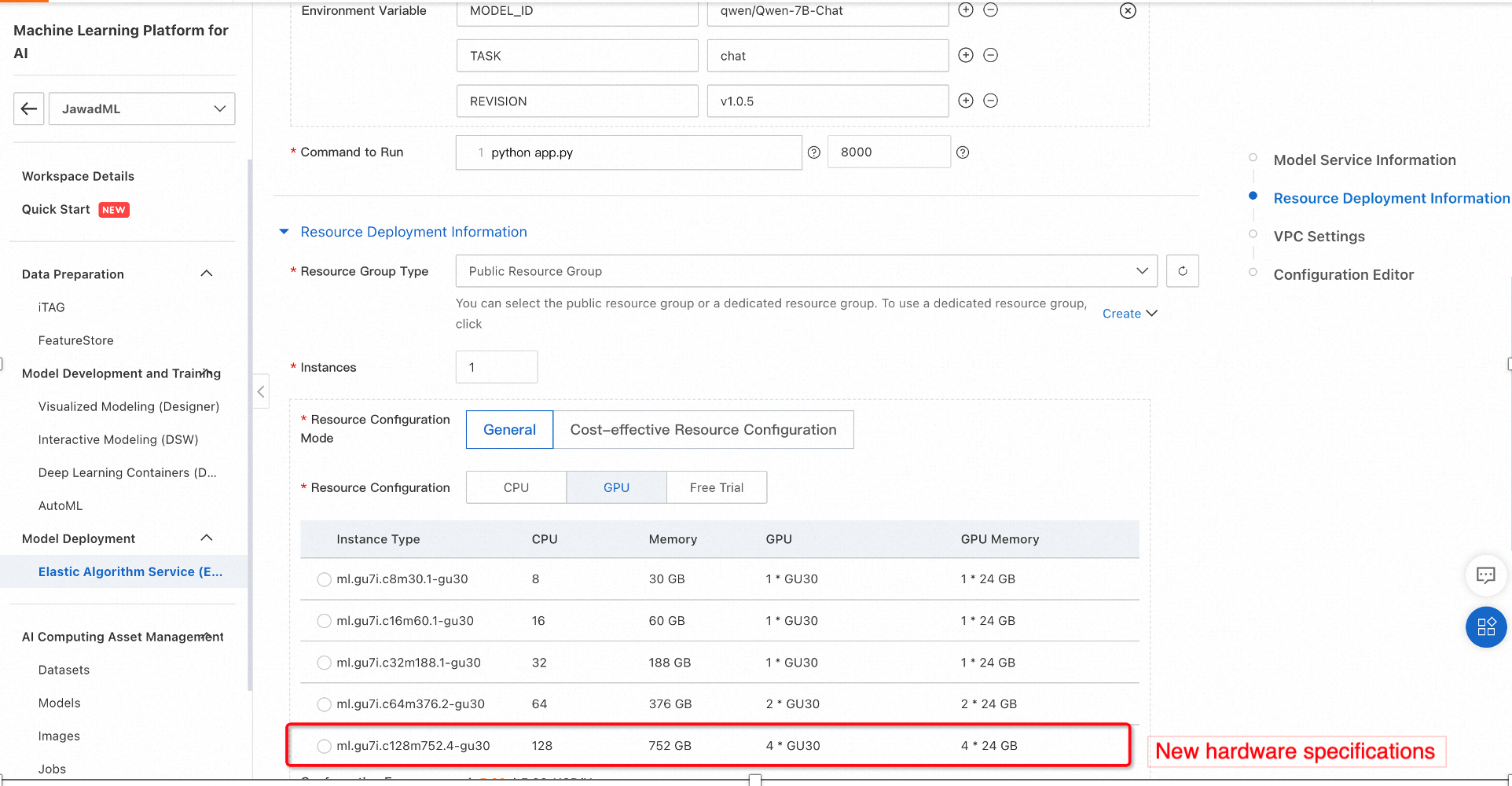

Alibaba Cloud PAI menyediakan berbagai opsi untuk perangkat keras yang dapat menjalankan model pemelajaran mesin untuk inferensi. Dalam hal ini, kita dapat menggunakan GPU dengan memori yang mencukupi. Pilih konfigurasi berikut dan klik Sebarkan.

Ini akan mulai penyebaran model Qwen-7B pralatih di perangkat keras yang dipilih. Prosesnya mungkin perlu waktu beberapa saat sehingga dianjurkan untuk memeriksa berbagai kejadian selama proses penyebaran.

3. Memeriksa proses pembuatan

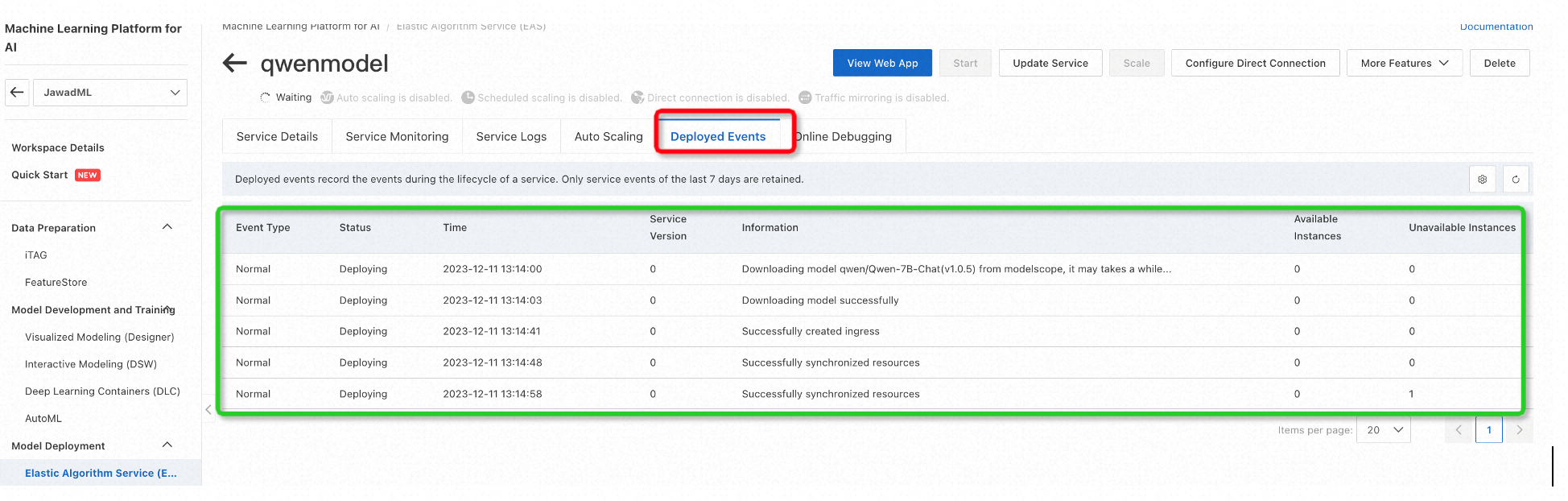

Untuk memeriksa kejadian penyebaran dan memastikan semuanya berjalan baik, klik ID/Nama Layanan (dalam kasus kita itu adalah qwenmodel ) lalu pilih Kejadian Penyebaran.

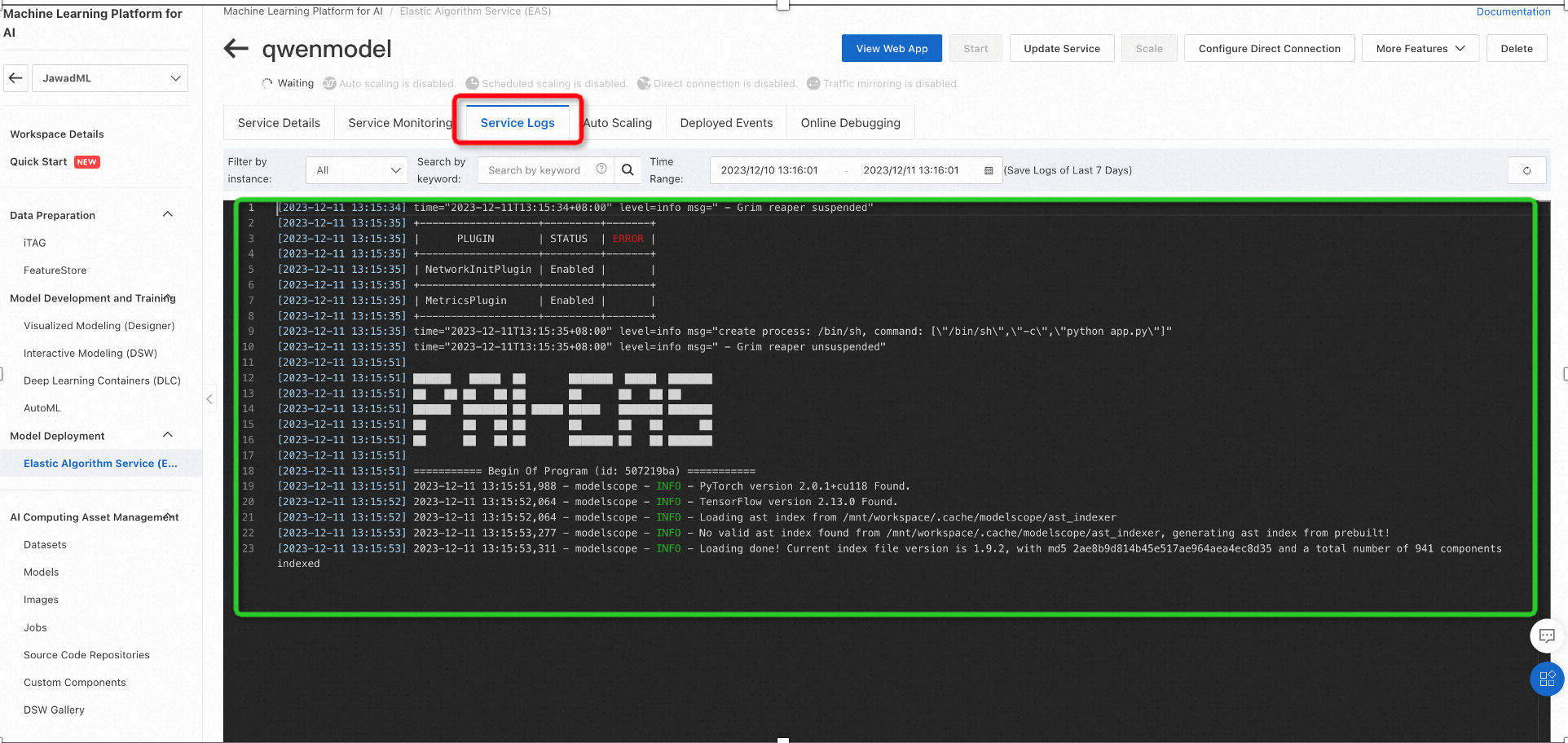

Demikian pula, Log Layanan dapat digunakan untuk melihat log terkait penginstalan paket, seperti yang ditunjukkan di bawah ini:

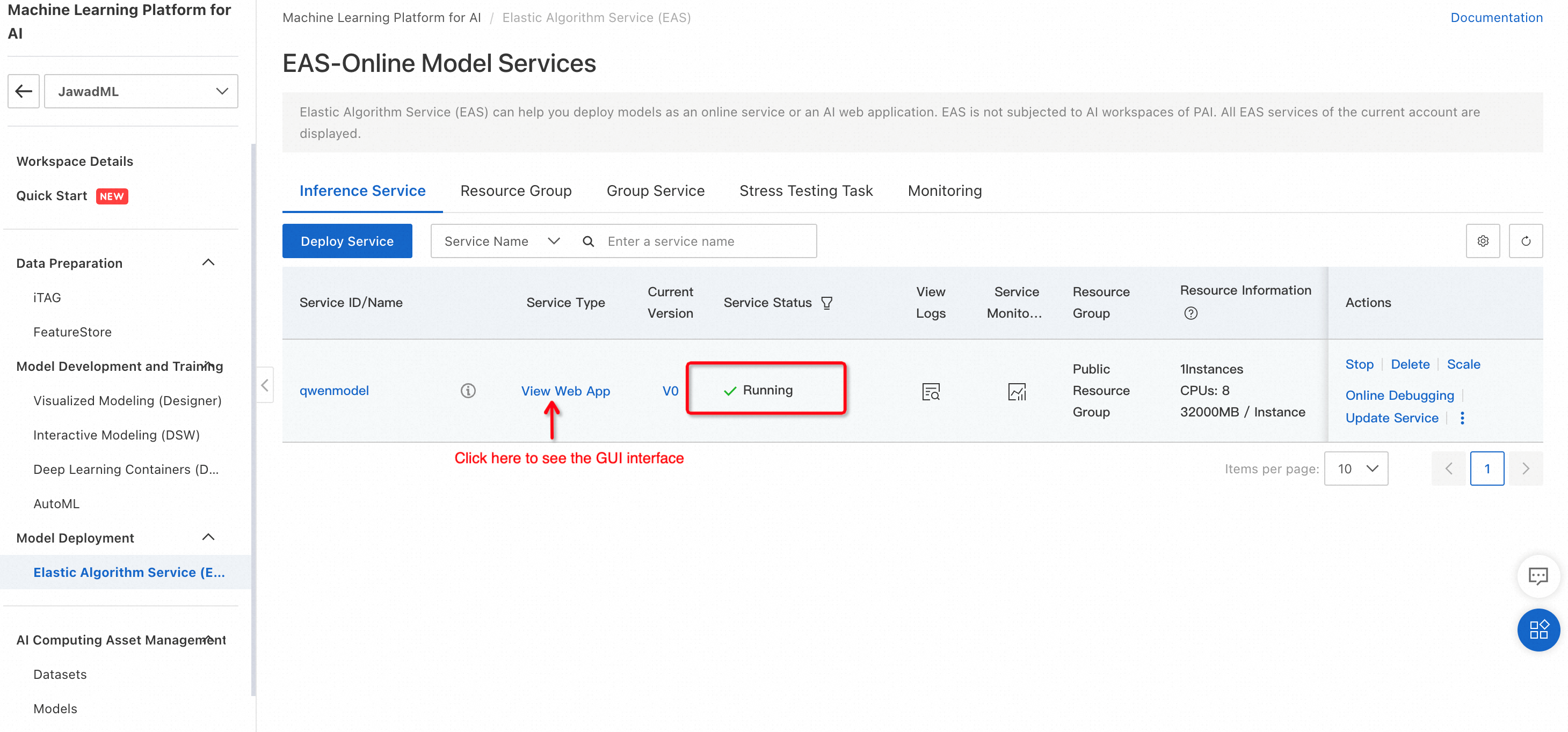

Setelah model berhasil disebarkan, status layanan akan berubah menjadi Berjalan.

Untuk menggunakan model untuk inferensi, klik Lihat Aplikasi Web. Ini akan membuka antarmuka GUI model yang dapat digunakan untuk pengujian untuk membuat teks.

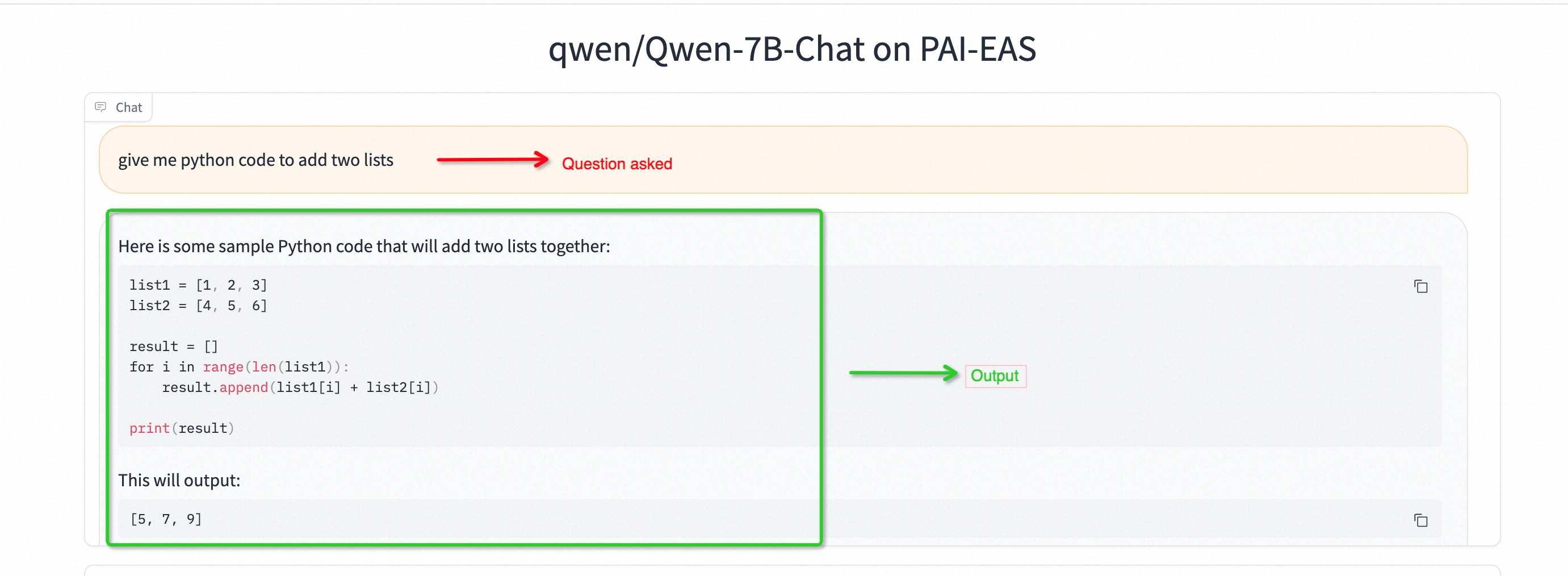

4. Pengujian: Qwen-7B untuk membuat kode python

Penting untuk dicatat bahwa dengan menggunakan mode GUI, model memproses teks input penuh, lalu membuat keseluruhan teks.

5. Tingkatkan jika Anda ingin menyempurnakan performa (Opsional)

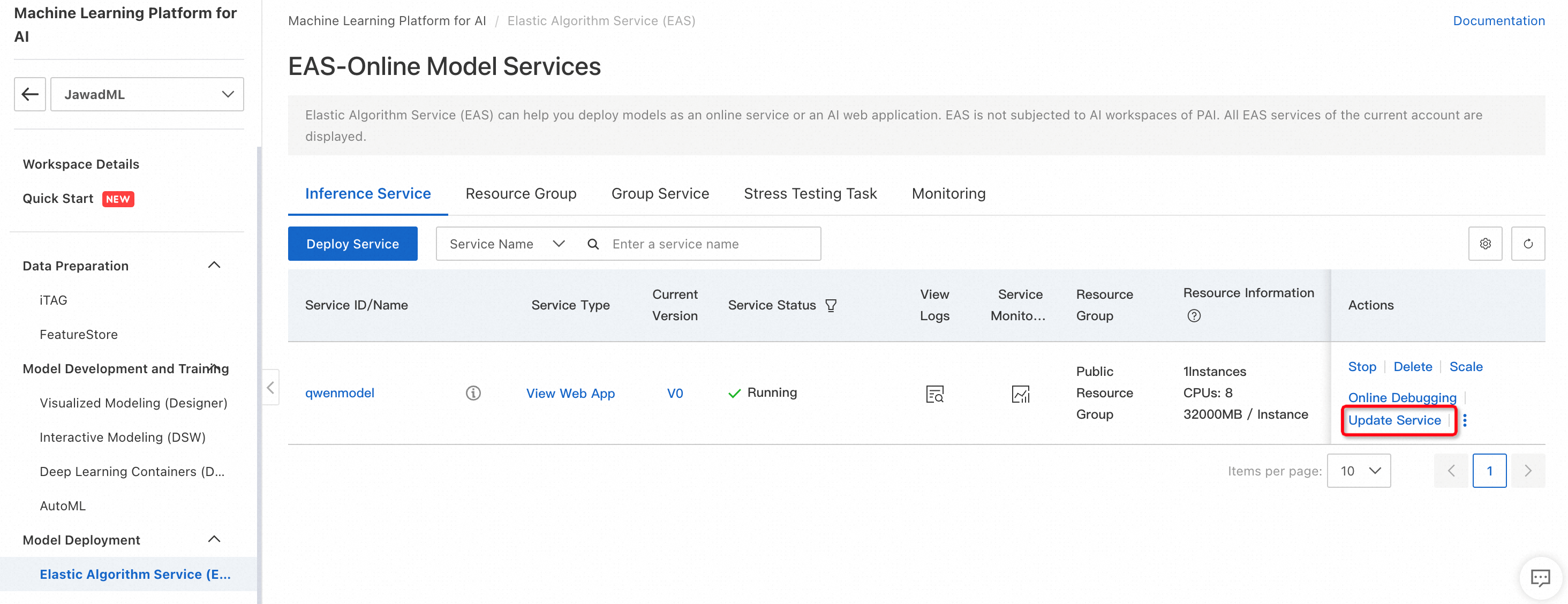

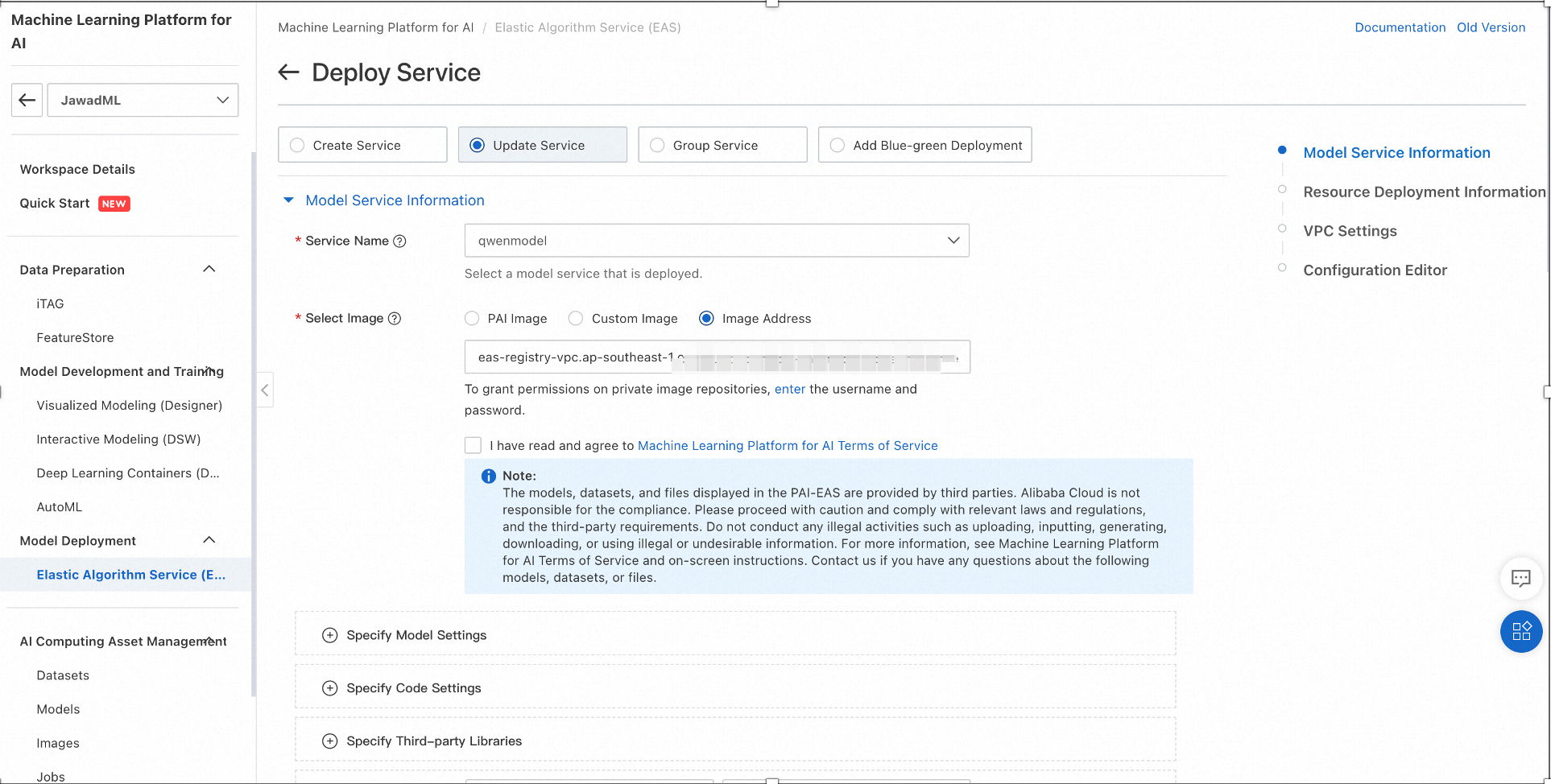

Konfigurasi perangkat keras dapat diubah jika diperlukan. Seperti yang ditunjukkan di bawah ini, mengeklik Perbarui Layanan akan membuka jendela konfigurasi.

Gambar berikut menunjukkan cara mengubah konfigurasi perangkat keras mesin inferensi. Setelah konfigurasi diubah, klik Sebarkan.

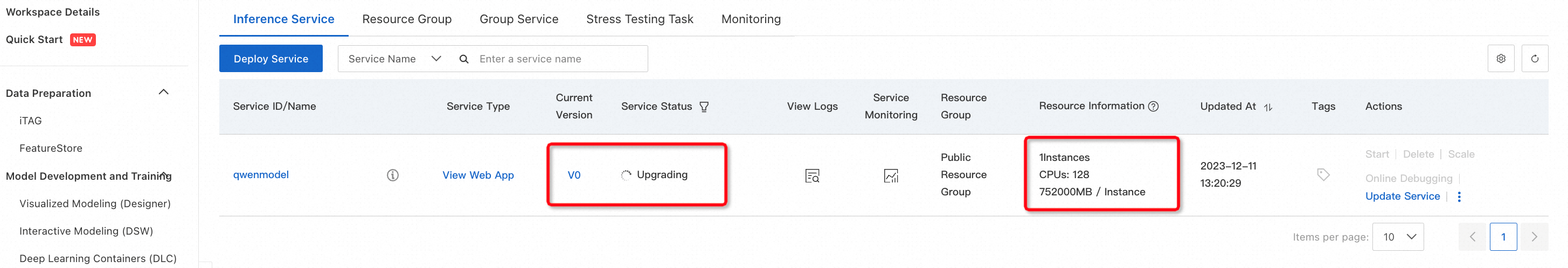

Perubahan konfigurasi perlu beberapa saat. Setelah selesai, Service Status (Status Layanan) akan berubah dari Meningkatkan menjadi Berjalan.

Kita dapat mengimplementasikan Qwen 7-B dalam mode CLI yang dapat membuat respons teks berjalan. Untuk tujuan ini, kita dapat menggunakan Pemodelan interaktif PAI (DSW) atau instans ECS. Kita akan membahas implementasi berbasis DSW.

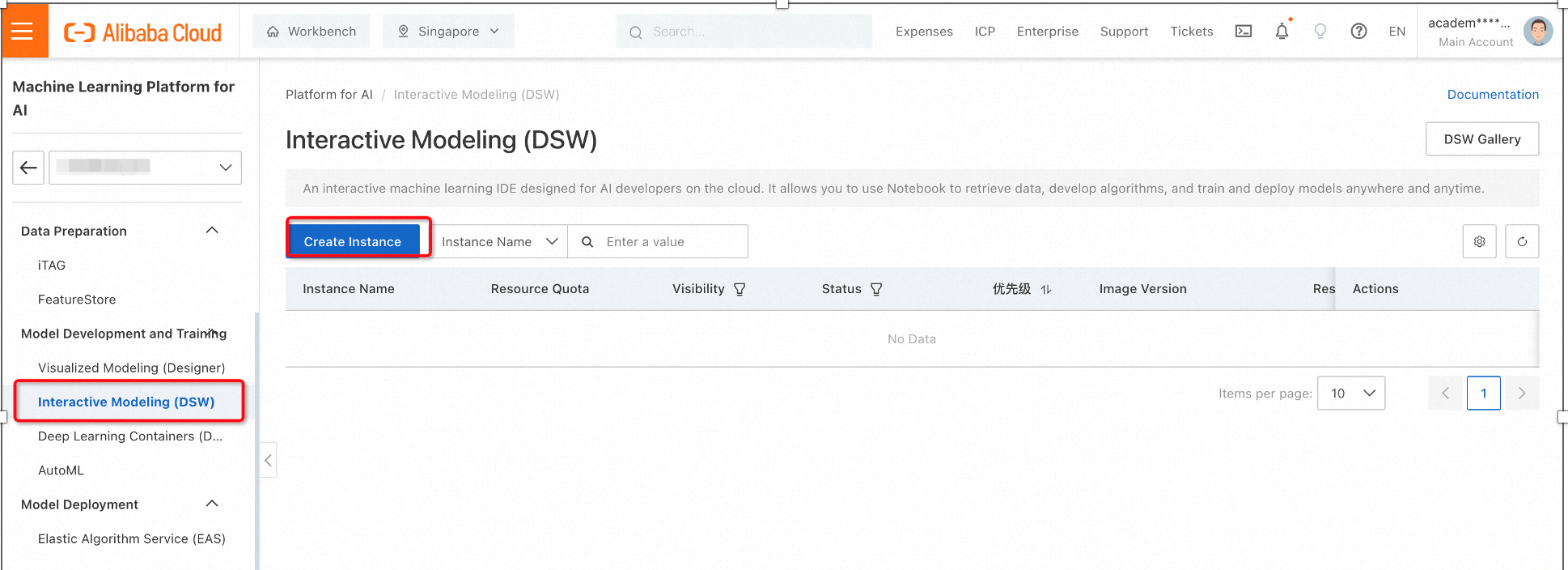

1. Di PAI, pilih Pemodelan interaktif (DSW) lalu klik Buat Instans. Tindakan ini membuka jendela konfigurasi.

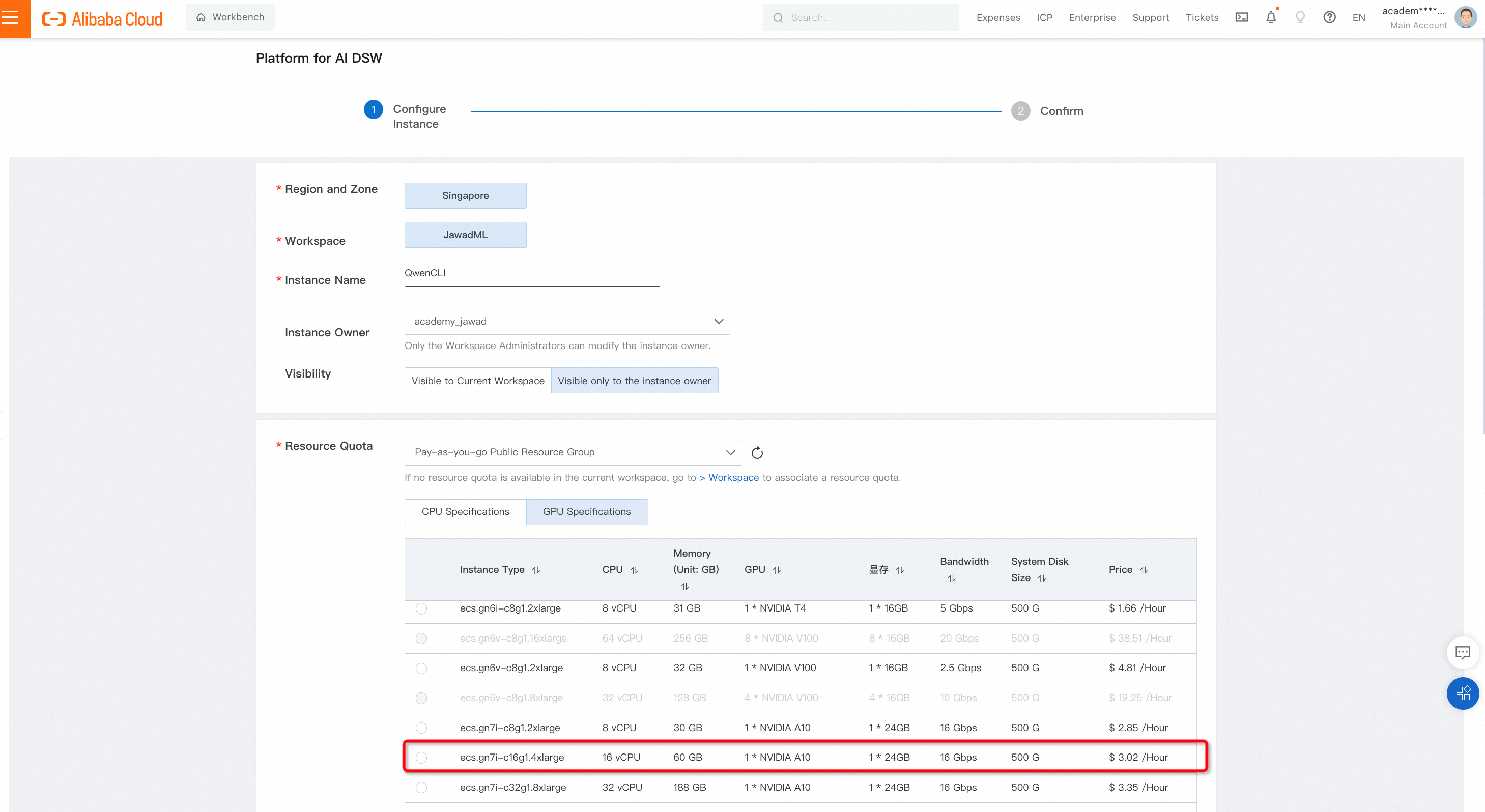

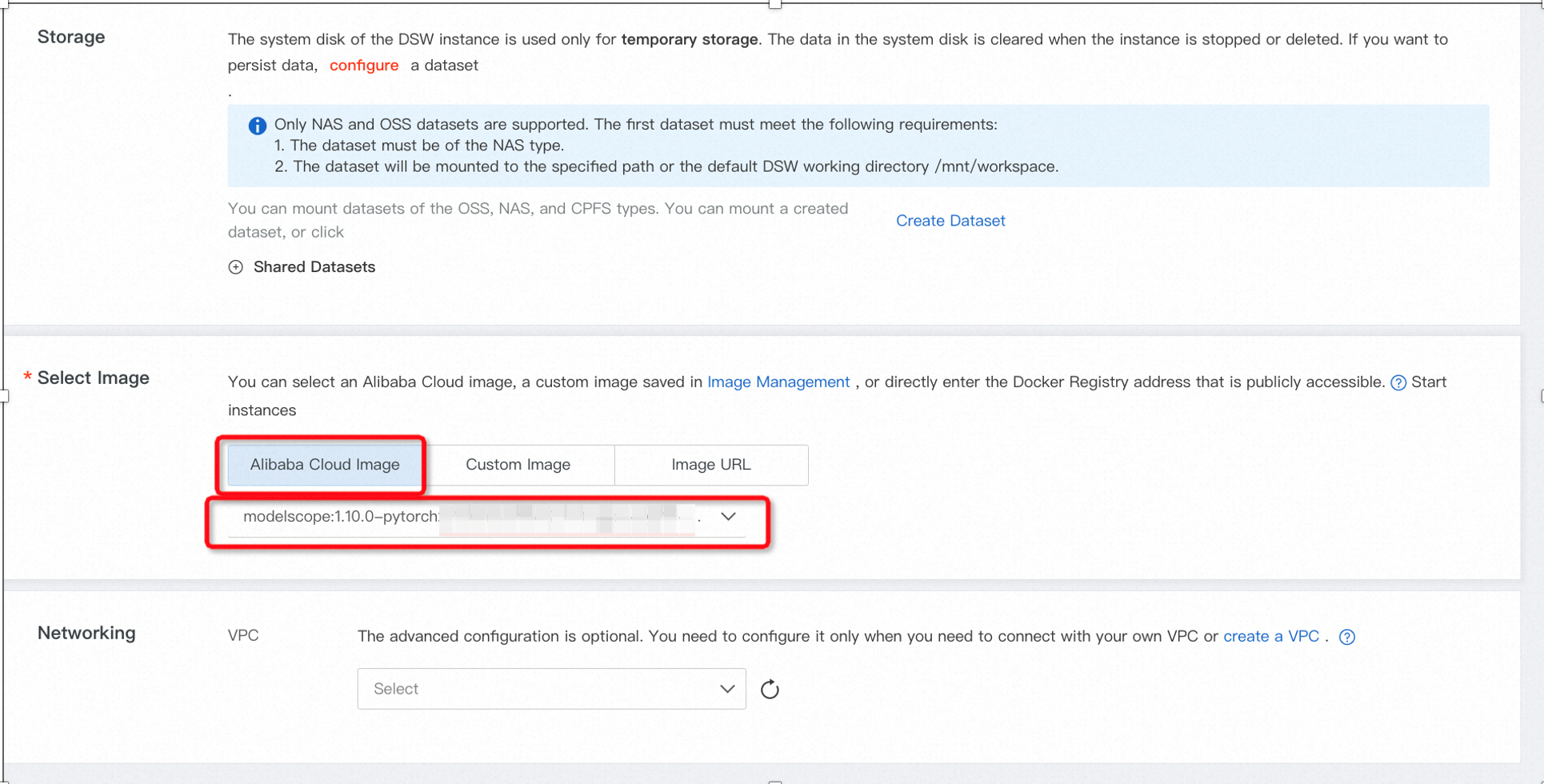

Untuk konfigurasi, pilih spesifikasi GPU yang tepat dan jenis gambar seperti yang ditunjukkan di bawah ini.

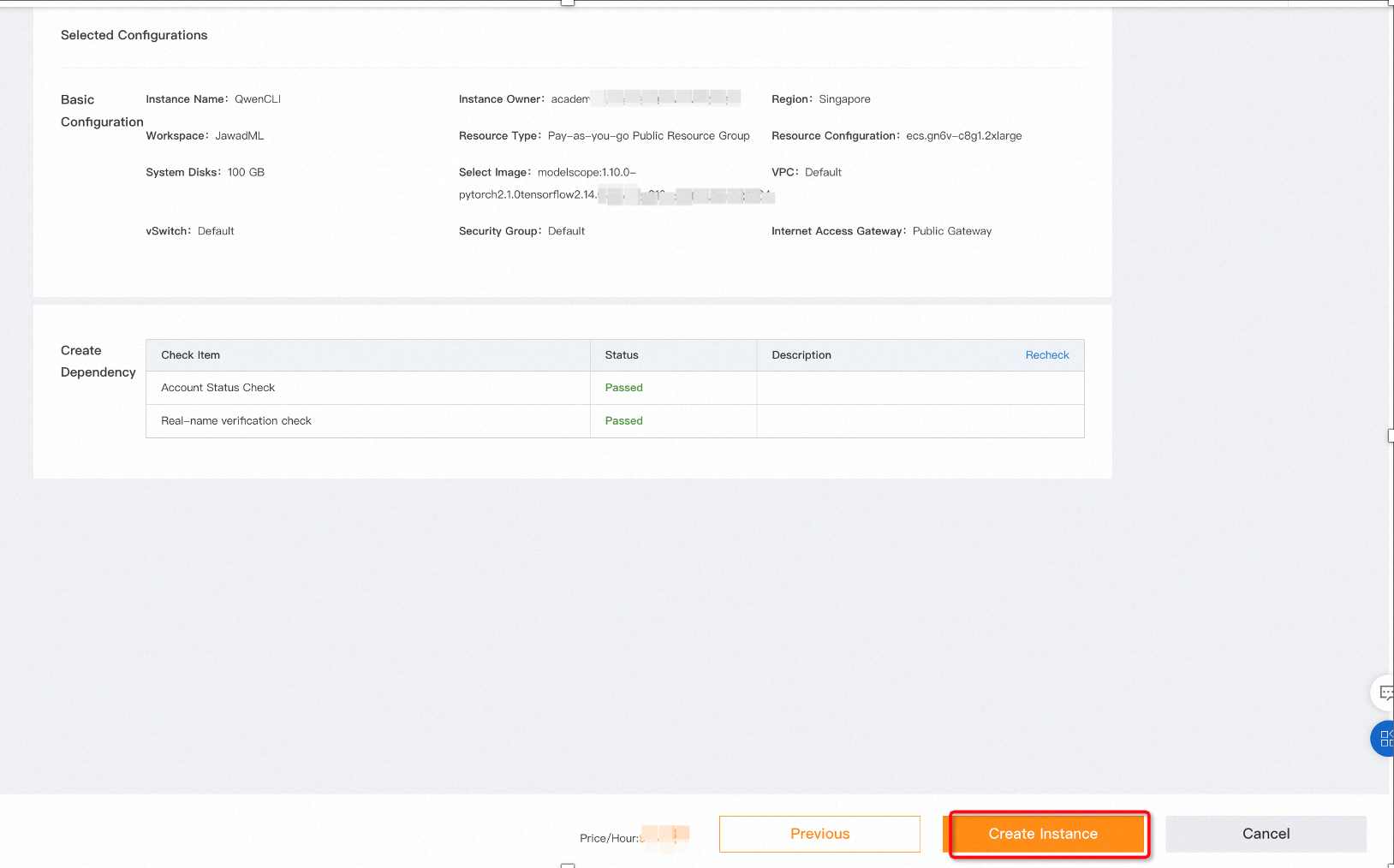

Klik Berikutnya untuk membuka halaman akhir. Pilih Buat Instans yang akan mulai memutar instans DSW.

Status awal instance akan menunjukkan Menyiapkan Sumber Daya.

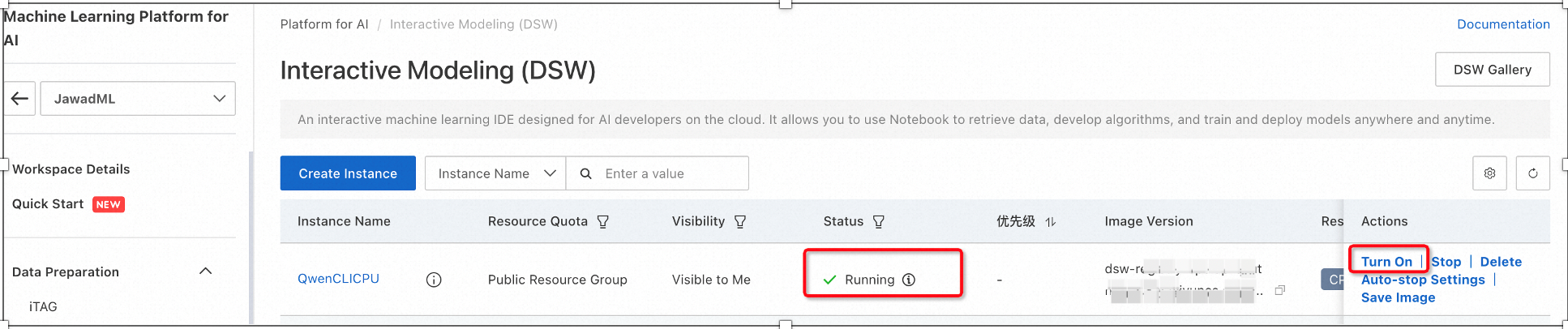

2. Setelah status instans berubah menjadi Berjalan, klik opsi Hidupkan di sisi kanan. Ini akan meluncurkan Jupyter Lab.

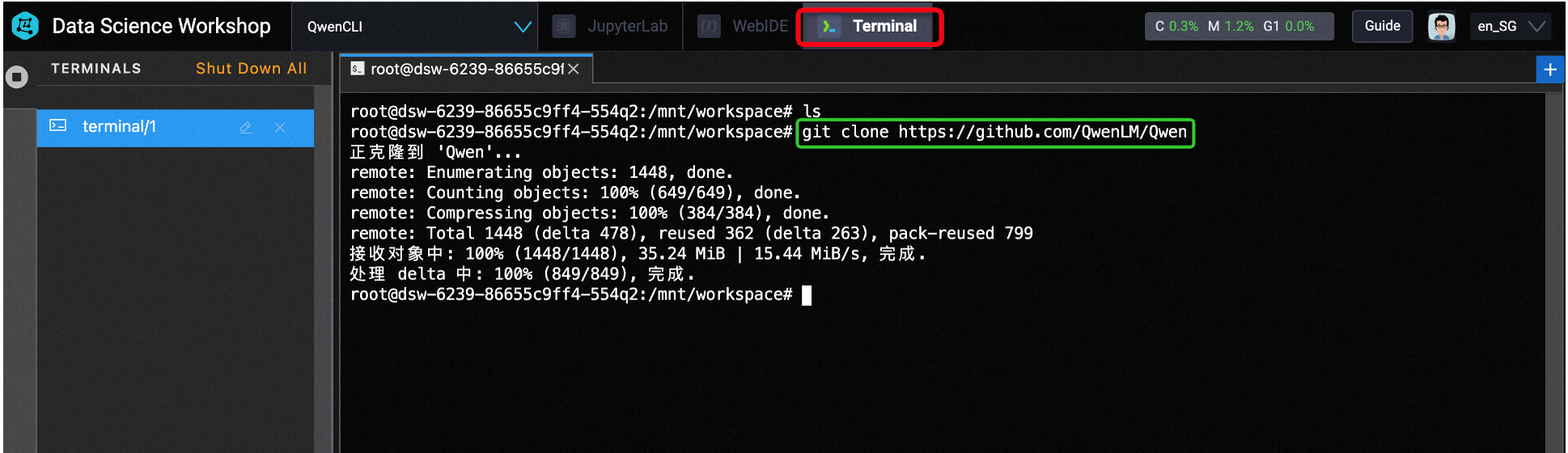

3. Kita tidak akan menggunakan Jupyter Lab di sini. Sebaliknya, kita akan membuka terminal untuk mengunduh model dari Github untuk penyebaran.

Cara terbaik adalah membuat lingkungan python terlebih dahulu. Setelah lingkungan virtual dibuat, aktifkan dan gunakan perintah berikut di terminal:

a) git clone https://github.com/QwenLM/Qwen

b) cd Qwen/

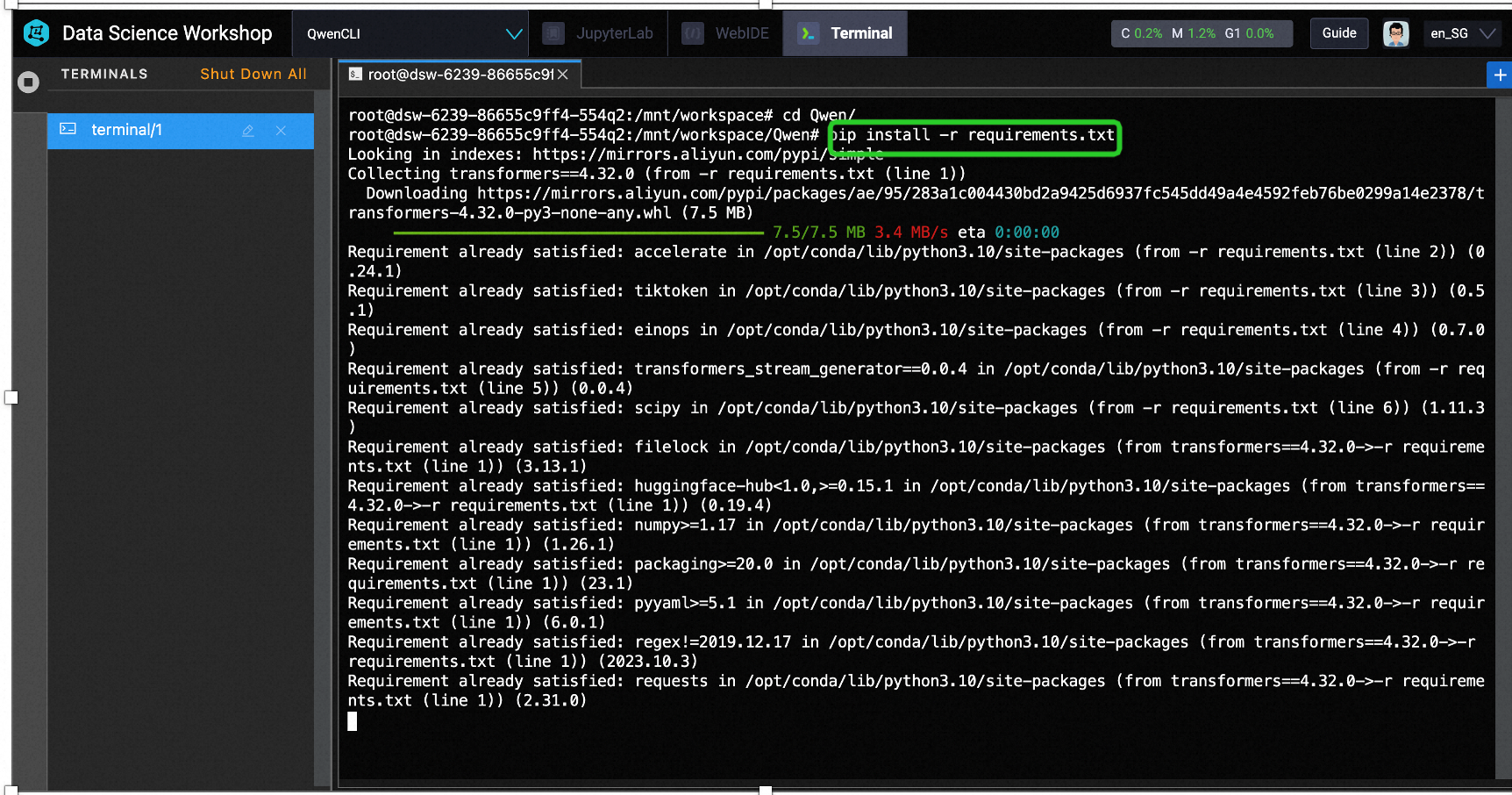

c) pip install -r requirements.txt

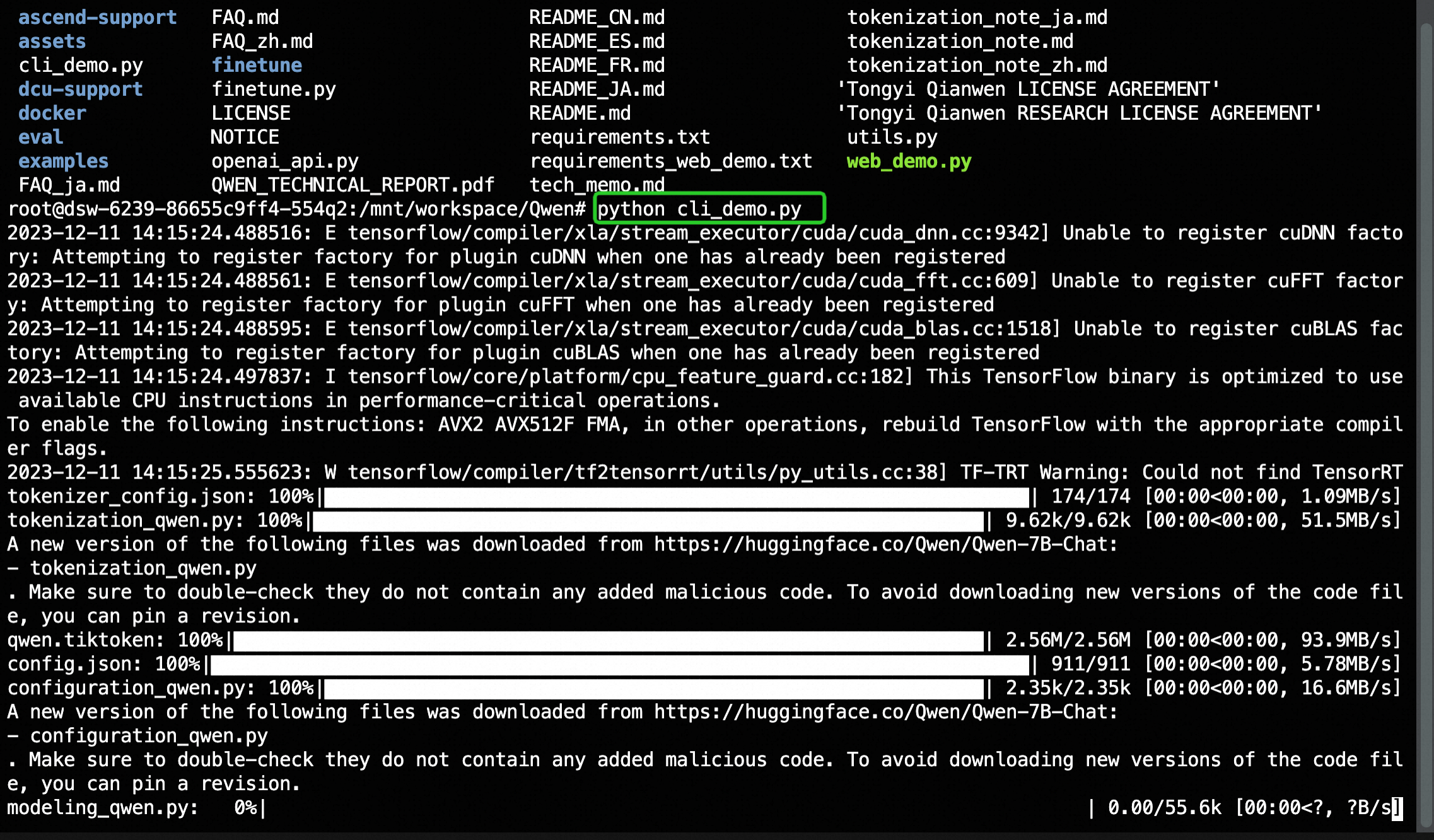

d) python3 cli_demo.py

Bikin secangkir kopi dan tunggu dengan sabar penginstalan selesai.

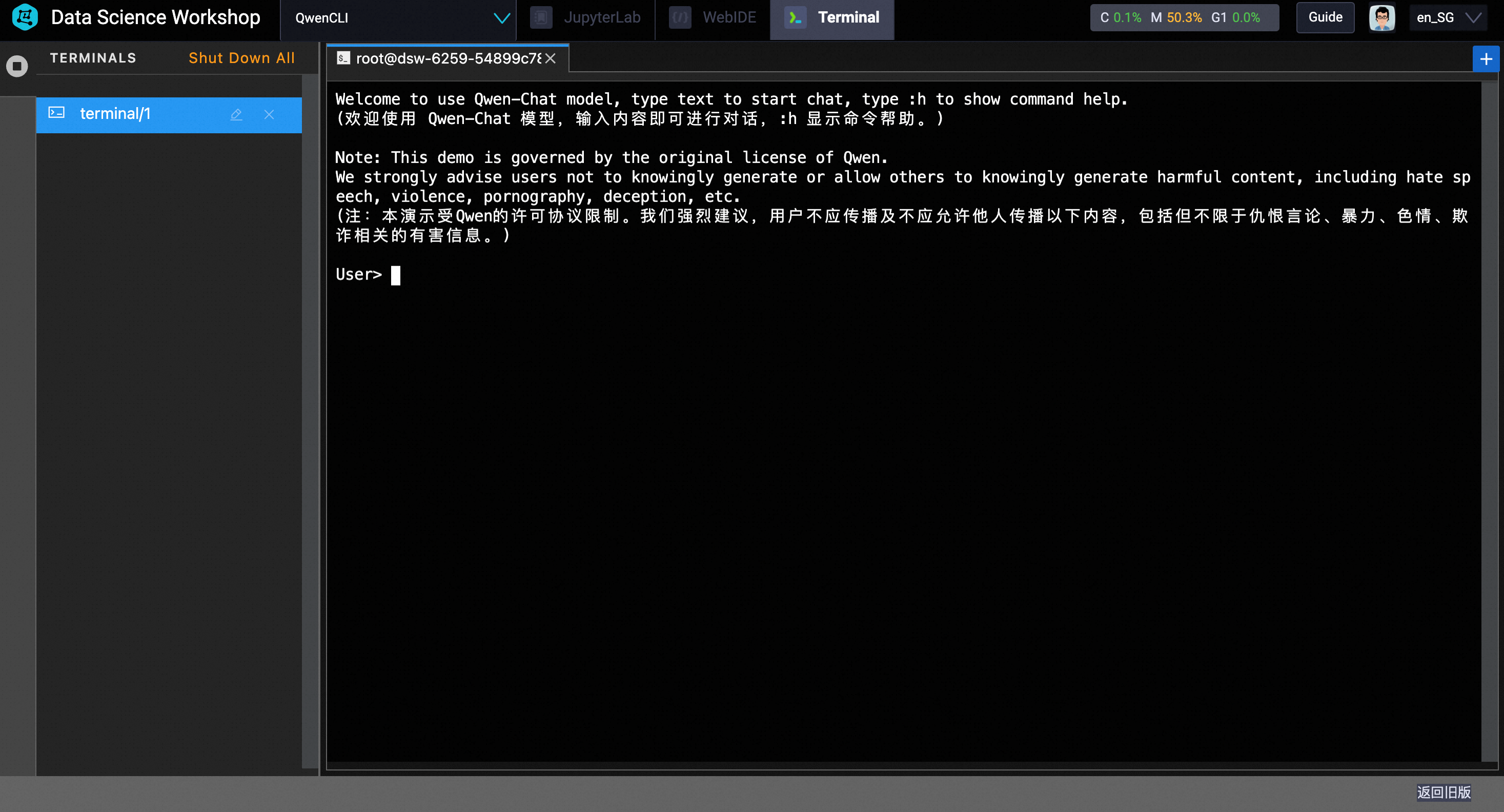

Setelah selesai, Anda akan melihat prompt baris perintah:

4. Menguji model:

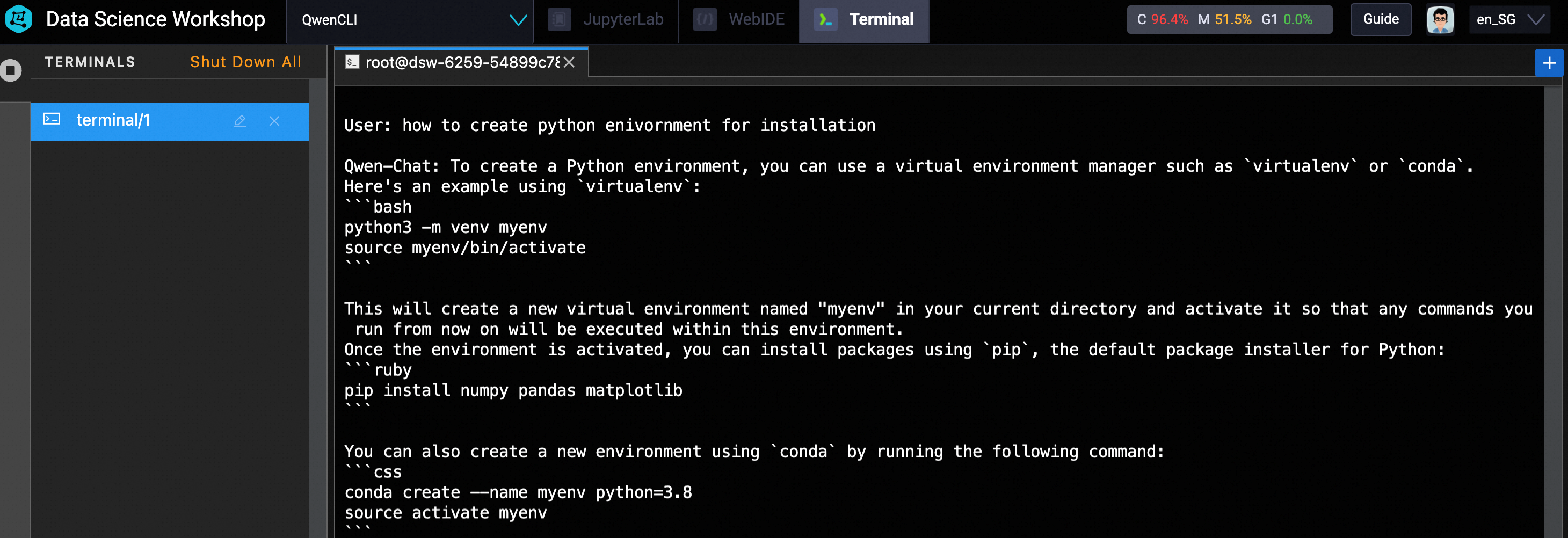

Untuk menguji model, ketik teks langsung di antarmuka CLI. Dalam kasus saya, saya menggunakan prompt: bagaimana cara membuat lingkungan python untuk penginstalan.

Seperti ditunjukkan di bawah ini, prompt tersebut menghasilkan kode python untuk membuat dan mengaktifkan lingkungan virtual.

Cobalah pertanyaan yang berbeda dan nikmati Qwen. 😀

Artikel ini aslinya ditulis dalam bahasa Inggris. Lihat artikel asli di sini

그래픽 및 명령줄 인터페이스를 사용하여 Alibaba Cloud 거대 언어 모델(Tongy Qianwen) 배포하기

Triển khai Mô hình ngôn ngữ lớn Alibaba Cloud (Tongy Qianwen) với giao diện đồ họa và dòng lệnh

89 posts | 3 followers

FollowRegional Content Hub - November 11, 2024

Regional Content Hub - September 2, 2024

Regional Content Hub - May 6, 2024

Regional Content Hub - May 20, 2024

Regional Content Hub - September 2, 2024

Regional Content Hub - April 1, 2024

89 posts | 3 followers

Follow Tongyi Qianwen (Qwen)

Tongyi Qianwen (Qwen)

Top-performance foundation models from Alibaba Cloud

Learn More Platform For AI

Platform For AI

A platform that provides enterprise-level data modeling services based on machine learning algorithms to quickly meet your needs for data-driven operations.

Learn More AI Acceleration Solution

AI Acceleration Solution

Accelerate AI-driven business and AI model training and inference with Alibaba Cloud GPU technology

Learn More Alibaba Cloud for Generative AI

Alibaba Cloud for Generative AI

Accelerate innovation with generative AI to create new business success

Learn MoreMore Posts by Regional Content Hub