Oleh JV Roig

Selamat datang di bagian 2 dalam seri pendekatan penyebaran AI generatif di Alibaba Cloud ini.

Di bagian 1 seri ini, kita membahas penyebaran GenAI IaaS (Infrastructure sebagai Layanan), menggunakan Elastic Compute Service (ECS). Seperti yang kita lihat dari bagian 1, ini adalah cara yang sangat efektif dan fleksibel untuk menyebarkan AI generatif. Sayangnya, banyak langkah yang diperlukan, dan banyak beban manajemen karena kita bertanggung jawab atas operasi dan pemeliharaan seluruh tumpukan.

Bisakah kita membuatnya lebih mudah, lebih cepat, dan dengan beban yang lebih ringan? Tentu saja bisa!

Hari ini, kita akan membahas pendekatan PaaS (Platform sebagai Layanan), menggunakan Platform untuk AI (PAI) Alibaba Cloud. Kita akan melihat cara pendekatan PaaS membantu mengurangi beban operasional yang terlibat, dan memungkinkan kita menyebarkan layanan AI generatif yang berguna dalam hitungan menit.

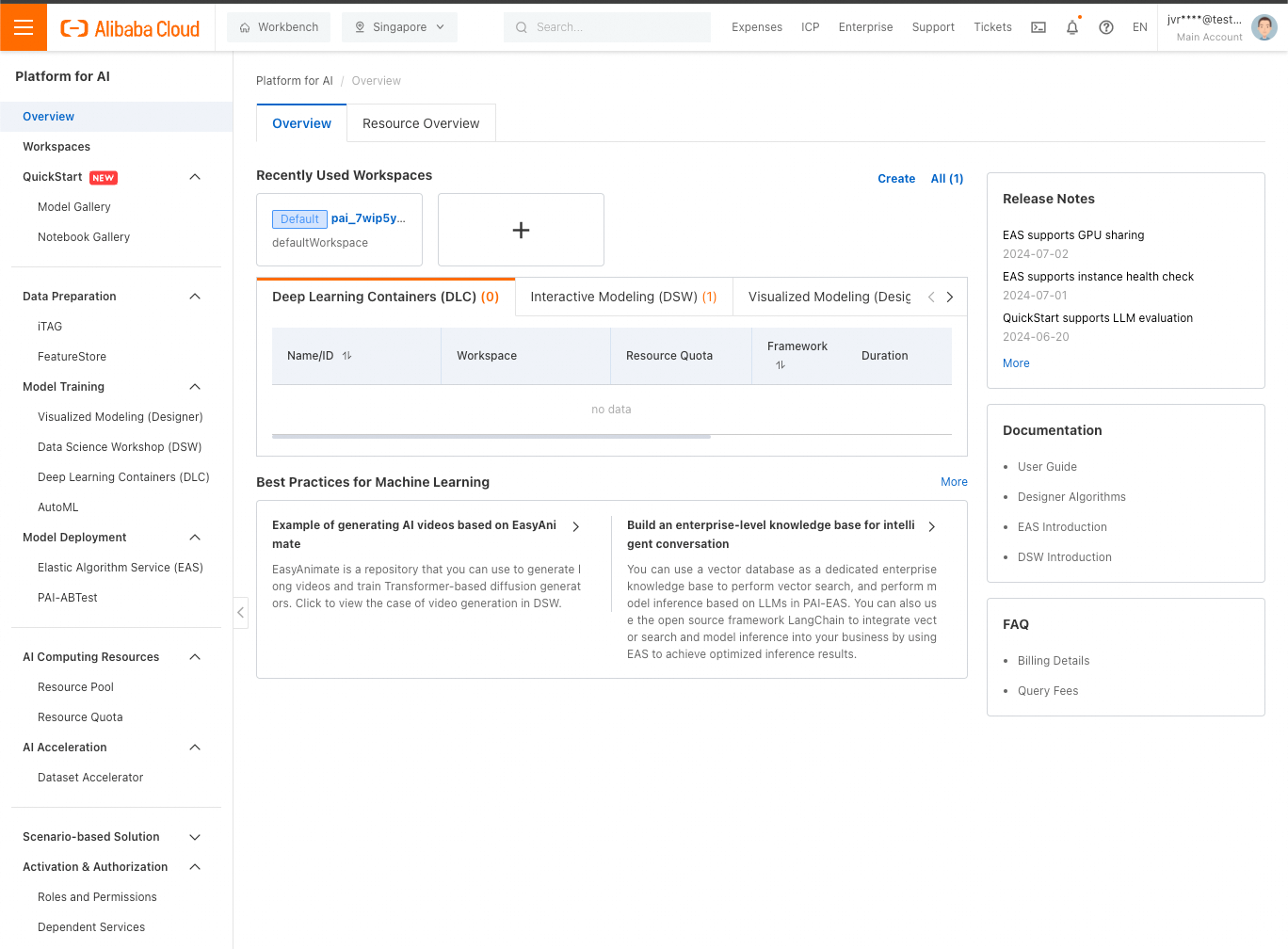

Masuk ke konsol web Alibaba Cloud Anda, lalu cari PAI. Klik hasil yang muncul (Platform for AI), dan Anda akan melihat konsol PAI:

Kita dapat menyebarkan LLM dengan cepat baik dari QuickStart (di dekat bagian atas bilah sisi kiri) atau EAS/Elastic Algorithm Service (di dekat bagian tengah bilah sisi kiri). Dalam kedua kasus tersebut, layanan disebarkan sebagai instans EAS, jadi bagaimanapun juga Anda akhirnya akan menggunakan EAS.

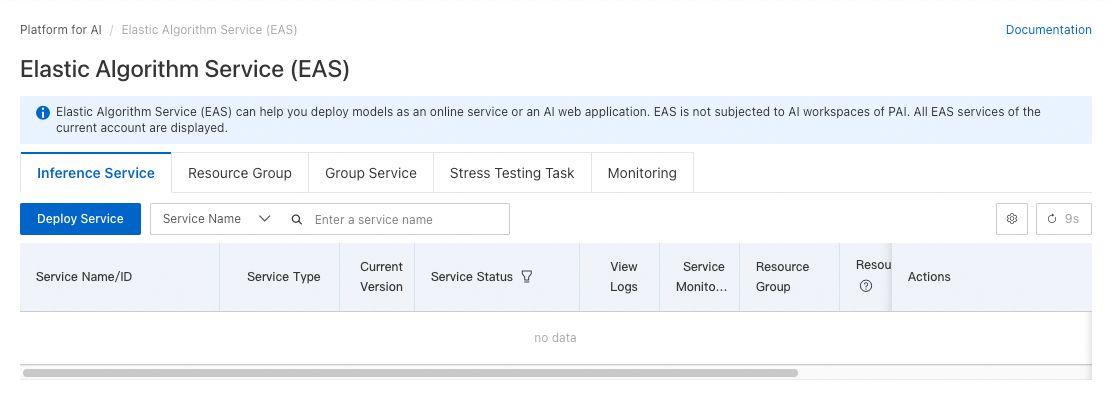

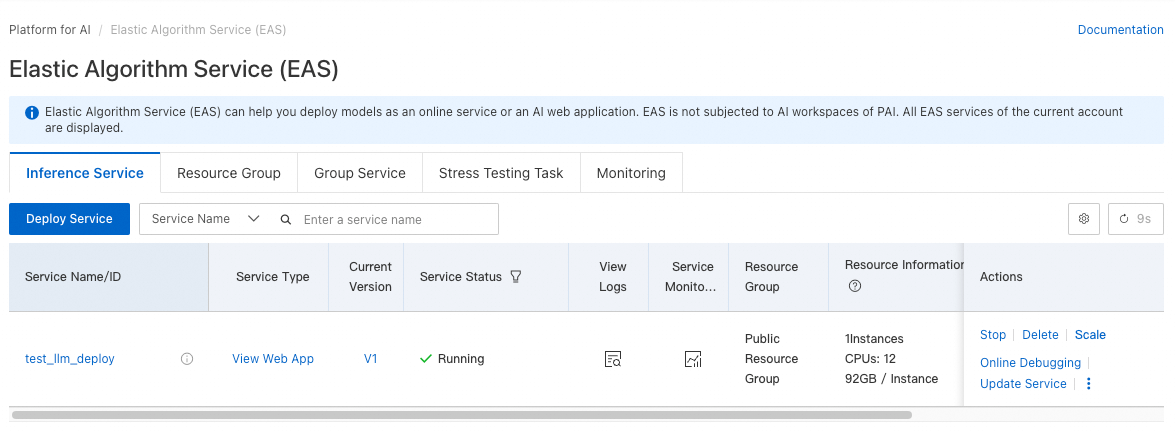

Mari kita langsung ke EAS. Klik Elastic Algorithm Service di bawah Penyebaran Model , dan Anda akan melihat layar ini:

Klik Sebarkan Layanan.

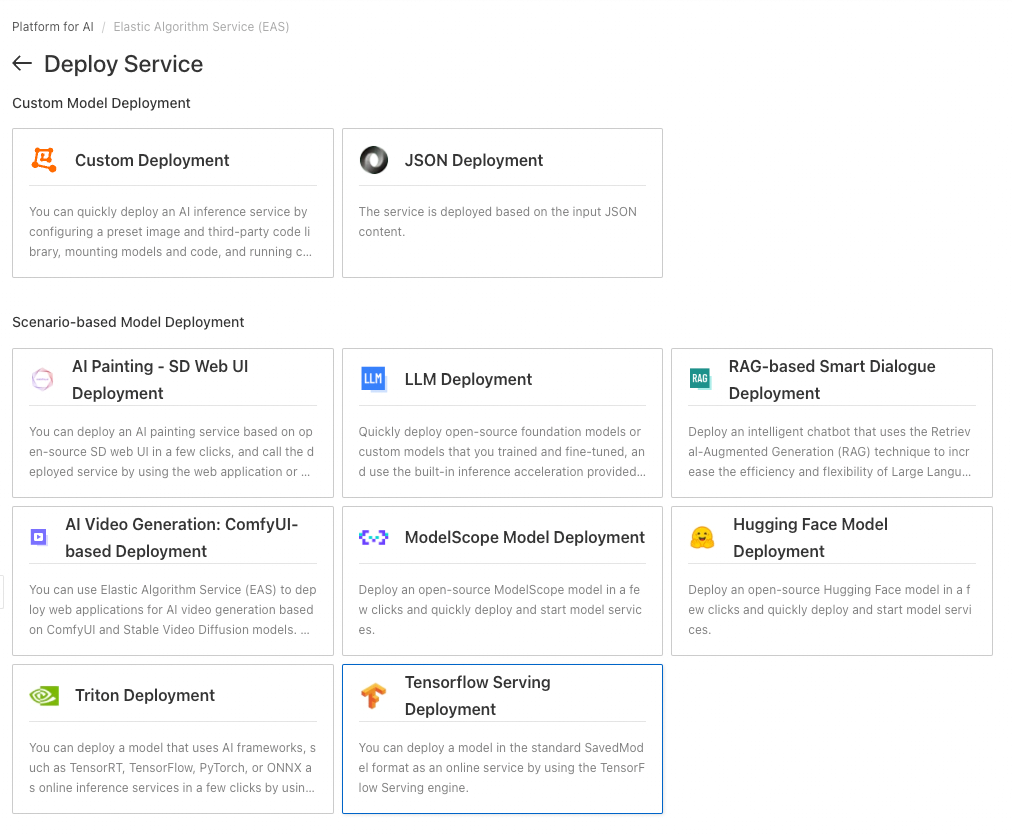

Untuk tutorial ini, klik Penyebaran LLM di bawah Penyebaran Model Berbasis Skenario.

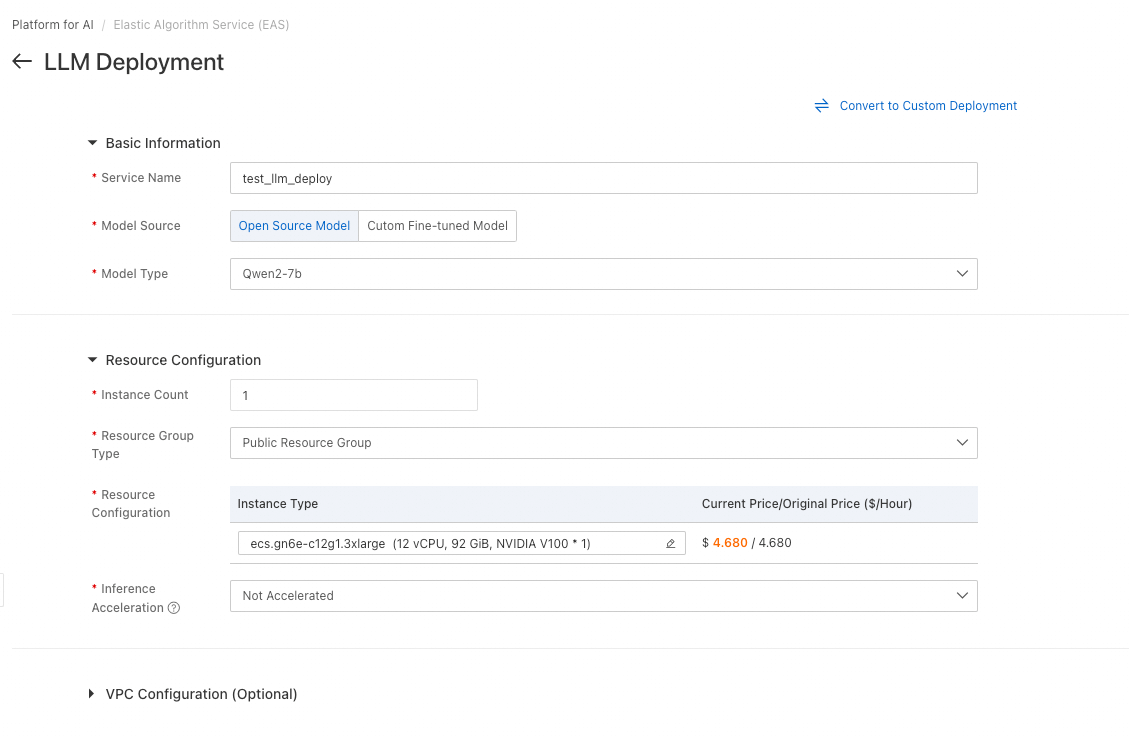

Untuk peluncuran contoh ini, Anda dapat mengikuti pengaturan seperti yang terlihat dalam tangkapan layar di atas:

• Beri nama layanan kita, misalnya test_service_deployment

• Pilih Model Sumber Terbuka, dan pilih model kecil seperti Qwen2-7b (catatan: berhati-hatilah agar tidak memilih versi 72b yang sangat besar secara tidak sengaja, itu sangat berbeda)

• Biarkan jenis instans default, tetapi hapus akselerasi (BladeLLM memerlukan jenis GPU berbeda, yang saat ini tidak penting untuk tutorial dasar ini)

Itu saja yang perlu kita ubah. Klik Sebarkan.

Tidak seperti penyebaran GenAI IaaS berbasis ECS, ini saja yang perlu kita lakukan untuk membuat infrastruktur! Hanya dalam beberapa klik dan dalam hitungan menit, infrastruktur kita sudah disiap.

Itulah keunggulan dan kemudahan menggunakan pendekatan Platform sebagai Layanan untuk GenAI.

Perlu waktu beberapa menit untuk menyelesaikan penyebaran, kemudian Anda akan melihat statusnya berubah menjadi Berjalan:

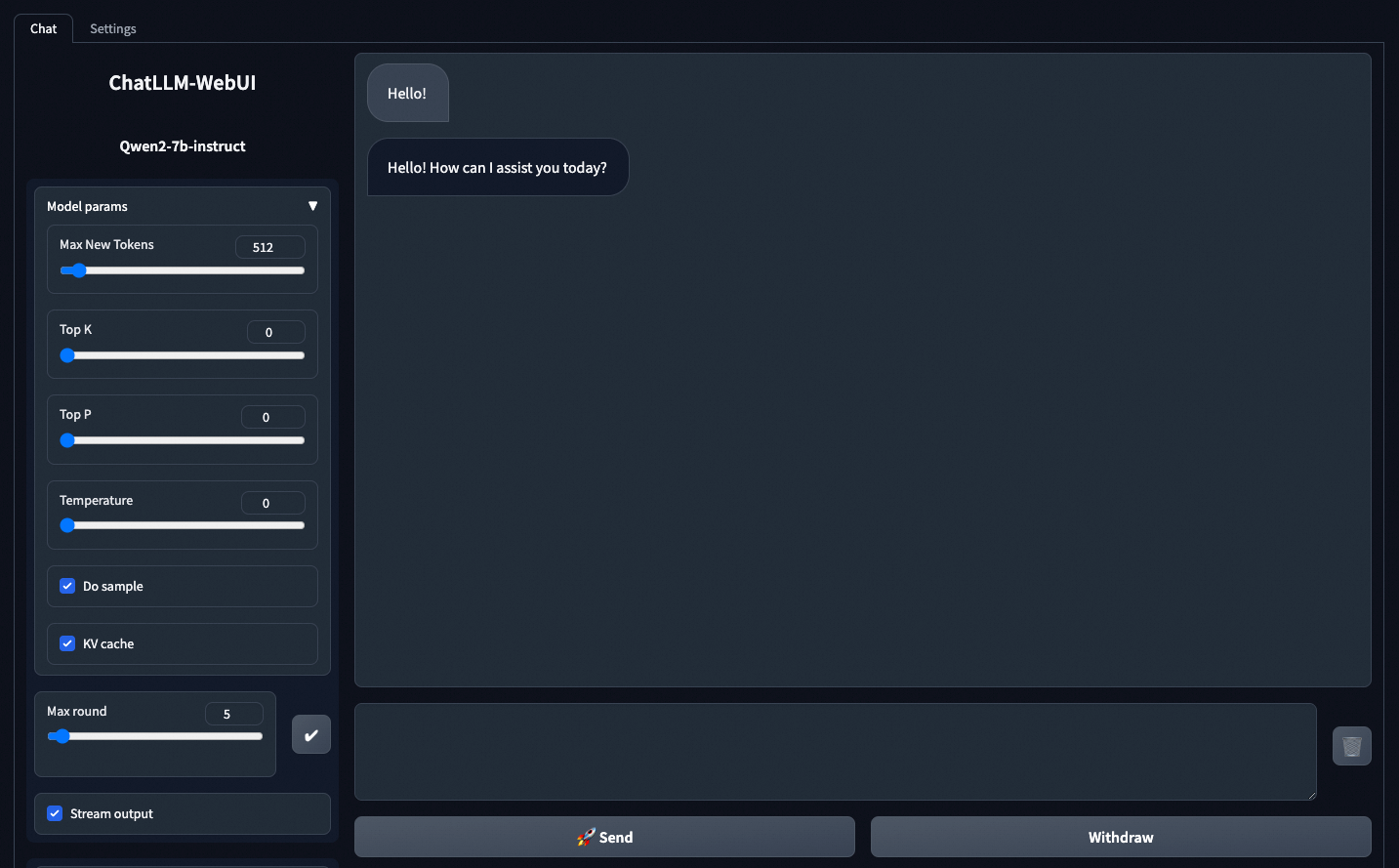

Terdapat tautan Lihat Aplikasi Web. Klik tautan tersebut untuk mengakses aplikasi obrolan demo bawaan layanan, yang memungkinkan Anda untuk menguji langsung dengan mudah:

Pesan pertama yang Anda kirim perlu sedikit waktu, karena LLM perlu waktu untuk dimuat ke dalam memori terlebih dahulu. Tetapi, pesan berikutnya, akan terkirim secepat kilat setelah pemuatan awal tersebut.

Tentu saja, aplikasi web itu bukan perhatian utama kita, itu hanya bonus. Sekarang mari mulai mengintegrasikan layanan LLM kita ke dalam aplikasi menggunakan API!

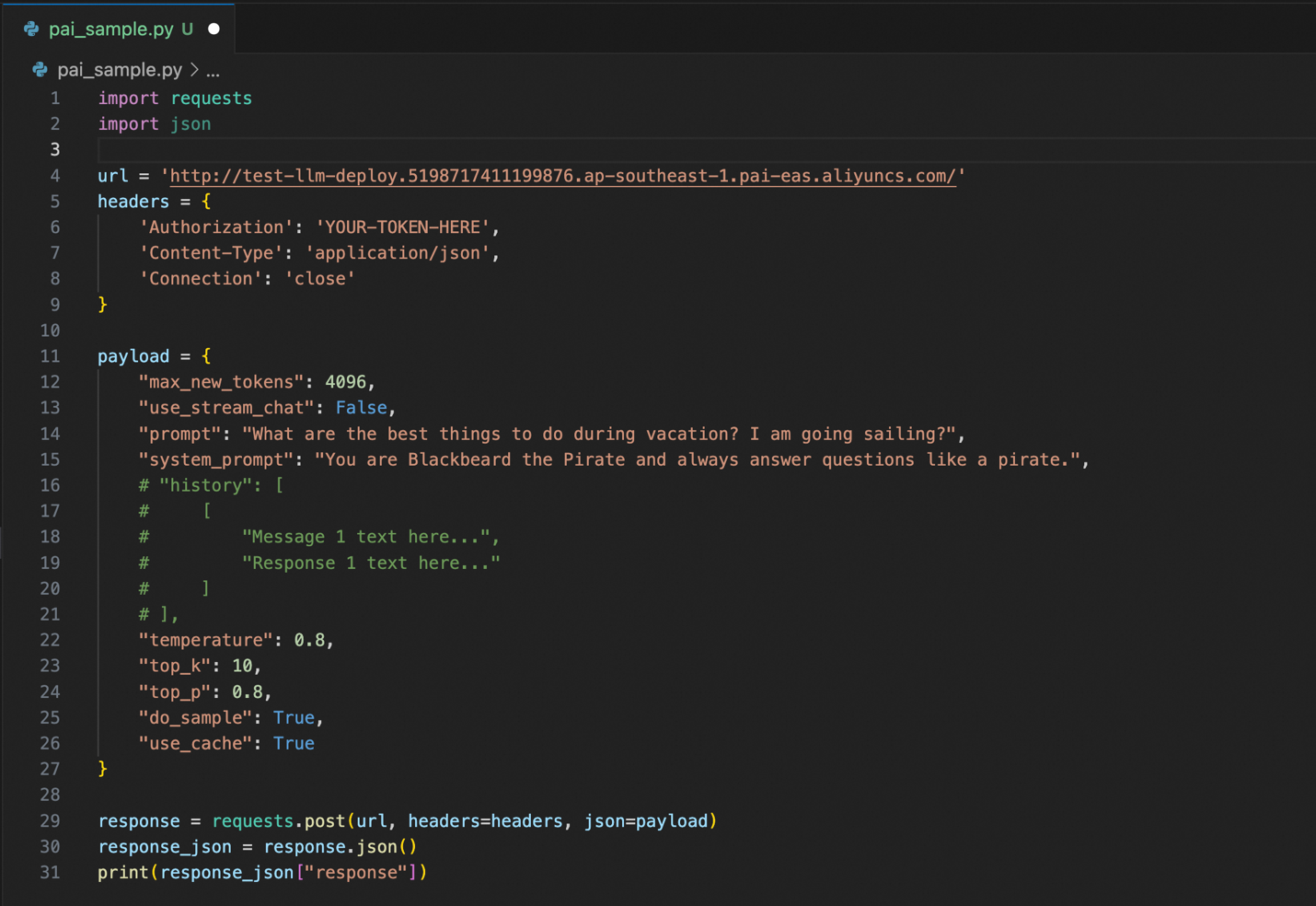

Berikut contoh kode yang menggunakan layanan API LLM kita yang baru disebar:

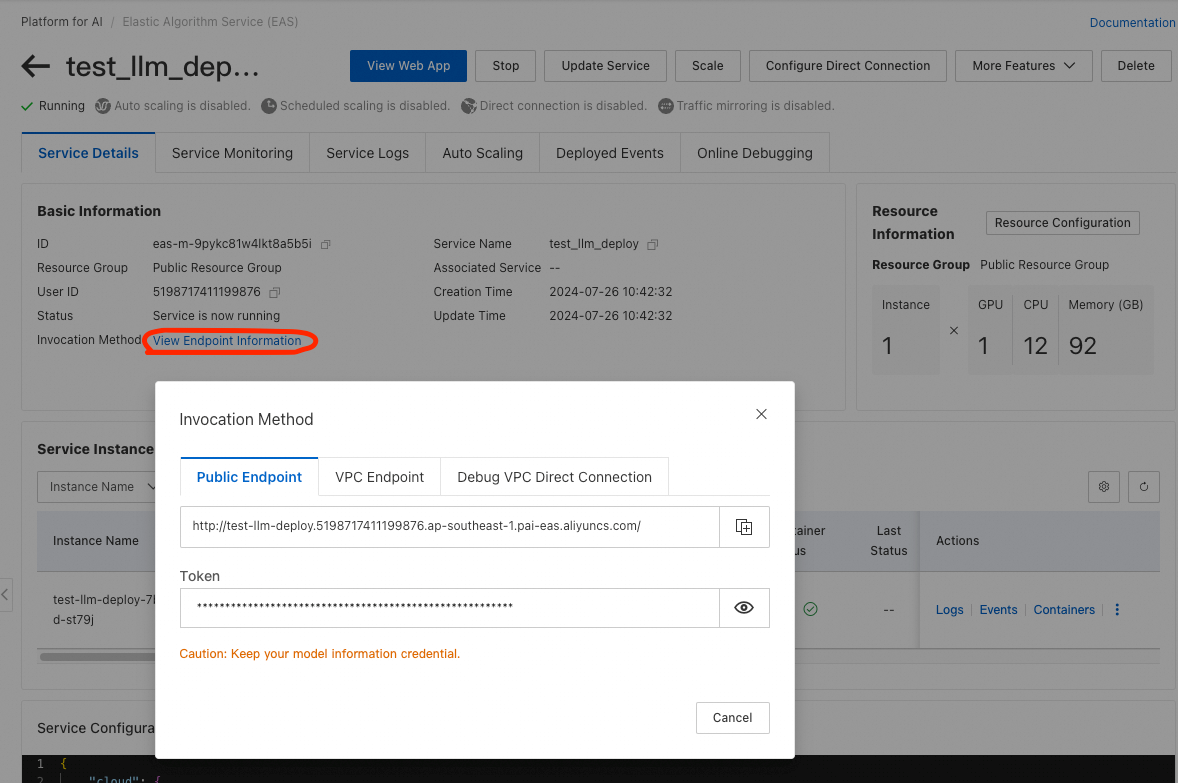

Anda harus mengubah parameter url dan Otorisasi (baris 4 dan 6) dengan parameter aktual Anda dari PAI EAS. Di konsol PAI EAS, klik nama layanan yang sebar, lalu klik Lihat Informasi Titik Akhir dari layar Detail Layanan yang muncul. Pop-up dengan URL titik akhir dan token autentikasi Anda akan muncul.

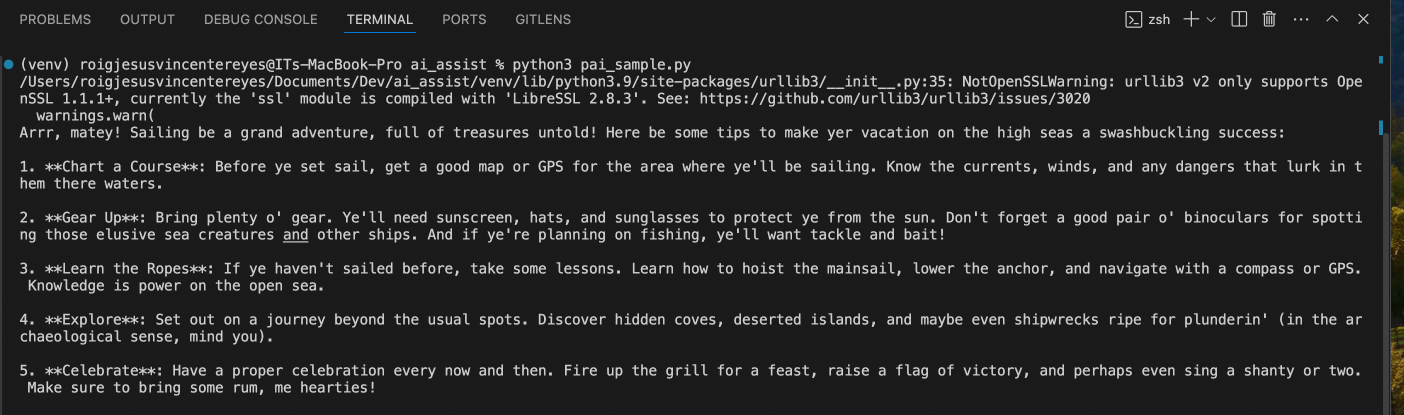

Kembali ke kode Python kita. Jika menjalankan kode Python tersebut, kita mendapatkan jawaban berikut:

Seperti dalam penyebaran GenAI berbasis ECS (IaaS), LLM merespons seperti bajak laut (karena perintah sistem kita) dan memberi kita ide untuk liburan berlayar (karena perintah kita).

Dibandingkan dengan penyebaran kita sebelumnya dari Bagian 1 dari seri ini, semuanya cukup mudah dan lebih cepat untuk disebarkan dan digunakan – dari hitungan jam hingga hitungan menit, dibandingkan dengan ECS!

Sekarang, Anda mungkin bertanya: JV, ada cara yang LEBIH CEPAT LAGI?

Ya, tentu saja!

Lain kali, di bagian 3, kita akan mempelajari cara yang lebih cepat itu: Model Studio Alibaba Cloud.

Sampai jumpa lagi!

TENTANG PENULIS: JV adalah seorang Arsitek Solusi Senior di Alibaba Cloud PH, dan memimpin strategi data dan AI generatif tim. Jika Anda merasa sesuatu dalam artikel ini relevan dengan beberapa masalah bisnis Anda saat ini, silakan hubungi JV di jv.roig@alibaba-inc.com.

Artikel ini diterjemahkan dari bahasa Inggris. Lihat artikel aslinya di sini.

99 posts | 4 followers

FollowRegional Content Hub - September 2, 2024

Regional Content Hub - September 2, 2024

Regional Content Hub - May 6, 2024

Regional Content Hub - April 1, 2024

Regional Content Hub - October 21, 2024

Regional Content Hub - June 24, 2024

99 posts | 4 followers

Follow Platform For AI

Platform For AI

A platform that provides enterprise-level data modeling services based on machine learning algorithms to quickly meet your needs for data-driven operations.

Learn More Tongyi Qianwen (Qwen)

Tongyi Qianwen (Qwen)

Top-performance foundation models from Alibaba Cloud

Learn More AI Acceleration Solution

AI Acceleration Solution

Accelerate AI-driven business and AI model training and inference with Alibaba Cloud GPU technology

Learn More Alibaba Cloud for Generative AI

Alibaba Cloud for Generative AI

Accelerate innovation with generative AI to create new business success

Learn MoreMore Posts by Regional Content Hub