Alibaba Cloud Container Service for Kubernetes (ACK) は Simple Log Service (SLS) と緊密に統合されています。この統合により、コンテナーログの収集と管理を簡素化するログ収集コンポーネントが提供されます。このトピックでは、ログ収集コンポーネントをインストールし、収集構成を作成する方法について説明します。これにより、ログを自動的に収集、クエリ、分析して、O&M 効率を向上させ、管理コストを削減できます。

シナリオ

ログ収集コンポーネントは、次の 2 つの方法でコンテナーログを収集します。

DaemonSet: このモードは、ログの分類が明確で、機能が比較的単純なクラスターに適しています。詳細については、このトピックをご参照ください。

Sidecar: このモードは、大規模なハイブリッドクラスターに適しています。詳細については、「Sidecar モードで Kubernetes コンテナーからテキストログを収集する」をご参照ください。

2 つのモードの違いの詳細については、「収集モード」をご参照ください。Simple Log Service の課金の詳細については、「課金の概要」をご参照ください。

インデックス

手順 | アクションリンク |

ステップ 1: ログ収集コンポーネントをインストールする | 次のいずれかのログ収集コンポーネントをインストールします。

|

ステップ 2: 収集構成を作成する | 収集要件に基づいて、テキストログまたは標準出力を選択します。

|

ステップ 3: ログのクエリと分析 | コンソールでログをクエリおよび分析します。 |

ステップ 1: ログ収集コンポーネントをインストールする

LoongCollector をインストールする (推奨)

LoongCollector ベースのデータ収集: LoongCollector は、Simple Log Service によって提供される新世代のログ収集エージェントです。LoongCollector は Logtail のアップグレードバージョンです。LoongCollector は、Application Real-Time Monitoring Service (ARMS) の特定の収集エージェントの機能 (Prometheus ベースのデータ収集や Extended Berkeley Packet Filter (eBPF) 技術ベースの非侵入型データ収集など) を統合することが期待されています。

既存の ACK クラスターに loongcollector コンポーネントをインストールする

ACK コンソールにログオンします。 左側のナビゲーションウィンドウで、[クラスター] をクリックします。

[クラスター] ページで、管理するクラスターをクリックします。左側のナビゲーションウィンドウで、[操作 > アドオン] を選択します。

アドオンページの[ログとモニタリング]タブで、loongcollector コンポーネントを見つけ、[インストール]をクリックします。

説明LoongCollector コンポーネントと logtail-ds コンポーネントは共存できません。logtail-ds コンポーネントがすでにクラスターにインストールされている場合は、「Logtail から LoongCollector へのアップグレード (サーバーシナリオ)」でアップグレードソリューションをご参照ください。

LoongCollector コンポーネントがインストールされると、Simple Log Service は自動的に k8s-log-${your_k8s_cluster_id} という名前のプロジェクトと、そのプロジェクト内のリソースを生成します。Simple Log Service コンソールにログインしてリソースを表示できます。次の表にリソースを示します。

リソースタイプ | リソース名 | 説明 | 例 |

マシン グループ | k8s-group- | loongcollector-ds のマシングループで、ログ収集シナリオで使用されます。 | k8s-group-my-cluster-123 |

k8s-group- | loongcollector-cluster のマシングループで、メトリック収集シナリオで使用されます。 | k8s-group-my-cluster-123-cluster | |

k8s-group- | 単一インスタンスのマシングループで、単一インスタンス用の LoongCollector 構成を作成するために使用されます。 | k8s-group-my-cluster-123-singleton | |

Logstore | config-operation-log | Logstore は、loongcollector-operator ログを収集および保存するために使用されます。 重要

| config-operation-log |

Logtail をインストールする

Logtail ベースのデータ収集: Logtail は、Simple Log Service によって提供されるログ収集エージェントです。Logtail を使用して、Alibaba Cloud Elastic Compute Service (ECS) インスタンス、データセンターのサーバー、サードパーティのクラウドサービスプロバイダーのサーバーなど、複数のデータソースからログを収集できます。Logtail は、ログファイルに基づく非侵入型のログ収集をサポートしています。アプリケーションコードを変更する必要はなく、ログ収集はアプリケーションの操作に影響しません。

既存の ACK クラスターに Logtail コンポーネントをインストールする

ACK コンソールにログインします。左側のナビゲーションウィンドウで、[クラスター] をクリックします。

クラスター ページで、管理するクラスターを見つけてその名前をクリックします。左側のナビゲーションウィンドウで、[アドオン] をクリックします。

[ログとモニタリング] タブで、logtail-ds コンポーネントを見つけて [インストール] をクリックします。

ACK クラスターを作成するときに Logtail コンポーネントをインストールする

ACK コンソールにログインします。左側のナビゲーションウィンドウで、[クラスター] をクリックします。

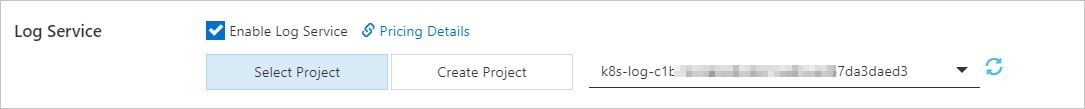

[クラスター] ページで、[Kubernetes クラスターの作成] をクリックします。ウィザードの [コンポーネント構成] ステップで、[Log Service を有効にする] を選択します。

このトピックでは、Simple Log Service に関連する設定のみを説明します。その他の設定の詳細については、「ACK マネージドクラスターの作成」をご参照ください。

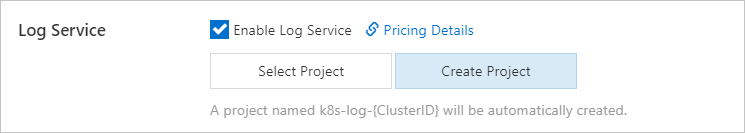

[Log Service を有効にする] を選択すると、Simple Log Service プロジェクトを作成するように求められます。次のいずれかの方法を使用してプロジェクトを作成できます。

[プロジェクトの選択]

既存のプロジェクトを選択して、収集されたコンテナーログを管理できます。

[プロジェクトの作成]

Simple Log Service は、収集されたコンテナーログを管理するためのプロジェクトを自動的に作成します。

ClusterIDは、作成された Kubernetes クラスターの一意の識別子を示します。

ウィザードの [コンポーネント構成] ステップで、コントロールプレーンコンポーネントログパラメーターの [有効] がデフォルトで選択されています。[有効] を選択すると、システムは自動的に収集設定を構成し、クラスターのコントロールプレーンコンポーネントからログを収集し、収集されたログに対して従量課金の課金方法に基づいて課金されます。ビジネス要件に基づいて [有効] を選択するかどうかを決定できます。詳細については、「ACK マネージドクラスターのコントロールプレーンコンポーネントのログを収集する」をご参照ください。

Logtail コンポーネントがインストールされると、Simple Log Service は自動的に k8s-log-<YOUR_CLUSTER_ID> という名前のプロジェクトと、そのプロジェクト内のリソースを生成します。Simple Log Service コンソールにログインしてリソースを表示できます。

リソースタイプ | リソース名 | 説明 | 例 |

マシングループ | k8s-group- | logtail-daemonset のマシングループで、ログ収集シナリオで使用されます。 | k8s-group-my-cluster-123 |

k8s-group- | logtail-statefulset のマシングループで、メトリック収集シナリオで使用されます。 | k8s-group-my-cluster-123-statefulset | |

k8s-group- | 単一インスタンスのマシングループで、単一インスタンス用の Logtail 構成を作成するために使用されます。 | k8s-group-my-cluster-123-singleton | |

Logstore | config-operation-log | Logstore は、alibaba-log-controller コンポーネントのログを保存するために使用されます。Logstore の Logtail 構成を作成しないことをお勧めします。Logstore は削除できます。Logstore が削除されると、システムは alibaba-log-controller コンポーネントの操作ログを収集しなくなります。Logstore は、通常の Logstore と同じ方法で課金されます。詳細については、「データ取り込み量に応じた課金モードの課金項目」をご参照ください。 | なし |

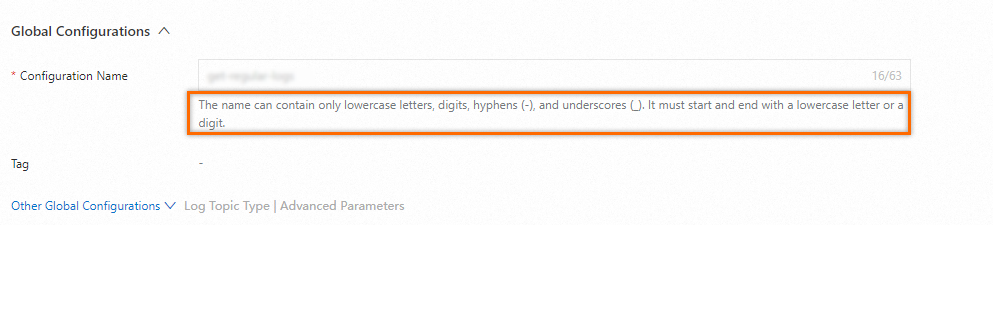

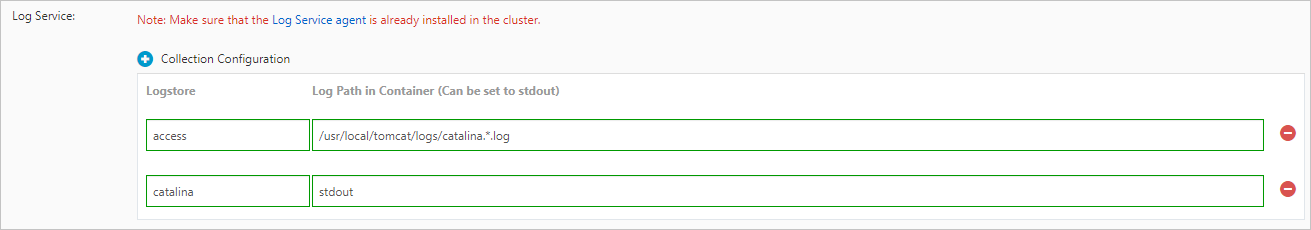

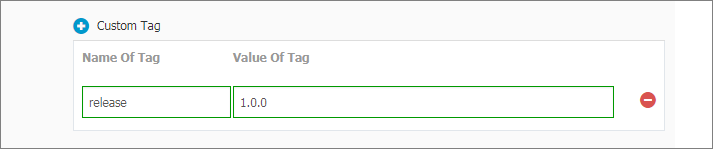

ステップ 2: 収集構成を作成する

ステップ 3: ログのクエリと分析

Simple Log Service コンソールにログインします。

[プロジェクト] セクションで、詳細ページに移動するプロジェクトをクリックします。

左側のナビゲーションウィンドウで、目的の Logstore の

アイコンをクリックします。ドロップダウンリストで、[検索と分析] を選択して、Kubernetes クラスターから収集されたログを表示します。

アイコンをクリックします。ドロップダウンリストで、[検索と分析] を選択して、Kubernetes クラスターから収集されたログを表示します。

デフォルトのログフィールド

テキストログ

標準出力

次の表に、Kubernetes クラスター内の各ログについてデフォルトでアップロードされるフィールドを示します。

フィールド | 説明 |

_time_ | ログが収集された時刻。 |

_source_ | ログソースのタイプ。有効な値: stdout および stderr。 |

_image_name_ | イメージの名前。 |

_container_name_ | コンテナーの名前。 |

_pod_name_ | Pod の名前。 |

_namespace_ | Pod の名前空間。 |

_pod_uid_ | Pod の一意の識別子。 |

参考

ログを収集した後、Simple Log Service のクエリおよび分析機能を使用してログを理解できます。詳細については、「ログのクエリと分析」をご参照ください。

ログを収集した後、Simple Log Service の可視化機能を使用してログを視覚的に分析および理解できます。詳細については、「ダッシュボードの作成」をご参照ください。

ログを収集した後、Simple Log Service のアラート機能を使用して、ログの例外に関する通知を自動的に受信できます。詳細については、「アラートルールの設定」をご参照ください。

デフォルトでは、Simple Log Service は増分ログのみを収集します。履歴ログを収集するには、「ログファイルから履歴ログをインポートする」をご参照ください。

収集エラーのトラブルシューティング:

コンソールにエラーメッセージが表示されるかどうかを確認します。詳細については、「Logtail 収集エラーの表示」をご参照ください。

コンソールにエラーメッセージが表示されない場合は、マシングループのハートビートと Logtail 構成を確認してください。詳細については、「コンテナーからのログ収集時のエラーのトラブルシューティング」をご参照ください。