โดย Farruh

ในยุค Generative AI (GenAI) โมเดลภาษาขนาดใหญ่ (Large Language Model หรือ LLM) ไม่ได้จำกัดอยู่แค่ข้อความอีกต่อไป โมเดลที่รองรับข้อมูลหลายรูปแบบอย่าง Qwen2.5 Omni จะอุดช่องโหว่ระหว่างข้อความ รูปภาพ เสียง และวิดีโอ จึงทำให้ AI สามารถคิด มองเห็น รับฟัง และพูดได้เสมือนมนุษย์อย่างเรา

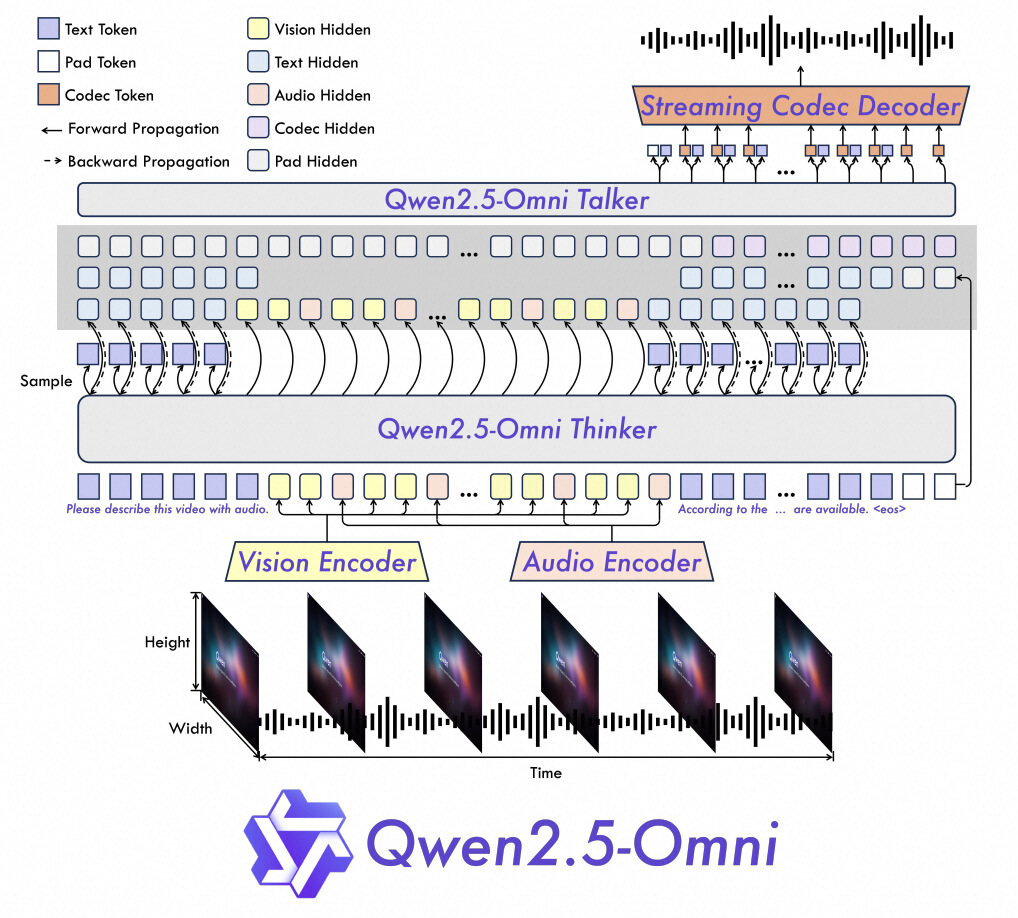

1. การเข้ารหัสทางตำแหน่ง TMRoPE:

2. สถาปัตยกรรม Thinker-Talker:

3. ประสิทธิภาพการสตรีม:

| งาน | Qwen2.5-Omni | Qwen2.5-VL | GPT-4o-Mini | ล้ำสมัย |

|---|---|---|---|---|

| รูปภาพ→ข้อความ | 59.2 (MMMUval) | 58.6 | 60.0 | 53.9 (อื่นๆ) |

| วิดีโอ→ข้อความ | 72.4 (วิดีโอ-MME) | 65.1 | 64.8 | 63.9 (อื่นๆ) |

| การให้เหตุผลที่รองรับข้อมูลหลายรูปแบบ | 81.8 (MMBench) | ไม่มี | 76.0 | 80.5 (อื่นๆ) |

| การสร้างเสียงพูด | 1.42% WER (จีน) | ไม่มี | ไม่มี | 2.33% (อังกฤษ) |

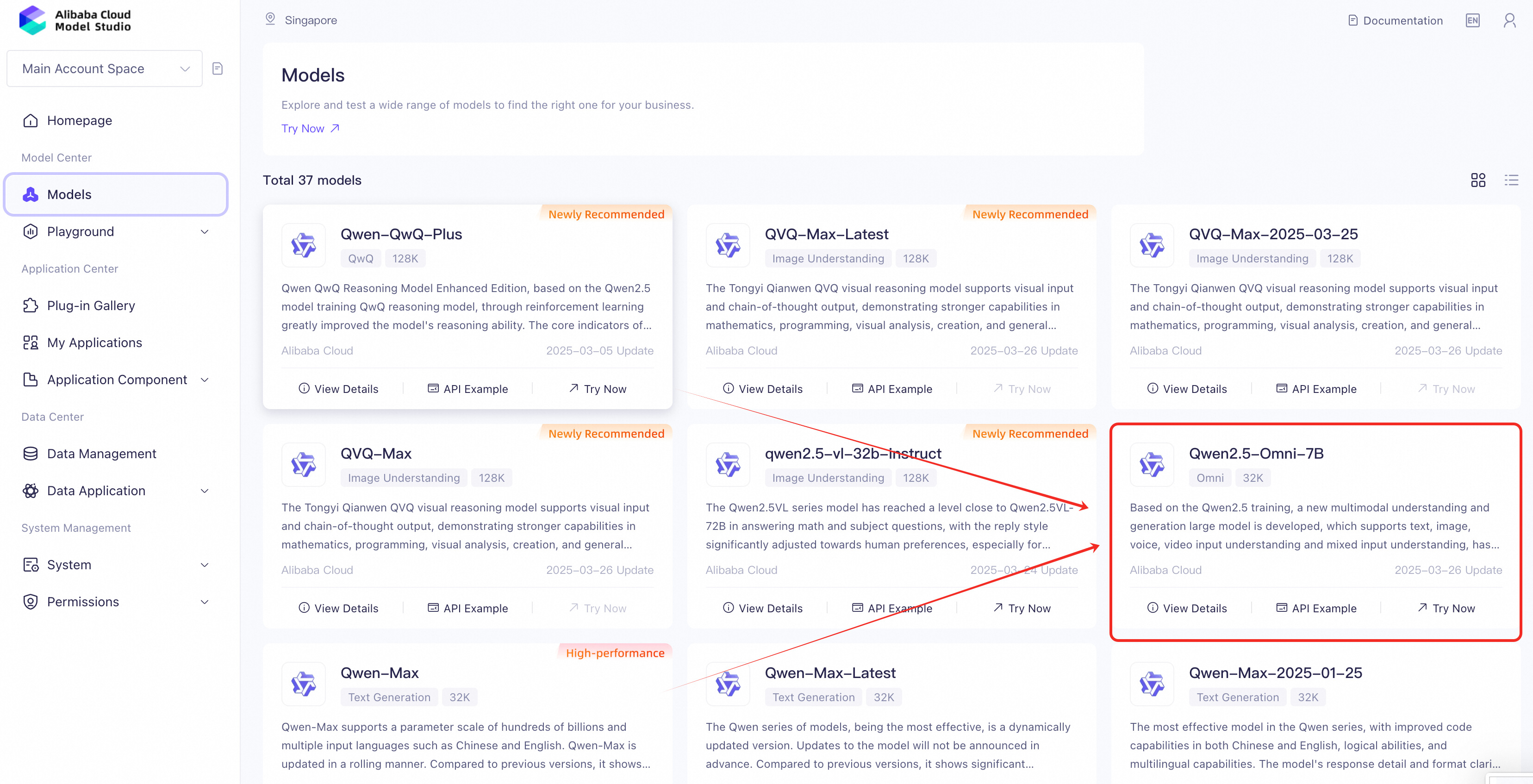

1. ไปที่ Alibaba Cloud ModelStudio หรือหน้าข้อมูลเบื้องต้นเกี่ยวกับ Model Studio

2. ค้นหา “Qwen2.5-Omni” แล้วไปที่หน้าดังกล่าว

3. อนุญาตให้เข้าถึงโมเดล (ฟรีสำหรับการใช้งานพื้นฐาน)

การตั้งค่าเพื่อการรักษาความปลอดภัย:

1. สร้างสภาพแวดล้อมเสมือน (แนะนำ):

python -m venv qwen-env

source qwen-env/bin/activate # Linux/MacOS | Windows: qwen-env\Scripts\activate2. ติดตั้งความสัมพันธ์พึ่งพิง:

pip install openai3. จัดเก็บคีย์ API อย่างปลอดภัย: สร้างไฟล์ .env ในไดเรกทอรีโครงการของคุณ:

DASHSCOPE_API_KEY=your_api_key_hereใช้ไลบรารี OpenAI เพื่อโต้ตอบกับ Qwen2.5-Omni:

import os

from openai import OpenAI

client = OpenAI(

api_key=os.getenv("DASHSCOPE_API_KEY"),

base_url="https://dashscope-intl.aliyuncs.com/compatible-mode/v1",

)

# Example: Text + Audio Output

completion = client.chat.completions.create(

model="qwen2.5-omni-7b",

messages=[{"role": "user", "content": "Who are you?"}],

modalities=["text", "audio"], # Specify output formats (text/audio)

audio={"voice": "Chelsie", "format": "wav"},

stream=True, # Enable real-time streaming

stream_options={"include_usage": True},

)

# Process streaming responses

for chunk in completion:

if chunk.choices:

print("Partial response:", chunk.choices[0].delta)

else:

print("Usage stats:", chunk.usage)| คุณสมบัติ | รายละเอียด |

|---|---|

| ประเภทอินพุต | ข้อความ รูปภาพ เสียง วิดีโอ (ผ่าน URL/Base64) |

| รูปแบบข้อมูลเอาต์พุต | ระบุพารามิเตอร์ modalities (เช่น ["text", "audio"] สำหรับเอาต์พุตคู่) |

| การรองรับการสตรีม | ผลลัพธ์แบบเรียลไทม์ผ่าน stream=True

|

| การรักษาความปลอดภัย | ตัวแปรสภาพแวดล้อมสำหรับคีย์ API (ไฟล์ .env) |

กรณีการใช้งาน: การใส่คำบรรยายงานกิจกรรมสดด้วยการตรวจจับอารมณ์

กรณีการใช้งาน: สร้างคำอธิบายสินค้าจากรูปภาพและรีวิวจากผู้ใช้

# อินพุต: รูปภาพสินค้า + "เขียนรีวิว 5 ดาวในภาษาสเปน"

# เอาต์พุต: ข้อความรีวิว + เวอร์ชันเสียงในภาษาสเปน 1. ขีดจำกัดขนาดไฟล์:

2. ปรับให้เหมาะกับการสตรีม:

stream=True เพื่อให้ได้เอาต์พุตแบบเรียลไทม์

ขณะที่ GenAI พัฒนาก้าวหน้า ขีดความสามารถในการรองรับข้อมูลหลายรูปจะแพร่หลายในอุตสาหกรรมต่างๆ ตั้งแต่การดูแลสุขภาพไปจนถึงความบันเทิง การมีความเชี่ยวชาญเกี่ยวกับ Qwen2.5 Omni จะพาคุณก้าวเข้าสู่ยุคแห่งการทำงานร่วมกันระหว่างมนุษย์กับ AI ยุคใหม่

เริ่มทดลองใช้เลยวันนี้แล้วร่วมปฏิวัติวงการไปด้วยกัน!

บทความนี้แปลจากภาษาอังกฤษ ดูบทความต้นฉบับที่นี่

104 posts | 4 followers

FollowRegional Content Hub - April 22, 2024

Regional Content Hub - May 7, 2024

Regional Content Hub - April 7, 2024

Regional Content Hub - August 12, 2024

Regional Content Hub - September 18, 2024

Regional Content Hub - November 11, 2024

104 posts | 4 followers

Follow Tongyi Qianwen (Qwen)

Tongyi Qianwen (Qwen)

Top-performance foundation models from Alibaba Cloud

Learn More Alibaba Cloud for Generative AI

Alibaba Cloud for Generative AI

Accelerate innovation with generative AI to create new business success

Learn More AI Acceleration Solution

AI Acceleration Solution

Accelerate AI-driven business and AI model training and inference with Alibaba Cloud GPU technology

Learn More Platform For AI

Platform For AI

A platform that provides enterprise-level data modeling services based on machine learning algorithms to quickly meet your needs for data-driven operations.

Learn MoreMore Posts by Regional Content Hub

Start building with 50+ products and up to 12 months usage for Elastic Compute Service

Get Started for Free Get Started for Free