MaxCompute リソースクォータを購入し、クォータを Platform for AI (PAI) に関連付けてモデルを開発し、関連するジョブを MaxCompute に送信して大規模な分散トレーニングを実行できます。このトピックでは、MaxCompute リソースについて説明し、リソースを設定する方法について説明します。

MaxCompute リソース

MaxCompute は、Software as a Service (SaaS) モデルを使用するエンタープライズレベルのクラウドデータウェアハウスです。 MaxCompute は、データ分析を伴うシナリオに適しています。サーバーレスアーキテクチャで、高速で完全に管理されたオンラインデータウェアハウスサービスを提供します。 MaxCompute は、リソースの拡張性と弾力性という点で従来のデータプラットフォームの制約を取り除き、O&M コストを最小限に抑え、低コストで大規模なデータの効率的な処理と分析を可能にします。詳細については、「MaxCompute とは」をご参照ください。

MaxCompute リソースの種類

PAI は MaxCompute の CPU リソースをサポートしています。 PAI では、CPU リソースは MaxCompute と同じ方法で課金されます。以下のリソースがサポートされています。

標準の従量課金制リソース(推奨)

標準のサブスクリプションリソース

MaxCompute リソースの以下のカテゴリについて課金されます。[計算リソース]、[ストレージリソース]、および [データのアップロードとダウンロードのリソース]。ほとんどの場合、PAI のトレーニングジョブでは [データのアップロードとダウンロードのリソース] は必要ありません。

従量課金制の計算リソースを使用する場合、計算ジョブによって発生した料金は PAI で課金されますが、SQL ジョブなどの他のジョブによって発生した料金は MaxCompute で課金されます。

項目 | 標準の従量課金制リソース(推奨) | 標準のサブスクリプションリソース |

計算リソース (トレーニングジョブで使用) | リソースは共有リソースプールから取得されます。このリソースカテゴリを使用する場合、MaxCompute プロジェクトの計算ジョブは、必要に応じてリソースプール内のリソースをプリエンプトできます。 | リソースには、専用計算リソースと共有計算リソースが含まれます。共有計算リソースはオプションです。 |

ストレージリソース (トレーニング結果テーブルの保存に使用) | リソースは共有リソースプールから取得されます。リソースプール内のストレージリソースをオンデマンドで使用できます。 | リソースは共有リソースプールから取得されます。リソースプール内のストレージリソースをオンデマンドで使用できます。 |

計算リソースの課金ルール | ||

ストレージリソースの課金ルール | 該当なし | |

シナリオ | 柔軟なストレージスペースが必要なプロジェクト。 | ビジネスのために作成され、適切に実行されているプロジェクト。 |

アカウントと権限の要件

Alibaba Cloud アカウント(推奨):Alibaba Cloud アカウントを使用すると、追加の承認なしですべての操作を完了できます。

RAM ユーザー:

RAM ユーザーを使用して MaxCompute リソースを購入する場合、RAM ユーザーに

AliyunBSSOrderAccess権限とAliyunDataWorksFullAccess権限を付与する必要があります。詳細については、「RAM ユーザーを準備する」をご参照ください。RAM ユーザーを使用して MaxCompute リソースをワークスペースに関連付けるには、ワークスペースで RAM ユーザーに管理者ロールを割り当てる必要があります。詳細については、「ワークスペースのメンバーを管理する」をご参照ください。

MaxCompute リソースを使用して Machine Learning Designer でモデルをトレーニングするには、ワークスペースで RAM ユーザーに MaxCompute 開発者ロールを割り当てる必要があります。詳細については、「ワークスペースのメンバーを管理する」をご参照ください。

MaxCompute をアクティブ化し、MaxCompute リソースを購入する

ニーズに応じて MaxCompute 購入ページ にアクセスして、MaxCompute リソースを購入できます。

MaxCompute リソースの使用と管理

購入した MaxCompute リソースグループを PAI ワークスペースに関連付けると、ワークスペース内のグループにジョブをデプロイできます。また、MaxCompute コンソールの従量課金制クォータグループページでリソースグループを管理することもできます。

MaxCompute リソースグループをワークスペースに関連付ける

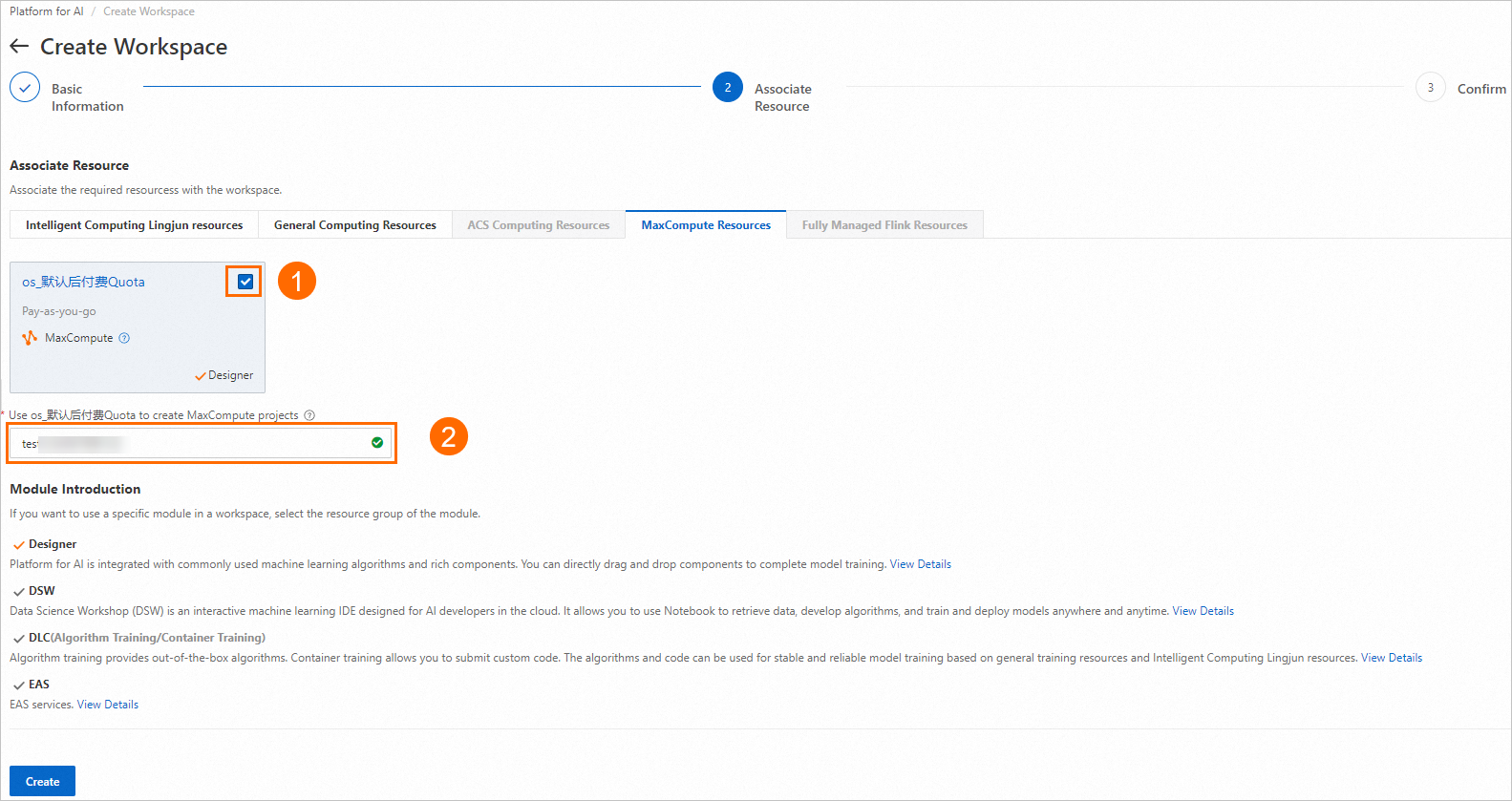

ワークスペースを作成するときに、MaxCompute リソースクォータをワークスペースに関連付け、プロジェクトの名前を編集できます。詳細については、「ワークスペースの作成と管理」をご参照ください。ワークスペースで作成されたすべてのトレーニングジョブに、関連付けられた MaxCompute リソースを使用できます。

ワークスペースの作成後、ワークスペースに関連付けられている MaxCompute プロジェクトを変更することもできます。詳細については、「ワークスペースの管理 - 計算リソースの設定」をご参照ください。

MaxCompute リソースを管理する

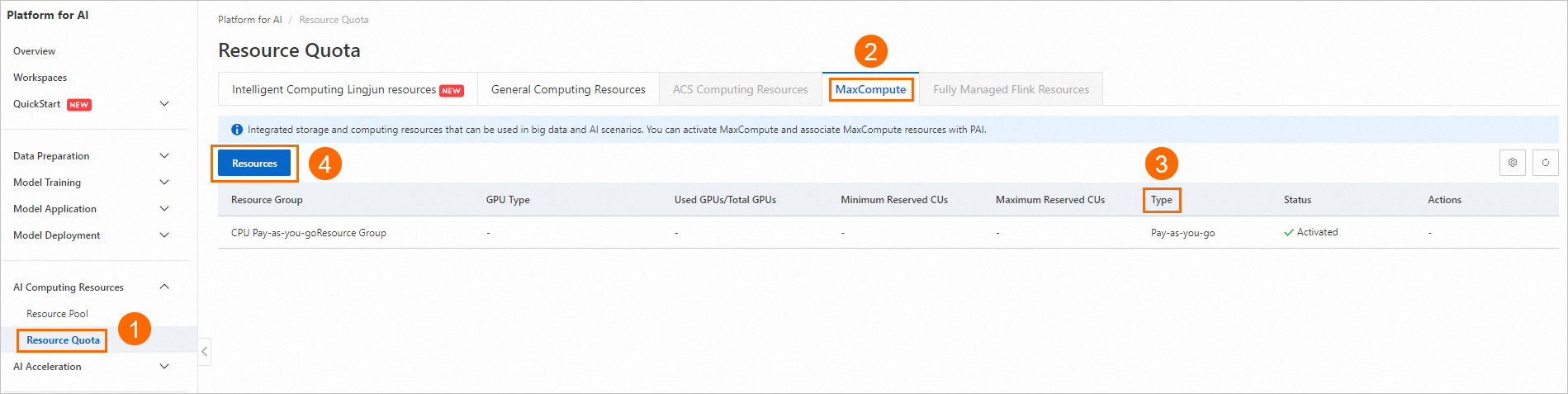

PAI コンソール にログインし、 を選択して、現在のリージョンで使用可能な MaxCompute リソースを表示します。

MaxCompute CU クォータの合計と MaxCompute リソースの課金方法を表示できます。

[リソース] をクリックして MaxCompute コンソールに移動し、従量課金制リソースのクォータを管理できます。クォータの管理方法の詳細については、「MaxCompute コンソールで計算リソースのクォータを管理する」トピックの「クォータグループを設定する」セクションをご参照ください。