Bon, humains férus de technologie, préparez-vous pour une aventure palpitante au pays de l’intelligence artificielle ! Nous ne faisons pas que tremper nos orteils ici, nous plongeons la tête la première dans le grand bain avec le modèle de chat Qwen. Qu'y a-t-il à l'ordre du jour? Mettre en place un chatbot plus malin qu'un renard et respecter la confidentialité comme un agent secret de premier ordre. Intrigué ? Vous devriez l'être ! Commençons notre parcours par comprendre l'IA générative et le LLM.

IA générative fait référence à la branche de l'intelligence artificielle axée sur la création de nouveaux contenus, qu'il s'agisse de textes, d'images, de musique ou d'autres formes de médias. Ce type d'IA exploite des modèles d'apprentissage automatique, en particulier des modèles génératifs, pour comprendre les modèles, les caractéristiques et les relations dans de grands ensembles de données et générer des résultats nouveaux et souvent impossibles à distinguer du contenu créé par l'Homme.

L’IA générative continue d’évoluer rapidement et ses capacités repoussent les limites de ce que les machines peuvent créer, offrant à la fois des opportunités passionnantes et des défis qui doivent être gérés de manière responsable.

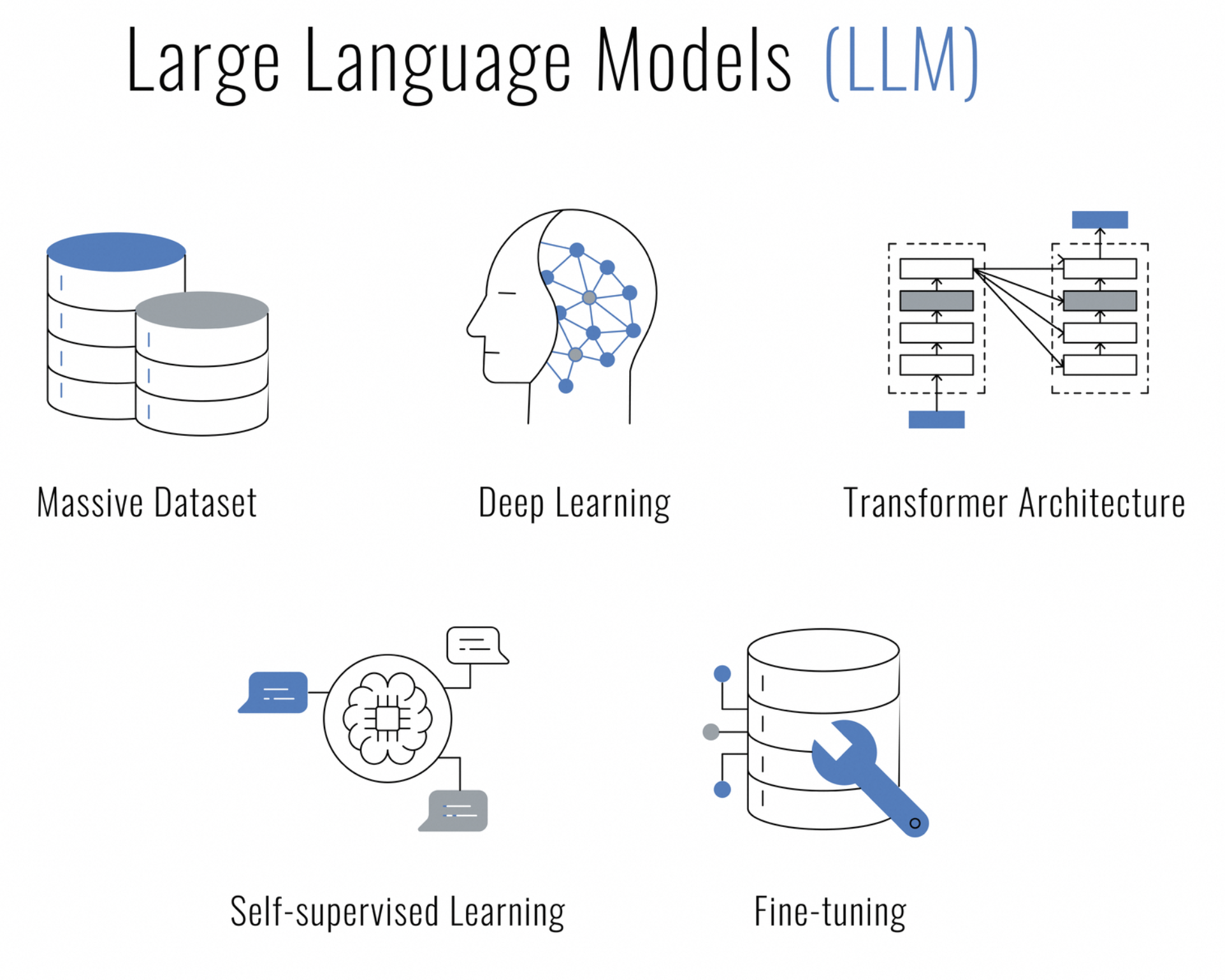

Que sont les grands modèles de langage (LLM) ? Il s'agit d'un type d'intelligence artificielle basé sur des techniques d'apprentissage en profondeur conçues pour comprendre, générer et travailler avec le langage humain. Ils sont appelés « grands » car ils sont constitués de plusieurs millions, voire milliards, de paramètres, qui leur permettent de capturer un large éventail de nuances et de contextes linguistiques.

Les LLM sont entraînés sur de grandes quantités de données textuelles et utilisent des architectures telles que les réseaux neuronaux transformateur, qui ont la capacité de traiter des séquences de données (comme des phrases) et de prêter attention à différentes parties de la séquence lors des prédictions. Cela les rend particulièrement efficaces pour une gamme de tâches de traitement du langage naturel (NLP), telles que :

Êtes-vous à la recherche d’une IA capable de discuter, de créer du contenu, de résumer, de coder et bien plus encore, tout en respectant votre droit à la confidentialité ? Ne cherchez pas plus loin, le modèle de chat Qwen est là pour transformer votre centre de données en un bastion d'interactions sécurisées alimentées par l'IA.

Qwen n'est pas votre chatbot ordinaire. Il est construit sur un modèle linguistique massif et a été entraîné sur un nombre impressionnant de 3 000 milliards de jetons de données multilingues. Cette merveille d’IA comprend parfaitement l’anglais et le chinois et a été optimisée pour une interaction de type humain.

Déployer Qwen localement sur votre serveur consiste à prendre le contrôle. Il s'agit de garantir que les conversations que vous avez, les données traitées et la confidentialité promise restent sous votre contrôle. Que vous soyez une entreprise cherchant à intégrer un système de chat intelligent, un développeur passionné de recherche en IA ou simplement un passionné désireux d'explorer les limites de l'IA conversationnelle, Qwen est votre choix incontournable.

Maintenant, pourquoi voudriez-vous héberger ce LLM localement ? Trois mots : contrôle, vitesse et confidentialité. Vous gardez vos données secrètes, les réponses arrivent à la vitesse de l'éclair et vous pouvez être tranquille en sachant que votre chatbot ne divulgue pas vos secrets à tous les services publics.

L’esprit d’innovation dans l’IA est amplifié par la communauté open source. Conformément à cette tradition, le code source complet du modèle de chat Qwen est facilement disponible sur GitHub pour toute personne intéressée à se plonger dans les mécanismes du modèle, contribuant ainsi à son développement, ou simplement à l’utiliser comme ressource d’apprentissage. Que vous soyez chercheur, développeur ou amateur d'IA, vous pouvez accéder au code source sur Qwen.

Avant de nous lancer dans cette odyssée technologique, assurons-nous que vous soyez bien préparé :

Vous avez tout ? Formidable ! Mettons la main à la pâte (au sens figuré, bien sûr).

Que vous soyez un fan inconditionnel de Visual Studio Code, un passionné de PyCharm ou quelqu'un qui apprécie le style interactif des Jupyter Notebooks, le code Python pour discuter avec Qwen est flexible et compatible avec les IDE. Tout ce dont vous avez besoin est un environnement prenant en charge Python, et vous êtes prêt à donner vie à votre compagnon de chat IA.

Voici un conseil de pro : si vous utilisez VSCode, profitez du terminal intégré pour exécuter vos scripts Python de manière fluide. Ouvrez simplement la palette de commandes (Ctrl+Shift+P), tapez Python : « Exécuter le fichier Python dans le terminal », et laissez VSCode faire le gros du travail. Vous verrez les réponses de Qwen directement dans votre terminal intégré.

Pour ceux d'entre vous qui préfèrent PyCharm, l'exécution de votre code est tout aussi fluide. Faites un clic droit sur votre script et sélectionnez « Exécuter 'script_name.py' », et regardez l'IDE exécuter votre conversation avec Qwen. Les outils puissants et les fonctionnalités de débogage de PyCharm en font un excellent choix pour développer des interactions plus complexes.

Et cela ne s'arrête pas là : il existe toute une pléthore d'IDE et d'éditeurs de code qui accueillent Python à bras ouverts. Choisissez celui qui convient le mieux à votre flux de travail et commencez à discuter !

Tout d’abord, préparons votre serveur Linux. Assurez-vous que votre liste de paquets est aussi fraîche que la brise du matin et que la magie de Python et de pip soit prête à opérer :

sudo apt update

sudo apt install python3 python3-pipPassons maintenant à l’ingrédient secret : un environnement virtuel. C'est comme si vous disposiez d'un espace de travail personnel où vous pouvez mettre le bazar sans que personne ne vous crie dessus pour que vous nettoyiez :

pip install --user virtualenv

virtualenv qwen_env

source qwen_env/bin/activateAvant de donner vie à Qwen, vous aurez besoin de quelques outils. Considérez cela comme la collecte des ingrédients pour un repas étoilé au guide Michelin :

pip install torch torchvision torchaudio

pip install transformersN'oubliez pas d'associer PyTorch à votre version CUDA : c'est comme associer un bon vin avec le bon fromage.

Les mots ne sont que des mots jusqu'à ce que Qwen leur donne un sens. C'est là qu'intervient le tokenizer, transformant vos réflexions en quelque chose que Qwen peut digérer :

from transformers import AutoTokenizer

tokenizer = AutoTokenizer.from_pretrained("Qwen/Qwen-7B-Chat", trust_remote_code=True)L'esprit de Qwen est vaste et prêt à être rempli de vos conversations. Voici comment réveiller le géant endormi :

from transformers import AutoModelForCausalLM

model = AutoModelForCausalLM.from_pretrained("Qwen/Qwen-7B-Chat", device_map="auto", trust_remote_code=True).eval()Selon votre matériel, vous pouvez opter pour différents modes de précision comme BF16 ou FP16. C'est comme accorder votre guitare pour obtenir la tonalité parfaite.

Vient maintenant la partie palpitante : il est temps de discuter avec Qwen ! Mais avant de vous laisser emporter par ces échanges, parlons de quelque chose de crucial : l’art de la continuité de la conversation.

Voici un aperçu du genre de répartie auquel vous pouvez vous attendre :

response, history = model.chat(tokenizer, "Greetings, Qwen! How's life in the digital realm?", history=None)

print("Qwen:", response)Dans notre phrase d'ouverture, nous saluons Qwen sans aucune chaîne, c'est-à-dire sans historique de conversation. En définissant history=None, nous disons à Qwen : « C'est le début de notre discussion. » Qwen, avec rien d'autre que l'invite actuelle à continuer, répondra avec la fraîcheur d'une nouvelle interaction.

Maintenant, regardez la magie du contexte se dérouler :

response, history = model.chat(tokenizer, "Any thoughts on the meaning of life, the universe, and everything?", history=history)

print("Qwen:", response)Dans ce tour, nous transmettons l’historique que nous avons reçu de notre échange précédent. C'est comme donner à Qwen un journal de tout ce dont nous avons parlé jusqu'à présent. Avec ce contexte historique, Qwen peut élaborer une réponse qui n'est pas seulement spirituelle ou profonde, mais également liée à notre conversation en cours. C'est la différence entre discuter avec un ami avisé qui vous connaît et poser des questions à un inconnu.

Maintenant que vous comprenez l'importance du contexte avec le paramètre d'historique, lancez ce script de démonstration et préparez-vous à une conversation engageante avec Qwen. Que vous discutiez du cosmos ou de la meilleure recette de cookies numériques, Qwen est prête à suivre votre conversation avec toute la grâce d'un interlocuteur chevronné.

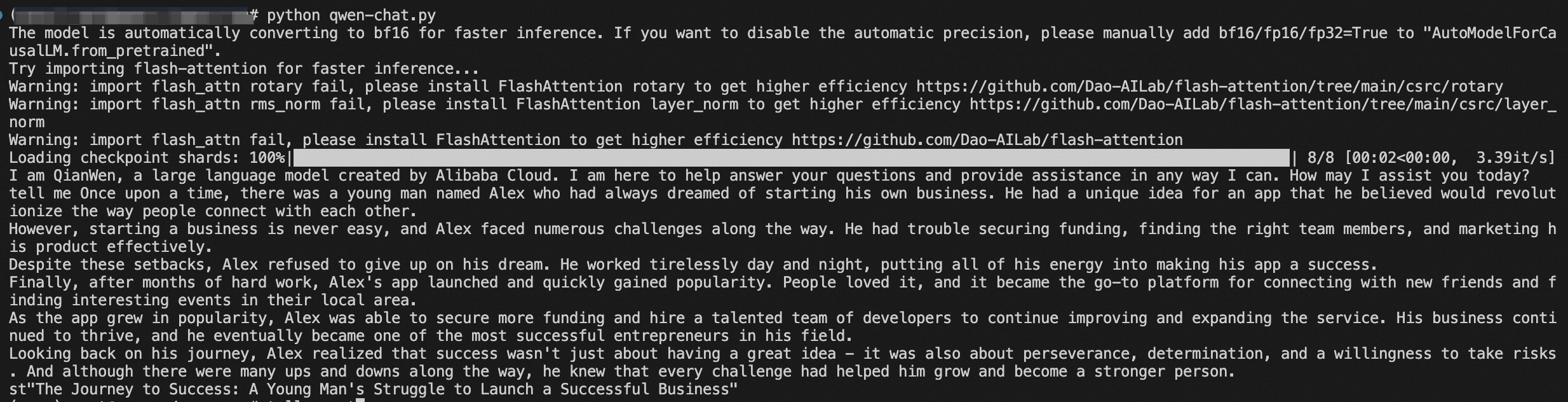

De plus, vous pouvez également lancer ce script et démarrer la conversation. C'est comme ouvrir la boîte de Pandore, mais au lieu du chaos, vous obtenez de délicieuses plaisanteries :

python qwen_chat.pyEt voilà, mon ami, vous avez votre propre compagnon de chat IA, prêt à conquérir le monde de la conversation.

Félicitations ! Vous avez navigué dans les eaux dangereuses du déploiement de l'IA comme un capitaine expérimenté. Qwen est désormais parfaitement installé sur votre serveur et vos données sont aussi sécurisées que vos maisons.

Explorez les capacités de Qwen, contribuez à son développement et rejoignez une communauté de personnes partageant les mêmes idées et désireuses de faire progresser l'état des conversations de l'IA.

Alors, allez-y et engagez-vous dans des dialogues épiques avec votre tout nouveau acolyte à l'IA. Et qui sait ? Peut-être que Qwen vous surprendra avec sa sagesse numérique ou une blague qui vous fera rire à vous rouler par terre.

Cet article a été initialement rédigé en anglais. Consultez l'article original ici.

Die Bereitstellung des QWEN-Chat-Modells mit HuggingFace-Handbuch

99 posts | 4 followers

FollowRegional Content Hub - April 28, 2024

Regional Content Hub - April 28, 2024

Regional Content Hub - April 1, 2024

Alibaba Cloud Community - May 22, 2024

Tran Phuc Hau - July 15, 2024

Alibaba Cloud Community - August 16, 2024

99 posts | 4 followers

Follow Tongyi Qianwen (Qwen)

Tongyi Qianwen (Qwen)

Top-performance foundation models from Alibaba Cloud

Learn More Offline Visual Intelligence Software Packages

Offline Visual Intelligence Software Packages

Offline SDKs for visual production, such as image segmentation, video segmentation, and character recognition, based on deep learning technologies developed by Alibaba Cloud.

Learn More Network Intelligence Service

Network Intelligence Service

Self-service network O&M service that features network status visualization and intelligent diagnostics capabilities

Learn More Alibaba Cloud Model Studio

Alibaba Cloud Model Studio

A one-stop generative AI platform to build intelligent applications that understand your business, based on Qwen model series such as Qwen-Max and other popular models

Learn MoreMore Posts by Regional Content Hub