Do JV Roig viết

Chào mừng bạn đến với phần 2 trong loạt bài về phương pháp triển khai AI tạo sinh trên Alibaba Cloud.

Trong phần 1 của loạt bài này, chúng ta đã tìm hiểu về cách triển khai genAI thông qua IaaS (Infrastructure as a Service) bằng cách sử dụng Elastic Compute Service (ECS). Như chúng ta đã thấy ở phần 1, đây là một phương pháp rất hiệu quả và linh hoạt để triển khai AI tạo sinh. Rất tiếc là phương pháp này có rất nhiều bước và mất nhiều chi phí quản lý vì chúng ta chịu trách nhiệm vận hành và bảo trì toàn bộ ngăn xếp.

Có phương pháp nào đơn giản hơn, nhanh hơn và tốn ít chi phí hơn không? Có!

Hôm nay, chúng ta sẽ tìm hiểu về phương pháp PaaS (Platform as a Service) bằng cách sử dụng Platform for AI (PAI) của Alibaba Cloud. Chúng ta sẽ xem phương pháp PaaS giúp chúng ta giảm chi phí vận hành và triển khai các dịch vụ AI tạo sinh hữu ích chỉ trong vài phút như thế nào.

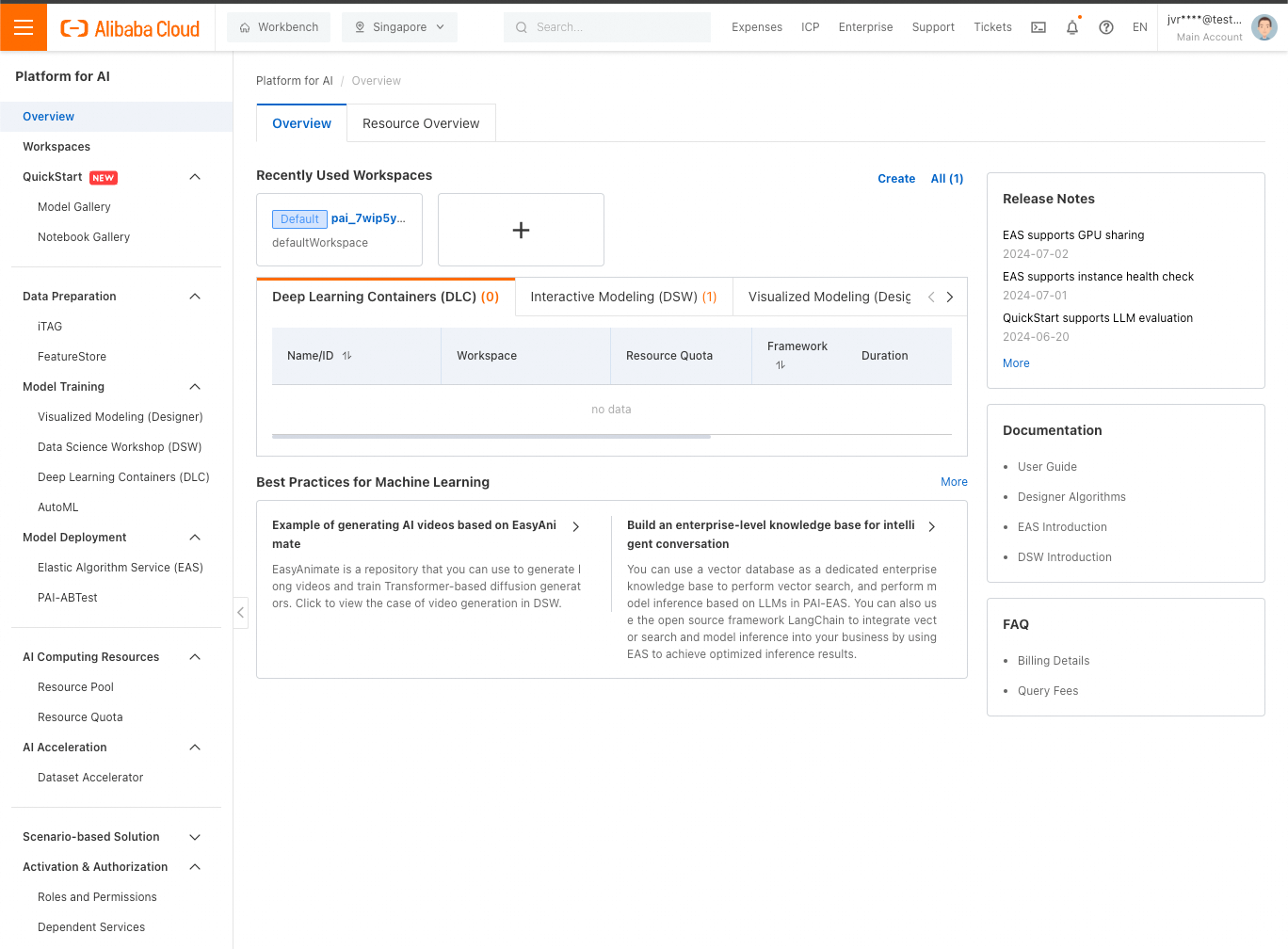

Đăng nhập vào bảng điều khiển web Alibaba Cloud của bạn, sau đó tìm kiếm PAI. Nhấp vào kết quả xuất hiện (Platform for AI), bạn sẽ thấy bảng điều khiển PAI:

Chúng ta có thể nhanh chóng triển khai LLM từ QuickStart (gần đầu thanh bên trái) hoặc EAS/Elastic Algorithm Service (gần giữa thanh bên trái). Trong cả hai trường hợp, dịch vụ này đều được triển khai dưới dạng phiên bản EAS. Do đó, dù thế nào đi chăng nữa thì cuối cùng bạn cũng sẽ tạo EAS.

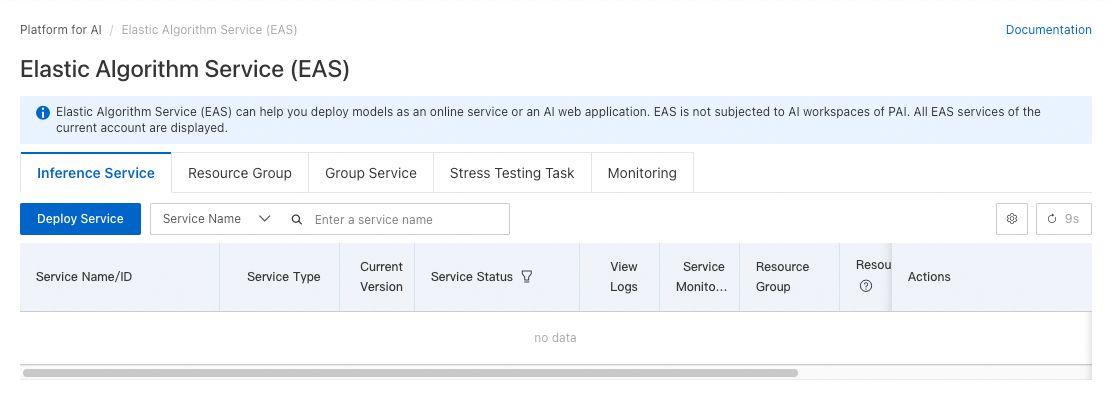

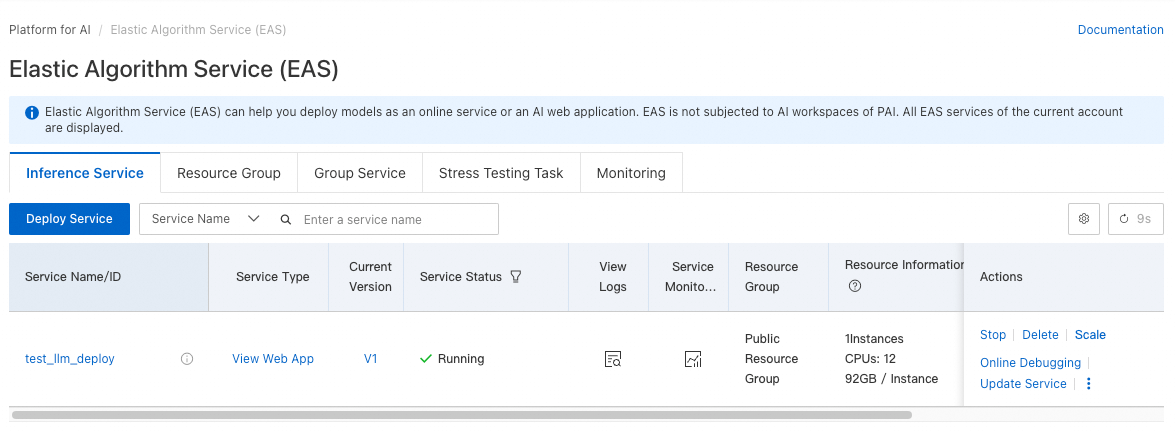

Chúng ta hãy cùng tìm hiểu chi tiết hơn về EAS. Nhấp vào Elastic Algorithm Service bên dưới Model Deployment, bạn sẽ thấy màn hình này:

Nhấp vào Deploy Service.

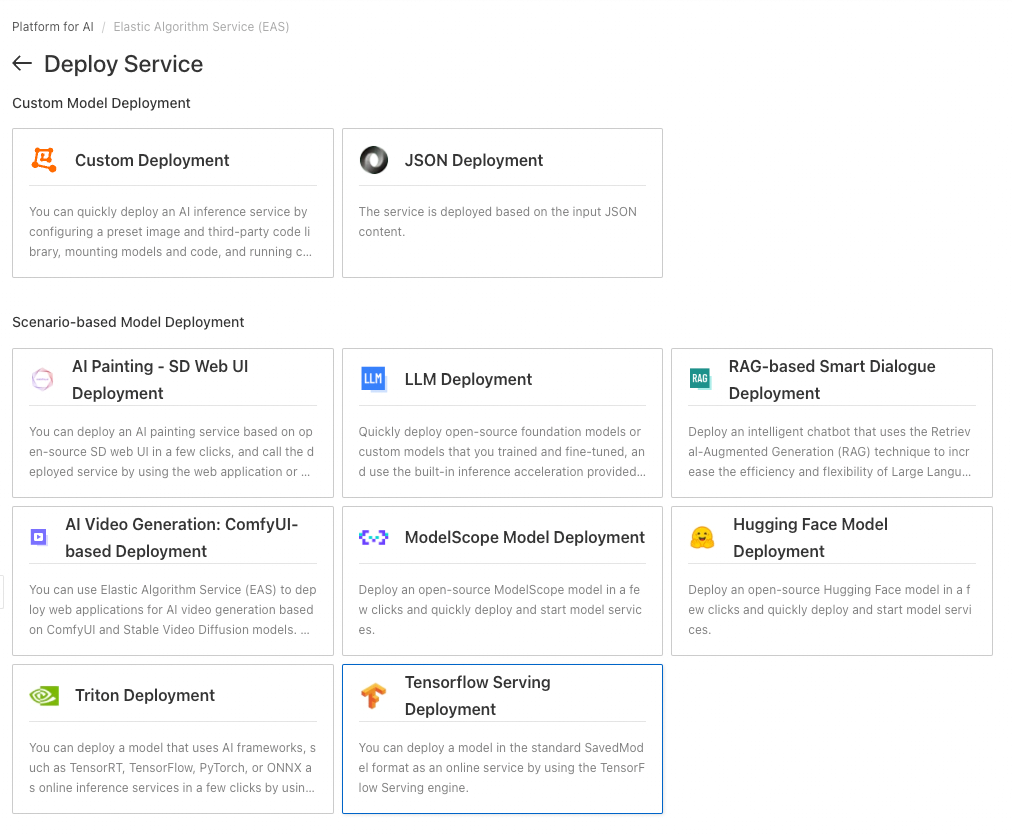

Trong hướng dẫn này, hãy nhấp vào LLM Deployment trong Scenario-based Model Deployment.

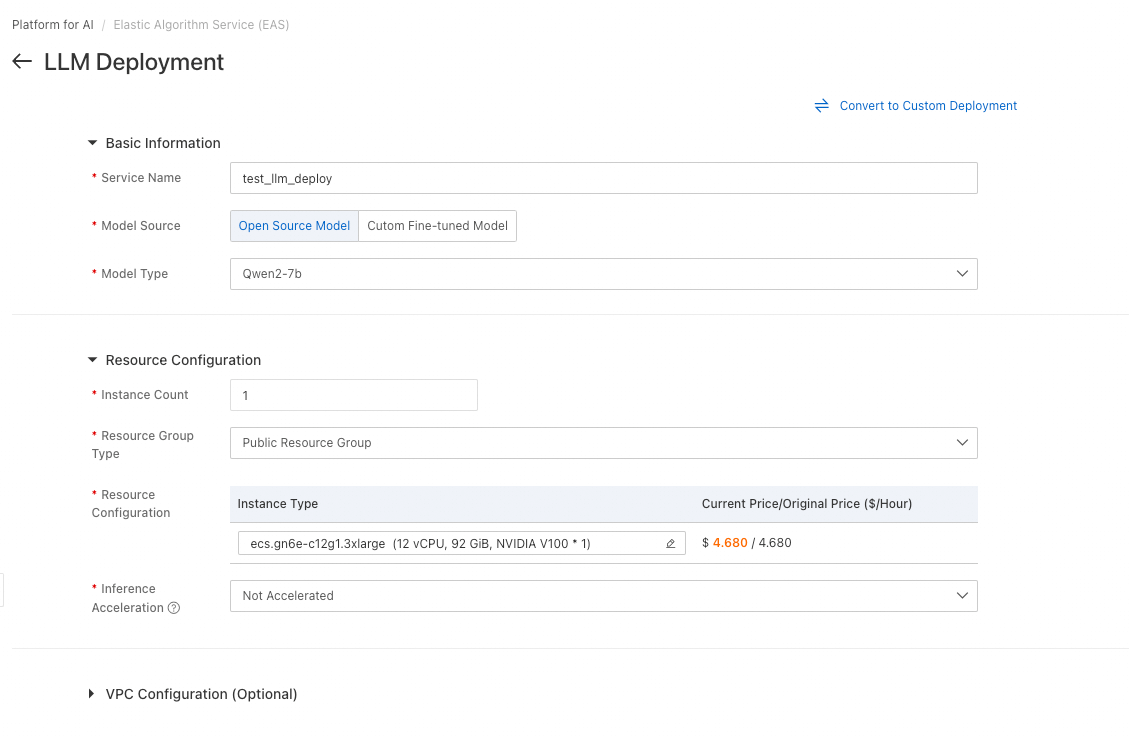

Để triển khai mẫu này, bạn có thể cài đặt giống như trong ảnh chụp màn hình bên trên:

• Chúng ta sẽ đặt tên cho dịch vụ của mình, chẳng hạn như test_service_deployment

• Chúng ta sẽ chọn Open Source Model và chọn một mô hình nhỏ như Qwen2-7b (lưu ý: hãy cẩn thận để không vô tình chọn phiên bản 72b quá lớn, rất khác biệt)

• Chúng tôi sẽ giữ nguyên loại phiên bản mặc định, nhưng loại bỏ chức năng tăng tốc (BladeLLM cần một loại GPU khác; hiện tại thì chuyện đó không quan trọng đối với hướng dẫn cơ bản này)

Đó là tất cả những gì chúng ta cần thay đổi. Nhấp vào Deploy.

Không giống như khi triển khai genAI thông qua IaaS dựa trên ECS của chúng ta, đây là tất cả những gì chúng ta cần làm để tạo cơ sở hạ tầng! Chỉ cần vài cú nhấp chuột và mất vài phút là chúng ta đã tạo được cơ sở hạ tầng của mình.

Đó chính là sức mạnh và sự tiện lợi khi sử dụng phương pháp Platform-as-a-Service cho genAI.

Có thể sẽ mất vài phút để hoàn tất việc triển khai, sau đó bạn sẽ thấy trạng thái thay đổi thành Running:

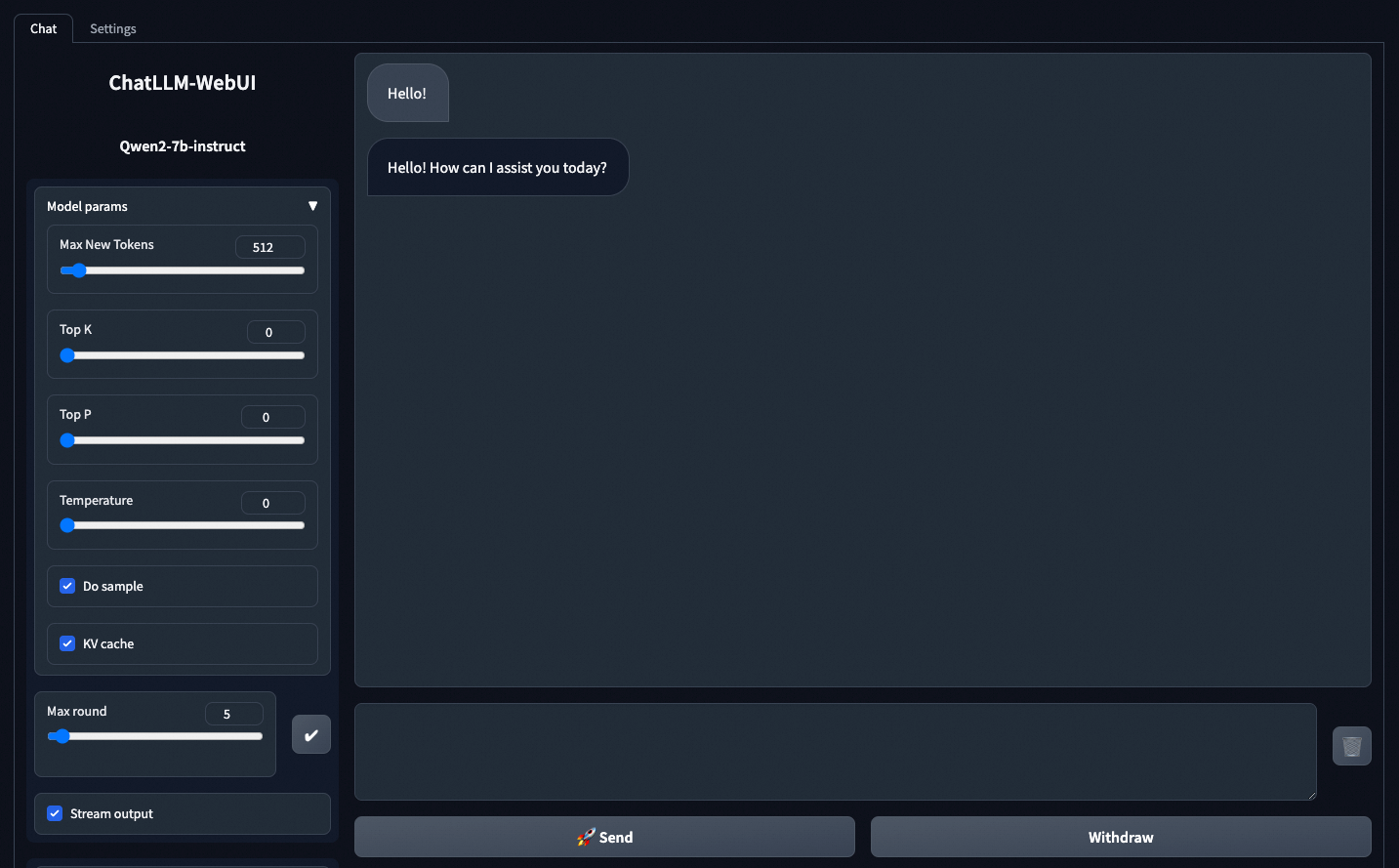

Có một liên kết View Web App. Hãy nhấp vào đó để truy cập ứng dụng trò chuyện minh họa được tích hợp sẵn trong dịch vụ, giúp bạn dễ dàng kiểm tra thực tế:

Tin nhắn đầu tiên bạn gửi sẽ mất một chút thời gian vì lúc đầu LLM cần thời gian để tải vào bộ nhớ. Tuy nhiên, tin nhắn tiếp theo sẽ nhanh như chớp sau lần tải đầu tiên đó.

Tất nhiên, ứng dụng web đó không phải là mối quan tâm chính của chúng ta, đó chỉ là phần tăng thêm mà thôi. Bây giờ, chúng ta hãy bắt đầu tích hợp dịch vụ LLM vào ứng dụng của mình bằng API!

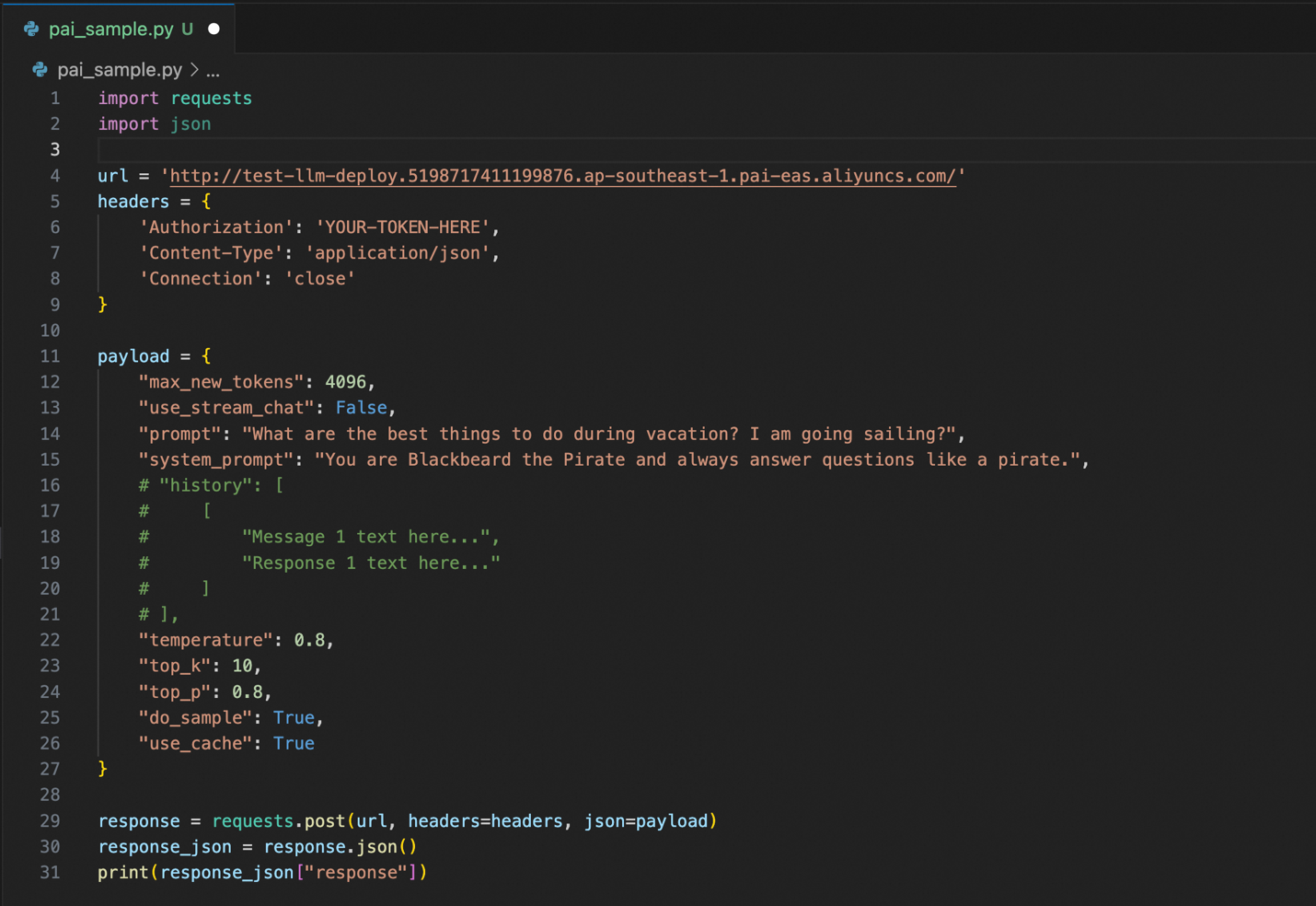

Sau đây là mã mẫu sử dụng dịch vụ API LLM mà chúng ta mới triển khai:

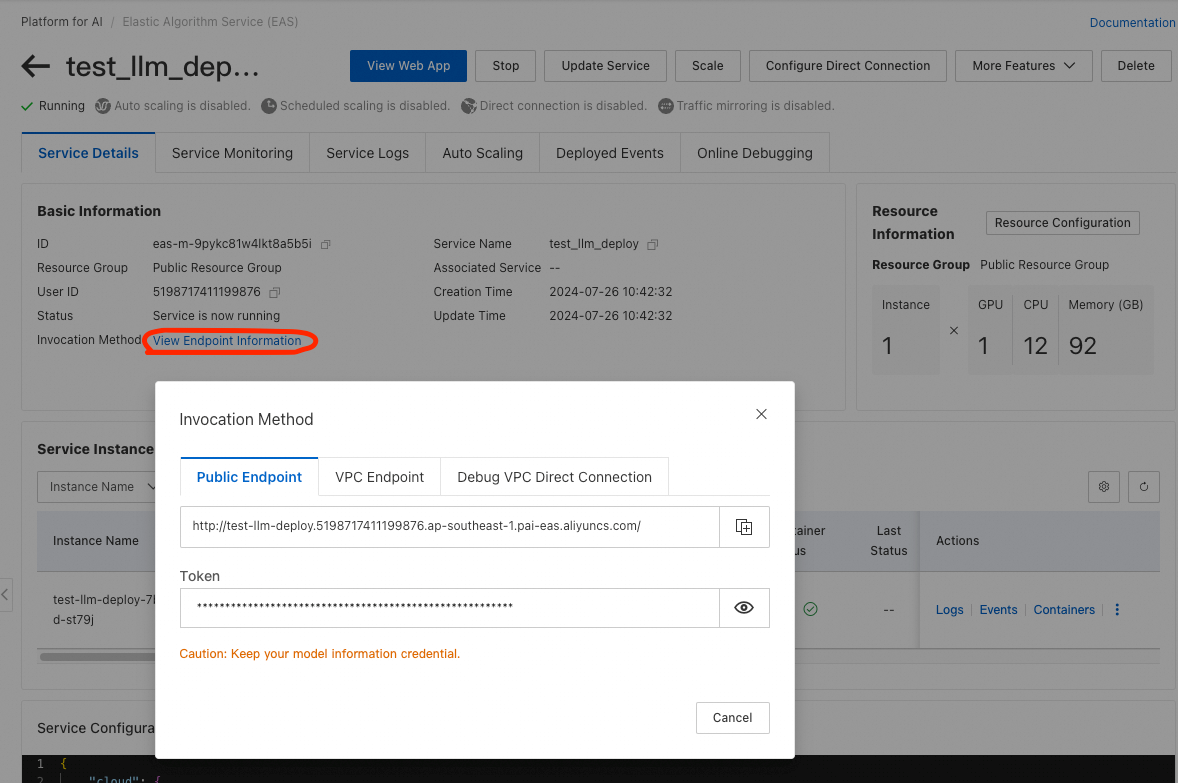

Bạn sẽ phải thay đổi các thông số url và Authorization (dòng 4 và 6) bằng các thông số thực tế từ PAI EAS. Trong bảng điều khiển PAI EAS, hãy nhấp vào tên dịch vụ bạn đã triển khai, sau đó nhấp vào View Endpoint Information từ màn hình Service Details. Một cửa sổ bật lên có URL điểm cuối và token xác thực của bạn sẽ xuất hiện.

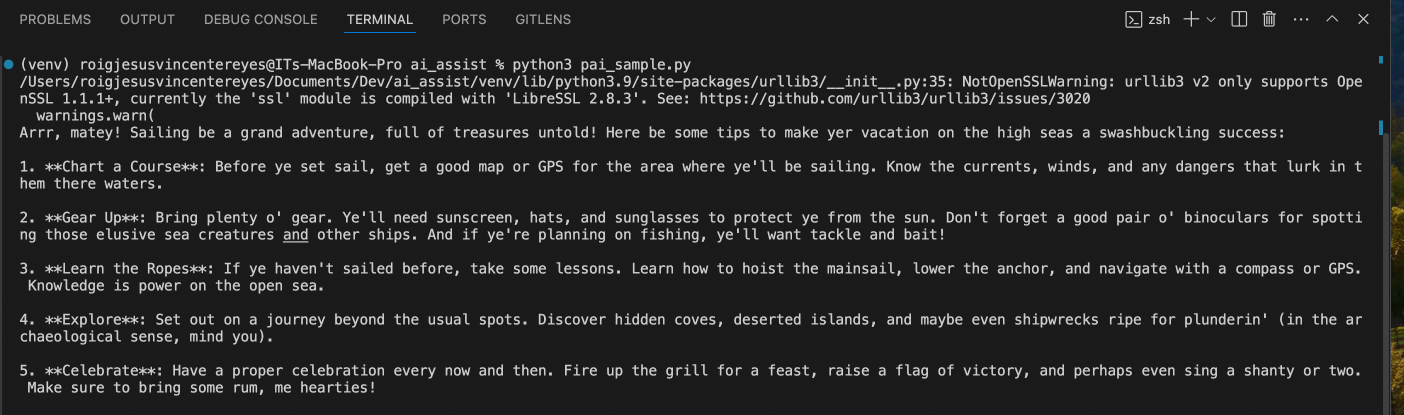

Quay lại với mã Python của chúng ta. Nếu chạy mã Python đó, chúng ta sẽ nhận được phản hồi sau đây:

Giống như khi chúng ta triển khai genAI dựa trên ECS (IaaS), LLM phản hồi như một tên cướp biển (do gợi ý của hệ thống) và đã đưa ra cho chúng ta những ý tưởng cho kỳ nghỉ đi thuyền của mình (do gợi ý của chúng ta).

So với lần trước chúng ta triển khai từ Phần 1 trong loạt bài này, mọi thứ đều dễ dàng và nhanh hơn khi triển khai và sử dụng – từ vài giờ xuống còn vài phút, so với ECS!

Bây giờ, có thể bạn sẽ hỏi: JV, có cách nào NHANH HƠN NỮA không?

Có chứ!

Lần tới, trong Phần 3, chúng ta sẽ xem xét phương pháp thậm chí còn nhanh hơn nữa: Alibaba Cloud Model Studio.

Hẹn gặp lại bạn khi đó nhé!

GIỚI THIỆU VỀ TÁC GIẢ: JV là Kiến trúc sư giải pháp cao cấp tại Alibaba Cloud PH, lãnh đạo chiến lược AI tạo sinh và dữ liệu của đội ngũ. Nếu bạn nghĩ bất kỳ điều gì trong bài viết này có liên quan đến một số vấn đề kinh doanh hiện tại của mình, vui lòng liên hệ với JV qua jv.roig@alibaba-inc.com.

Bài viết này được dịch từ tiếng Anh. Xem bài viết gốc tại đây.

99 posts | 4 followers

FollowRegional Content Hub - August 29, 2024

Regional Content Hub - August 29, 2024

Alibaba Cloud Vietnam - January 1, 2024

Regional Content Hub - August 5, 2024

Alibaba Cloud Vietnam - December 25, 2023

Regional Content Hub - May 13, 2024

99 posts | 4 followers

Follow Platform For AI

Platform For AI

A platform that provides enterprise-level data modeling services based on machine learning algorithms to quickly meet your needs for data-driven operations.

Learn More Tongyi Qianwen (Qwen)

Tongyi Qianwen (Qwen)

Top-performance foundation models from Alibaba Cloud

Learn More DBStack

DBStack

DBStack is an all-in-one database management platform provided by Alibaba Cloud.

Learn More EasyDispatch for Field Service Management

EasyDispatch for Field Service Management

Apply the latest Reinforcement Learning AI technology to your Field Service Management (FSM) to obtain real-time AI-informed decision support.

Learn MoreMore Posts by Regional Content Hub