執筆担当者:Jawad

Tongyi Qianwen-7B (Qwen-7B) は、Alibaba Cloud が開発した Tongyi Qianwen 大規模モデルシリーズの 70 億パラメータースケールモデルです。

Qwen-7B は Transformerに基づく大規模言語モデル (LLM) であり、非常に大規模な事前トレーニングデータでトレーニングされています。 事前トレーニングデータの型は多様であり、多数のオンラインテキスト、専門的な本、コードなどを含む広範囲の領域を網羅しています。

モデルの詳細については、以下をご参照ください。

https://www.modelscope.cn/models/qwen/Qwen-7B-Chat/files

この記事では、Tongyi Qianwen-7B モデルと対話するための 2 つのアプローチについて説明します。1 つは GUI (Graphical User Interface) を使用し、もう 1 つは CLI (Command Line Interface) を使用します。

注:

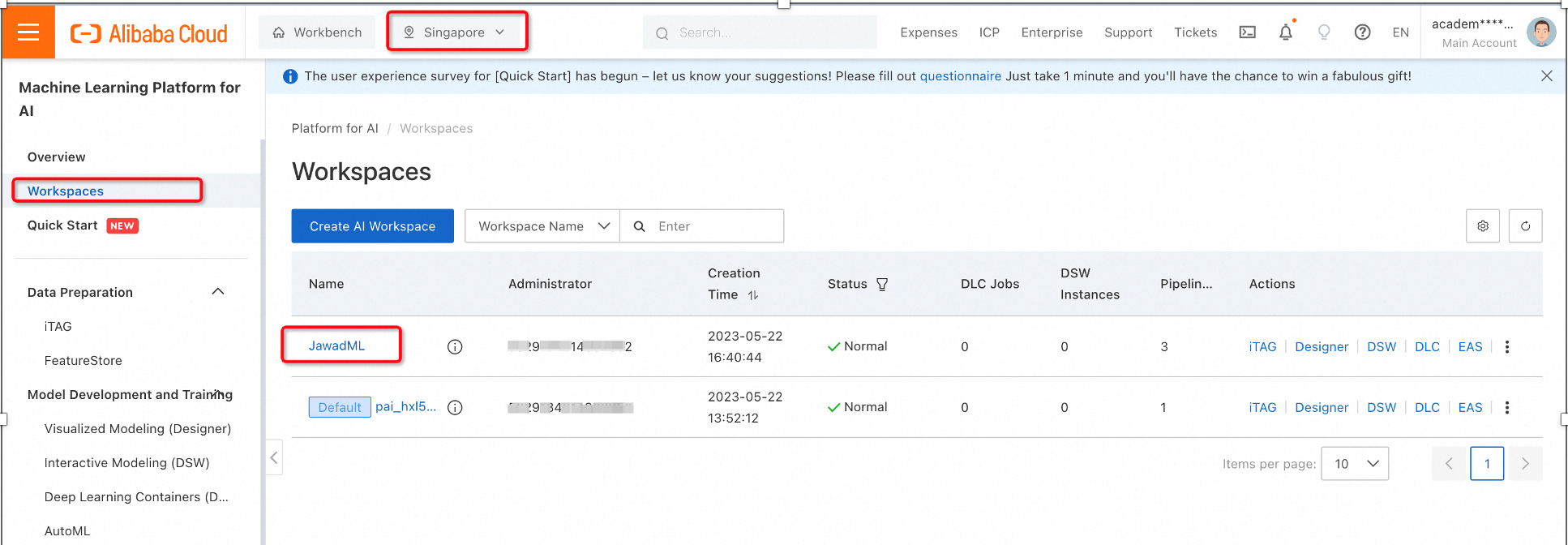

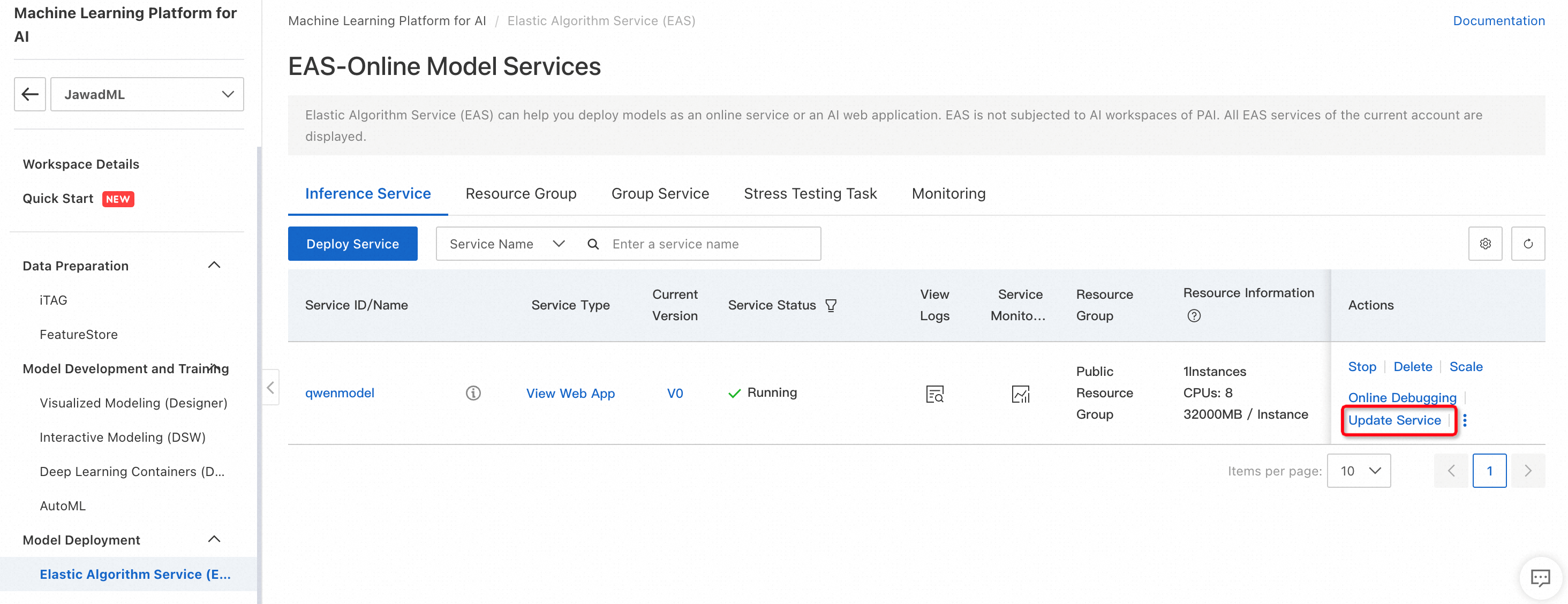

1. PAI プラットフォームでワークスペースを選択し、モデルのデプロイ で Elastic Algorithm Service (EAS) を選択し、サービスのデプロイ をクリックします。

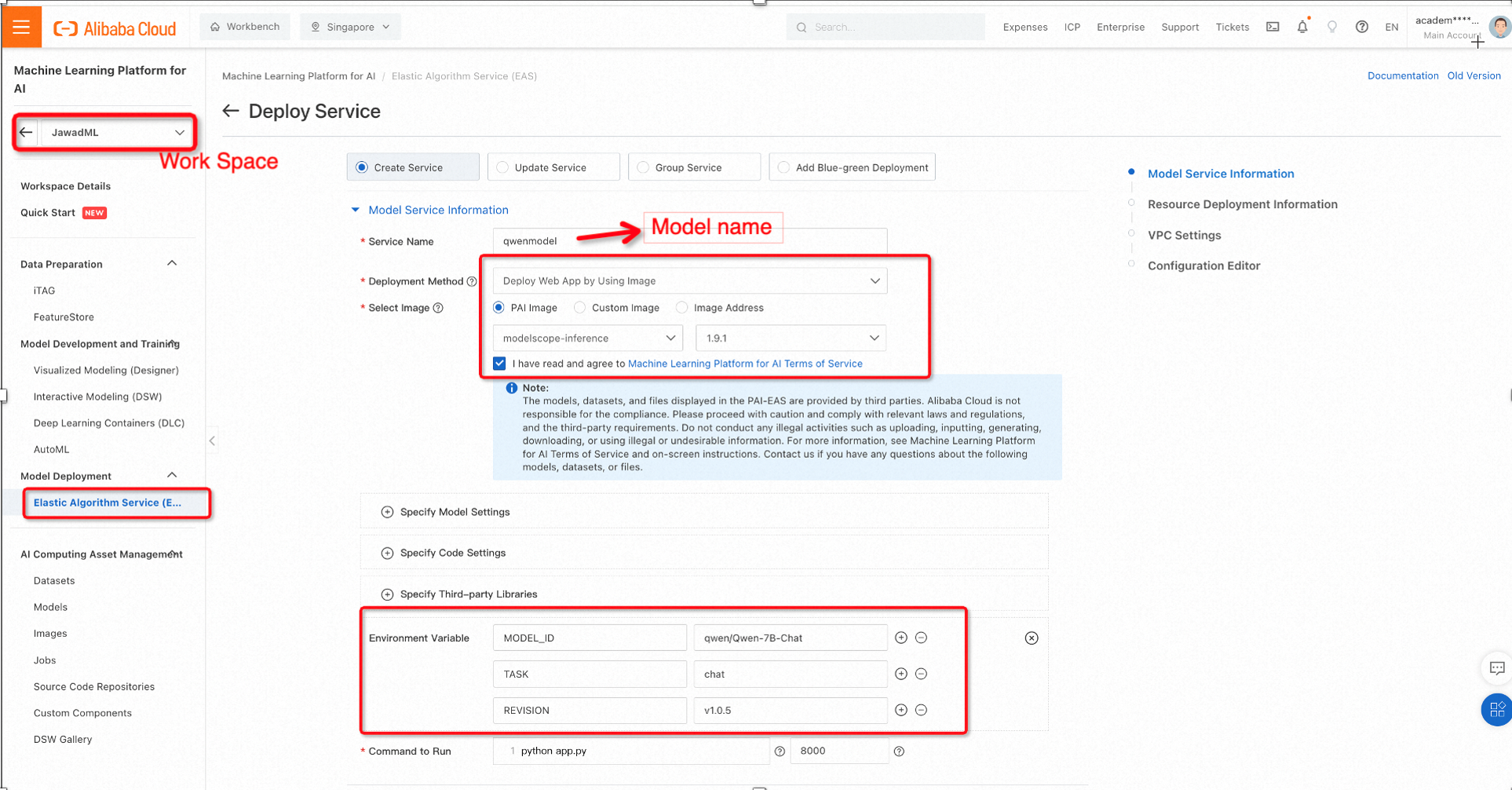

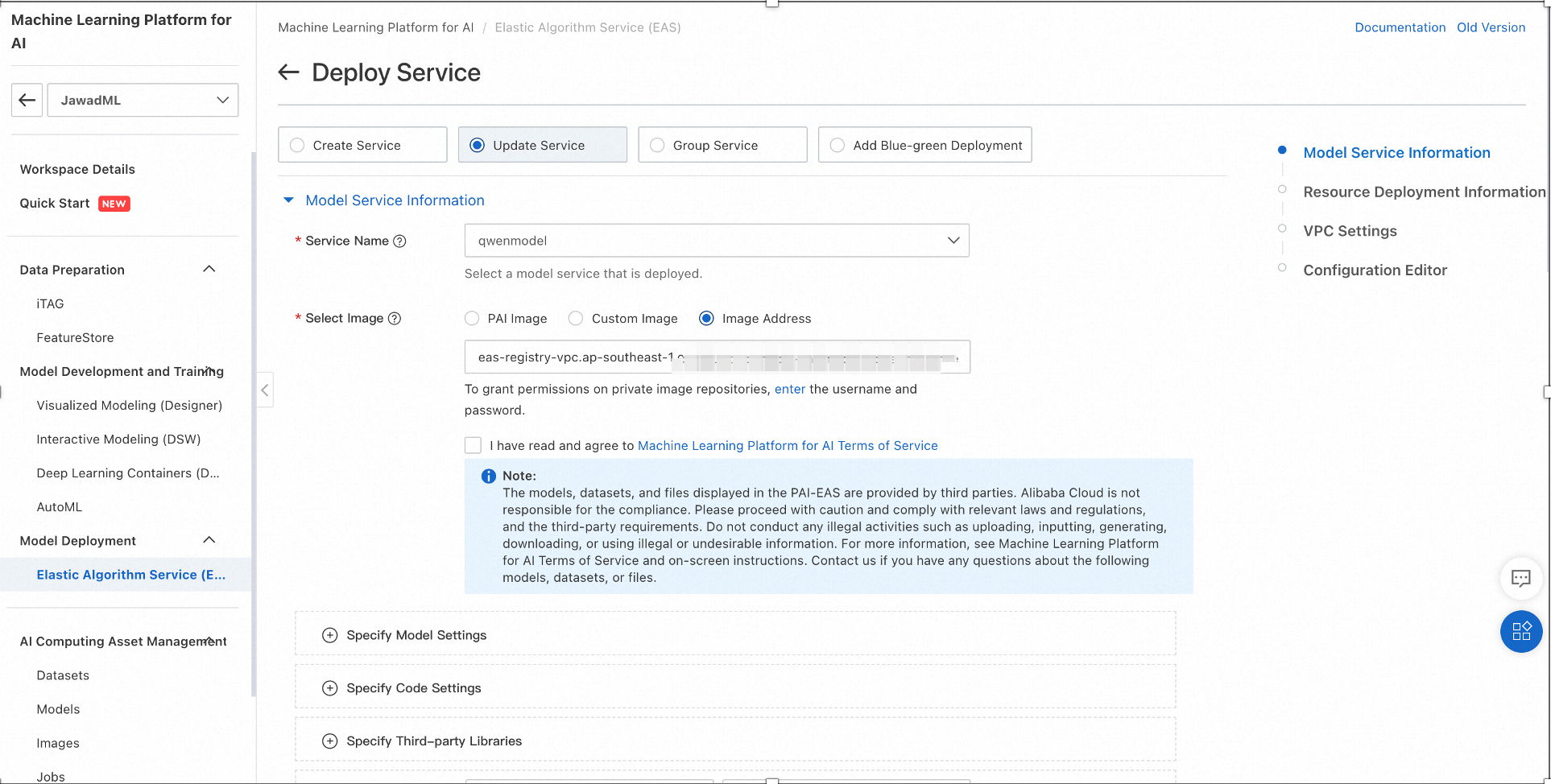

2. ModelScope の事前トレーニング済みモデルを使用して、以下の設定でイメージと環境変数を選択します。

ModelScope は、Alibaba Cloud によって開発されたオープンソースの Model-as-a-Service (MaaS) プラットフォームで、グローバルな開発者や研究者向けの事前トレーニング済みの大規模モデルを含む数百の AI モデルが付属しています。

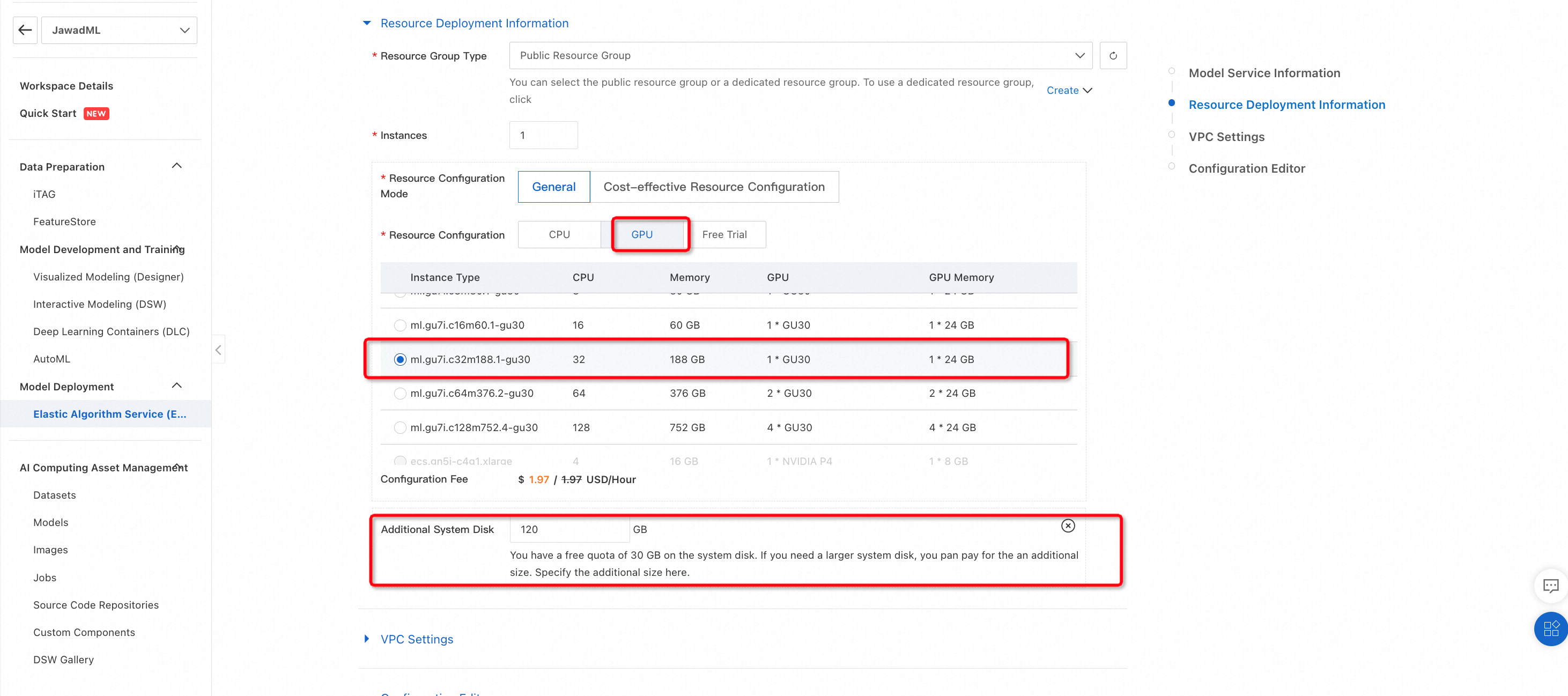

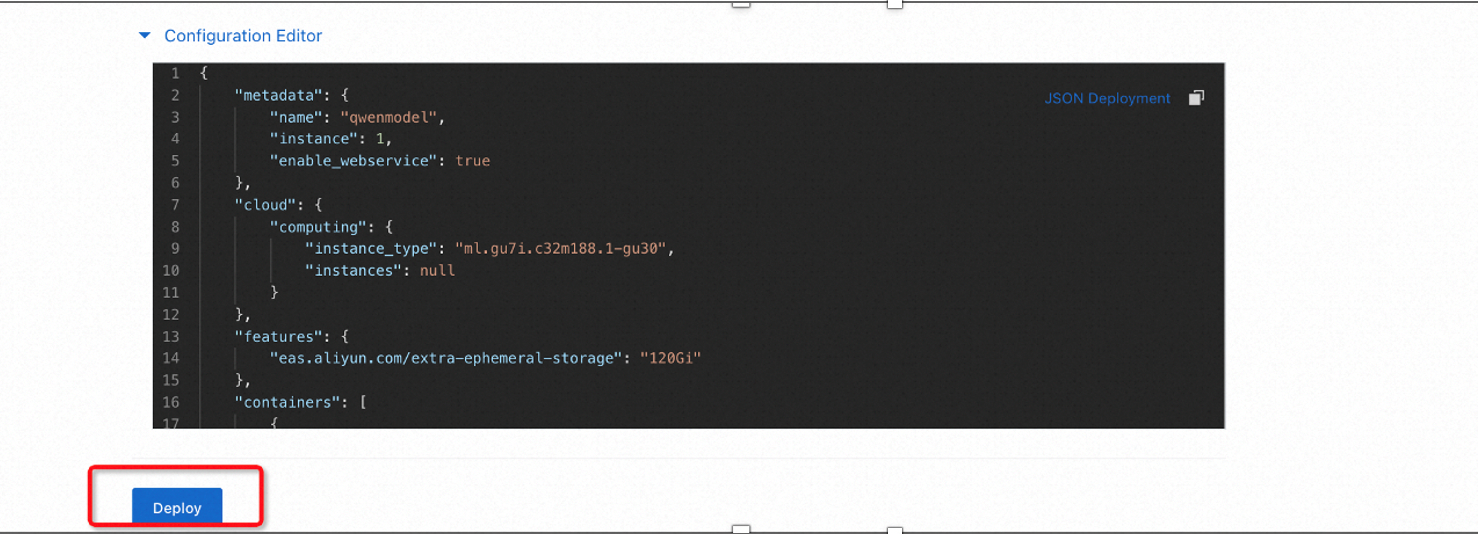

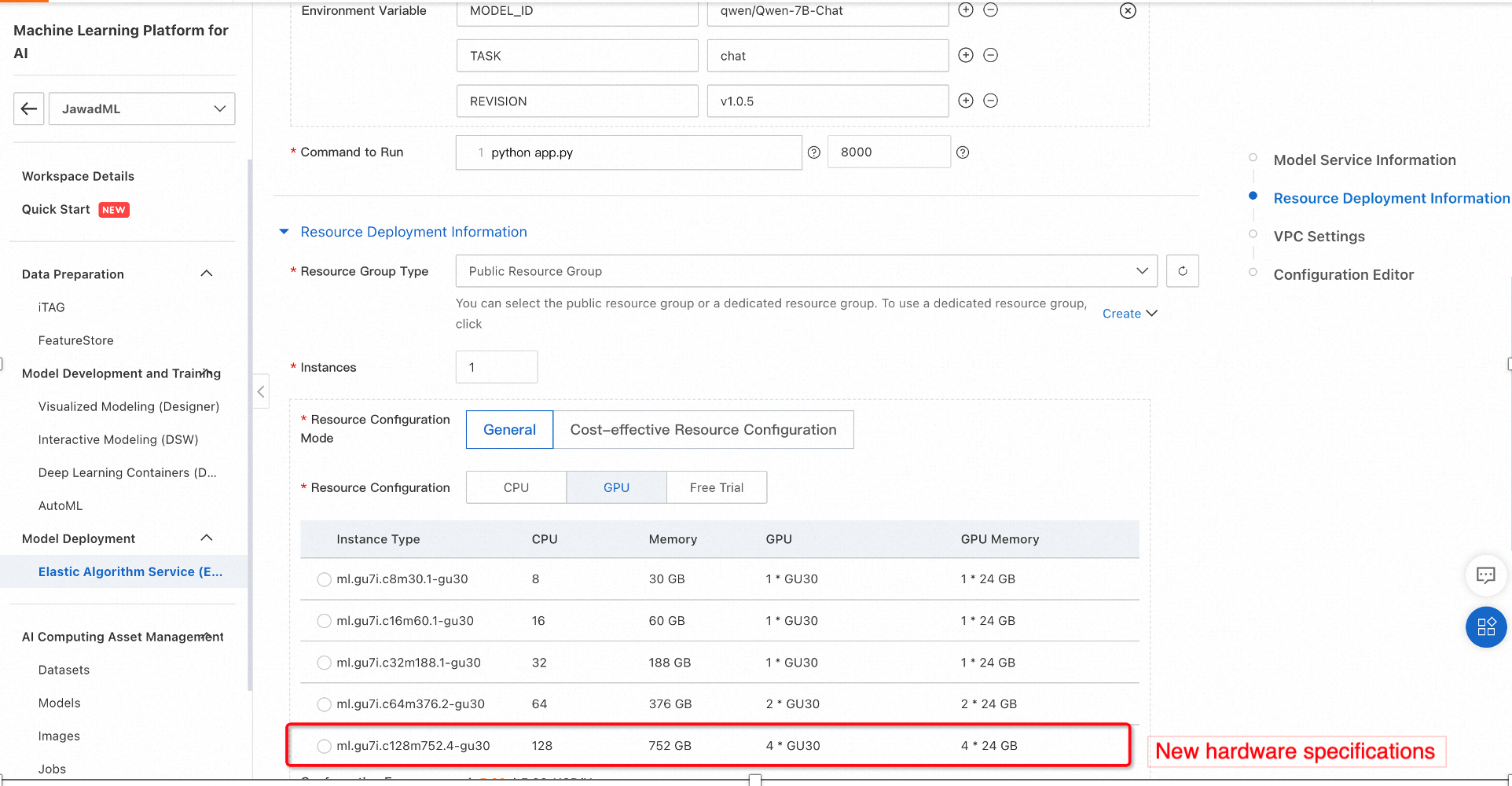

Alibaba Cloud PAI では、推論用の機械学習モデルを実行できるハードウェア用にさまざまなオプションが提供されています。 今回は、十分なメモリを有する GPU を使用できます。 以下の設定を選択し、デプロイ をクリックします。

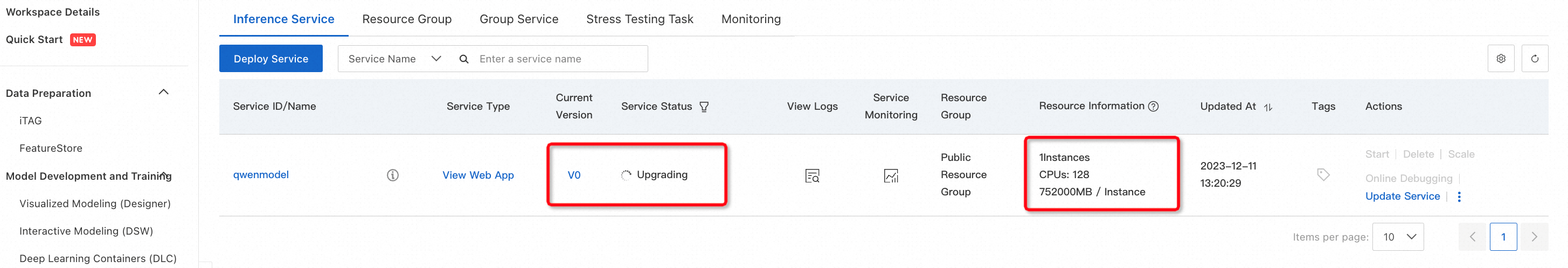

これにより、選択したハードウェアに事前トレーニング済みの Qwen-7B モデルのデプロイが開始されます。 時間がかかる場合があるため、デプロイプロセス中にさまざまなイベントを確認することを推奨します。

3. 作成プロセスの確認

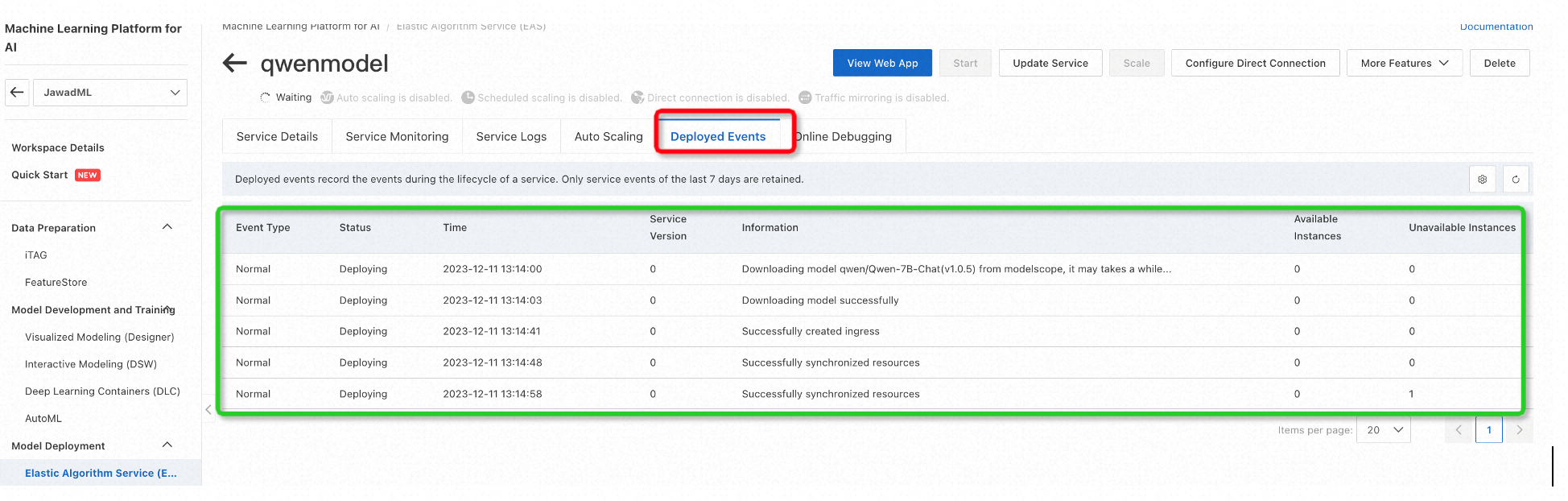

デプロイイベントを確認し、すべてが正常であることを確認するには、サービスID / 名前 (今回の場合は qwenmodel) をクリックし、デプロイイベント を選択します。

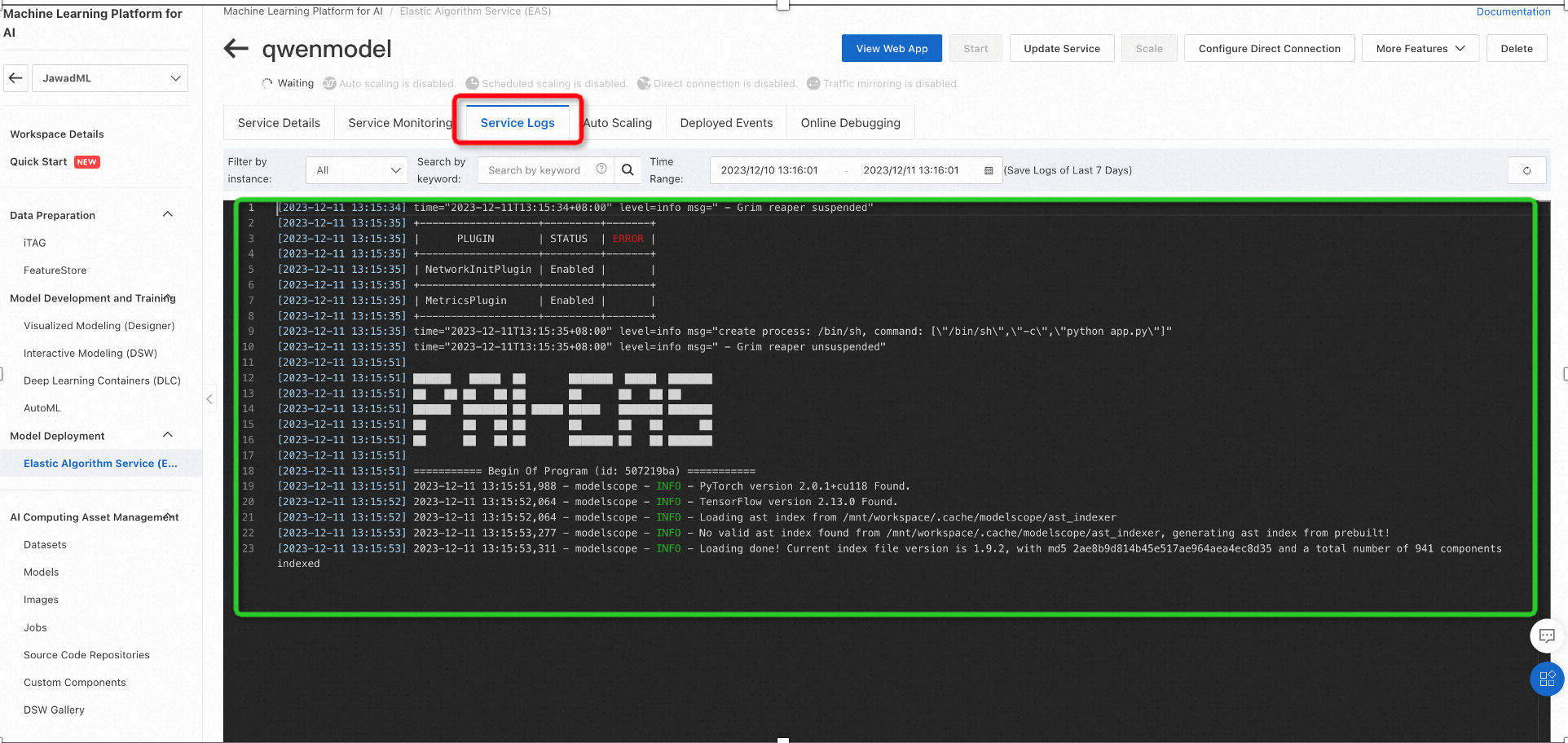

同様に、サービスログ を使用して、パッケージのインストール関連ログを表示できます。

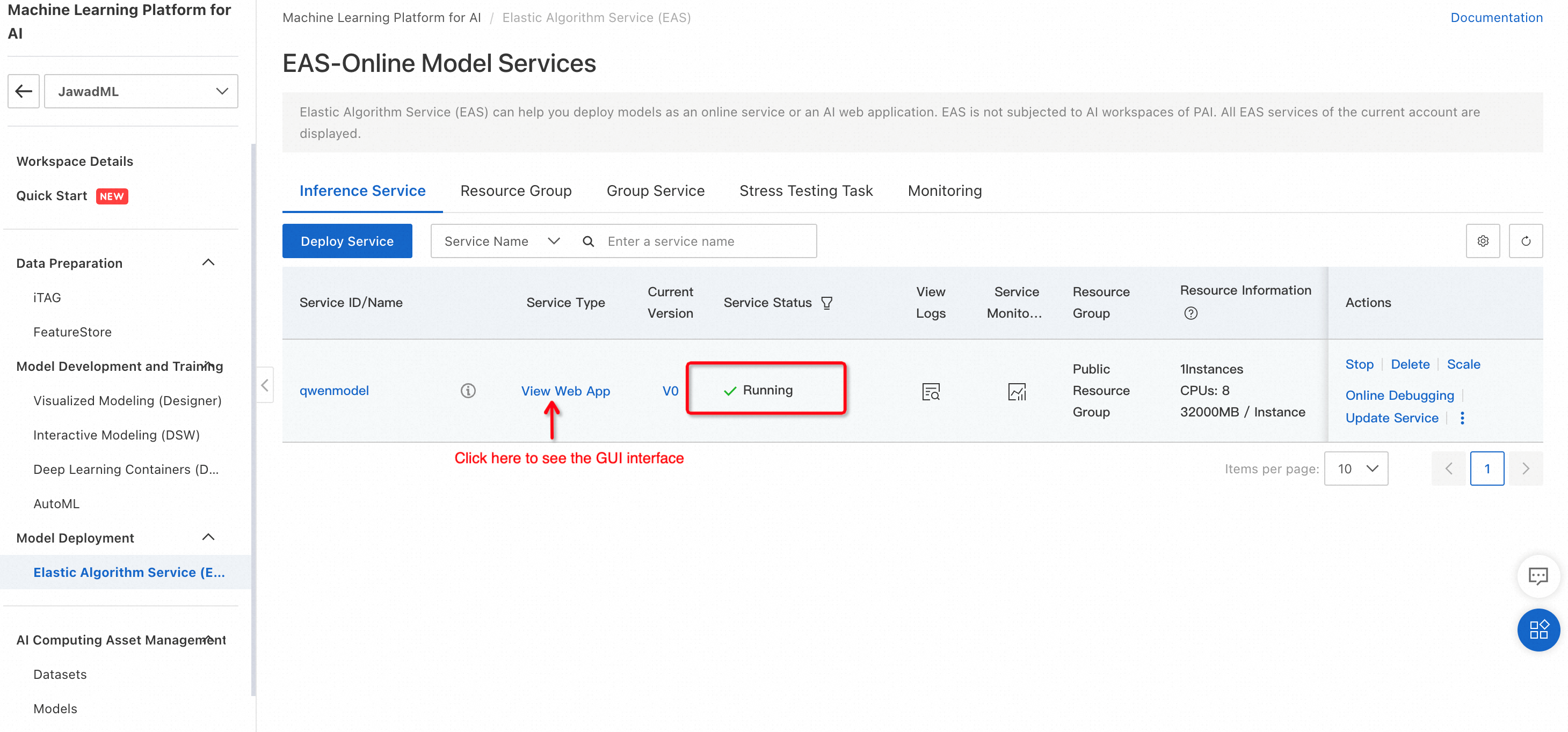

モデルが正常にデプロイされると、サービスのステータスは 実行中 に変わります。

推論にモデルを使用するには、Webアプリの表示 をクリックします。 テキスト生成のテストに使用できるモデルの GUI インターフェースが開きます。

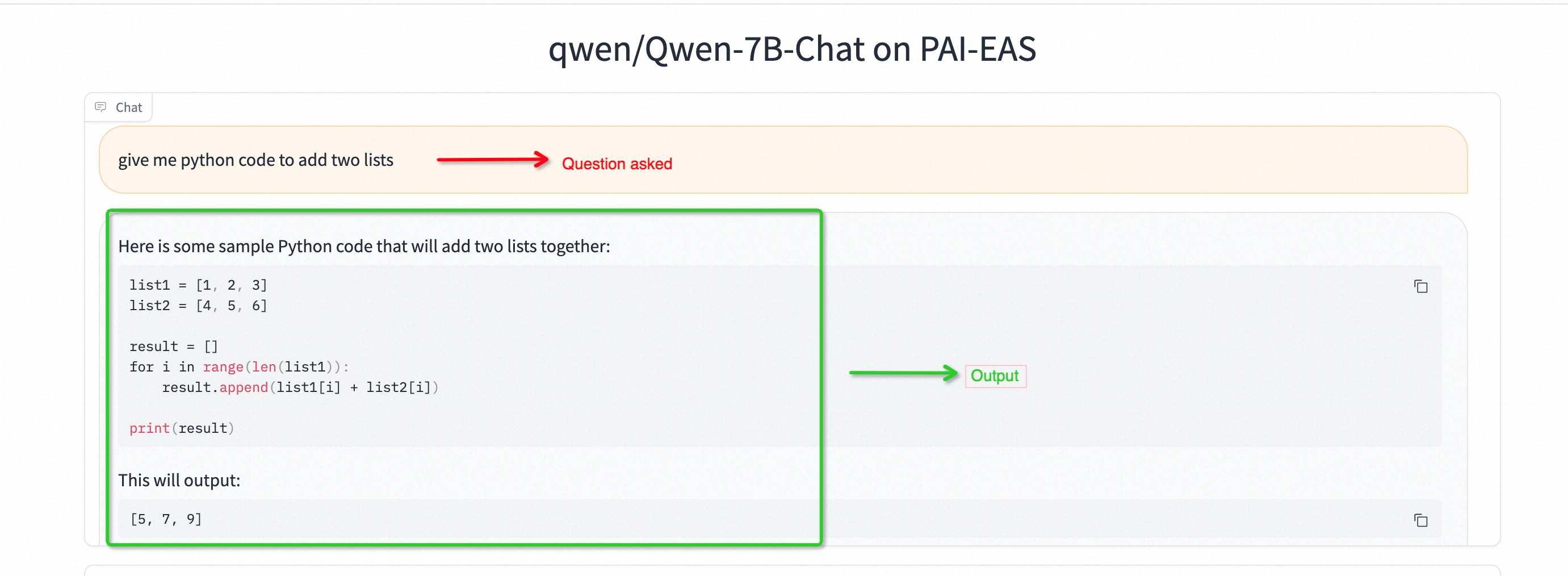

4. テスト:Qwen-7B で python コードを生成する

GUI モードを使用する場合、モデルは入力テキスト全体を処理してからテキスト全体を生成することに注意してください。

5. パフォーマンスを向上させたい場合のアップグレード (オプション)

ハードウェア設定は、必要に応じて変更することができます。 以下に示すように、サービスの更新 をクリックすると、設定ウィンドウが開きます。

下図に、推論エンジンのハードウェア設定を変更する方法を示します。 設定が変更されたら、デプロイ をクリックします。

設定の変更には多少時間がかかります。 完了すると、サービスステータスは アップグレード中 から 実行中 に変わります。

スクロールテキスト応答を生成できる Qwen 7-B を CLI モードで実装できます。 PAI インタラクティブモデリング (DSW) または ECS インスタンスを使用して実装できます。 今回は、DSW ベースの実装について説明します。

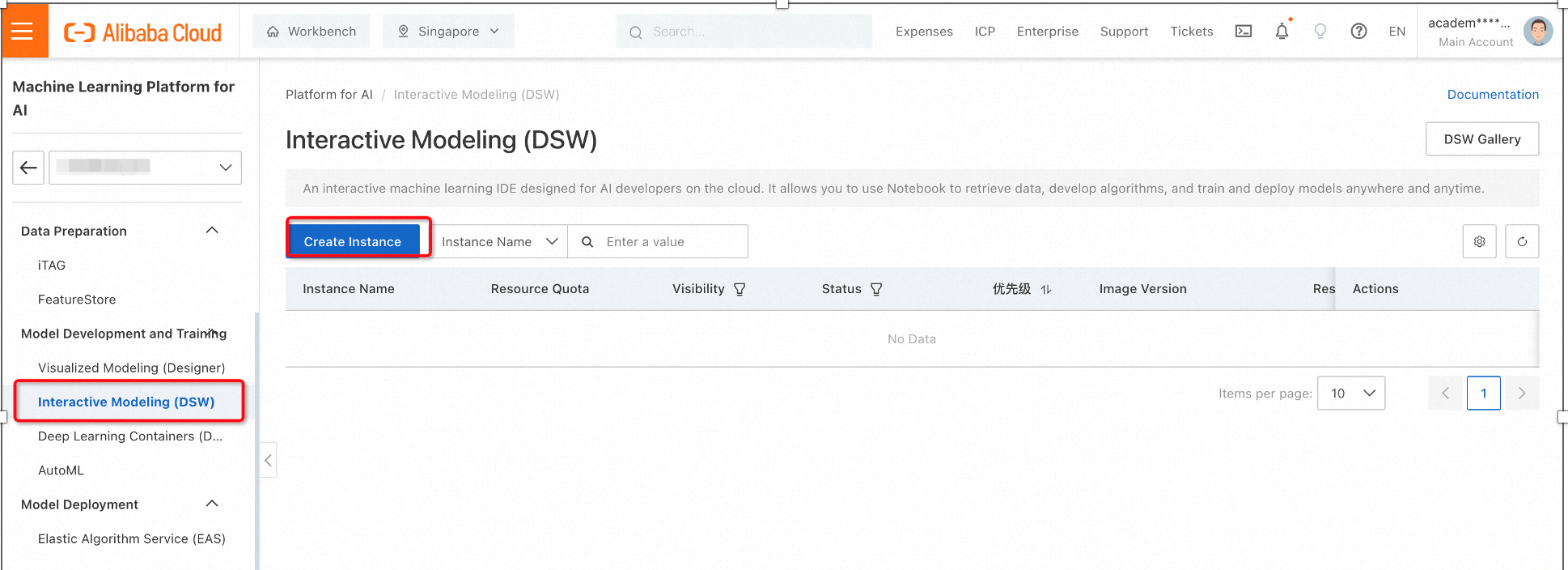

1. PAI で、[インタラクティブモデリング (DSW)] を選択し、インスタンスの作成 をクリックします。 設定ウィンドウが開きます。

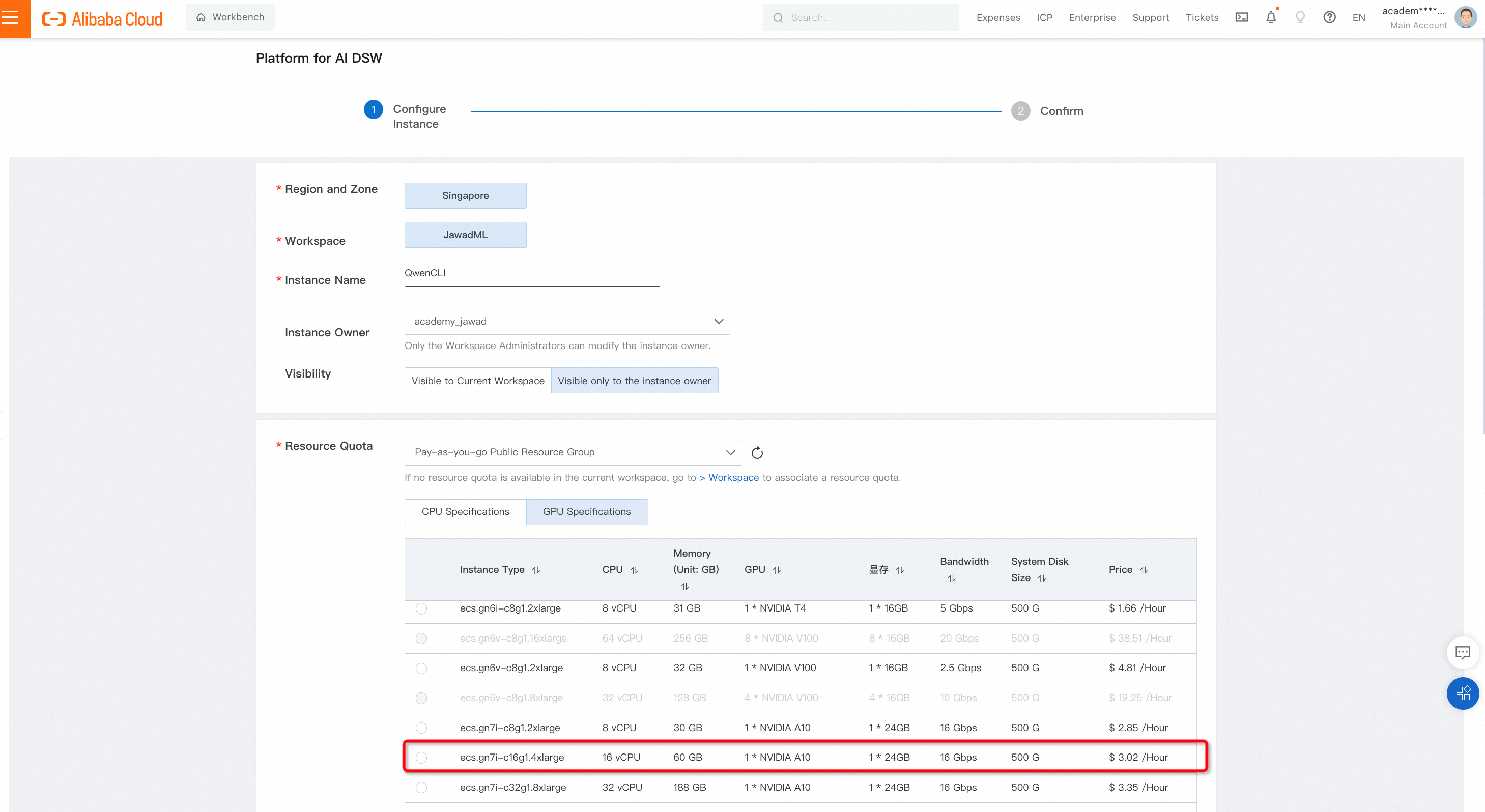

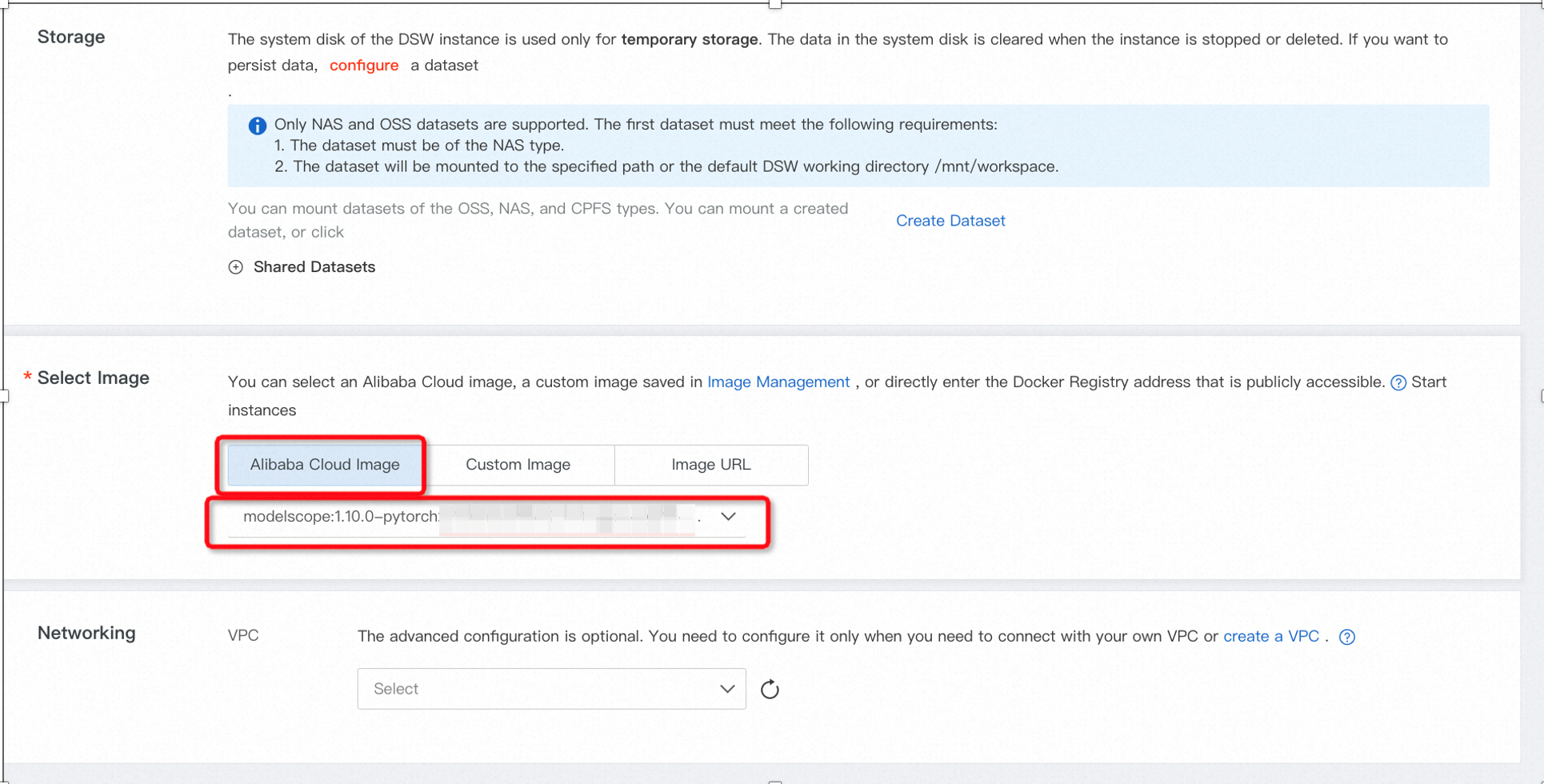

以下のように適切な GPU 仕様とイメージタイプを選択して設定します。

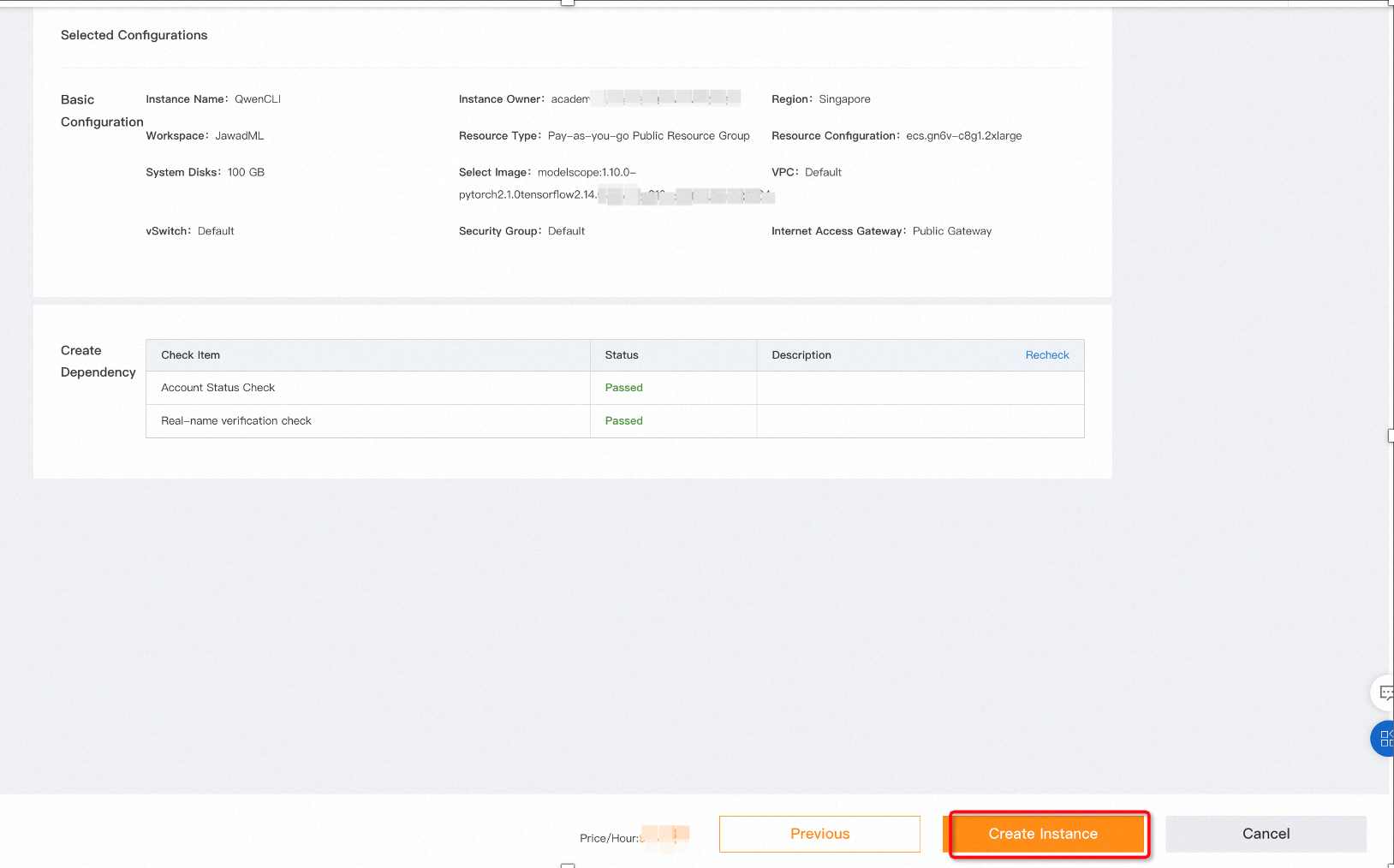

次へ をクリックして最終ページに移動します。 インスタンスの作成を選択すると、DSW インスタンスが起動されます。

インスタンスの初期ステータスは、リソースの準備中 です。

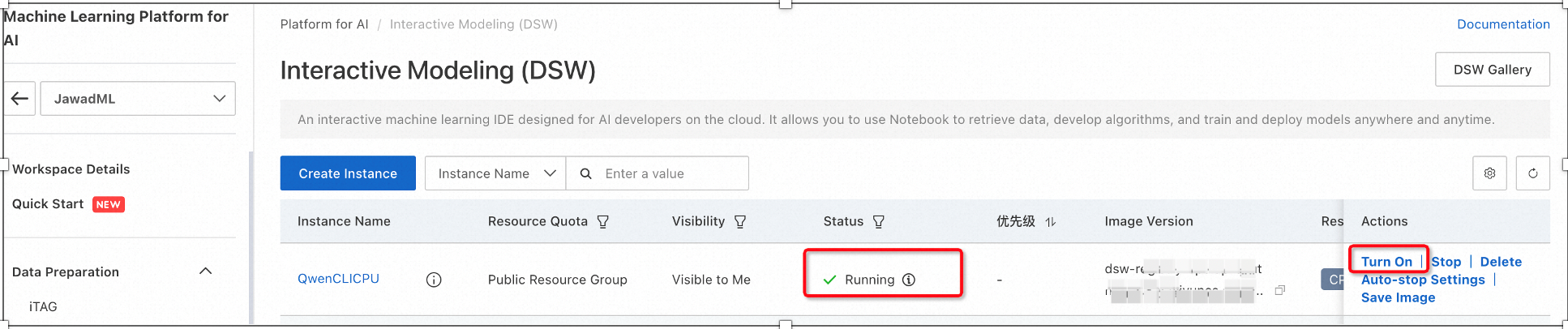

2. インスタンスのステータスが “実行中” になったことを確認んし、右側にある 有効化 オプションをクリックします。 Jupiter Lab が起動されます。

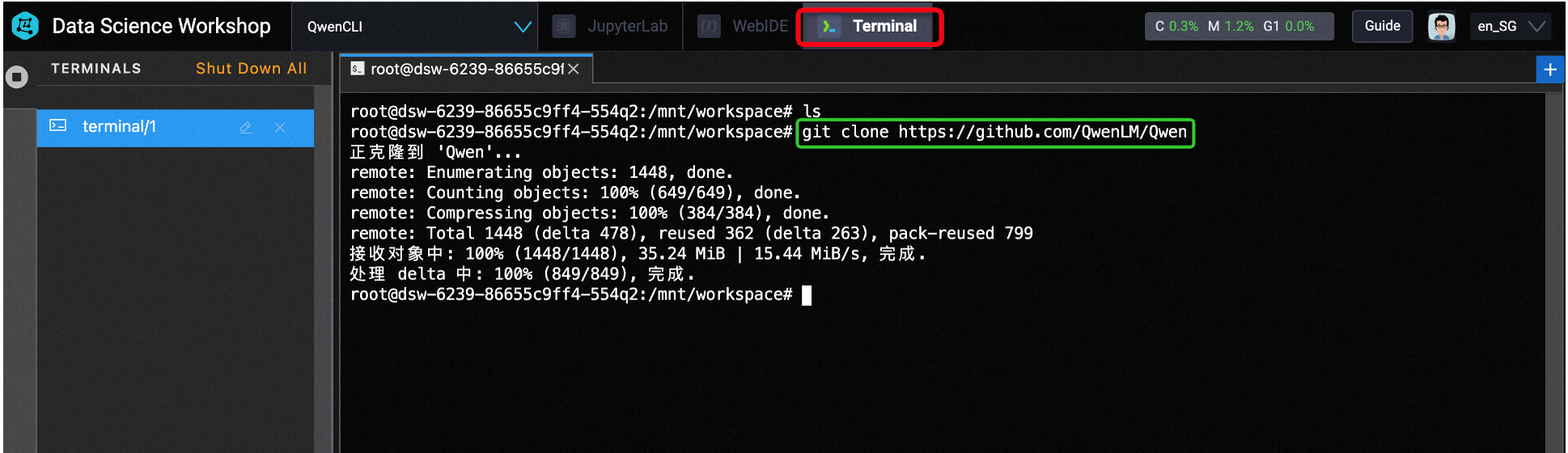

3. ただし、ここでは Jupyter Lab は使用しません。 その代わりに、ターミナルで Github からモデルをダウンロードしてデプロイします。

最善の方法は、最初に python 環境を作成しておくことです。 仮想環境が作成されたらアクティブ化し、端末で以下のコマンドを使用します。

a) git clone https://github.com/QwenLM/Qwen

b) cd Qwen/

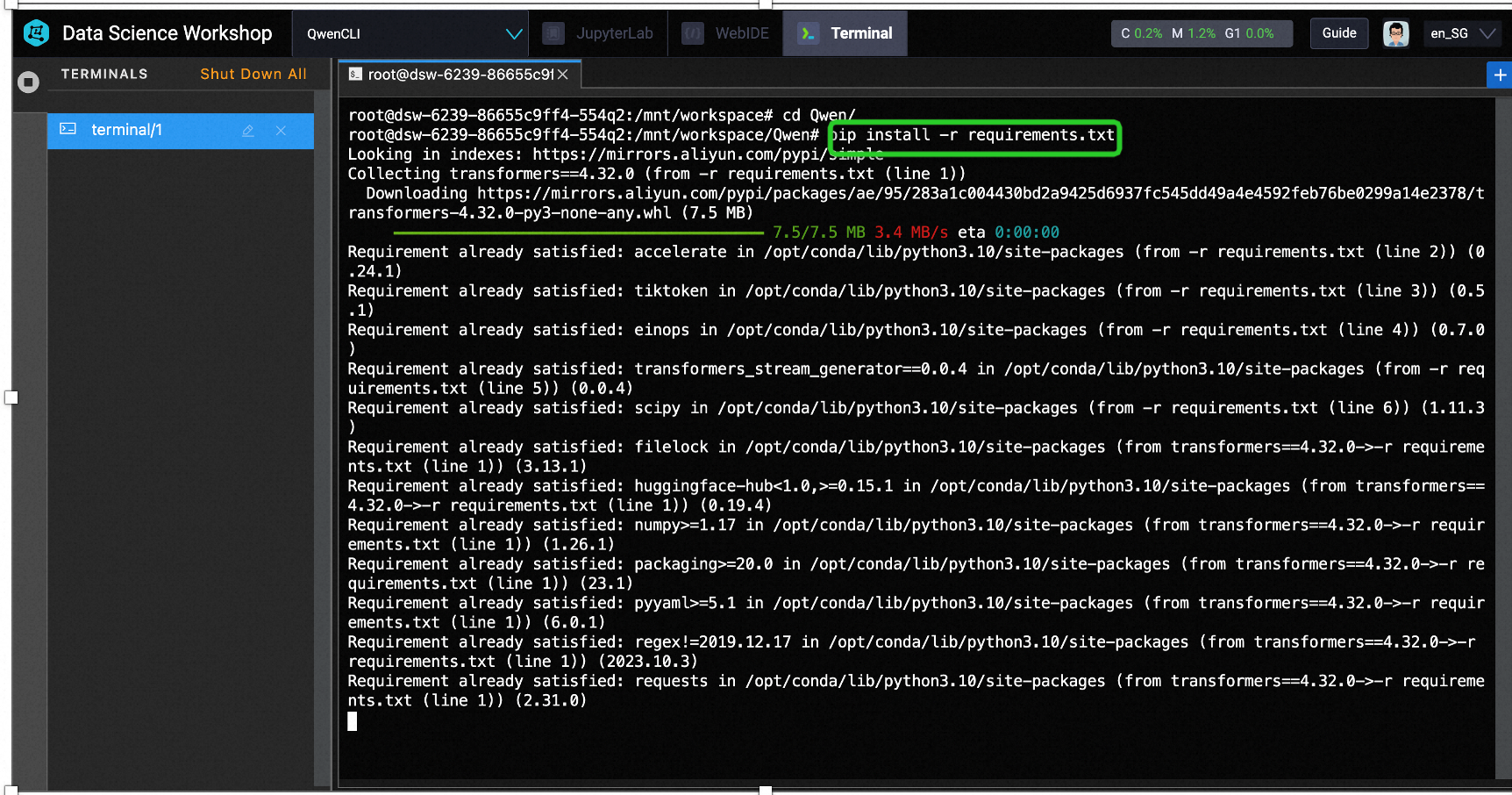

c) pip install -r requirements.txt

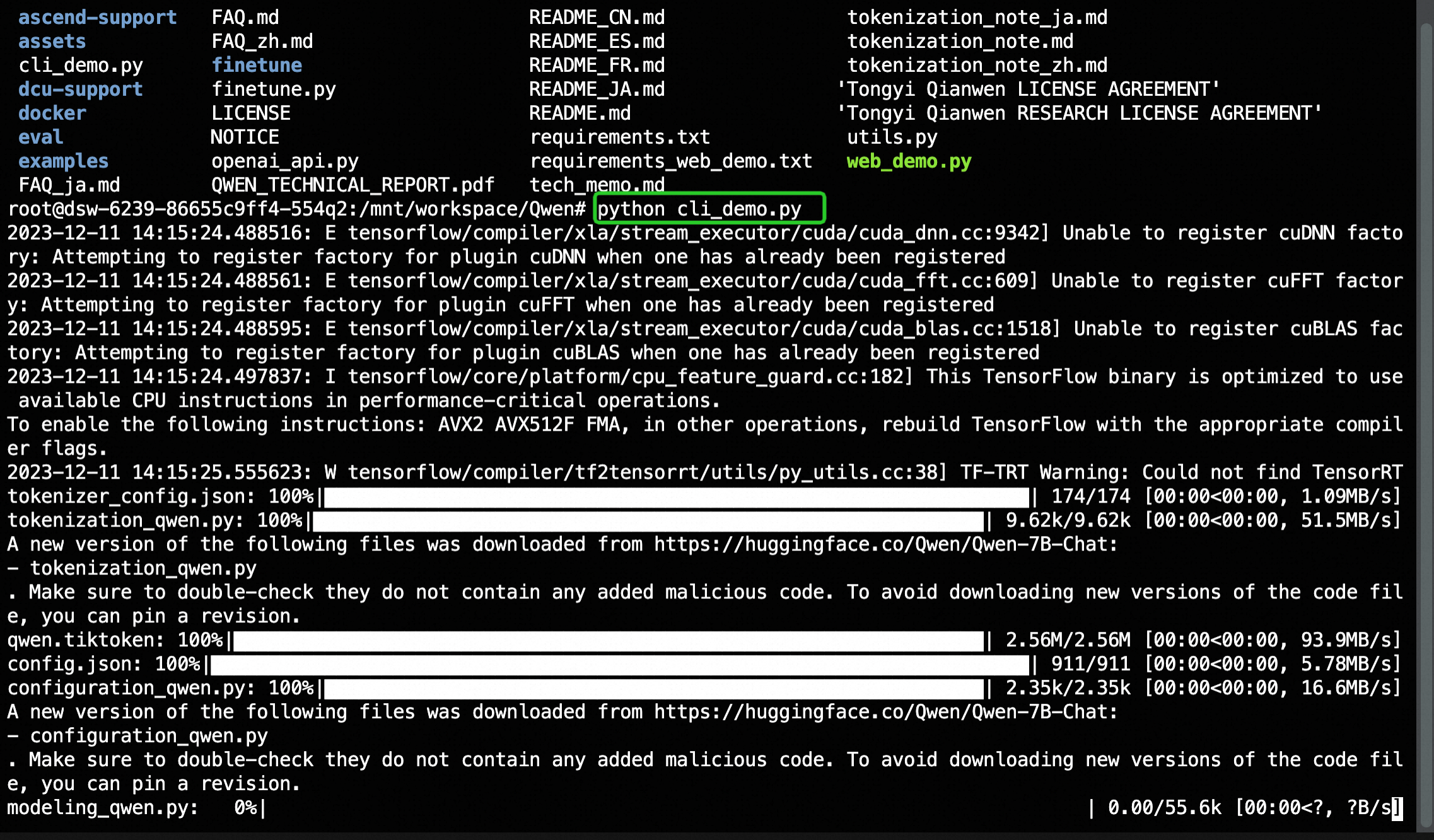

d) python3 cli_demo.py

インストールの完了にはしばらくかかります。コーヒーなどを用意して待ちましょう。

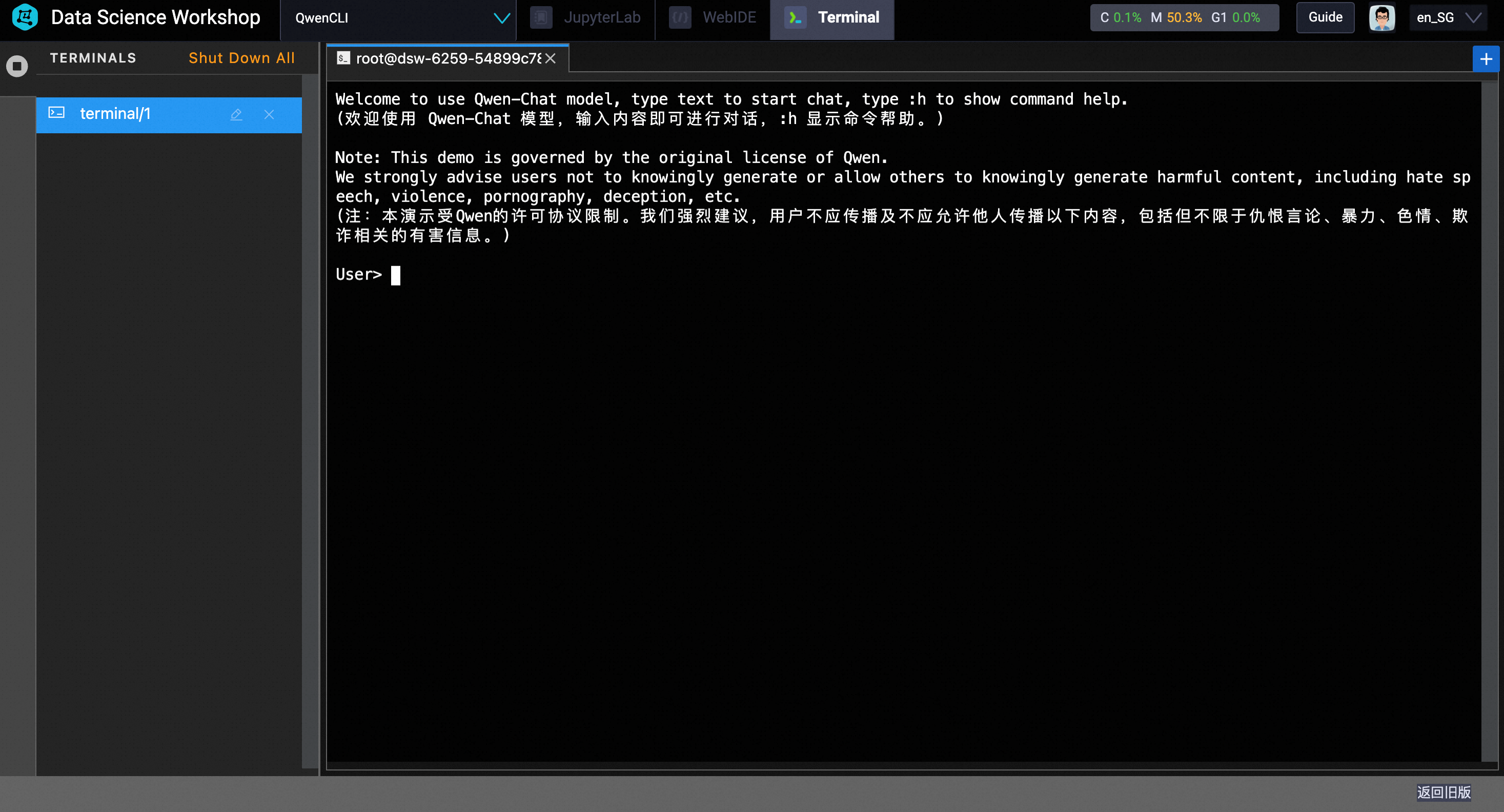

完了すると、コマンドラインプロンプトが表示されます。

4. モデルのテスト:

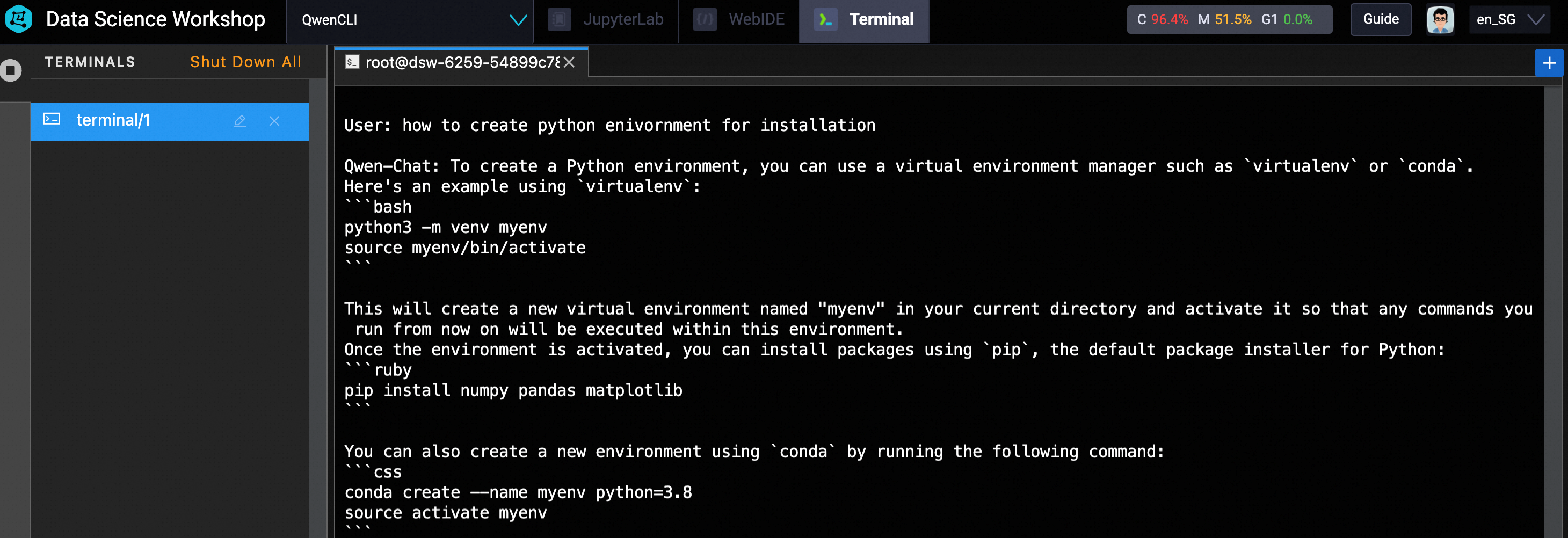

モデルをテストするには、CLI インターフェースでテキストを直接入力します。 私の場合は、プロンプトを使用しました:how to create python environment for installation

以下に示すように、仮想環境を作成およびアクティブ化するための python コードが生成されます。

さまざまな質問を試して、Qwen をお楽しみください。 😀

この記事の原典は、英語で執筆されました。 原典はこちらから表示できます

การปรับใช้โมเดลภาษาขนาดใหญ่ของ Alibaba Cloud (Tongy Qianwen) ด้วยส่วนต่อประสานรายคำสั่งและกราฟิก

그래픽 및 명령줄 인터페이스를 사용하여 Alibaba Cloud 거대 언어 모델(Tongy Qianwen) 배포하기

89 posts | 3 followers

FollowRegional Content Hub - August 28, 2024

Regional Content Hub - March 8, 2024

Regional Content Hub - November 4, 2024

Regional Content Hub - March 8, 2024

Regional Content Hub - June 14, 2024

Regional Content Hub - May 13, 2024

89 posts | 3 followers

Follow Tongyi Qianwen (Qwen)

Tongyi Qianwen (Qwen)

Top-performance foundation models from Alibaba Cloud

Learn More Platform For AI

Platform For AI

A platform that provides enterprise-level data modeling services based on machine learning algorithms to quickly meet your needs for data-driven operations.

Learn More AI Acceleration Solution

AI Acceleration Solution

Accelerate AI-driven business and AI model training and inference with Alibaba Cloud GPU technology

Learn More Alibaba Cloud for Generative AI

Alibaba Cloud for Generative AI

Accelerate innovation with generative AI to create new business success

Learn MoreMore Posts by Regional Content Hub