작성자: Jawad

이 블로그 포스트에서는 ECS 인스턴스에서 Ollama 및 Open WebUI를 사용하여 Alibaba Cloud 오픈 소스 Qwen 0.5 모델을 설정하고 실행하는 방법을 살펴봅니다. 완료되면 사용자 친화적인 웹 인터페이스를 통해 Qwen 모델의 기능을 사용할 수 있게 됩니다. 동영상:

이 간단한 데모에서는 ecs.g7.large(2코어, 8GB RAM)를 사용하고 있습니다. 그러나 ECS 인스턴스를 선택할 때는 AI 워크로드에 대해 다음과 같은 주요 요소를 고려하세요:

• CPU/GPU: 효율적인 모델 계산을 위해 vCPU 수가 더 많은 인스턴스를 찾고 GPU를 사용하세요.

• 메모리: Qwen과 같은 모델은 메모리 사용량이 많을 수 있으므로 여기서 사용하는 것보다 더 많은 용량을 확보하세요.

• 스토리지: SSD 기반 스토리지는 모델 로딩에 중요한 읽기/쓰기 속도를 향상시킵니다.

• 대역폭: Open-WebUI를 통한 원활한 상호 작용을 위해 충분한 대역폭을 확보하세요.

인스턴스를 생성하려면 다음 단계를 따르세요:

SSH를 사용하여 연결합니다:

ssh root@<your-instance-public-ip>Docker를 업데이트하고 설치합니다:

apt update

apt install docker.io

apt install docker-compose나노 또는 vi 편집기를 사용하여 docker-compose.yml 파일을 생성합니다:

버전: '3.8'

서비스:

ollama:

이미지: ollama/ollama

container_name: ollama

볼륨:

- ollama:/root/.ollama

포트:

- "11434:11434"

재시작: 항상

open-webui:

이미지: ghcr.io/open-webui/open-webui:ollama

container_name: open-webui

볼륨:

- ollama:/root/.ollama

- open-webui:/app/backend/data

포트:

- "3000:8080"

재시작: 항상

볼륨:

ollama:

open-webui:위의 내용을 원하는 디렉토리와 서비스에 docker-compose.yml이라는 파일에 저장하고 다음을 사용하여 서비스합니다:

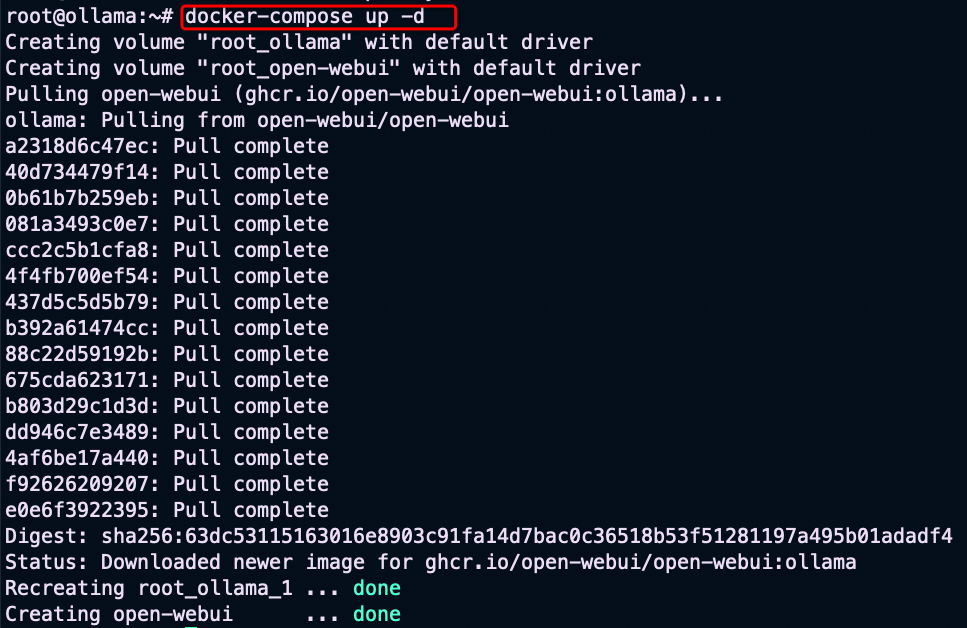

docker-compose up -d

Ollama Container에 접속하여 Qwen 0.5 모델을 가져오려면 먼저 다음을 입력하여 Ollama 컨테이너에 들어가세요:

docker exec -it ollama /bin/bash컨테이너에 들어가면 다음 명령을 실행하여 Qwen 0.5 모델을 가져옵니다:

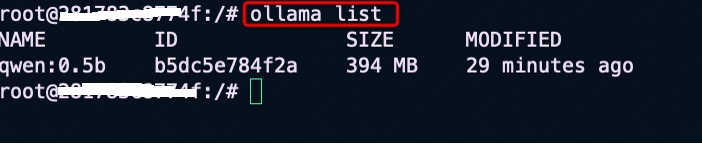

ollama pull qwen:0.5완료되면 Qwen 모델을 사용할 수 있는지 확인하고 ollama list를 사용합니다.

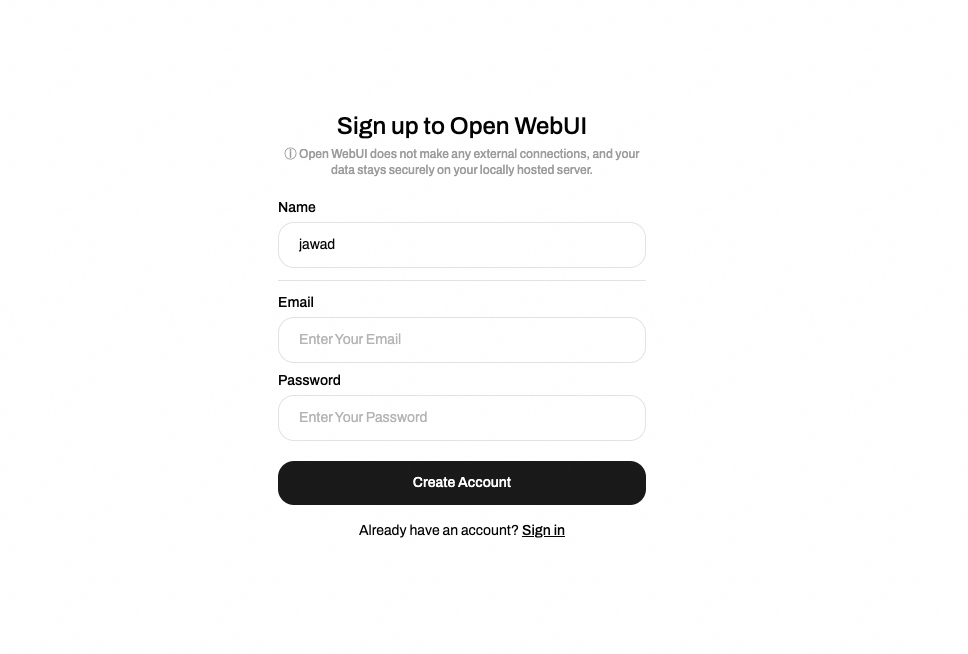

• ECS 퍼블릭 액세스: 퍼블릭 IP 및 보안 그룹 규칙이 설정되면 누구나 http://<your-instance-public-ip>:3000으로 이동하여 Open-WebUI에 접속할 수 있습니다. 아래와 같이 이름, 이메일, 비밀번호를 입력하여 가입하세요:

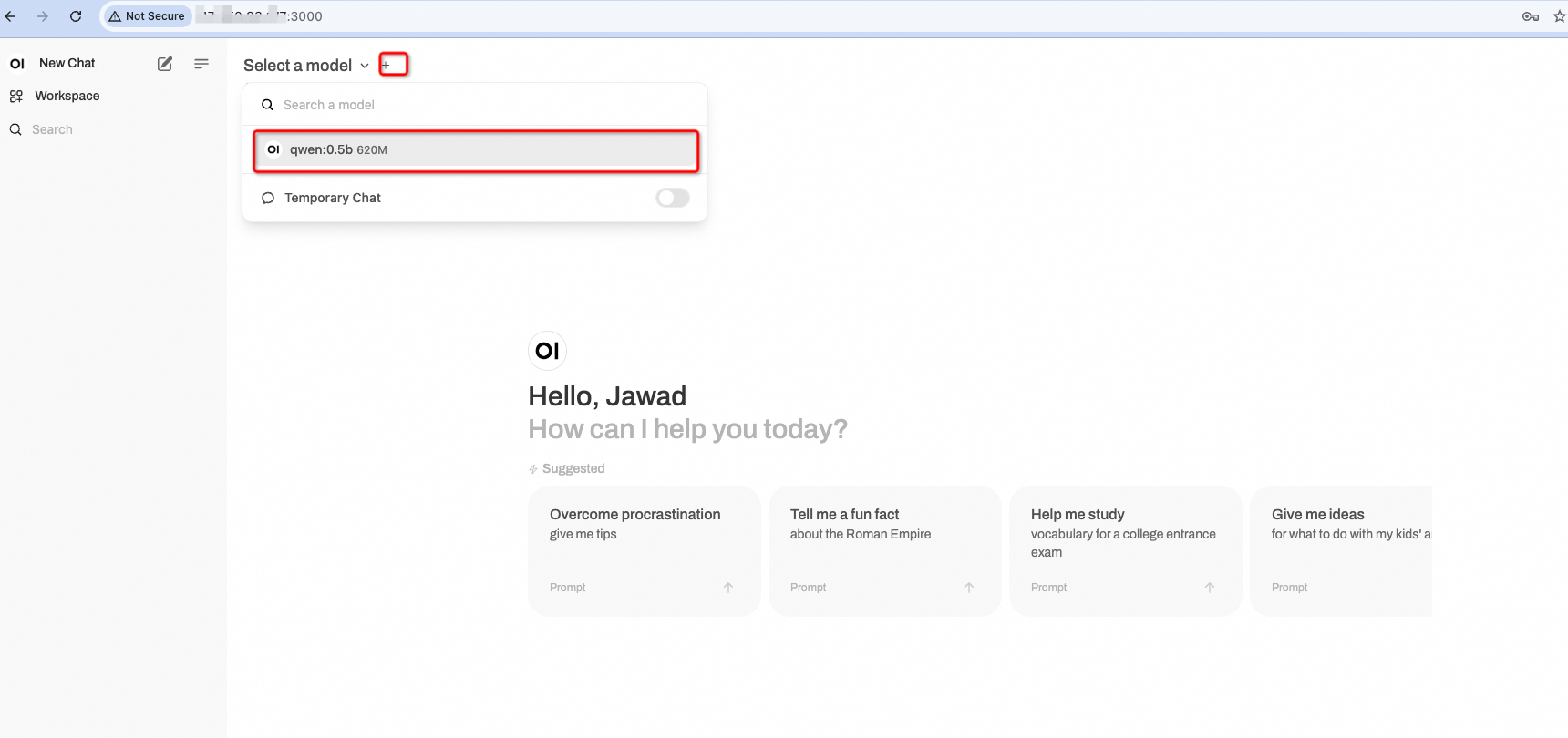

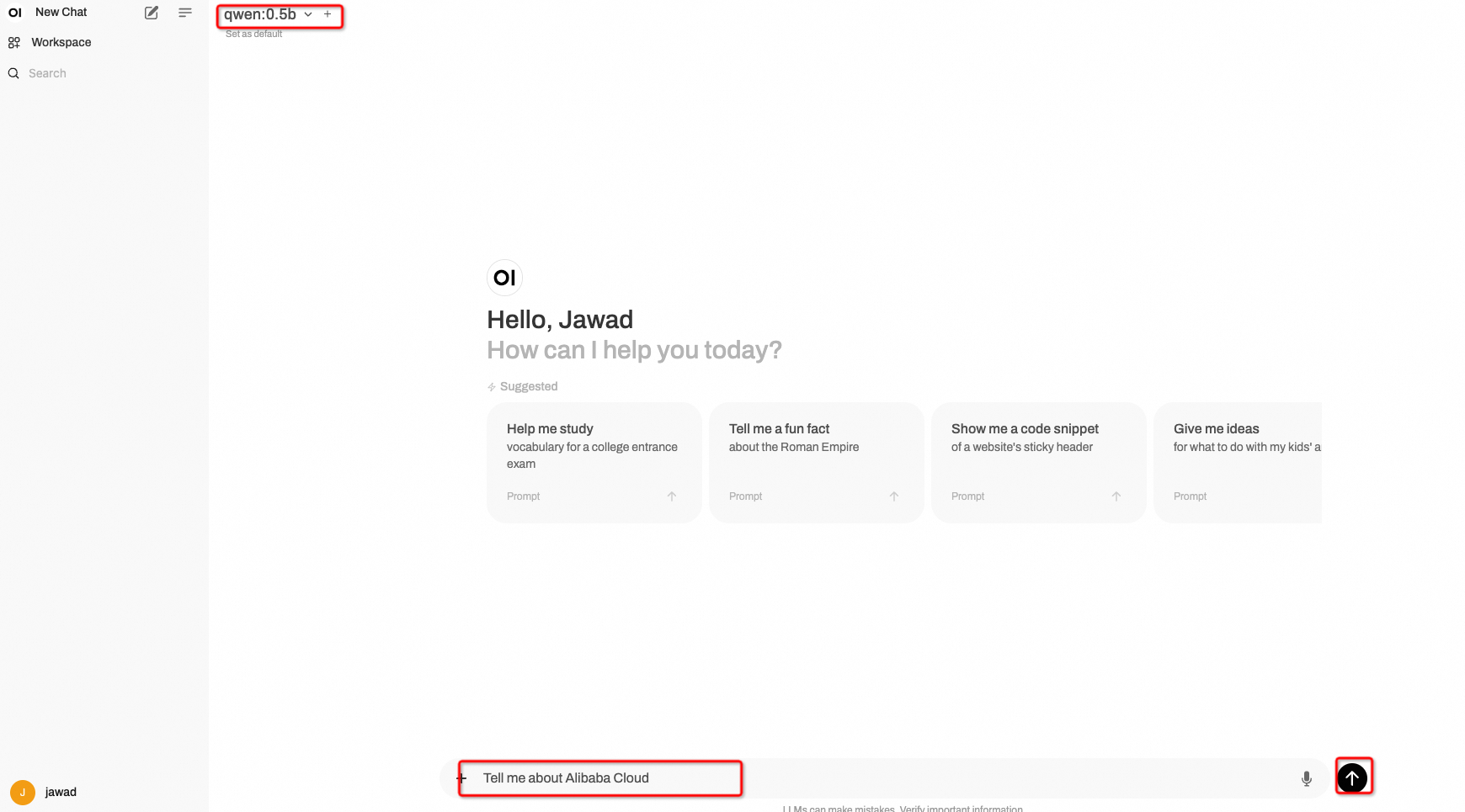

• 모델 사용: 계정을 생성한 후 Alibaba Cloud Qwen:0.5b 모델과 상호 작용합니다:

이제 모델에 다양한 프롬프트를 제공하여 응답을 얻을 수 있습니다:

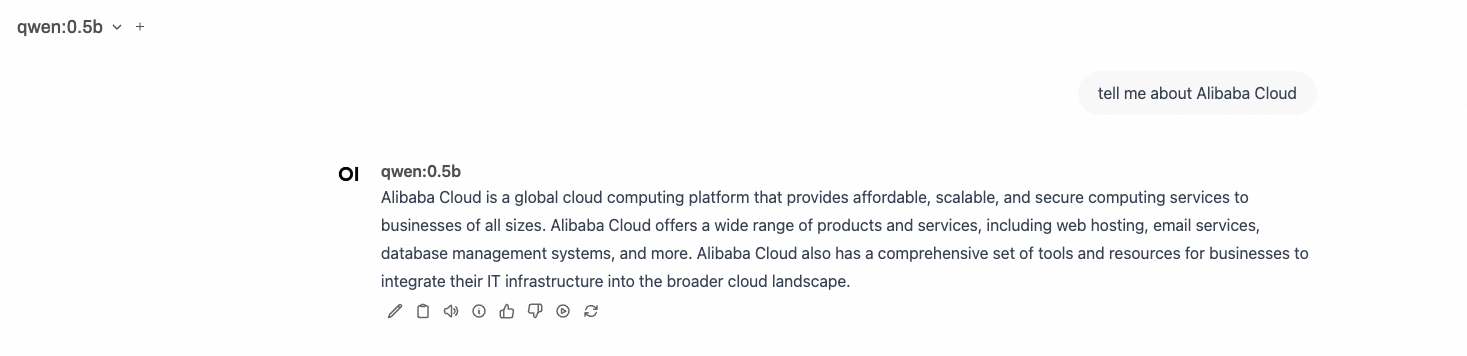

다음은 모델의 출력입니다:

이제 Alibaba Cloud ECS 인스턴스에서 Ollama 및 Open WebUI를 성공적으로 설정하고, Qwen 0.5 모델을 가져오고, 간편한 상호 작용을 위한 웹 인터페이스에 액세스할 수 있게 되었습니다. 이 설정은 모델 배포를 간소화할 뿐만 아니라 직관적인 인터페이스로 사용자 경험을 향상시킵니다. Qwen 모델을 실험하고 그 기능을 탐색해 보세요!

마지막으로, 보다 정확한 응답이 필요한 경우 더 나은 응답을 위해 높은 사양의 하드웨어가 필요할 수 있으므로 https://ollama.com/library/qwen 에서 제공되는 Qwen 4b 등과 같은 Alibaba Cloud LLM을 사용하는 것이 좋습니다.

궁금한 점이 있거나 문제가 발생하면 아래에 댓글을 남겨 주세요.

이 문서는 영문에서 번역되었으며, 원문은 여기를 참조하세요.

สร้าง ChatGPT ของคุณเอง: ใช้งาน OLLAMA และ Open-WebUI ด้วย Qwen บน Alibaba Cloud ECS

Xây dựng ChatGPT riêng của bạn: Triển khai OLLAMA và Open-WebUI với Qwen trên Alibaba Cloud ECS

99 posts | 4 followers

FollowJames Lee - December 23, 2024

Regional Content Hub - August 12, 2024

Regional Content Hub - September 9, 2024

Regional Content Hub - May 20, 2024

Regional Content Hub - March 20, 2024

JJ Lim - January 23, 2025

99 posts | 4 followers

Follow Tongyi Qianwen (Qwen)

Tongyi Qianwen (Qwen)

Top-performance foundation models from Alibaba Cloud

Learn More AI Acceleration Solution

AI Acceleration Solution

Accelerate AI-driven business and AI model training and inference with Alibaba Cloud GPU technology

Learn More Alibaba Cloud for Generative AI

Alibaba Cloud for Generative AI

Accelerate innovation with generative AI to create new business success

Learn More Platform For AI

Platform For AI

A platform that provides enterprise-level data modeling services based on machine learning algorithms to quickly meet your needs for data-driven operations.

Learn MoreMore Posts by Regional Content Hub