Вы хорошо технически подкованы. Приготовьтесь к захватывающим приключениям в области искусственного интеллекта! Мы не просто скользим по поверхности, а ныряем головой в глубокий конец с моделью чата Qwen. Что есть на повестке дня? Создать чат-бота умнее, чем лиса, и уважать частную жизнь, как первоклассный секретный агент. Заинтригованы? Вы должны быть! Давайте начнем наше путешествие с понимания генеративного ИИ и LLM (больших языковых моделей).

Генеративный ИИ — это тип искусственного интеллекта, способной генерировать новый контент в виде текста, изображений, музыки или других мультимедиа. Этот тип ИИ использует модели машинного обучения, в частности генеративные модели, для понимания закономерностей, функций и отношений в больших наборах данных и создания новых контентов, которые являются часто неотличимыми от созданного человеком контента.

Генеративный ИИ продолжает быстро развиваться и его возможности расширяют границы того, что могут создавать машины, предлагая как захватывающие перспективы, так и проблемы, к решению которых необходимо подходить ответственно.

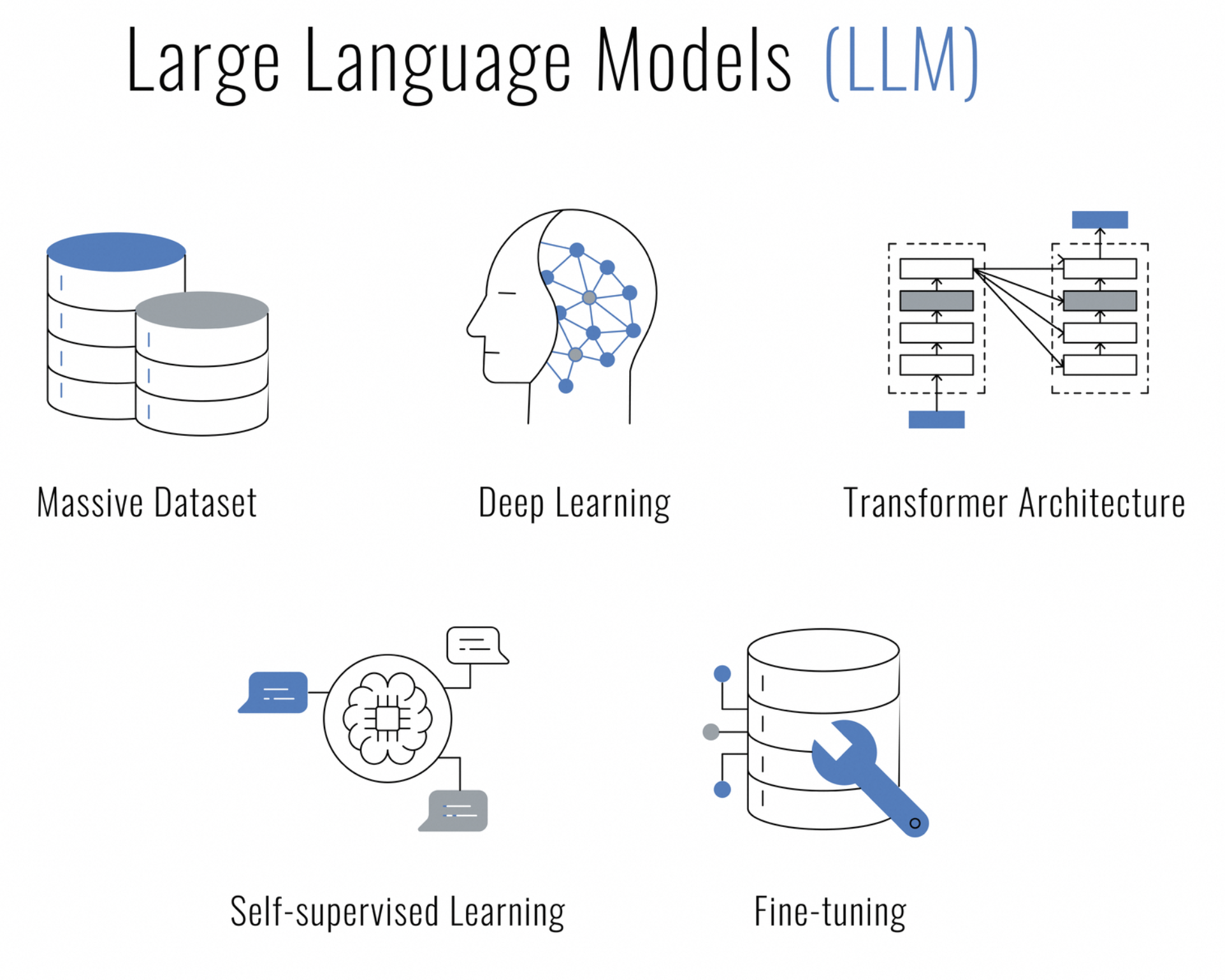

Что такое большие языковые модели (LLM)? Это тип искусственного интеллекта, основанный на методах глубокого обучения и предназначенный для понимания, генерации и обработки человеческого языка. Их называют «большими», потому что они имеют огромное количество параметров, что позволяет им улавливать более широкий спектр языковых нюансов и контекстов.

LLM обучаются на огромном объеме текстовых данных и используют такие архитектуры, как нейронные сети — трансформер, которые способны обрабатывать последовательности данных (например, предложения) и обращать внимание на разные части последовательности при прогнозировании. Это делает их особенно эффективными для задач обработки естественного языка (NLP), таких как:

Вы ищете ИИ, способный общаться, создавать контент, обобщать, кодировать и т. д., уважая при этом вашу конфиденциальность? Не нужно искать дальше. Модель чата Qwen превратит ваш центр обработки данных в «оплот» безопасного взаимодействия на базе ИИ.

Qwen — это не обычный чат-бот. Он создан на массивной языковой модели и был обучен на ошеломляющих 3 триллионах токенов многоязычных данных. Это чудо искусственного интеллекта понимает как английский, так и китайский язык, и было точно настроено для взаимодействия, подобного человеческому.

Развертывание Qwen на локальном сервере означает получение контроля. Это означает, что ваши разговоры, обрабатываемые данные и обещанная конфиденциальность остаются в вашей компетенции. Независимо от того, являетесь ли вы бизнесменом, стремящимся интегрировать интеллектуальную систему чата, разработчиком, увлекающимся исследованиями в области ИИ, или просто энтузиастом, стремящимся изучить границы диалогового искусственного интеллекта, Qwen — ваш лучший выбор.

Итак, почему вы хотите развернуть LLM локально? Три слова: контроль, скорость и конфиденциальность. Ваши данные остаются при вас, ответы приходят с молниеносной скоростью, вы можете быть спокойны, зная, что ваш чат-бот не разболтает ваши секреты по всем публичным сервисам.

Дух инноваций в области ИИ усиливается сообществом разработчиков ПО с открытым исходным кодом. По этой традиции полный исходный код модели чата Qwen доступен на GitHub для всех, кто интересуется механикой модели, хочет внести свой вклад в ее разработку или просто использовать его в качестве учебных материалов. Независимо от того, являетесь ли вы исследователем, разработчиком или любителем ИИ, вы можете получить доступ к исходному коду на Qwen.

Прежде чем мы отправимся в эту техническую одиссею, давайте убедимся, что у вас есть все необходимое:

Все готово? Прекрасно! Давайте начнем.

Независимо от того, являетесь ли вы ярым поклонником Visual Studio Code, энтузиастом PyCharm или тем, кто любит интерактивный стиль Jupyter Notebook, код на Python для чата с Qwen отличается гибкостью и не зависит от IDE. Все, что вам нужно, — это среда, поддерживающая Python. И все готово, чтобы запустить чат с вашим собеседником на основе искусственного интеллекта.

Совет от профессионалов: если вы используете VSCode, воспользуйтесь встроенным терминалом для беспрепятственного запуска скриптов на Python. Просто откройте палитру команд (Ctrl+Shift+P), введите Python: Run Python File in Terminal и пусть VSCode выполнить всю работу. Вы можете читать ответы Qwen прямо на вашем встроенном терминале.

Для тех, кто предпочитает PyCharm, запуск кода будет таким же плавным. Щелкните правой кнопкой мыши свой скрипт и выберите «Запустить 'script_name.py'» и наблюдайте, как IDE выполняет ваш диалог с Qwen. Мощные инструменты и функции отладки PyCharm делают его отличным выбором для разработки более сложных взаимодействий.

Но и на этом дело не закончилось — существует множество IDE и редакторов кода, которые приветствуют Python с распростертыми объятиями. Выберите тот, который лучше всего подходит для вашего рабочего процесса, и начните общаться!

Прежде всего, давайте подготовим сервер Linux. Убедитесь, что ваш список пакетов, Python и pip готовы к работе:

sudo apt update

sudo apt install python3 python3-pipТеперь секретный ингредиент: виртуальная среда. Это похоже на личное рабочее пространство, где вы можете устроить беспорядок, и при этом никто не кричит на вас, чтобы вы убрали:

pip install --user virtualenv

virtualenv qwen_env

source qwen_env/bin/activateПрежде чем мы активизируем Qwen, вам понадобятся некоторые инструменты. Представьте, что вы собираете ингредиенты для блюда, отмеченного звездой Мишлен:

pip install torch torchvision torchaudio

pip install transformersНе забудьте совместить PyTorch с вашей версией CUDA — это все равно, что подобрать правильный сыр к вину.

Слова остаются просто словами, пока Qwen не придаст им значения. Вот тут-то и нуждаться в помощи токенизатора, который преобразует ваш текст в отдельные единицы информации, которые Qwen может обрабатывать:

from transformers import AutoTokenizer

tokenizer = AutoTokenizer.from_pretrained("Qwen/Qwen-7B-Chat", trust_remote_code=True)Возможность Qwen огромен и Qwen готов к вашим разговорам. Вот как разбудить спящего гиганта:

from transformers import AutoModelForCausalLM

model = AutoModelForCausalLM.from_pretrained("Qwen/Qwen-7B-Chat", device_map="auto", trust_remote_code=True).eval()В зависимости от аппаратного обеспечения вы можете выбрать различные режимы точности, например BF16 или FP16. Это как настроить вашу гитару на идеальный слух.

Теперь наступает самое приятное время — чат с Qwen! Но прежде чем вы увлечетесь болтовней, давайте поговорим о чем-то важном: искусстве непрерывности диалога.

Вот фрагмент остроумного диалога, который вы можете ожидать:

response, history = model.chat(tokenizer, "Greetings, Qwen! How's life in the digital realm?", history=None)

print("Qwen:", response)В начале мы приветствуем Qwen без каких-либо условий, то есть без истории диалога. Установив history=None, мы говорим Qwen: «Это начало нашего чата». Qwen, не имея ничего, кроме текущей подсказки, ответит оригинальностью нового взаимодействия.

Сейчас наблюдайте за тем, как разворачивается магия контекста:

response, history = model.chat(tokenizer, "Any thoughts on the meaning of life, the universe, and everything?", history=history)

print("Qwen:", response)В этом раунде мы передаем историю, которую мы получили от нашего предыдущей беседы. Это все равно, что передать Qwen дневник со всем, о чем мы говорили до сих пор. Благодаря этому историческому контексту Qwen может дать ответ, который будет не только остроумным или глубоким, но и связанным с нашим текущим диалогом. Это разница между общением с мудрым другом, который вас знает, и заданием вопросов незнакомцу.

Теперь, когда вы знаете, как важен контекст с параметром истории, запустите демонстрационный скрипт и приготовьтесь к увлекательному чату с Qwen. Независимо от того, обсуждаете ли вы космос или лучший рецепт цифрового cookie, Qwen готов следовать за вами в разговоре со всей изяществом опытного собеседника.

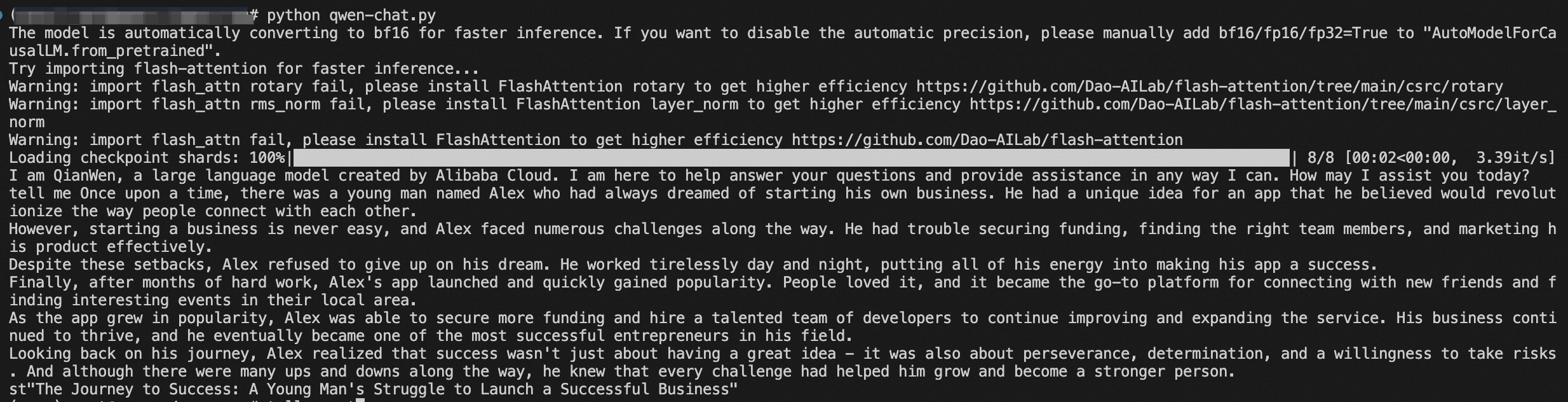

Кроме того, вы можете запустить данный скрипт и начать диалог. Это похоже на открытие ящика Пандоры, но вместо хаоса, вы получаете восхитительный подшучивание:

python qwen_chat.pyИ вот, мой друг, у тебя есть собственный собеседник на основе искусственного интеллекта. Приготовьтесь покорить мир общения.

Поздравляем! Вы прошли по коварным водам развертывания искусственного интеллекта, как опытный капитан. Qwen теперь надежно развернут на вашем сервере и ваши данные в безопасности, как дома.

Исследуйте возможности Qwen, внесите свой вклад в его развитие и присоединитесь к сообществу единомышленников, увлеченных развитием технологий искусственного интеллекта.

Итак, идите вперед и вступайте в эпические диалоги со своим новым блестящим помощником на основе искусственного интеллекта. И кто знает? Может быть, Qwen удивит вас своей цифровой мудростью или шуткой, которая заставит вас смеяться.

Эта статья изначально была написана на английском. Посмотрите оригинальную статью здесь

การใช้ AI เพื่อนแชทของคุณเอง - การปรับใช้โมเดล Qwen Chat ด้วย HuggingFace Guide

Der Beginn der KI-Revolution – eine Reise mit RAG und LangChain

89 posts | 3 followers

FollowRegional Content Hub - April 22, 2024

Morningking - September 26, 2023

Morningking - September 26, 2023

Alibaba Clouder - August 15, 2017

Chao - June 26, 2023

Balaban - October 19, 2021

89 posts | 3 followers

Follow Tongyi Qianwen (Qwen)

Tongyi Qianwen (Qwen)

Top-performance foundation models from Alibaba Cloud

Learn More AI Acceleration Solution

AI Acceleration Solution

Accelerate AI-driven business and AI model training and inference with Alibaba Cloud GPU technology

Learn More Alibaba Cloud for Generative AI

Alibaba Cloud for Generative AI

Accelerate innovation with generative AI to create new business success

Learn More Platform For AI

Platform For AI

A platform that provides enterprise-level data modeling services based on machine learning algorithms to quickly meet your needs for data-driven operations.

Learn MoreMore Posts by Regional Content Hub