阿里雲流式資料服務DataHub是流式資料(Streaming Data)的處理平台,提供對流式資料的發布、訂閱和分發功能,讓您可以輕鬆構建基於流式資料的分析和應用。通過Data Transmission Service,您可以將RDS MySQL的資料同步至DataHub,協助您快速實現使用Realtime Compute等巨量資料產品對資料即時分析。

前提條件

DataHub執行個體的地區為華東1、華東2、華北2或華南1。

DataHub執行個體中,已建立用作接收同步資料的專案(Project),詳情請參見建立專案。

RDS MySQL中待同步的表需具備主鍵或唯一約束。

費用說明

| 同步類型 | 鏈路配置費用 |

| 庫表結構同步和全量資料同步 | 不收費。 |

| 增量資料同步 | 收費,詳情請參見計費概述。 |

功能限制

不支援全量資料初始化,即DTS不會將源RDS執行個體中同步對象的存量資料同步至目標DataHub執行個體。

僅支援表層級的資料同步。

資料同步的過程中,請勿對源庫中待同步的表執行DDL變更,否則會導致同步失敗。

支援同步的SQL操作

操作類型 | SQL動作陳述式 |

DML | INSERT、UPDATE、DELETE |

DDL | ADD COLUMN |

操作步驟

購買資料同步作業,詳情請參見購買流程。

說明購買時,選擇源執行個體為MySQL、目標執行個體為DataHub,並選擇同步拓撲為單向同步。

登入資料轉送控制台。

說明若資料轉送控制台自動跳轉至Data Management控制台,您可以在右下角的

中單擊

中單擊 ,返回至舊版資料轉送控制台。

,返回至舊版資料轉送控制台。在左側導覽列,單擊資料同步。

在同步作業列表頁面頂部,選擇同步的目標執行個體所屬地區。

定位至已購買的資料同步執行個體,單擊配置同步鏈路。

配置同步作業的源執行個體及目標執行個體資訊。

類別

配置

說明

無

同步作業名稱

DTS會自動產生一個同步作業名稱,建議配置具有業務意義的名稱(無唯一性要求),便於後續識別。

源執行個體資訊

執行個體類型

根據源庫的部署位置進行選擇,本文以RDS執行個體為例介紹配置流程。

說明如果源庫為自建MySQL資料庫,您還需要執行相應的準備工作,詳情請參見準備工作概覽。

執行個體地區

購買資料同步執行個體時選擇的源執行個體地區資訊,不可變更。

執行個體ID

選擇作為資料同步源的RDS執行個體ID。

資料庫帳號

填入源RDS的資料庫帳號。

說明當源RDS執行個體的資料庫類型為MySQL 5.5或MySQL 5.6時,無需配置資料庫帳號和資料庫密碼。

資料庫密碼

填入資料庫帳號對應的密碼。

串連方式

根據需求選擇非加密串連或SSL安全連線。如果設定為SSL安全連線,您需要提前開啟RDS執行個體的SSL加密功能,詳情請參見使用雲端認證快速開啟SSL鏈路加密。

重要目前僅中國內地及中國香港地區支援設定串連方式。

目標執行個體資訊

執行個體類型

固定為DataHub,不可變更。

執行個體地區

購買資料同步執行個體時選擇的目標執行個體地區資訊,不可變更。

Project

選擇DataHub執行個體的Project。

單擊頁面右下角的授權白名單並進入下一步。

如果源或目標資料庫是阿里雲資料庫執行個體(例如RDS MySQL、ApsaraDB for MongoDB等),DTS會自動將對應地區DTS服務的IP地址添加到阿里雲資料庫執行個體的白名單中;如果源或目標資料庫是ECS上的自建資料庫,DTS會自動將對應地區DTS服務的IP地址添加到ECS的安全規則中,您還需確保自建資料庫沒有限制ECS的訪問(若資料庫是叢集部署在多個ECS執行個體,您需要手動將DTS服務對應地區的IP地址添加到其餘每個ECS的安全規則中);如果源或目標資料庫是IDC自建資料庫或其他雲資料庫,則需要您手動添加對應地區DTS服務的IP地址,以允許來自DTS伺服器的訪問。DTS服務的IP地址,請參見DTS伺服器的IP位址區段。

警告DTS自動添加或您手動添加DTS服務的公網IP位址區段可能會存在安全風險,一旦使用本產品代表您已理解和確認其中可能存在的安全風險,並且需要您做好基本的安全防護,包括但不限於加強帳號密碼強度防範、限制各網段開放的連接埠號碼、內部各API使用鑒權方式通訊、定期檢查並限制不需要的網段,或者使用通過內網(專線/VPN網關/智能網關)的方式接入。

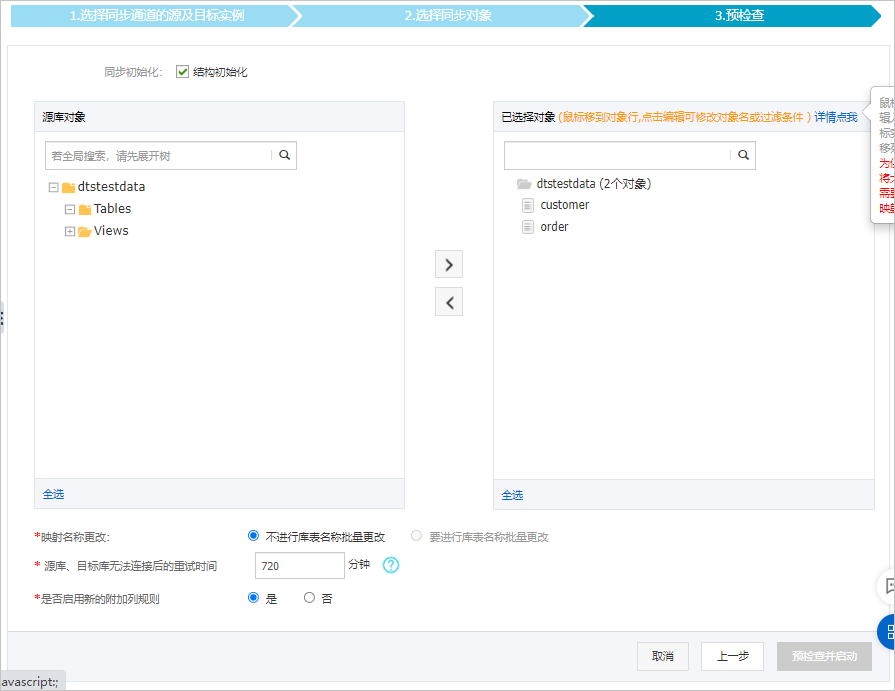

配置同步策略和同步對象。

配置

說明

同步初始化

勾選結構初始化。

說明勾選結構初始化後,在資料同步作業的初始化階段,DTS會將同步對象的結構資訊(例如表結構)同步至目標DataHub執行個體。

選擇同步對象

在源庫對象框中單擊待遷移的對象,然後單擊

將其移動至已選擇對象框。說明

將其移動至已選擇對象框。說明同步對象的選擇粒度為表。

預設情況下,同步對象的名稱保持不變。如果您需要改變同步對象在目標執行個體中的名稱,需要使用對象名映射功能,詳情請參見設定同步對象在目標執行個體中的名稱。

選擇附加列規則

DTS在將資料同步到DataHub時,會在同步的目標Topic中添加一些附加列。如果附加列和目標Topic中已有的列出現名稱衝突將會導致資料同步失敗。您需要根據業務需求選擇是否啟用新的附加列規則為是或否。

警告在選擇附加列規則前,您需要評估附加列和目標Topic中已有的列是否會出現名稱衝突,否則可能會導致任務失敗或資料丟失。關於附加列的規則和定義說明,請參見附加列名稱和定義說明。

映射名稱更改

如需更改同步對象在目標執行個體中的名稱,請使用對象名映射功能,詳情請參見庫表列映射。

源表DMS_ONLINE_DDL過程中是否複製暫存資料表到目標庫

如源庫使用Data Management(Data Management)執行Online DDL變更,您可以選擇是否同步Online DDL變更產生的暫存資料表資料。

是:同步Online DDL變更產生的暫存資料表資料。

說明Online DDL變更產生的暫存資料表資料過大,可能會導致同步任務延遲。

否:不同步Online DDL變更產生的暫存資料表資料,只同步源庫的原始DDL資料。

說明該方案會導致目標庫鎖表。

源、目標庫無法串連重試時間

當源、目標庫無法串連時,DTS預設重試720分鐘(即12小時),您也可以自訂重試時間。如果DTS在設定的時間內重新串連上源、目標庫,同步任務將自動回復。否則,同步任務將失敗。

說明由於串連重試期間,DTS將收取任務運行費用,建議您根據業務需要自訂重試時間,或者在源和目標庫執行個體釋放後儘快釋放DTS執行個體。

可選:將滑鼠指標放置在已選擇對象框中待同步的Topic名上,單擊對象後出現的編輯,然後在彈出的對話方塊中設定Shardkey(即用於分區的key)。

上述配置完成後,單擊頁面右下角的預檢查並啟動。

說明在同步作業正式啟動之前,會先進行預檢查。只有預檢查通過後,才能成功啟動同步作業。

如果預檢查失敗,單擊具體檢查項後的

,查看失敗詳情。

,查看失敗詳情。您可以根據提示修複後重新進行預檢查。

如無需修複警示檢測項,您也可以選擇確認屏蔽、忽略警示項並重新進行預檢查,跳過警示檢測項重新進行預檢查。

在預檢查對話方塊中顯示預檢查通過後,關閉預檢查對話方塊,同步作業將正式開始。

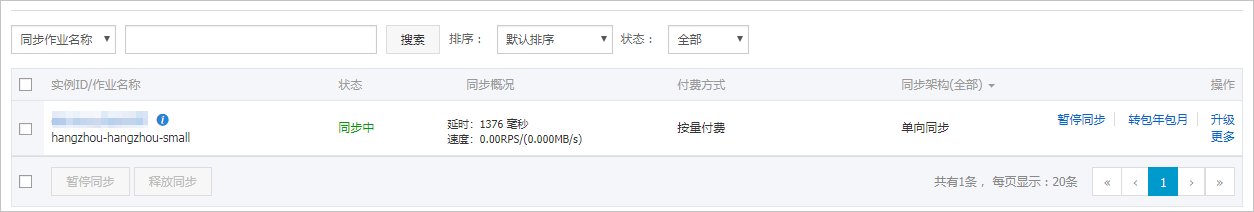

等待同步作業的鏈路初始化完成,直至處於同步中狀態。

您可以在資料同步頁面,查看資料同步作業的狀態。

Topic結構定義說明

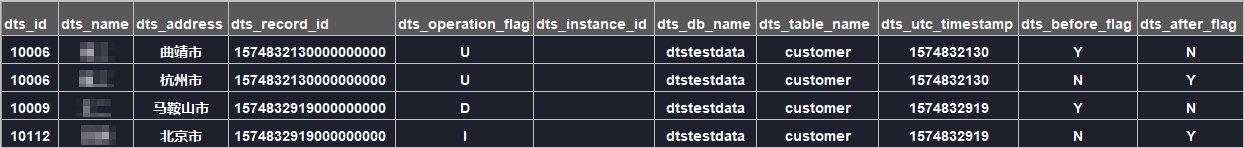

DTS在將資料變更同步至DataHub執行個體的Topic時,目標Topic中除了儲存變更資料外,還會新增一些附加列用於儲存元資訊,樣本如下。

本案例中的業務欄位為id、name、address,由於在配置資料同步時選用的是舊版附加列規則,DTS會為業務欄位(包含目標庫中的源庫原有的業務欄位)添加dts_的首碼。若您使用新版附加列規則,DTS不會給目標庫中的源庫原有業務欄位加首碼。

結構定義說明:

舊版附加列名稱 | 新版附加列名稱 | 資料類型 | 說明 |

|

| String | 增量日誌的記錄ID,為該日誌唯一標識。 說明

|

|

| String | 操作類型,取值:

|

|

| String | 資料庫的server ID。 |

|

| String | 資料庫名稱。 |

|

| String | 表名。 |

|

| String | 操作時間戳記,即日誌的時間戳記(UTC 時間)。 |

|

| String | 所有列的值是否更新前的值,取值:Y或N。 |

|

| String | 所有列的值是否更新後的值,取值:Y或N。 |

關於dts_before_flag和dts_after_flag的補充說明

對於不同的操作類型,增量日誌中的dts_before_flag和dts_after_flag定義如下:

INSERT

當操作類型為INSERT時,所有列的值為新插入的值,即為更新後的值,所以

dts_before_flag取值為N,dts_after_flag取值為Y,樣本如下。

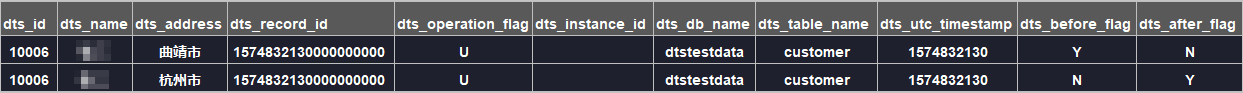

UPDATE

當操作類型為UPDATE時,DTS會將UPDATE操作拆分為兩條增量日誌。這兩條增量日誌的

dts_record_id、dts_operation_flag及dts_utc_timestamp對應的值相同。第一條增量日誌記錄了更新前的值,所以

dts_before_flag取值為Y,dts_after_flag取值為N。第二條增量日誌記錄了更新後的值,所以dts_before_flag取值為N,dts_after_flag取值為Y,樣本如下。

DELETE

當操作類型為DELETE時,增量日誌中所有的列值為被刪除的值,即列值不變,所以

dts_before_flag取值為Y,dts_after_flag取值為N,樣本如下。

後續操作

配置完資料同步作業後,您可以對同步到DataHub執行個體中的資料執行計算分析。更多詳情,請參見阿里雲Realtime Compute。