在DataWorks中,您可按照工作空間粒度指定各模組使用的SPARK參數,後續各模組將預設使用對應SPARK參數執行任務。您可參考Spark官方文檔自訂全域Spark參數,並配置全域Spark參數的優先順序是否高於指定模組內(資料開發、資料分析、營運中心)的SPARK參數。本文為您介紹如何設定全域Spark參數。

背景資訊

Apache Spark是用於進行大規模資料分析的引擎。在DataWorks中,您可通過如下方式配置調度節點運行時使用的Spark參數:

方式一:配置全域Spark參數

設定工作空間層級某DataWorks功能模組運行EMR任務時使用哪個Spark參數,並定義此處配置的Spark參數優先順序是否高於指定模組內配置的Spark參數。詳情請參見設定全域Spark參數。

方式二:配置產品模組內Spark參數

資料開發(Data Studio):對於Hive、Spark節點,可在節點編輯頁面右側的調度配置中,設定單個節點任務的Spark屬性參數。

其他產品模組:暫不支援在模組內單獨設定Spark屬性參數。

使用限制

僅以下角色可配置全域Spark參數:

阿里雲主帳號。

擁有AliyunDataWorksFullAccess許可權的子帳號(RAM使用者)或RAM角色。

擁有空間管理員角色的子帳號(RAM使用者)。

Spark參數僅針對EMR Spark節點、EMR Spark SQL節點、EMR Spark Streaming節點生效。

說明如需在DataWorks中使用Spark啟用Ranger許可權控制,請在設定全域Spark參數中添加配置

spark.hadoop.fs.oss.authorization.method=ranger,以確保Ranger許可權控制生效。您可在DataWorks的管理中心及阿里雲E-MapReduce控制台中更新Spark相關配置,若相同Spark參數在兩者中的配置不同,則通過DataWorks提交的任務將採用DataWorks管理中心中的配置。

目前僅支援對資料開發(Data Studio)、資料品質、資料分析、營運中心模組設定全域Spark參數。

前提條件

登入EMR叢集至DataWorks,詳情請參見新版資料開發:綁定EMR計算資源。

設定全域Spark參數

進入全域Spark參數配置頁面。

進入管理中心頁面。

登入DataWorks控制台,切換至目標地區後,單擊左側導覽列的,在下拉框中選擇對應工作空間後單擊進入管理中心。

單擊左側導覽列的計算資源,進入計算資源頁面。

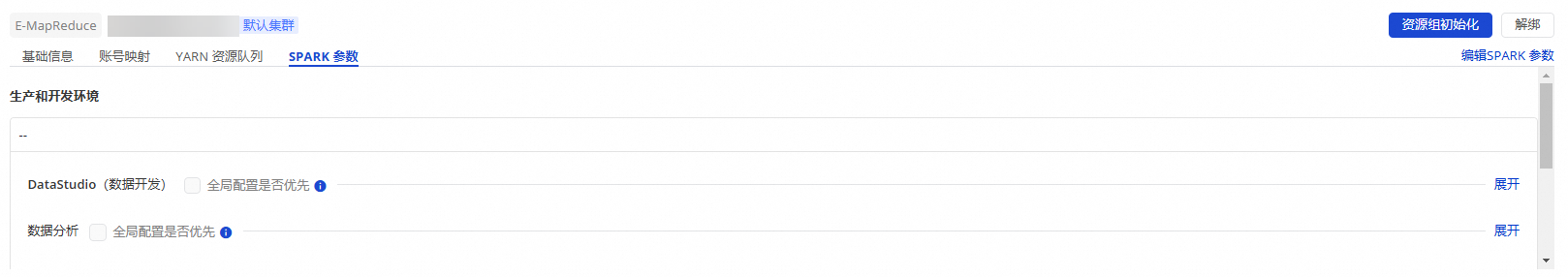

找到目標EMR叢集,單擊SPARK參數,進入全域SPARK參數配置頁面。

設定全域Spark參數。

單擊SPARK參數頁面右上方的編輯SPARK參數,配置各模組的全域SPARK參數及優先順序。

說明該配置為工作空間全域配置,請在配置前確認所使用的工作空間是否正確。

參數

步驟

Spark屬性

配置各模組運行EMR任務時使用的Spark屬性(Spark屬性名稱、Spark屬性值)。您可參考Spark Configurations、Spark Configurations on Kubernetes配置。

全域配置是否優先

勾選後,表示全域配置將比產品模組內配置優先生效;此時將按照全域配置的Spark屬性來統一運行任務。

全域配置:表示在的EMR叢集SPARK參數頁面配置的Spark屬性參數。

說明目前僅支援對資料開發(Data Studio)、資料品質、資料分析、營運中心模組設定全域Spark參數。

產品模組內配置:

資料開發(Data Studio):對於Hive、Spark節點,可在節點編輯頁面右側的調度配置中,設定單個節點任務的Spark屬性參數。

其他產品模組:暫不支援在模組內單獨設定Spark屬性參數。