熟悉Spark的開發人員都瞭解SparkPi,它相當於Spark引擎的”Hello World!“。本文介紹如何在DLA控制台跑通SparkPi。

準備事項

- 您需要在提交作業之前首先建立虛擬叢集。說明 建立虛擬叢集時注意選擇引擎類型為Spark。

- 如果您是子帳號登入,需要配置子帳號提交作業的許可權,具體操作請參考快速配置子帳號許可權。

操作步驟

- 登入雲原生資料湖分析管理主控台。

- 在概覽頁面的左上方,選擇虛擬叢集所在地區。

- 單擊左側導覽列的。

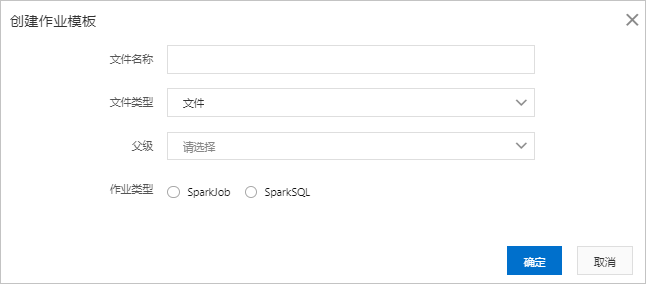

- 在作業編輯頁面,單擊建立工作範本,填寫以下作業資訊:

- 新建立的作業中包含了SparkPi作業的預設配置,在作業編輯頁面,單擊執行即可。說明 關於作業提交的詳細說明,請參見建立和執行Spark作業。