本文為您介紹如何使用資料轉送遷移 PolarDB-X 1.0 資料庫的資料至 OceanBase 資料庫 MySQL 租戶。

如果資料移轉任務長期處於非活躍狀態(任務狀態為 失敗、已暫停 或 已完成),受增量日誌保留時間長度等影響,任務可能無法恢複。資料轉送將主動釋放處於非活躍狀態超過 3 天的資料移轉任務,以回收相關資源,建議您為任務配置警示並及時處理任務相關異常。

背景資訊

PolarDB-X 1.0 是由阿里巴巴自主研發的雲原生分散式資料庫,融合分布式 SQL 引擎和分布式自研儲存 X-DB,雲端式原生一體化架構設計。PolarDB-X 1.0 可以支撐千萬級並發規模,以及百 PB 級海量儲存。詳情請參見 產品概述。

PolarDB-X 1.0 資料庫至 OceanBase 資料庫 MySQL 租戶的資料移轉任務啟動成功後,該任務會自動刪除。資料轉送會自動建立 PolarDB-X 1.0 資料庫下掛載的 MySQL 資料庫至 OceanBase 資料庫 MySQL 租戶的資料移轉任務,其任務個數取決於 PolarDB-X 1.0 資料庫底層的 MySQL 執行個體個數。

建議您使用標籤或任務名稱作為過濾條件對這些任務進行大量啟動、大量暫停、批量正向切換等操作。大量操作的詳情請參見 大量操作資料移轉任務。

前提條件

資料轉送已具備雲資源存取權限。詳情請參見 資料轉送遷移角色授權。

已為源端 PolarDB-X 1.0 資料庫和目標端 OceanBase 資料庫 MySQL 租戶建立專用於資料移轉的資料庫使用者,並賦予其相關許可權。

使用限制

源端資料庫的操作限制

請勿在全量遷移階段執行庫或表結構變更的 DDL 操作,否則可能造成資料移轉任務中斷。

資料轉送支援 PolarDB-X 1.0 資料庫 V5.2.8、V5.4.2、V5.4.9 和 V5.4.12。

資料轉送支援 PolarDB-X 1.0 資料庫下掛載的 RDS MySQL 相容的 MySQL 資料庫 V5.5、V5.6、V5.7 和 V8.0,以及標準 RDS 和 PolarDB MySQL 執行個體。

資料轉送僅支援遷移庫名、表名和列名為 ASCII 碼且不包含特殊字元(包括換行、空格,以及 .|"'`()=;/&\)的對象。

遷移 PolarDB-X 1.0 資料庫的資料至 OceanBase 資料庫 MySQL 租戶時,資料轉送不支援以下內容:

不支援結構遷移和反向增量。

不支援源端和目標端資料庫跨阿里雲帳號。

不支援遷移視圖。

不支援 PolarDB-X 1.0 資料庫下掛載的 RDS MySQL 執行個體的帳號密碼不一致。

OceanBase 資料庫支援的字元集為 utf8mb4、gbk、gb18030、binary 和 utf16。

注意事項

對於無唯一鍵表(指具有主鍵或者 Not Null UK 的表)的遷移,在重啟或恢複全量遷移步驟時,通常資料轉送會自動清空(TRUNCATE)重啟或恢複前已完成同步的目標表。但在 PolarDB-X 1.0 情境下,RDS MySQL 資料庫無唯一鍵表至 OceanBase 資料庫 MySQL 租戶的資料移轉任務的全量遷移步驟在重啟或恢複時,資料轉送不會自動清空目標表。

如果您未配置 PolarDB-X 1.0 資料庫物件的映射關係,則物理表的資料會全部同步至目標端相同名稱的物理表中,即源端物理表的數量和目標端數量一致。

如果源端和目標端的表結構不完全一致,可能會出現資料不一致的情況。目前已知情境如下:

使用者手動建立表結構時,可能會因超出資料轉送的支援範圍而產生隱式的轉換問題,導致源端和目標端列的類型不一致。

目標端的資料長度小於源端的資料長度時,可能出現資料截斷的情況,導致源端和目標端的資料不一致。

如果建立資料移轉任務時,您僅配置了 增量同步處理,資料轉送要求源端資料庫的本地增量日誌儲存 48 小時以上。

如果建立資料移轉任務時,您配置了 全量遷移+增量同步處理,資料轉送要求源端資料庫的本地增量日誌至少保留 7 天以上。否則資料轉送可能因為無法擷取增量日誌導致資料移轉任務失敗,甚至導致源端和目標端資料不一致。

如果源端或目標端存在僅大小寫不同的表對象,可能會因為源端或目標端大小寫不敏感導致資料移轉的結果不符合預期。

支援的源端和目標端執行個體類型

下表中,OceanBase 資料庫 MySQL 租戶簡稱為 OB_MySQL。

源端 | 目標端 |

PolarDB-X 1.0(阿里雲 PolarDB-X 1.0 執行個體) | OB_MySQL(OceanBase 叢集執行個體) |

PolarDB-X 1.0(阿里雲 PolarDB-X 1.0 執行個體) | OB_MySQL(Serverless 執行個體) |

操作步驟

登入 OceanBase 管理主控台,購買資料移轉任務。

詳情請參見 購買資料移轉任務。

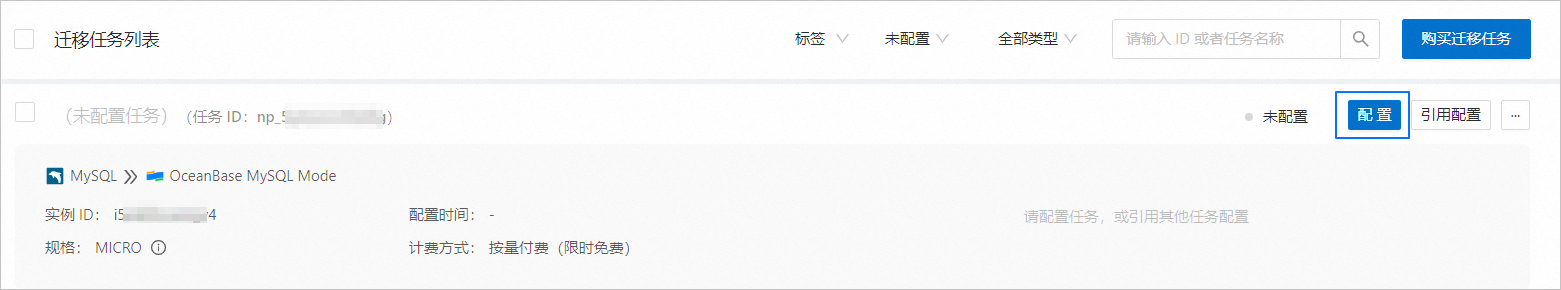

在 資料轉送 > 資料移轉 頁面,單擊新購買的資料移轉任務後的 配置。

如果您需要引用已有的任務配置資訊,可以單擊 引用配置。詳情請參見 引用資料移轉任務配置。

在 選擇源和目標 頁面,配置各項參數。

參數

描述

遷移任務名稱

建議使用中文、數字和字母的組合。名稱中不能包含空格,長度不得超過 64 個字元。

源端

如果您已建立 PolarDB-X 1.0 資料來源,請從下拉式清單中進行選擇。如果未建立,請單擊下拉式清單中的 建立資料來源,在右側對話方塊進行建立。參數詳情請參見 建立 PolarDB-X 1.0 資料來源。

目標端

如果您已建立 OceanBase 資料庫 MySQL 租戶資料來源,請從下拉式清單中進行選擇。如果未建立,請單擊下拉式清單中的 建立資料來源,在右側對話方塊進行建立。參數詳情請參見 建立 OceanBase 資料來源。

標籤

單擊文字框,在下拉式清單中選擇目標標籤。您也可以單擊 管理標籤,進行建立、修改和刪除。詳情請參見 通過標籤管理資料移轉任務。

說明PolarDB-X 1.0 資料庫至 OceanBase 資料庫 MySQL 租戶的資料移轉任務啟動成功後,該任務會自動刪除,請選擇合適的標籤進行標記。

擊 下一步。在 選擇遷移類型 頁面,選擇當前資料移轉任務的遷移類型。

遷移類型支援 全量遷移、增量同步處理 和 全量校正。

遷移類型

描述

全量遷移

全量遷移任務開始後,資料轉送會將源端庫表的存量資料移轉至目標端資料庫對應的表中。

執行資料移轉前,請評估源端和目標端的效能,建議在業務低峰期執行資料移轉。否則全量遷移期間,資料轉送佔用源端和目標端一定的讀寫資源,可能會導致資料庫的負載上升。效能評估詳情請參見 遷移評估的效能評估。

增量同步處理

增量同步處理任務開始後,資料轉送會同步源端資料庫發生變化的資料(新增、修改或刪除)至目標端資料庫對應的表中。

增量同步處理 支援的同步 DML 包括

Insert、Delete和Update,您可以根據需求進行選擇。詳情請參見 自訂配置 DDL/DML。全量校正

在全量遷移完成、增量資料同步至目標端並與源端基本追平後,資料轉送會自動發起一輪針對源端庫配置的資料表和目標表的全量資料校正任務。

如果您選擇了 增量同步處理,且 同步 DML 選項中未選擇所有的 DML,則資料轉送不支援本情境下的全量資料校正。

執行資料移轉前,請評估源端和目標端的效能,建議業務低峰期執行資料移轉。否則全量校正期間,資料轉送佔用源端和目標端部分讀資源,可能會導致資料庫的負載上升。

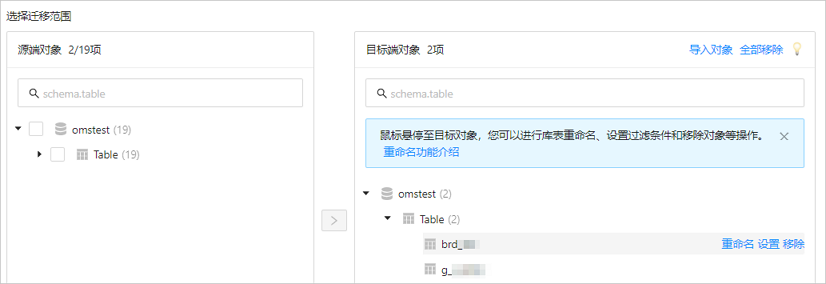

單擊 下一步。在 選擇遷移對象 頁面,選擇當前資料移轉任務的遷移對象。

目前僅支援通過 指定對象 的方式選擇遷移對象。在左側選中需要遷移的對象,單擊 >,將其添加至右側列表中。您可以選擇一個或多個庫的表作為遷移對象。

資料轉送支援通過文本匯入對象,並支援對目標端對象進行重新命名、設定行過濾、查看列資訊,以及移除單個或全部遷移對象等操作。

操作

步驟

匯入對象

在選擇地區的右側列表中,單擊右上方的 匯入對象。

在對話方塊中,單擊 確定。

重要匯入會覆蓋之前的操作選擇,請謹慎操作。

在 匯入遷移對象 對話方塊中,匯入需要遷移的對象。

您可以通過匯入 CSV 檔案的方式進行庫表重新命名、設定行過濾條件等操作。詳情請參見 下載和匯入遷移對象配置。

單擊 檢驗合法性。

完成遷移對象匯入後,請先檢驗合法性。目前暫不支援欄欄位映射。

通過檢驗後,單擊 確定。

重新命名

資料轉送支援重新命名遷移對象的名稱,詳情請參見 資料庫庫表重新命名。

設定

資料轉送支援

WHERE條件實現行過濾,詳情請參見 SQL 條件過濾資料。您還可以在 查看列 地區,查看遷移對象的列資訊。

移除/全部移除

資料轉送支援在資料對應時,對暫時選中到目標端的單個或多個對象進行移除操作。

移除單個遷移對象

在選擇地區的右側列表中,滑鼠移至上方至目標對象,單擊顯示的 移除,即可移除該遷移對象。

移除全部遷移對象

在選擇地區的右側列表中,單擊右上方的 全部移除。在對話方塊中,單擊 確定,即可移除全部遷移對象。

單擊 下一步。在 遷移選項 頁面,配置各項參數。

全量遷移

在 選擇遷移類型 頁面,選中 全量遷移,才會顯示下述參數。

參數

描述

讀取並發配置

該參數用於配置全量遷移階段從源端讀取資料的並發數,最大限制為 512.並發數過高可能會造成源端壓力過大,影響業務。

寫入並發配置

該參數用於配置全量遷移階段往目標端寫入資料的並發數,最大限制為 512。並發數過高可能會造成目標端壓力過大,影響業務。

全量遷移速率限制

您可以根據實際需求決定是否開啟全量遷移速率限制。如果開啟,請設定 RPS(全量遷移階段每秒最多可以遷移至目標端的資料行數的最大值限制)和 BPS(全量遷移階段每秒最多可以遷移至目標端的資料量的最大值限制)。

說明此處設定的 RPS 和 BPS 僅作為限速限流能力,全量遷移實際可以達到的效能受限於源端、目標端、執行個體規格配置等因素的影響。

目標端表對象存在記錄時處理策略

處理策略包括 忽略 和 停止遷移:

選擇 忽略:當目標端表對象存在資料時,如果原資料與寫入資料衝突,資料轉送採用將衝突資料記錄日誌,保留原資料不變的策略進行資料寫入。

重要選擇 忽略,全量校正將使用 IN 模式拉取資料,無法校正目標端存在源端沒有的資料的情境,並且校正效能會有一定程度降級。

選擇預設值 停止遷移:當目標端表對象存在資料時,全量遷移會報錯不允許遷移,請處理好目標端資料後再繼續遷移。

重要如果出錯後單擊恢複,資料轉送將忽略該配置選項,繼續遷移表資料,請謹慎操作。

增量同步處理

在 選擇遷移類型 頁面,選中 增量同步處理,才會顯示下述參數。

參數

描述

寫入並發配置

該參數用於配置增量同步處理階段往目標端寫入資料的並發數,最大限制為 512。並發數過高可能會造成目標端壓力過大,影響業務。

增量同步處理速率限制

您可以根據實際需求決定是否開啟增量同步處理速率限制。如果開啟,請設定 RPS(增量同步處理階段每秒最多可以同步至目標端的資料行數的最大值限制)和 BPS(增量同步處理階段每秒最多可以同步至目標端的資料量的最大值限制)。

說明此處設定的 RPS 和 BPS 僅作為限速限流能力,增量同步處理實際可以達到的效能受限於源端、目標端、執行個體規格配置等因素的影響。

增量同步處理起始位點

如果選擇遷移類型時已選擇 全量遷移,則不顯示該參數。

如果選擇遷移類型時未選擇 全量遷移,但選擇了 增量同步處理,請在此處指定遷移某個時間節點之後的資料,預設為當前系統時間。詳情請參見 設定增量同步處理位點。

單擊 預檢查,系統對資料移轉任務進行預檢查。

在 預檢查 環節,資料轉送會檢查資料庫使用者的讀寫權限、資料庫的網路連接等是否符合要求。全部檢查任務均通過後才能啟動資料移轉任務。如果預檢查報錯:

您可以在排查並處理問題後,重新執行預檢查,直至預檢查成功。

您也可以單擊錯誤預檢查項操作列中的 跳過,會彈出對話方塊提示您跳過本操作的具體影響,確認可以跳過後,請單擊對話方塊中的 確定。

預檢查成功後,單擊 啟動任務。

如果您暫時無需啟動任務,請單擊 儲存。後續您只能在 遷移工作清單 頁面手動啟動任務或通過大量操作啟動任務。大量操作的詳情請參見 大量操作資料移轉任務。

任務啟動成功後,PolarDB-X 1.0 資料庫至 OceanBase 資料庫 MySQL 租戶的資料移轉任務會自動刪除,資料轉送會儲存 PolarDB-X 1.0 資料庫下掛載的資料庫至 OceanBase 資料庫 MySQL 租戶的資料移轉任務,並自動建立相應的資料來源。您可以在彈出對話方塊中單擊 下載為檔案,將相關資訊儲存為 CSV 檔案。

單擊對話方塊中的 確定,進入 遷移工作清單 頁面,單個或大量啟動 MySQL 資料庫至 OceanBase 資料庫 MySQL 租戶的資料移轉任務。

資料轉送支援在資料移轉任務運行過程中修改遷移對象,詳情請參見 查看和修改遷移對象及其過濾條件。資料移轉任務啟動後,會根據選擇的遷移類型依次執行,詳情請參見 查看遷移詳情。