작성자: JV Roig

Alibaba Cloud의 생성형 AI 배포 접근 방식 시리즈 파트 2에 오신 것을 환영합니다.

이 시리즈의 파트 1에서는 Elastic Compute Service (ECS)를 사용한 IaaS(서비스형 인프라) genAI 배포를 다루었습니다. 파트 1에서 살펴본 것처럼, 이것은 매우 강력하고 유연한 방식으로 생성형 AI를 배포할 수 있는 방법입니다. 하지만 안타깝게도 전체 스택의 운영과 유지보수를 우리가 책임져야 하기 때문에 많은 단계와 관리 오버헤드가 수반됩니다.

더 쉽고, 더 빠르고, 더 적은 오버헤드로 만들 수 있을까요? 네, 가능합니다!

오늘은 Alibaba Cloud Platform for AI (PAI)를 사용하여 PaaS(서비스형 플랫폼) 접근 방식을 살펴보겠습니다. PaaS 접근 방식을 통해 어떻게 운영 오버헤드를 줄이고 유용한 생성형 AI 서비스를 몇 분 안에 배포할 수 있는지 살펴보겠습니다.

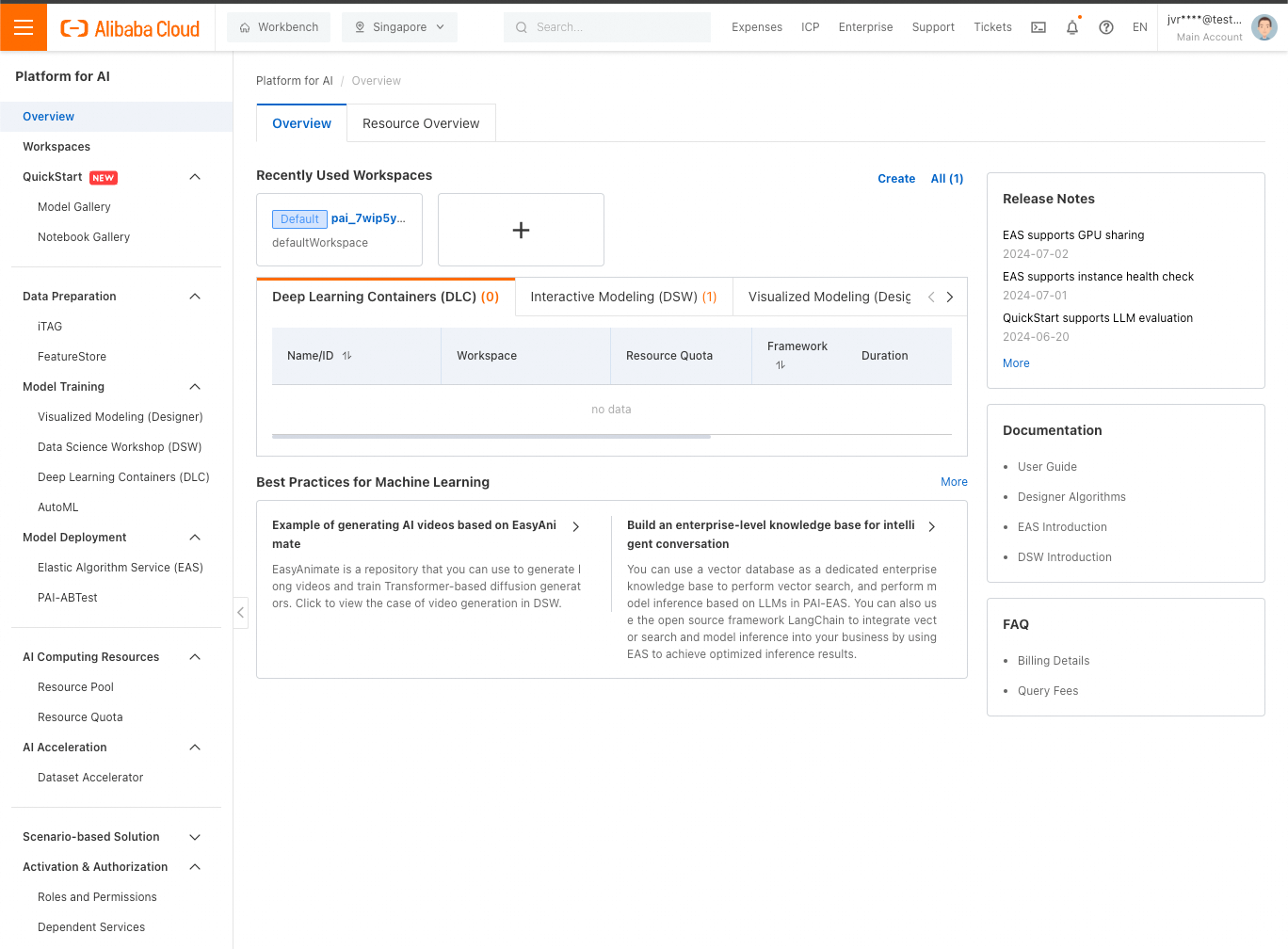

Alibaba Cloud 웹 콘솔에 로그인한 다음 PAI를 검색합니다. 표시되는 결과(Platform for AI)를 클릭하면 PAI 콘솔이 표시됩니다:

QuickStart(왼쪽 사이드 바 상단에 있음) 또는 EAS/Elastic Algorithm Service(왼쪽 사이드 바 가운데에 있음)에서 LLM을 빠르게 배포할 수 있습니다. 두 경우 모두 서비스가 EAS 인스턴스로 배포되므로 결국에는 어떤 경우에도 EAS를 사용하게 됩니다.

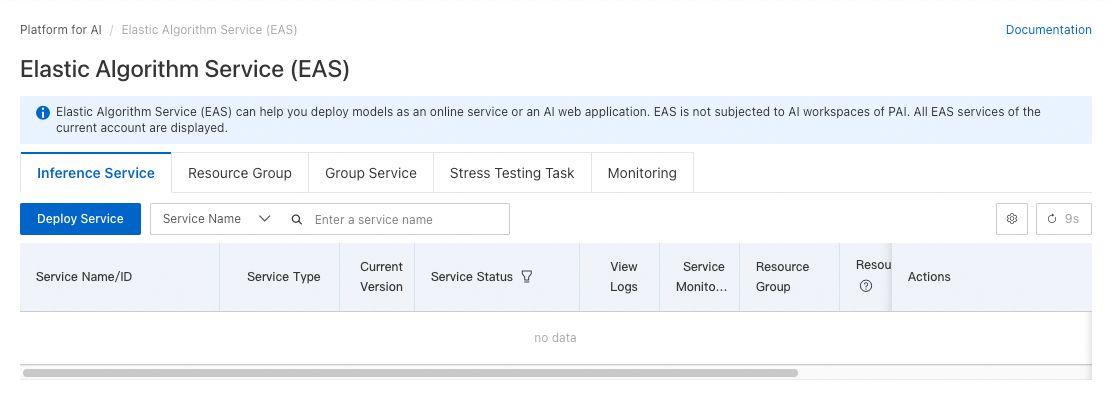

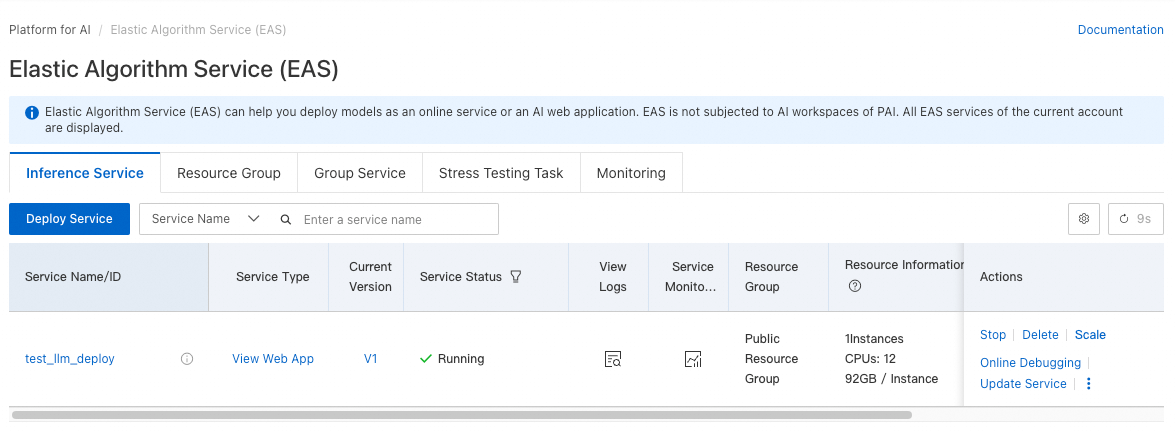

EAS로 바로 이동해 보겠습니다. Model Deployment에서 Elastic Algorithm Service를 클릭하면 다음과 같은 화면이 표시됩니다.

Deploy Service를 클릭합니다.

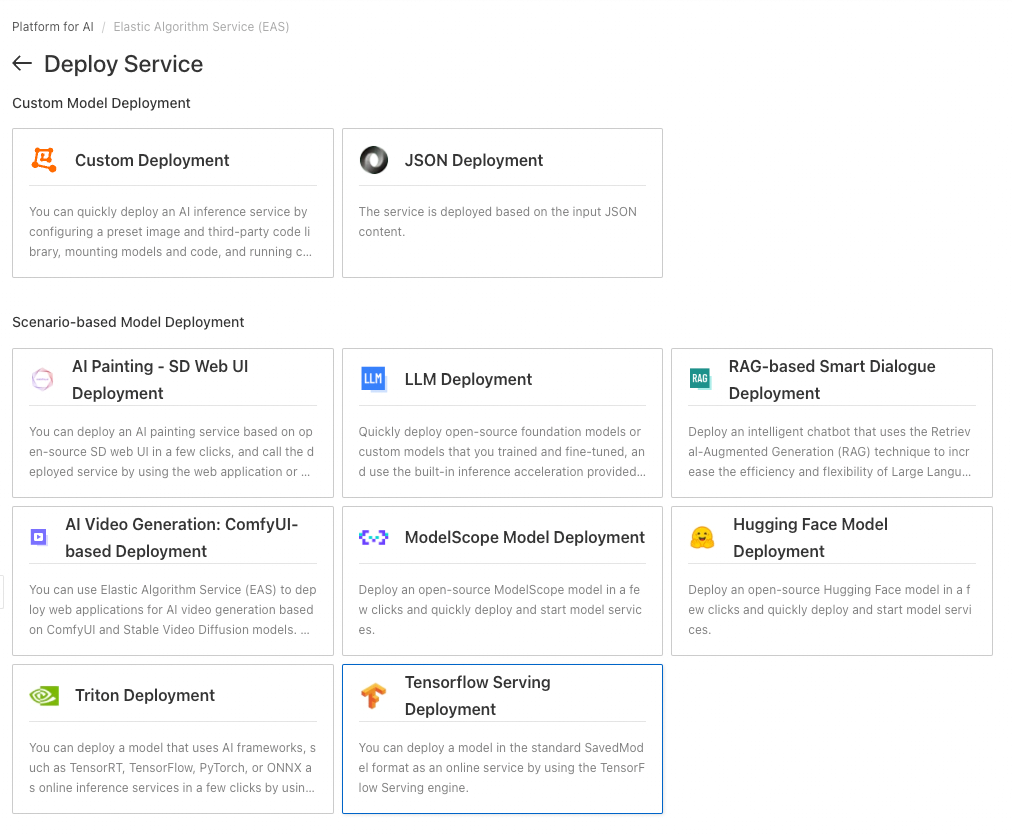

이 튜토리얼에서는 Scenario-based Model Deployment에서 LLM Deployment를 클릭합니다.

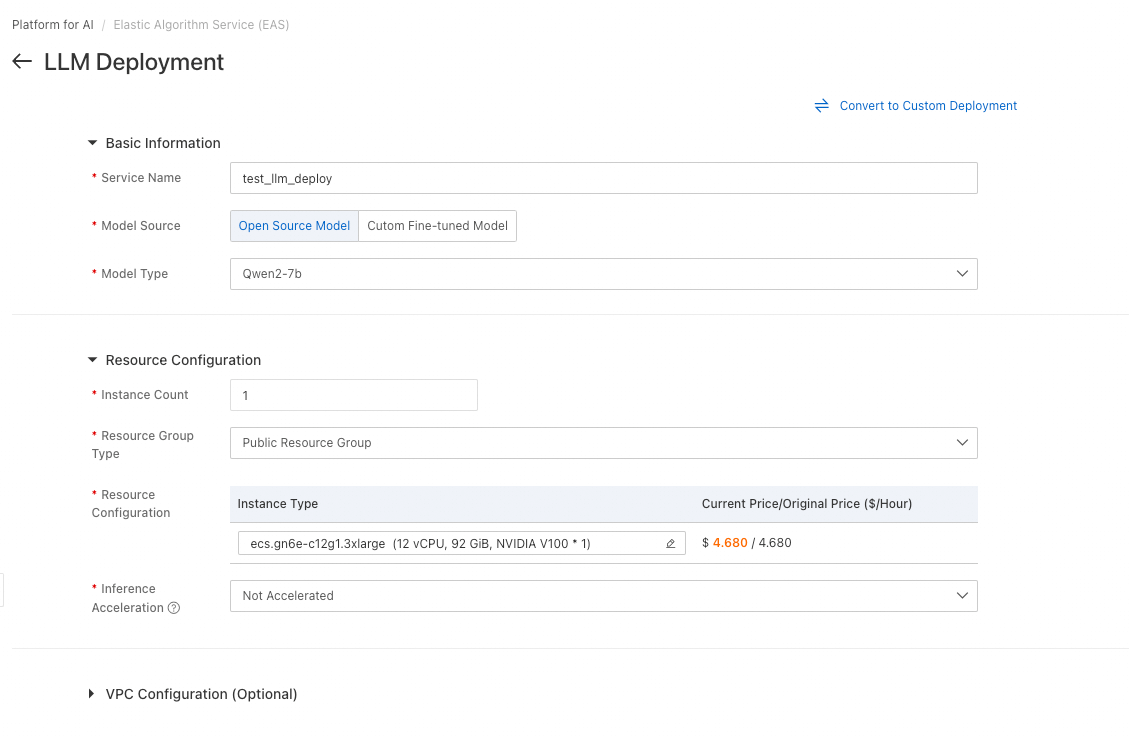

이 샘플 배포의 경우 위 스크린샷과 같은 설정을 따르면 됩니다.

• test_service_deployment와 같은 서비스 이름을 지정합니다.

• Open Source Model을 선택하고, Qwen2-7b와 같은 작은 모델을 선택합니다(참고: 실수로 거대한 72b 버전을 선택하지 않도록 주의하세요. 매우 다릅니다).

• 기본 인스턴스 유형은 유지하되 가속을 제거합니다(BladeLLM에는 다른 GPU 유형이 필요하지만 이 기본 튜토리얼에서는 중요하지 않습니다).

이것만 변경하면 됩니다. Deploy를 클릭합니다.

ECS 기반 IaaS genAI 배포와 달리, 인프라를 생성하는 데 필요한 작업은 이것뿐입니다! 몇 번의 클릭만으로 단 몇 분 만에 인프라가 모두 설정됩니다.

이것이 바로 genAI에 대한 서비스형 플랫폼 접근 방식의 강력함과 편리함입니다.

배포를 완료하는 데 몇 분 정도 걸리며, 배포 상태가 Running으로 변경되는 것을 확인할 수 있습니다.

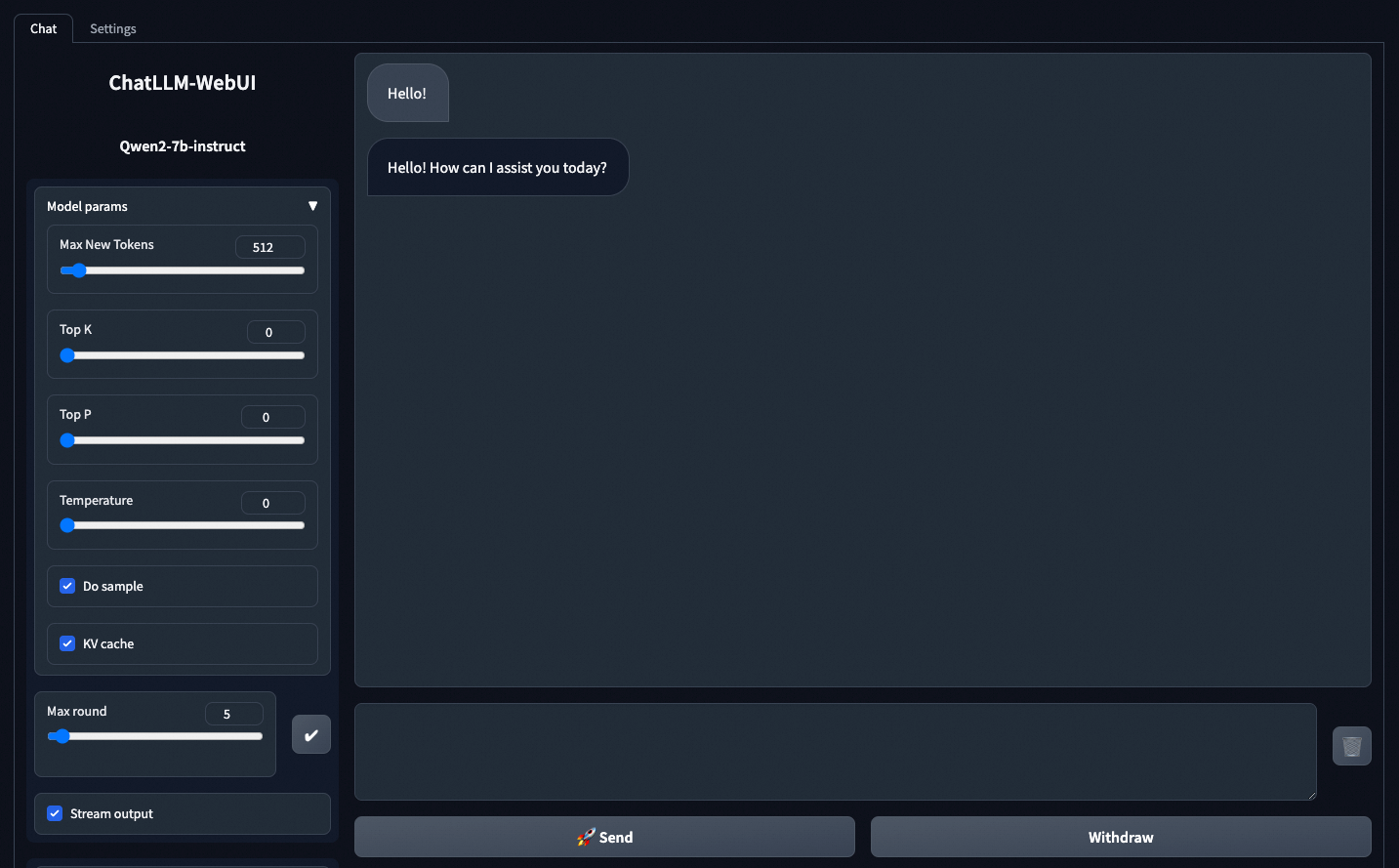

View Web App 링크가 있습니다. 이 링크를 클릭하면 서비스에 내장된 데모 채팅 애플리케이션에 액세스하여 쉽게 테스트할 수 있습니다.

처음 보내는 첫 번째 메시지는 LLM이 메모리에 로드되는 데 시간이 필요하기 때문에 시간이 조금 걸립니다. 그러나 초기 로드 후에는 다음 메시지를 매우 빠르게 전송할 수 있습니다.

물론 이 웹 앱이 우리의 주된 관심사는 아니며, 이는 단지 보너스일 뿐입니다. 이제 API를 사용하여 LLM 서비스를 애플리케이션에 통합해 보겠습니다!

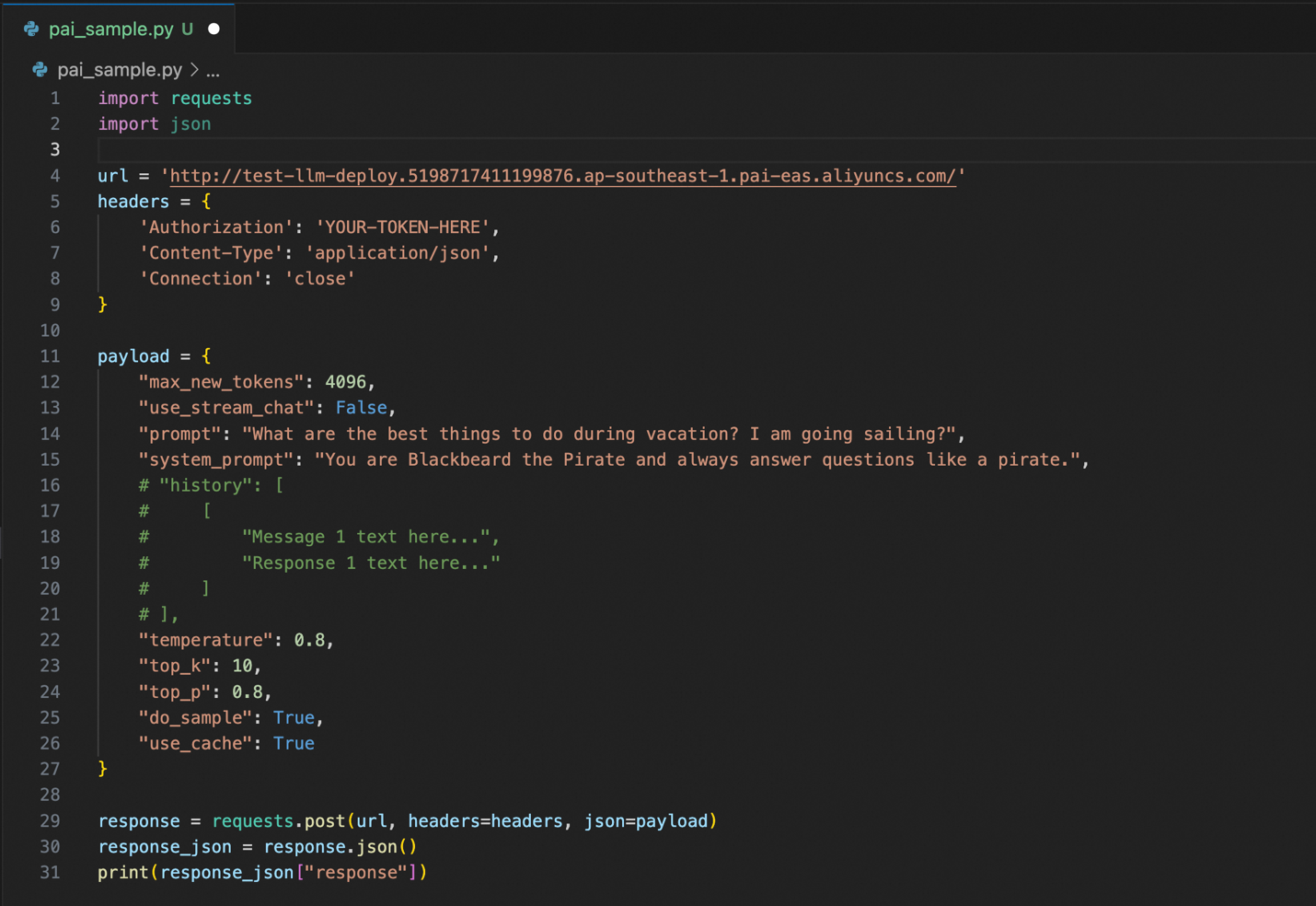

다음은 새로 배포된 LLM API 서비스를 사용하는 샘플 코드입니다.

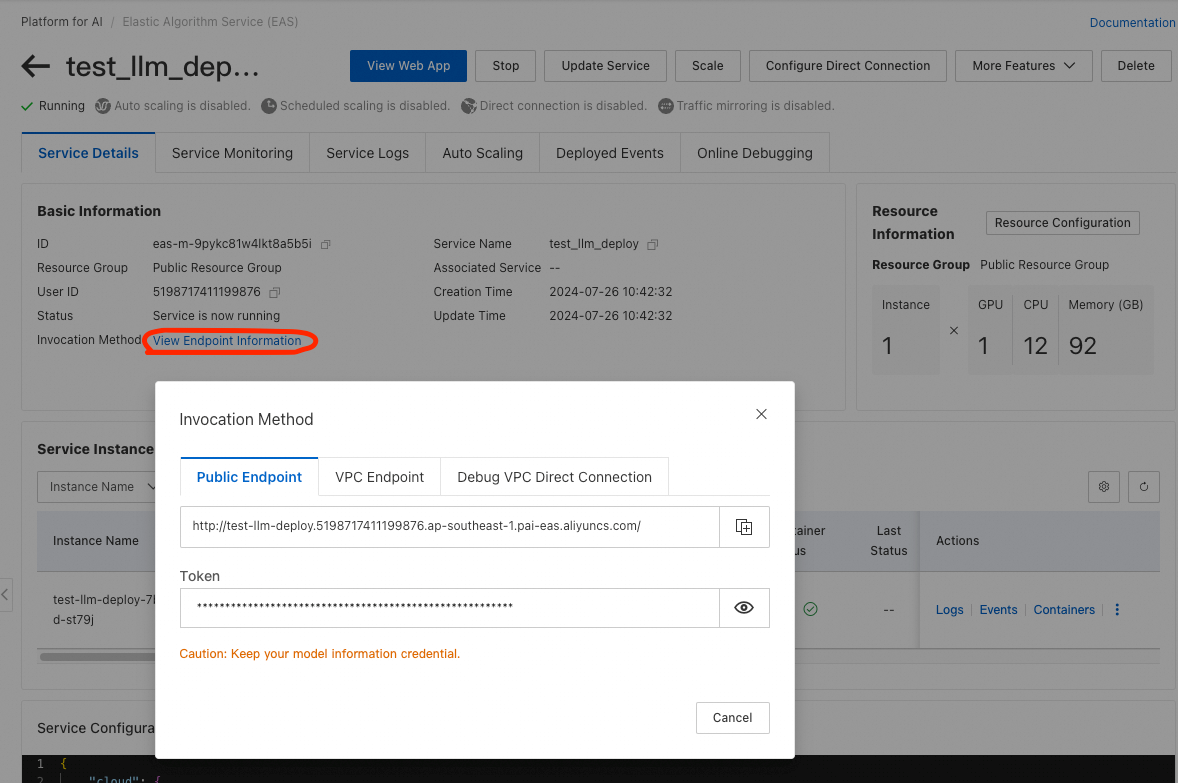

4줄과 6줄의 url 및 Authorization 파라미터를 PAI EAS의 실제 파라미터로 변경해야 합니다. PAI EAS 콘솔에서 배포한 서비스의 이름을 클릭한 다음 표시되는 Service Details 화면에서 View Endpoint Information를 클릭합니다. 엔드포인트 URL과 인증 토큰이 포함된 팝업이 나타납니다.

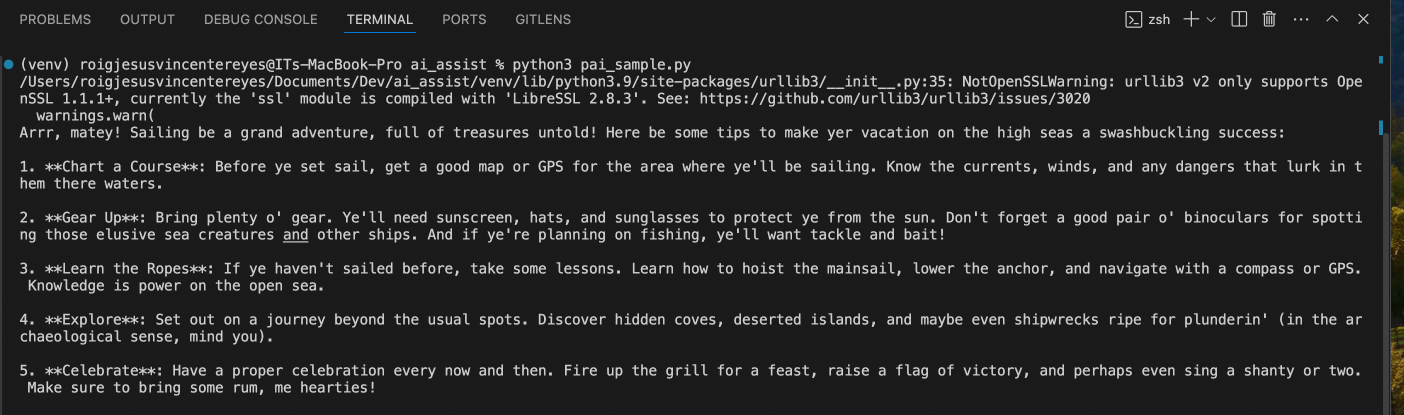

Python 코드로 돌아갑니다. 해당 Python 코드를 실행하면 다음과 같은 응답이 표시됩니다:

ECS 기반(IaaS) genAI 배포에서와 마찬가지로, LLM은 (시스템 프롬프트 때문에) 해적처럼 응답했고 (프롬프트 때문에) 항해 휴가를 위한 아이디어를 제공했습니다.

이 시리즈의 파트 1에서 소개한 이전 배포와 비교했을 때 ECS에 비해 모든 것이 몇 시간에서 몇 분으로 더 쉽고 빠르게 배포하고 사용할 수 있었습니다!

이제 이렇게 질문하실 수도 있습니다: JV, 더 빠른 방법이 있나요?

네, 있습니다!

다음 파트 3에서는 더 빠른 방법을 살펴보겠습니다.

그때 뵙겠습니다.

저자 소개: JV는 Alibaba Cloud PH의 선임 솔루션 아키텍트이며 팀의 데이터 및 생성형 AI 전략을 이끌고 있습니다. 이 글의 내용이 현재 비즈니스 문제와 관련이 있다고 생각되면 jv.roig@alibaba-inc.com로 JV에게 문의해 주세요.

본 기사의 원본은 영문으로 작성되었습니다. 원본 문서 여기 참조.

91 posts | 3 followers

FollowRegional Content Hub - September 9, 2024

Regional Content Hub - September 9, 2024

Regional Content Hub - April 15, 2024

Regional Content Hub - August 12, 2024

James Lee - December 24, 2024

James Lee - October 11, 2023

91 posts | 3 followers

Follow Platform For AI

Platform For AI

A platform that provides enterprise-level data modeling services based on machine learning algorithms to quickly meet your needs for data-driven operations.

Learn More Tongyi Qianwen (Qwen)

Tongyi Qianwen (Qwen)

Top-performance foundation models from Alibaba Cloud

Learn More AI Acceleration Solution

AI Acceleration Solution

Accelerate AI-driven business and AI model training and inference with Alibaba Cloud GPU technology

Learn More Alibaba Cloud for Generative AI

Alibaba Cloud for Generative AI

Accelerate innovation with generative AI to create new business success

Learn MoreMore Posts by Regional Content Hub