本記事の作成者:Jawad

このブログ記事では、ECS instance で Ollama と Open WebUI を使用して、Alibaba Cloud Open Source Qwen 0.5 モデルをセットアップして実行する方法について説明します。 完了すると、使いやすい Web インターフェースを通じて Qwen モデルの機能を使用できるようになります。 ビデオはこちらです。

今回の簡単なデモでは、ecs.g7.large (2 コア、8 GB RAM) を使用します。 ただし、ECS インスタンスを選択する際は、以下のような AI ワークロードの重要な要素を考慮してください。

• CPU/GPU:vCPU 数の多いインスタンスを探し、効率的なモデル計算のために GPU を使用します。

• メモリ:Qwen のようなモデルはメモリ集約的です。今回の例以上のものを使用してください。

• ストレージ:SSD を使用したストレージでは、モデルの読み込みに不可欠な読み書き速度が向上します。

• 帯域幅:Open-WebUI 経由でスムーズな対話をおこなうために十分な帯域幅を確保します。

以下の手順に従ってインスタンスを作成します。

SSH を使用して接続します。

ssh root@<作成したインスタンスのパブリック IP アドレス>Docker を更新してインストールします。

apt update

apt install docker.io

apt install docker-composenano または vi エディターを使用して docker-compose.yml ファイルを作成します。

version: '3.8'

services:

ollama:

image: ollama/ollama

container_name: ollama

volumes:

- ollama:/root/.ollama

ports:

- "11434:11434"

restart: always

open-webui:

image: ghcr.io/open-webui/open-webui:ollama

container_name: open-webui

volumes:

- ollama:/root/.ollama

- open-webui:/app/backend/data

ports:

- "3000:8080"

restart: always

volumes:

ollama:

open-webui:以下のコマンドを使用して、目的のディレクトリとサービスのdocker-compose.yml ファイルに上記の内容を保存します。

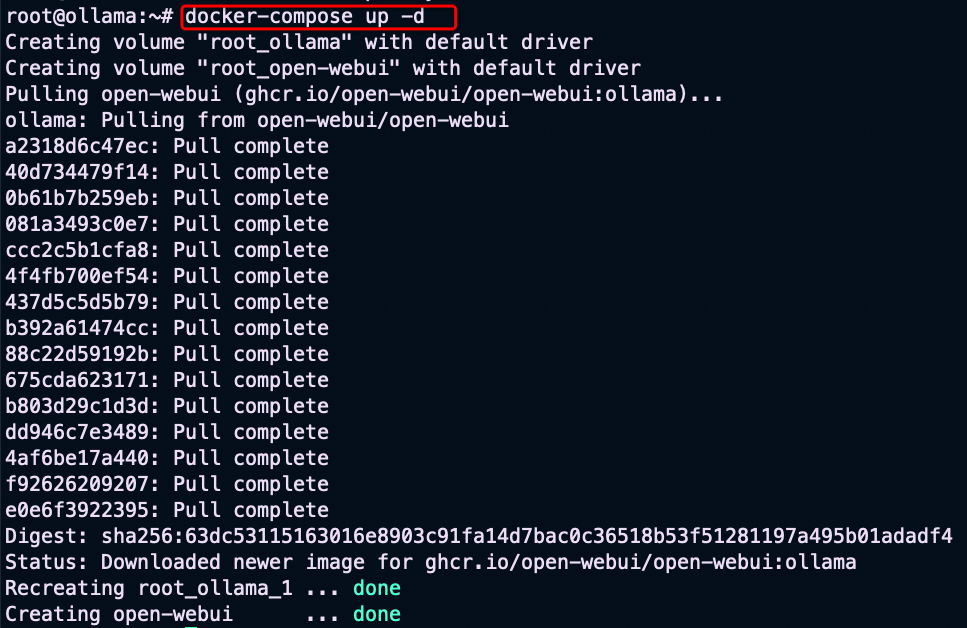

docker-compose up -d

Ollama コンテナー にアクセスして Qwen 0.5 モデルをプルするには、まず以下のように入力して Ollama コンテナーに入ります。

docker exec -it ollama /bin/bashコンテナー内で以下のコマンドを実行し、Qwen 0.5 モデルをプルします。

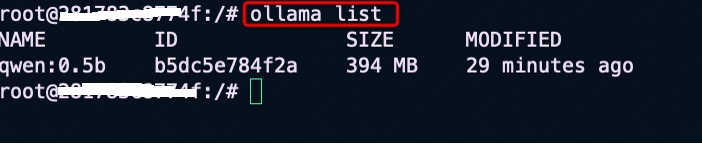

ollama pull qwen:0.5完了後、Qwen モデルが利用可能であることを確認し、ollama リストを使用します。

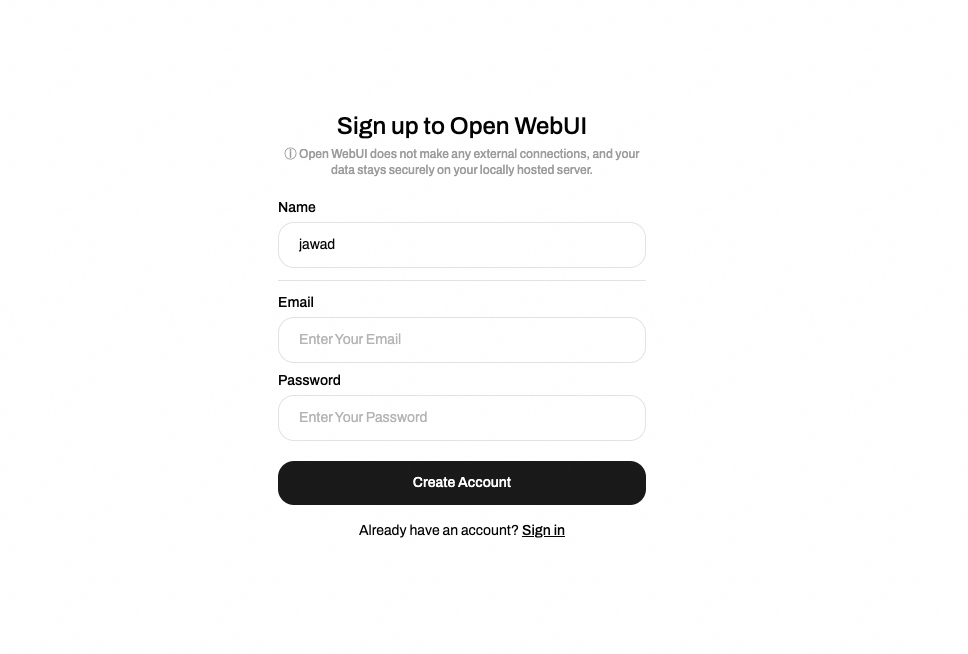

• ECSパブリックアクセス:パブリック IP とセキュリティグループルールが設定されている場合、誰でも http://<your-instance-public-ip>:3000 に移動して Open-WebUI にアクセスできます。 以下に示すように、名前、メール、パスワードを指定してサインアップします。

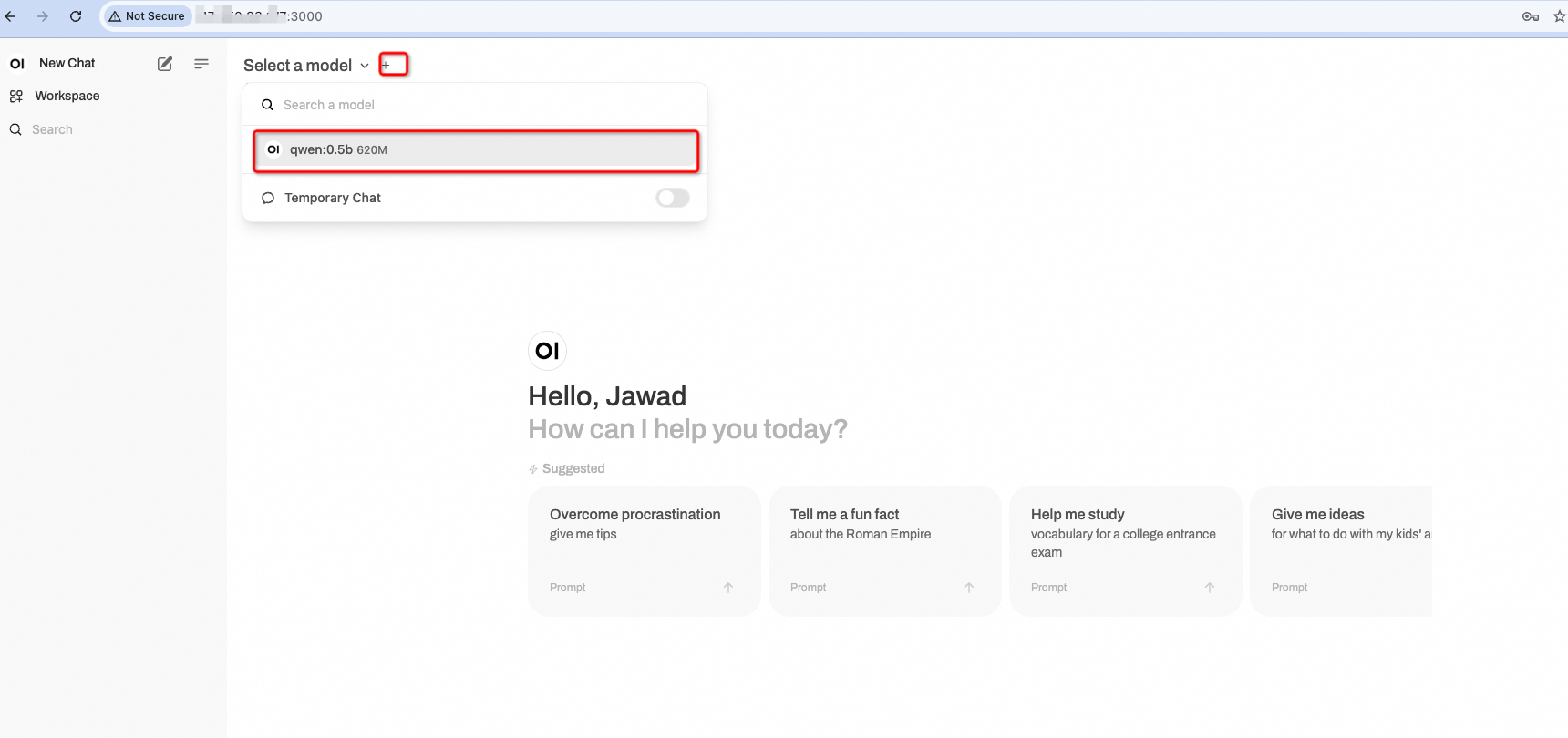

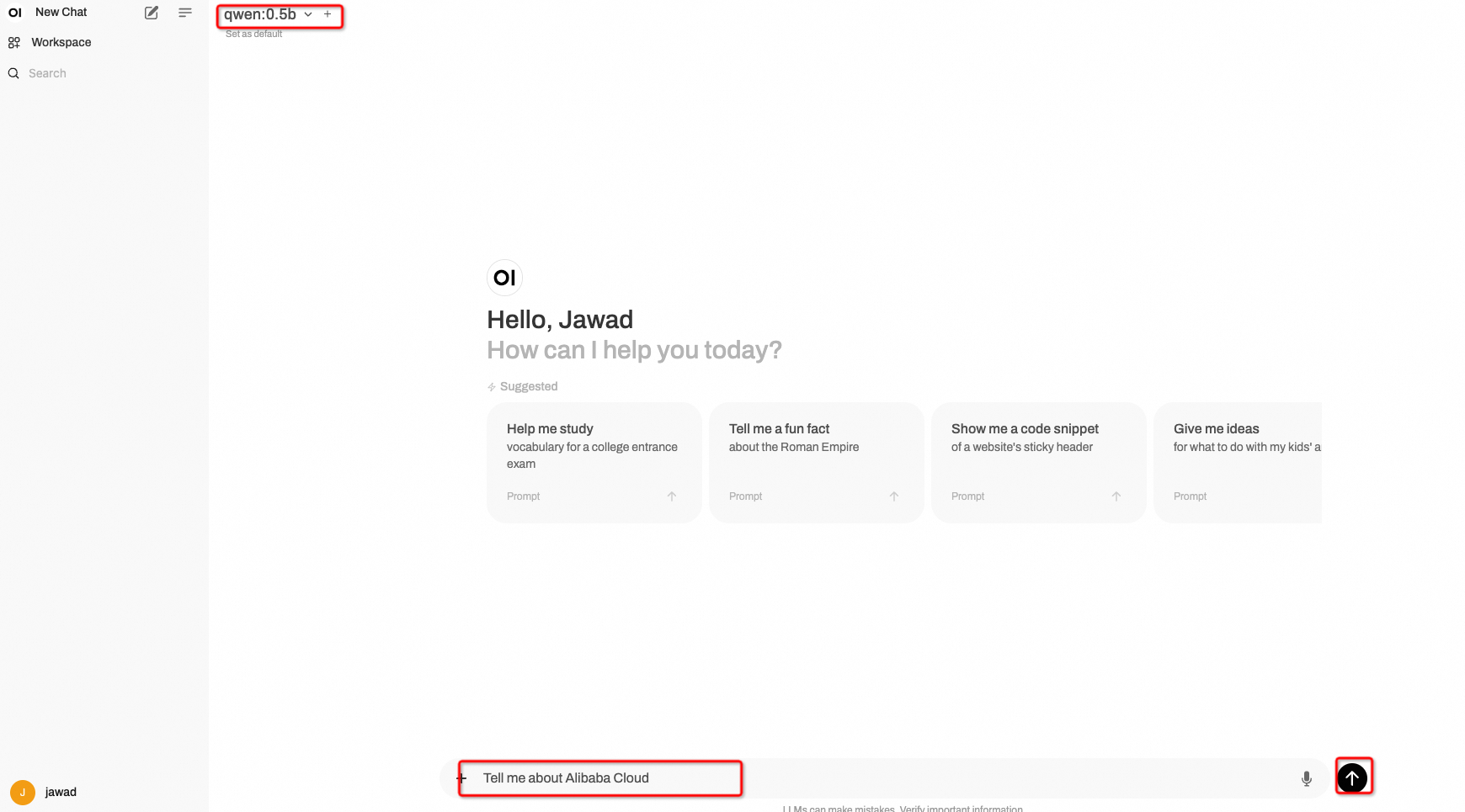

• モデルの使用:アカウントの作成後、Alibaba Cloud Qwen:0.5b モデルを操作します。

これで、モデルにさまざまなプロンプトを入力して応答を得ることができます。

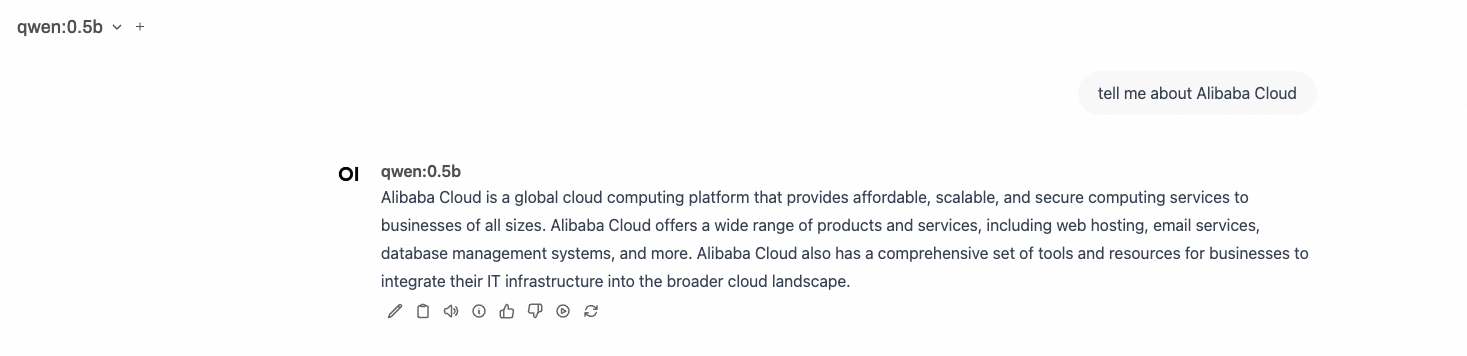

モデルは以下のような出力を返します。

Alibaba Cloud ECS インスタンスで Ollama と Open WebUI を正しくセットアップし、Qwen 0.5 モデルをプルし、Web インターフェースにアクセスして簡単に対話ができるようになりました。 このセットアップは、モデルのデプロイが簡単なだけでなく、直感的なインターフェースでユーザーエクスペリエンスも向上します。 Qwen モデルの実験とその機能の探索をお楽しみください!

最後に、より正確な応答が必要な場合は、https://ollama.com/library/qwen から入手できる、高いハードウェア仕様を必要とし、良好な応答が得られる Qwen 4b などの Alibaba Cloud LLM をより適切に使用してください。

ご質問や問題が発生した場合は、コメント欄からお知らせください。

この記事は英語から翻訳されています。元の記事 こちら をご参照ください。

Xây dựng ChatGPT riêng của bạn: Triển khai OLLAMA và Open-WebUI với Qwen trên Alibaba Cloud ECS

93 posts | 3 followers

FollowRegional Content Hub - August 5, 2024

Regional Content Hub - March 8, 2024

Regional Content Hub - March 8, 2024

Regional Content Hub - February 1, 2024

Regional Content Hub - August 28, 2024

Alibaba Cloud Japan - August 7, 2024

93 posts | 3 followers

Follow Tongyi Qianwen (Qwen)

Tongyi Qianwen (Qwen)

Top-performance foundation models from Alibaba Cloud

Learn More AI Acceleration Solution

AI Acceleration Solution

Accelerate AI-driven business and AI model training and inference with Alibaba Cloud GPU technology

Learn More Alibaba Cloud for Generative AI

Alibaba Cloud for Generative AI

Accelerate innovation with generative AI to create new business success

Learn More Platform For AI

Platform For AI

A platform that provides enterprise-level data modeling services based on machine learning algorithms to quickly meet your needs for data-driven operations.

Learn MoreMore Posts by Regional Content Hub