AIといえば、真っ先に思いつくのは「生成AI」だろう。有名なものでChatGPTやGemini、Claudeといった、LLM(大規模言語モデル)を活用したソリューションが挙げられるが、現在世界中で、非常に優れた性能のモデルが各社より次々に発表されている。

今回は数多くのLLMの中から、アリババクラウドのオープンソースLLM「Qwen(クウェン)」について、アリババクラウド・ジャパンサービス株式会社の藤川氏にインタビューを行った。4兆円超の予算でAI 系サービスの開発を行っているアリババグループのAI研究所「DAMOアカデミー」の紹介や、「Qwen」についてお話していただくのと同時に、実際に「Qwen」を用いて国産LLM「Karasu」「Qarasu」開発した株式会社Lightblue の谷口氏にもお越しいただき、「Qwen」の選定理由から独自LLM開発の苦労まで幅広く質問をぶつけた。

企業のAI導入、開発担当者は是非ご一読いただきたい。

→Alibaba Cloudの生成AIソリューション📝

アリババクラウド・ジャパンサービス株式会社

AI/Big Data ソリューションアーキテクト

藤川 裕一

大手通信会社入社後、経営コンサルティングファームを経て独立。Web/モバイルアプリ、AIに関する新規事業立ち上げや開発案件を多数経験。その後、スタートアップのCTOを経て、現在はアリババクラウドにて主にAI案件に参画している。

株式会社Lightblue

取締役|上級研究員

谷口 俊一氏

東京大学大学院工学系研究科修了。建設現場、インフラ等を主に手掛ける。Lightblueでは開発に従事。

──まず初めに、アリババグループが持つAI研究所の「DAMOアカデミー」について教えてください。

藤川

約7年前の2017年に アリババはDAMOアカデミーというテクノロジーの研究施設を設立しました。この研究所のミッションは、「科学技術の研究とイノベーションを通して未知なるものを探求すること」です。ミッションを実現するために、合計4兆8000億円という莫大な予算を費やし、世界トップクラスのAI研究者を集め、 中国だけでなくアメリカにも研究施設を構え、最先端のAI技術を研究しております。このようにして生み出された AI技術を実際にお客様にも提供しており、このDAMOアカデミーの発足以降、アリババクラウドのAIソリューションは大きく進化いたしました。設立当初は画像予測などのシンプルなAI技術でしたが、近年では、LLMと呼ばれる 生成系AIの開発に非常に力を入れています。

──実際にアリババクラウドで開発しているLLMにはどのようなものがありますか。

藤川

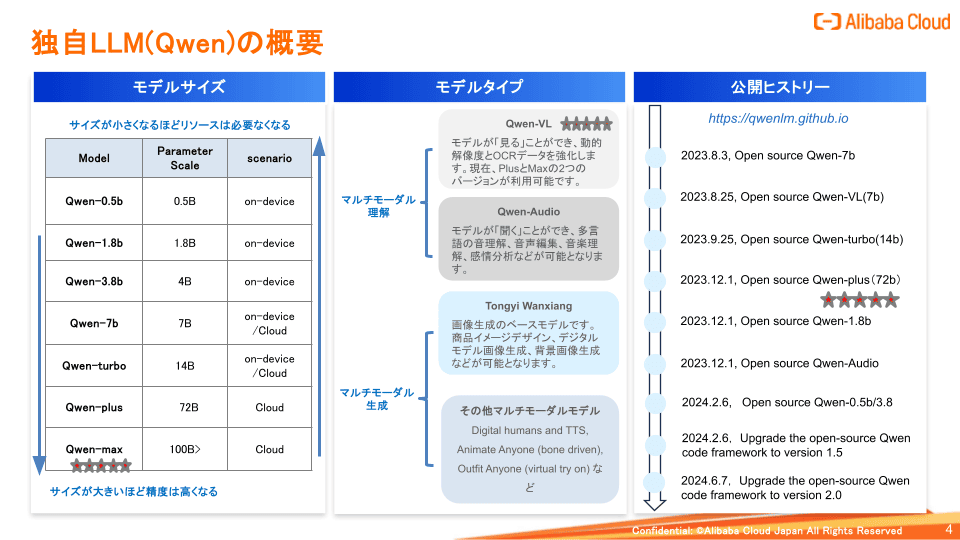

「Qwen(クウェン)」という名前のオープンソースLLMがあります。

このQwenは様々なモデルのサイズがありまして、 小さいものですと0.5b(約5億のパラメーター)で非常に軽量なもののため、AIなどでも利用いただけます。大きいものですと100b(約1,000億を超えるサイズ)となっており、現時点では110bでオープンソースとして公開しているのですが、世界規模で見てもトップクラスのサイズのモデルとなっております。

また、モデルタイプもテキストだけでなく、例えばマルチモーダルのものや、音声を入力できるもの、そして画像生成や動画を生成するモデルなど、様々なモデルを 提供しています。

Qwenは昨年公開したんですが頻繁にアップデートしておりまして、2024年6月7日にバージョン2.0を公開しました。こちらは多言語能力がアップしているのと、トークンサイズも伸びておりまして、非常に重要なアップデートとなっています。Hugging Faceから利用いただけますので、ぜひ1度お試しいただきたいです。

──ちょうど本日アップデートされたのですね。

藤川

そうですね。このインタビューの数時間前にアップデートされていたので、インタビューに合わせて情報を調査してきました(笑)

日々ブラッシュアップしているアリババクラウドのLLMですが、実際にアリババのビジネスでも幅広く利用されており、例えば、画像検索AIは、毎日数千万を超えるユーザーが30億を超える製品画像を検索しています。コールセンターAIでは、約70万人のカスタマーサービス担当者が行うタスク量を日々処理していますし、翻訳AIは214の言語をサポートしていて、毎日13億以上使用されています。

アリババクラウドは、生成系AIに対して莫大な資本と人材を投入して最先端のAI技術を研究するとともに、実際にアリババグループのサービス内で活用することで、実績のある信頼性の高いAIサービスを提供しています。

→Alibaba Cloudの生成AIソリューション📝

──ここからは実際にアリババクラウドの「Qwen」を使ってサービス開発を行った企業の方に、ユーザーインタビューを行いたいと思います。株式会社Lightblueの谷口様、よろしくお願いいたします。

谷口氏

よろしくお願いします。

──まず、貴社はどのような事業をされている会社なのでしょうか。

谷口氏

弊社は東大発のAIベンチャー企業で、生成AIおよび画像解析を事業領域としています。代表の園田が大学在学中に起業した会社で、技術顧問として鳥海先生という東大教授を迎えております。弊社は、「リアル空間にアルゴリズムを導入し、 デジタルの恩恵を全ての人へ」をミッションに掲げており、自然言語処理と画像解析技術を大衆化し、全ての現場にデジタルの利便性を届けることを目標としています。

弊社の課題解決のソリューションとしては、先ほど申し上げたように、生成AIと画像解析で、企業の知の最大活用を生成AIで実現し、安全管理を画像解析で実現することで、業務プロセスの改革の実現を目指しています。

生成AIソリューションは3つありまして、「Lightblue Assistant」と「生成AIの自作開発」、「独自LLM開発」です。まさにアリババさんのクラウドサービスを利用しながら研究開発を行っており、それをベースに個別の実装を行ったり、そこから得た知見を製品開発に活かすアプローチを行っています。

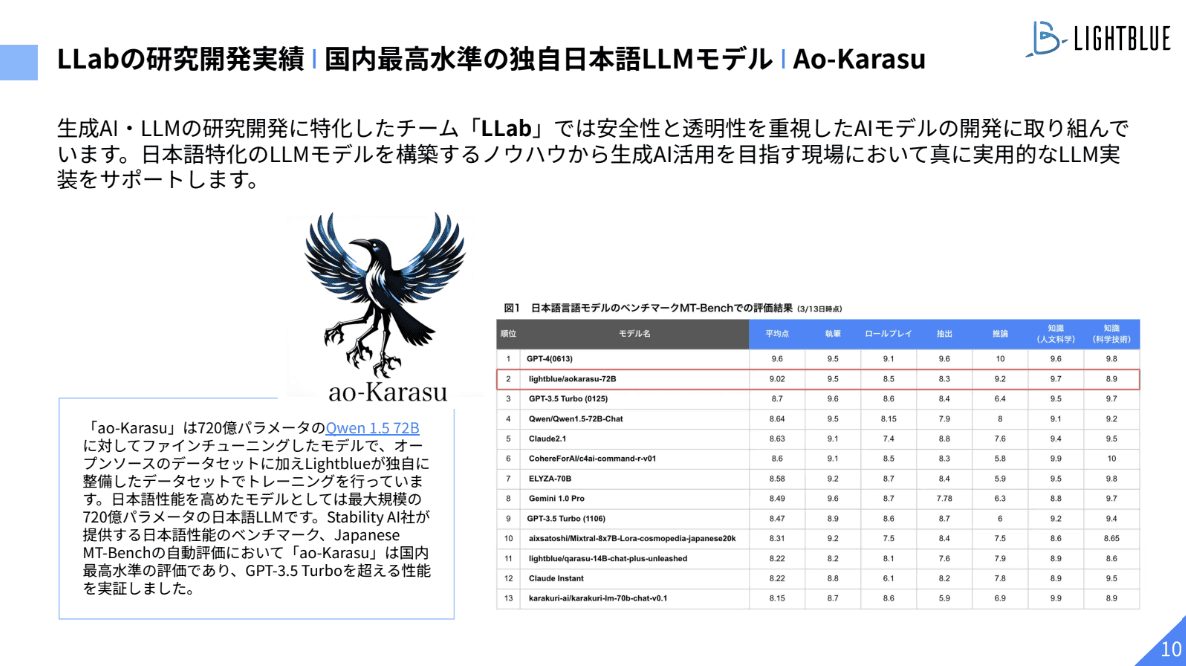

後に詳しく説明出来ればと思いますが、「ao-Karasu」という弊社の独自の言語モデルは、アリババクラウドの「Qwen」をベースに開発したLLMです。

──それでは実際に「ao-Karasu」についてお伺いできればと思いますが、どのようなサービスなのでしょうか。

谷口氏

「ao-Karasu」は、弊社が独自に構築した大規模な言語データセットを用いて、720億パラメータのQwen 1.5 72Bモデルをベースに学習したLLMです。

データセットは、RAGを想定したような質問応答のデータセットや、特定のカテゴリーで質問と回答を生成し、まとめたデータ、また、チェーン・オブ・ソート(CoT)と呼ばれる、論理的に考えるようなスタイルのデータセットなどを独自で用意しました。

──国産LLMが増えてきていると思いますが、その中で「ao-Karasu」はどのような特徴を持つのですか。

谷口氏

まず「ao-Karasu」の開発背景をお話できればと思います。園田はもともと大学で自然言語を専攻していたのですが、在学中にChatGPTがリリースされ、そこから爆発的に生成AIが盛り上がりました。生成AIが盛り上がる一方で、なかなか国産のモデルはないというところに着目して、「では何ができるか?」というところからアプローチを開始したのが、スタートです。

弊社のLLM「Karasu」「Qarasu」の特徴としては、エンジニアが手を動かして、日々どういったデータセットがよいかを議論しながらブラッシュアップしているところで、特に日本語に強い点が特徴です。

お客様の都合上、セキュリティ的に外部のAPIに出すことができないデータなどがある中で、オンプレで完結させられるというニーズも捉えて開発を行っております。

──LLMの基盤モデルは世界的にも数多くあると思いますが、その中でアリババクラウドを利用しようと思ったきっかけを教えてください。

谷口氏

「Karasu」「Qarasu」は昨年の12月ごろに公開したのですが、9月か10月あたりからデータセットの構築を開始し、また、何をベースに開発するのが良いかの議論を社内で行いました。当然、その当時で一番良いモデルを使いたいという要望はあって、当時だとLlama2やMistral Largeが方法としてはあったかと思いますが、言語対応において、英語では良い勝負の一方、日本語対応できる点ではQwenが公開されていたものでトップだと判断したんです。日本語が喋れるモデルをベースにファインチューニングすると精度が全然違う、という点でQwenを選定しました。

──日本語の精度で判断したのですね。実際に開発でQwenを使用していかがでしたか。

谷口氏

軽量版から大きなものまでモデルサイズが複数出されているので、かなり便利だと感じました。スコアを追い求めると72bのモデルで開発する方が当然精度はよくなりますが、一方で7b程度のモデルサイズの方が取り回しが良いので、アウトプットの速度なども含めて、同じモデルで複数のパラメーターサイズが用意されていることは、使い勝手の良い部分だと感じていました。

Qwenを利用して「ao-Karasu」を開発し、その後アリババクラウドさんのサポート担当とも何度かやり取りをしまして、まだ開始はしていないですが、クラウドGPUリソースのサポートをしていただくような話も進めています。弊社の独自LLMでも新しいモデルをどんどん出していこうと動く中で、このようにリソースの支援をしていただけるというのは、大変魅力に感じています。

QwenはHugging Faceで公開されていると藤川さんも仰っていましたが、しっかりと学習ができる状態で公開されていて、特に障害などなく開発できた記憶があります。

──これから開発を始める、新規の方も利用しやすそうですね。

谷口氏

そうですね。最初に試すにはかなりいいんじゃないかなと思います。

──開発過程で困難だったことはありますか。

谷口氏

特徴でもある、データセットを作成する部分はどうしても試行錯誤が必要でした。「どういうデータセットでどういう精度になったか」という情報は出てはいるのですが、基本的に英語ベースの情報なので、日本語でできるのか?という点を調査したり、論文をもとにテストを行いましたが、意外と精度がよくなかったりしました。数万件データを作成して、軽く学習をしてみて、良いデータセットは何だろう?ということを探るのは、工数としては一番時間を割いた部分です。

また、1回学習するのにも時間とコストがかかるので、並列で再現したりするのは非常に大変です。学習に何十時間もかかる中で、GPUのリソースなど、インスタンスを予約して確保しておかないと使えない状況だったので、そのあたりのリソース管理も大変でした。

──どのような順序やスピードで開発を進めたのですか。

谷口氏

まず、オープンソースのモデルを何個かリストアップし、ファインチューニングする前の段階で試験的に動かしてみて、どのような出力が出るかを見ました。また、ライセンスがどうなっているかなどの情報をリストアップする作業を行いながら選定しました。

オープンソースモデルの選定と「ao-Karasu」開発着手からリリースまで、2~3ヵ月程度のスピードで開発を行いました。

──今後の展開についてはいかがですか。

谷口氏

1番理想としているのは、弊社が作っているSaaSのサービス「Lightblue Assistant」、いわゆるRAGを使ったサービスを、ChatGPTやClaudeののAPIを使っている部分をリプレイスできるまで精度を上げることです。一方で、ローカル環境でしか動かせないようなお客様向けにカスタマイズした、ローカル環境で使いやすいLLMモデルの構築も考えています。

→株式会社Ligtblueの事例をもっと詳しく📝

──ちなみに、貴社の中で生成AIに関して話題になっていることや、トピックなどありますか。

谷口氏

ビジネス用途ですと、RAGが話題に挙がりやすいという印象です。そのため弊社でも、RAGの精度を上げるためにどうするのか、という点は日々社内で議論しています。特に今年に入ってからRAGを活用したいというご相談がとても増えましたし、AI関連のイベントを見てみても、RAGに対する注目度が上がっていると思います。

RAGについては、論文で言うと2020年ごろから出ているはずですが、最近メディアでも多く取り上げられたり、当たり前に耳にするようになりましたね。生成AIで何ができるのか、という話になった際には、RAGが一番イメージしやすく、現実的な活用方法なのだと思います。

その他には、本日Qwenのバージョンアップがあったように、新しいモデルがアップされるとすぐに試して、出力精度について話したりします。Qwenも日本語の精度が上がっている印象を受けました。

──AIを導入した一方、活用が進んでいない企業に向けたアドバイスなどはありますか。

谷口氏

弊社のお客様でも多い印象ですね。ChatGPTはただ導入しても結局使われないこともあると思います。エンジニアの場合、「困ったらGPTに聞けばよい」というような感覚を持っている人は多いと思いますが、ビジネスサイドの通常業務では活用が難しいのではないでしょうか。その中で、RAGを使ったソリューションは現実的にイメージがしやすく、メリットを感じてもらいやすいと思います。

RAGを使う中、弊社としては利用するデータの準備からお客様のサポートをしていきたいと考えています。「RAGを使ってなんとなく正しそうな回答は出るけど、本当にこれでよいのか?」といった現象は往々にして起こるので、どのぐらいのデータ数を用意すれば精度が出せるかなど、そういったところもお伝えしながら、サポート出来ればと考えています。

左からレッジ小瀧氏(インタビュアー)、Lightblue 谷口氏、アリババクラウド藤川

1 posts | 0 followers

FollowRegional Content Hub - July 8, 2024

Alibaba Cloud Native Community - February 26, 2025

Regional Content Hub - March 8, 2024

Regional Content Hub - February 26, 2024

Regional Content Hub - March 8, 2024

Alibaba Cloud Japan Compliance - October 15, 2023

1 posts | 0 followers

Follow AI Acceleration Solution

AI Acceleration Solution

Accelerate AI-driven business and AI model training and inference with Alibaba Cloud GPU technology

Learn More Tongyi Qianwen (Qwen)

Tongyi Qianwen (Qwen)

Top-performance foundation models from Alibaba Cloud

Learn More Offline Visual Intelligence Software Packages

Offline Visual Intelligence Software Packages

Offline SDKs for visual production, such as image segmentation, video segmentation, and character recognition, based on deep learning technologies developed by Alibaba Cloud.

Learn More Network Intelligence Service

Network Intelligence Service

Self-service network O&M service that features network status visualization and intelligent diagnostics capabilities

Learn MoreStart building with 50+ products and up to 12 months usage for Elastic Compute Service

Get Started for Free Get Started for Free