本文介绍如何使用数据传输服务DTS(Data Transmission Service),依次将本地MongoDB分片集群数据库中的各个Shard节点,迁移至阿里云MongoDB分片集群实例来实现迁移上云。通过DTS的增量迁移功能,可以实现在本地应用不停服的情况下,平滑完成数据库的迁移上云。

更多数据迁移和同步场景的解决方案,请参见MongoDB数据迁移和同步方案概览。

前提条件

自建MongoDB和云数据库MongoDB支持的版本,请参见迁移方案概览。

确保目标分片集群实例中的Shard节点具备充足的存储空间。

说明例如自建数据库中有三个Shard节点,其中第二个Shard节点占用的存储空间最多(500GB),那么分片集群实例中的每个Shard节点的存储空间均需要大于500GB。

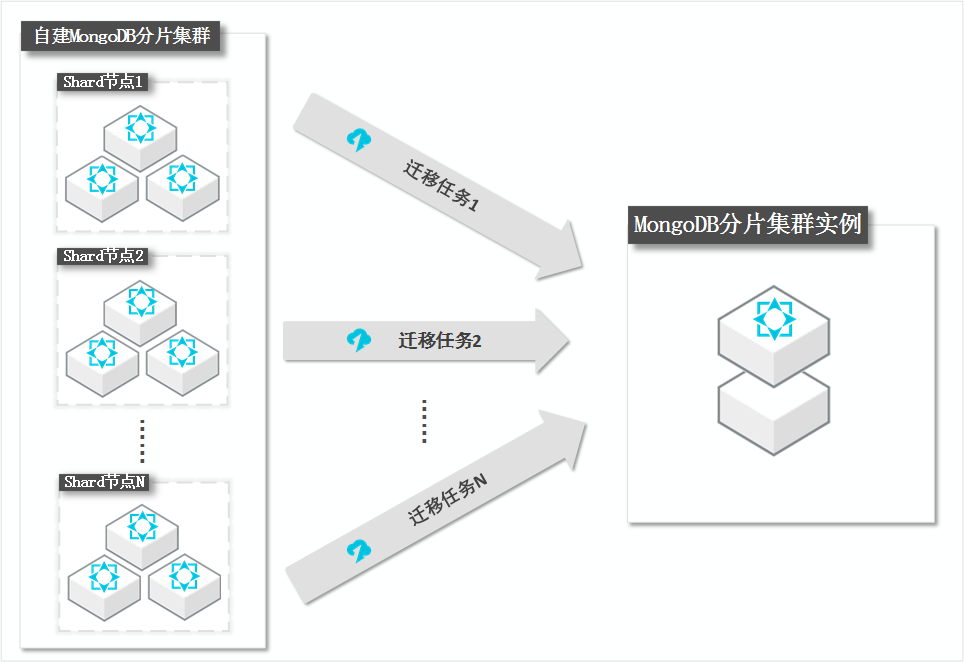

迁移原理介绍

DTS通过迁移分片集群中的每个Shard节点来实现分片集群数据库的整体迁移,您需要为每个Shard节点创建一个对应的数据迁移任务。

数据在目标MongoDB实例中的分布取决于您设置的片键,详情请参见设置数据分片以充分利用Shard性能。

注意事项

DTS在执行全量数据迁移时将占用源库和目标库一定的资源,可能会导致数据库服务器负载上升。如果数据库业务量较大或服务器规格较低,可能会加重数据库压力,甚至导致数据库服务不可用。建议您在执行数据迁移前谨慎评估,在业务低峰期执行数据迁移。

MongoDB实例支持的版本与存储引擎请参见版本及存储引擎,如需跨版本或跨引擎迁移,请提前确认兼容性。

由于DTS写入数据的逻辑为并发写入,所以会导致目标端占用的存储空间比源端大5%~10%。

请确保目标端MongoDB没有与源端相同的主键(默认为_id),否则会导致数据丢失。若目标端有与源端相同的主键,请在不影响业务的前提条件下清空目标端的相关数据(删掉目标端中与源端相同_id的文档)。

不支持数据库admin和local作为源和目标库。

源MongoDB分片集群实例的Mongos节点的数量不能超过10个。

费用说明

迁移类型 | 链路配置费用 | 公网流量费用 |

全量数据迁移 | 不收费。 | 通过公网将数据迁移出阿里云时将收费,详情请参见DTS产品定价。 |

增量数据迁移 | 收费,详情请参见。DTS产品定价 |

迁移类型说明

全量数据迁移:将源MongoDB数据库迁移对象的存量数据全部迁移到目标MongoDB数据库中。

说明支持database、collection、index的迁移。

增量数据迁移:在全量迁移的基础上,将源MongoDB数据库的增量更新数据同步到目标MongoDB数据库中。

说明支持database、collection、index的新建和删除操作的同步。

支持document的新增、删除和更新操作的同步。

数据库账号的权限要求

数据库 | 全量数据迁移 | 增量数据迁移 |

自建MongoDB数据库 | 待迁移库的read权限 | 待迁移库、admin库和local库的read权限 |

阿里云MongoDB数据库 | 目标库的readWrite权限 | 目标库的readWrite权限 |

数据库账号创建及授权方法:

自建MongoDB数据库请参见MongoDB Create User说明。

阿里云MongoDB实例请参见使用DMS管理MongoDB数据库用户。

准备工作

必需:为避免块迁移对数据一致性的影响,迁移期间需要关闭自建MongoDB数据库的均衡器(Balancer),详情请参见管理MongoDB均衡器Balancer 。

警告如果未关闭均衡器,迁移期间发生了块迁移将影响DTS读取到的数据的一致性。

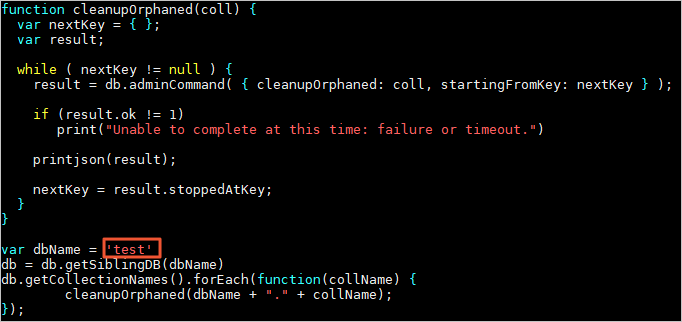

清除自建MongoDB数据库中,因块迁移失败而产生的孤立文档。

说明如果未清除孤立文档,将影响迁移性能,而且可能在迁移过程会遇到

_id冲突的文档,导致迁移错误的数据。下载cleanupOrphaned.js脚本文件。

wget "https://docs-aliyun.cn-hangzhou.oss.aliyun-inc.com/assets/attach/120562/cn_zh/1564451237979/cleanupOrphaned.js"修改cleanupOrphaned.js脚本文件,将

test替换为待清理孤立文档的数据库名。说明如果您有多个数据库,您需要重复执行本步骤和步骤c。

执行如下命令,清理Shard节点中指定数据库下所有集合的孤立文档。

说明您需要重复执行本步骤,为每个Shard节点清理孤立文档。

mongo --host <Shardhost> --port <Primaryport> --authenticationDatabase <database> -u <username> -p <password> cleanupOrphaned.js说明<Shardhost>:Shard节点的IP地址。

<Primaryport>:Shard节点中的Primary节点的服务端口。

<database>:鉴权数据库名,即数据库账号所属的数据库。

<username>:登录数据库的账号。

<password>:登录数据库的密码。

示例:

本案例的自建MongoDB数据库有三个Shard节点,所以需要分别为这三个节点清除孤立文档。

mongo --host 172.16.1.10 --port 27018 --authenticationDatabase admin -u dtstest -p 'Test123456' cleanupOrphaned.jsmongo --host 172.16.1.11 --port 27021 --authenticationDatabase admin -u dtstest -p 'Test123456' cleanupOrphaned.jsmongo --host 172.16.1.12 --port 27024 --authenticationDatabase admin -u dtstest -p 'Test123456' cleanupOrphaned.js

根据业务需要,在目标MongoDB实例中创建需要分片的数据库和集合,并配置数据分片,详情请参见设置数据分片以充分利用Shard性能。

说明在配置数据迁移前配置数据分片,可避免数据被迁移至同一Shard中,导致单个Shard使用的存储空间超出预期规划。

操作步骤

进入目标地域的迁移任务列表页面(二选一)。

通过DTS控制台进入

登录数据传输服务DTS控制台。

在左侧导航栏,单击数据迁移。

在页面左上角,选择迁移实例所属地域。

通过DMS控制台进入

说明实际操作可能会因DMS的模式和布局不同,而有所差异。更多信息。请参见极简模式控制台和自定义DMS界面布局与样式。

登录DMS数据管理服务。

在顶部菜单栏中,选择。

在迁移任务右侧,选择迁移实例所属地域。

单击创建任务,进入任务配置页面。

配置源库及目标库信息。

警告选择源和目标实例后,建议您仔细阅读页面上方显示的使用限制,否则可能会导致任务失败或数据不一致。

类别

配置

说明

无

任务名称

DTS会自动生成一个任务名称,建议配置具有业务意义的名称(无唯一性要求),便于后续识别。

源库信息

选择已有连接信息

若您需要使用已录入系统(新建或保存)的数据库实例,请在下拉列表中选择所需的数据库实例,下方的数据库信息将自动进行配置。

说明DMS控制台的配置项为选择DMS数据库实例。

若您未将数据库实例录入到系统,或无需使用已录入系统的数据库实例,则需要手动配置下方的数据库信息。

数据库类型

选择MongoDB。

接入方式

请根据源库的部署位置进行选择,本示例以公网IP为例介绍配置流程。

说明当选择其他方式接入自建数据库时,您还需要执行相应的准备工作。

实例地区

选择自建MongoDB数据库所属地域。

说明若选项中没有自建MongoDB数据库所属的地域,您可以选择一个距离该数据库最近的地域。

架构类型

选择分片集群架构。

说明仅当以专线/VPN网关/智能网关、公网IP或云企业网CEN的方式接入自建MongoDB时,才会出现分片集群架构选项。

迁移方式

请根据实际情况,选择增量数据迁移的方式。

Oplog(推荐):

若源库已开启Oplog日志,则支持此选项。

说明本地自建MongoDB和云数据库MongoDB版默认已开启Oplog日志,且使用此方式迁移增量数据时增量迁移任务的延迟较小(拉取日志的速度较快),因此推荐选择Oplog。

ChangeStream:若源库已开启变更流(Change Streams),则支持此选项。

说明源库为Amazon DocumentDB(非弹性集群)时,仅支持选择ChangeStream。

源库架构类型选择为分片集群架构,无需填写Shard账号和Shard密码。

连接地址类型

请根据实际情况选择单节点或多节点。

说明仅当以专线/VPN网关/智能网关、公网IP或云企业网CEN的方式接入自建MongoDB时,才会出现此配置项。

Mongos域名或IP地址

填入自建MongoDB数据库中,单个Mongos节点的域名或IP地址,本案例填入公网IP地址。

说明仅当连接地址类型为单节点时,才会出现此配置项。

Mongos域名或IP地址和端口填入任一组Mongos节点的IP地址(或域名)和端口。

端口

填入自建MongoDB数据库的服务端口。

说明仅当连接地址类型为单节点时,才会出现此配置项。

各Mongos节点的服务端口须开放至公网。

Mongos连接地址

填入自建MongoDB数据库的连接地址。

说明仅当连接地址类型为多节点时,才会出现此配置项。

格式为

<IP>:<Port>。其中<IP>为域名或者IP地址,建议使用公网可解析的域名。多个连接地址可以使用回车键换行进行分隔。

鉴权数据库名称

填入自建MongoDB中数据库账号所属的数据库名称,若未修改过则默认为admin。

数据库账号

填入自建MongoDB对应Mongos节点的账号。权限要求,请参见数据库账号的权限要求。

说明若自建MongoDB的接入方式为ECS自建数据库或数据库网关DG,则填入Shard节点的账号。

数据库密码

填入该数据库账号对应的密码。

多Shard节点接入信息

配置自建MongoDB数据库的Shard节点接入信息。

说明当自建MongoDB数据库为源库、架构类型选择为分片集群架构、迁移方式选择为Oplog,且连接地址类型选择为多节点时,才会出现此配置项。

单击多Shard节点接入信息右侧的添加按钮。

在Shard连接地址文本框中,填入自建MongoDB数据库某个Shard节点的连接地址。

说明当架构类型选择为副本集架构时,需配置的参数为连接地址;当架构类型选择为分片集群架构,需配置的参数为Mongos连接地址。

格式为

<IP>:<Port>。其中<IP>为域名或者IP地址,建议使用公网可解析的域名。多个连接地址可以使用回车键换行进行分隔。

重复上述操作,配置每个Shard节点接入信息。

Shard接入信息(IP:Port)

填入自建MongoDB数据库Shard节点的IP地址和端口信息,格式为

<IP>:<Port>。说明仅当连接地址类型为单节点时,才会出现此配置项。

多个Shard节点信息可以使用逗号(,)进行分隔。

Shard账号

填入自建MongoDB数据库的Shard账号。

Shard密码

填入自建MongoDB数据库Shard账号的密码。

连接方式

DTS支持非加密连接、SSL安全连接和Mongo Atlas SSL三种连接方式。连接方式的选项与接入方式和架构类型有关,请以控制台为准。

说明架构类型为分片集群架构,且迁移方式为Oplog的MongoDB数据库,不支持SSL安全连接。

若源库为自建(接入方式不为云实例)副本集架构的MongoDB数据库,并且选择了SSL安全连接,DTS还支持上传CA证书对连接进行校验。

目标库信息

选择已有连接信息

若您需要使用已录入系统(新建或保存)的数据库实例,请在下拉列表中选择所需的数据库实例,下方的数据库信息将自动进行配置。

说明DMS控制台的配置项为选择DMS数据库实例。

若您未将数据库实例录入到系统,或无需使用已录入系统的数据库实例,则需要手动配置下方的数据库信息。

数据库类型

选择MongoDB。

接入方式

选择云实例。

实例地区

选择目标云数据库MongoDB版实例所属地域。

是否跨阿里云账号

本示例使用当前阿里云账号下的数据库实例,需选择不跨账号。

架构类型

选择目标云数据库MongoDB版所属的架构类型。

实例ID

选择目标云数据库MongoDB版实例的ID。

鉴权数据库名称

填入目标云数据库MongoDB版实例数据库账号所属的数据库名称,若未修改过则默认为admin。

数据库名称

填入目标云数据库MongoDB版实例中迁移对象所属数据库的名称。

数据库账号

填入目标云数据库MongoDB版实例的数据库账号。权限要求,请参见数据库账号的权限要求。

数据库密码

填入该数据库账号对应的密码。

连接方式

DTS支持非加密连接、SSL安全连接和Mongo Atlas SSL三种连接方式。连接方式的选项与接入方式和架构类型有关,请以控制台为准。

说明架构类型为分片集群架构的MongoDB数据库,不支持SSL安全连接。

若目标库为自建(接入方式不为云实例)副本集架构的MongoDB数据库,并且选择了SSL安全连接,DTS还支持上传CA证书对连接进行校验。

配置完成后,在页面下方单击测试连接以进行下一步,并在弹出的DTS服务器访问授权对话框单击测试连接。

说明请确保DTS服务的IP地址段能够被自动或手动添加至源库和目标库的安全设置中,以允许DTS服务器的访问。更多信息,请参见添加DTS服务器的IP地址段。

配置任务对象。

在对象配置页面,配置待迁移的对象。

配置

说明

迁移类型

如果只需要进行全量迁移,建议同时选中库表结构迁移和全量迁移。

如果需要进行不停机迁移,建议同时选中库表结构迁移、全量迁移和增量迁移。

说明若未选中库表结构迁移,请确保目标库中存在接收数据的数据库和表,并根据实际情况,在已选择对象框中使用库表列名映射功能。

若未选中增量迁移,为保障数据一致性,数据迁移期间请勿在源实例中写入新的数据。

目标已存在表的处理模式

预检查并报错拦截:检查目标数据库中是否有同名的表。如果目标数据库中没有同名的表,则通过该检查项目;如果目标数据库中有同名的表,则在预检查阶段提示错误,数据迁移任务不会被启动。

说明如果目标库中同名的表不方便删除或重命名,您可以更改该表在目标库中的名称,请参见库表列名映射。

忽略报错并继续执行:跳过目标数据库中是否有同名表的检查项。

警告选择为忽略报错并继续执行,可能导致数据不一致,给业务带来风险,例如:

表结构一致的情况下,在目标库遇到与源库主键的值相同的记录:

全量期间,DTS会保留目标集群中的该条记录,即源库中的该条记录不会迁移至目标数据库中。

增量期间,DTS不会保留目标集群中的该条记录,即源库中的该条记录会覆盖至目标数据库中。

表结构不一致的情况下,可能导致只能迁移部分列的数据或迁移失败,请谨慎操作。

目标库对象名称大小写策略

您可以配置目标实例中迁移对象的库名、集合名的英文大小写策略。默认情况下选择DTS默认策略,您也可以选择与源库、目标库默认策略保持一致。更多信息,请参见目标库对象名称大小写策略。

源库对象

在源库对象框中单击待迁移的对象,然后单击

将其移动到已选择对象框。说明

将其移动到已选择对象框。说明迁移对象选择的粒度为Collection或Database。

已选择对象

如需设置待迁移对象在目标实例中的名称,或指定目标实例中接收数据的对象,请右击已选择对象中的迁移对象进行修改。设置方式,请参见库表列名映射。

如需移除已选择的迁移对象,请在已选择对象框中单击待迁移的对象,然后单击

将其移动到源库对象框。

将其移动到源库对象框。

说明如需按库或集合级别选择增量迁移的操作,请在已选择对象中右击待迁移的对象,并在弹出的对话框中进行选择。

如需设置条件过滤数据(全量迁移阶段支持条件过滤数据,增量迁移阶段不支持),请在已选择对象中右击待迁移的表,并在弹出的对话框中进行设置。设置方法,请参见设置过滤条件。

如果使用了对象名映射功能(指定用于接收数据的数据库或集合),可能会导致依赖这个对象的其他对象迁移失败。

单击下一步高级配置,进行高级参数配置。

配置

说明

选择调度该任务的专属集群

DTS默认将任务调度到共享集群上,您无需选择。您可以购买指定规格的专属集群来运行DTS迁移任务,详情请参见什么是DTS专属集群。

源库、目标库无法连接后的重试时间

在迁移任务启动后,若源库或目标库连接失败则DTS会报错,并会立即进行持续的重试连接,默认重试720分钟,您也可以在取值范围(10~1440分钟)内自定义重试时间,建议设置30分钟以上。如果DTS在设置的时间内重新连接上源、目标库,迁移任务将自动恢复。否则,迁移任务将失败。

说明针对同源或者同目标的多个DTS实例,网络重试时间以后创建任务的设置为准。

由于连接重试期间,DTS将收取任务运行费用,建议您根据业务需要自定义重试时间,或者在源和目标库实例释放后尽快释放DTS实例。

源库、目标库出现其他问题后的重试时间

在迁移任务启动后,若源库或目标库出现非连接性的其他问题(如DDL或DML执行异常),则DTS会报错并会立即进行持续的重试操作,默认持续重试时间为10分钟,您也可以在取值范围(1~1440分钟)内自定义重试时间,建议设置10分钟以上。如果DTS在设置的重试时间内相关操作执行成功,迁移任务将自动恢复。否则,迁移任务将会失败。

重要源库、目标库出现其他问题后的重试时间的值需要小于源库、目标库无法连接后的重试时间的值。

是否限制全量迁移速率

在全量迁移阶段,DTS将占用源库和目标库一定的读写资源,可能会导致数据库的负载上升。您可以根据实际情况,选择是否对全量迁移任务进行限速设置(设置每秒查询源库的速率QPS、每秒全量迁移的行数RPS和每秒全量迁移的数据量(MB)BPS),以缓解目标库的压力。

说明仅当迁移类型选择了全量迁移,才有此配置项。

您也可以在迁移实例运行后,调整全量迁移的速率。

待同步的数据中,同一张表内主键_id的数据类型是否唯一

待迁移的数据中,同一个集合内主键

_id的数据类型是否唯一。重要请根据实际情况选择,否则可能会导致数据丢失。

仅当迁移类型选择了全量迁移,才有此配置项。

是:唯一。在全量迁移阶段,DTS将不会扫描源库待迁移数据中主键的数据类型;在单个集合中,DTS仅会迁移一种数据类型的主键所对应的数据。

否:不唯一。在全量迁移阶段,DTS将扫描源库待迁移数据中主键的数据类型,并迁移其所有数据。

是否限制增量迁移速率

您也可以根据实际情况,选择是否对增量迁移任务进行限速设置(设置每秒增量迁移的行数RPS和每秒增量迁移的数据量(MB)BPS),以缓解目标库的压力。

说明仅当迁移类型选择了增量迁移,才有此配置项。

您也可以在迁移实例运行后,调整增量迁移的速率。

环境标签

您可以根据实际情况,选择用于标识实例的环境标签。本示例无需选择。

配置ETL功能

选择是否配置ETL功能。关于ETL的更多信息,请参见什么是ETL。

是:配置ETL功能,并在文本框中填写数据处理语句,详情请参见在DTS迁移或同步任务中配置ETL。

否:不配置ETL功能。

监控告警

根据业务需求选择是否设置告警并接收告警通知。

不设置:不设置告警。

设置:设置告警。您还需要设置告警阈值和告警通知,当迁移失败或延迟超过阈值后,系统将进行告警通知。

单击下一步数据校验,进行数据校验任务配置。

若您需要使用数据校验功能,配置方法请参见配置数据校验。

保存任务并进行预检查。

若您需要查看调用API接口配置该实例时的参数信息,请将鼠标光标移动至下一步保存任务并预检查按钮上,然后单击气泡中的预览OpenAPI参数。

若您无需查看或已完成查看API参数,请单击页面下方的下一步保存任务并预检查。

说明在迁移任务正式启动之前,会先进行预检查。只有预检查通过后,才能成功启动迁移任务。

如果预检查失败,请单击失败检查项后的查看详情,并根据提示修复后重新进行预检查。

如果预检查产生警告:

对于不可以忽略的检查项,请单击失败检查项后的查看详情,并根据提示修复后重新进行预检查。

对于可以忽略无需修复的检查项,您可以依次单击点击确认告警详情、确认屏蔽、确定、重新进行预检查,跳过告警检查项重新进行预检查。如果选择屏蔽告警检查项,可能会导致数据不一致等问题,给业务带来风险。

购买实例。

预检查通过率显示为100%时,单击下一步购买。

在购买页面,选择数据迁移实例的链路规格,详细说明请参见下表。

类别

参数

说明

信息配置

资源组配置

选择实例所属的资源组,默认为default resource group。更多信息,请参见什么是资源管理。

链路规格

DTS为您提供了不同性能的迁移规格,迁移链路规格的不同会影响迁移速率,您可以根据业务场景进行选择。更多信息,请参见数据迁移链路规格说明。

配置完成后,阅读并选中《数据传输(按量付费)服务条款》。

单击购买并启动,并在弹出的确认对话框,单击确定。

您可以在迁移任务列表页面,查看迁移实例的具体进度。

说明若迁移实例不包含增量迁移任务,则迁移实例会自动结束。迁移实例自动结束后,运行状态为已完成。

若迁移实例包含增量迁移任务,则迁移实例不会自动结束,增量迁移任务会持续进行。在增量迁移任务正常运行期间,迁移实例的运行状态为运行中。

(可选):若自建MongoDB的接入方式为ECS自建数据库或数据库网关DG,您还需参考步骤1~步骤7,为剩余的Shard节点创建迁移任务。

完成迁移任务。

全量数据迁移

请勿手动结束迁移任务,否则可能会导致数据不完整。您只需等待迁移任务完成即可,迁移任务会自动结束。

增量数据迁移

迁移任务不会自动结束,需要手动结束迁移任务。

说明请选择合适的时间手动结束迁移任务,例如业务低峰期或准备将业务切换至MongoDB实例时。

等待所有Shard节点的迁移任务的运行阶段进入增量迁移,且运行信息中显示无延迟状态时,将源库停写几分钟,此时的状态可能会显示延迟的时间。

等待所有Shard节点迁移任务的增量迁移再次进入无延迟状态后,手动结束迁移任务。