LogHubStream Reader插件基于LogHub(SLS) SDK实时抽取您配置的LogHub(SLS) topic数据,并支持合并和分裂Shard。合并或分裂Shard后,数据可能会增加,但保证不会丢失数据。

背景信息

LogHub(SLS)实时同步读取插件,会自带以下元数据字段:

LogHub(SLS)实时同步字段 | 数据类型 | 说明 |

__time__ | STRING | SLS保留字段:__time__写入日志数据时指定的日志时间,Unix时间戳,单位为秒。 |

__source__ | STRING | SLS保留字段:__source__日志来源设备。 |

__topic__ | STRING | SLS保留字段:__topic__topic名称。 |

__tag__:__receive_time__ | STRING | 日志到达服务端的时间。开启记录外网IP功能后,服务端接收日志时为原始日志追加该字段。Unix时间戳,单位为秒。 |

__tag__:__client_ip__ | STRING | 日志来源设备的公网IP。开启记录外网IP功能后,服务端接收日志时为原始日志追加该字段。 |

__tag__:__path__ | STRING | Logtail采集的日志文件路径,Logtail会自动为日志追加该字段。 |

__tag__:__hostname__ | STRING | Logtail采集数据的来源机器主机名,Logtail为日志自动追加该字段。 |

操作步骤

进入数据开发页面。

登录DataWorks控制台,切换至目标地域后,单击左侧导航栏的,在下拉框中选择对应工作空间后单击进入数据开发。

鼠标悬停至

图标,单击。

图标,单击。 您也可以展开业务流程,右键单击目标业务流程,选择。

在新建节点对话框中,选择同步方式为单表(Topic)到单表(Topic)ETL,输入名称,并选择路径。

单击确认。

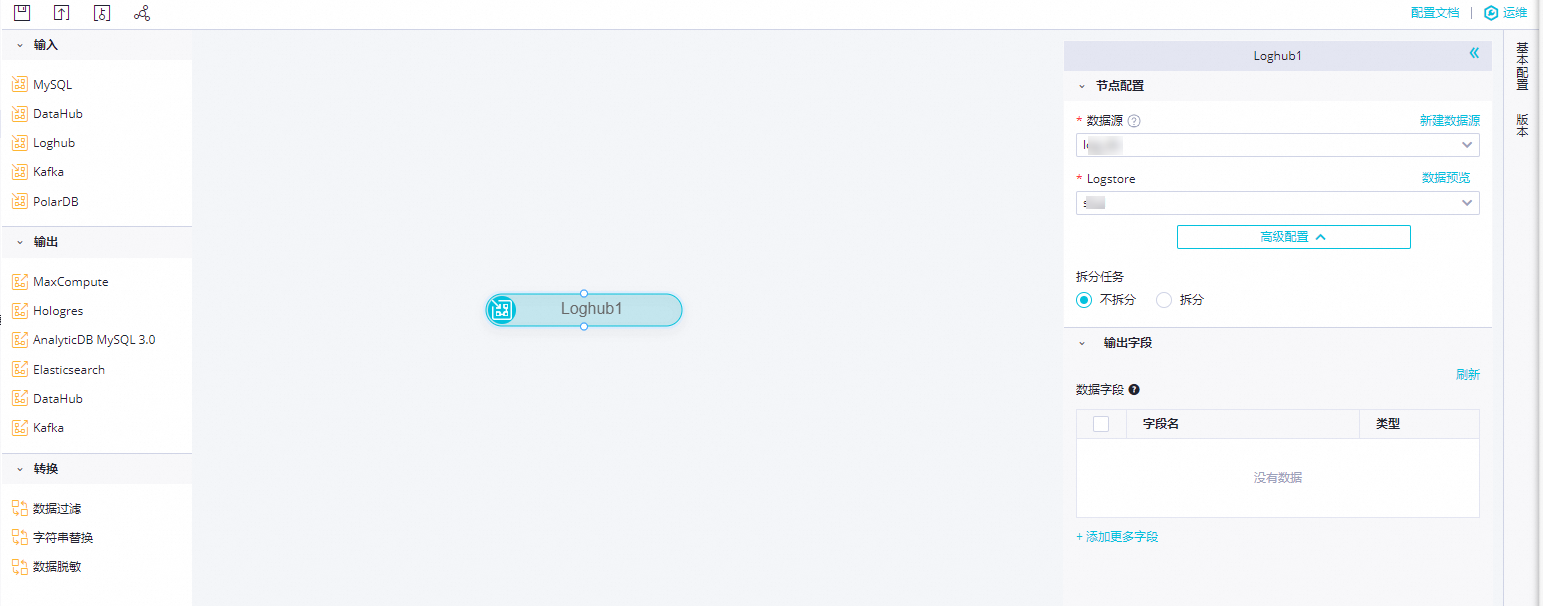

在实时同步节点的编辑页面,鼠标单击并拖拽至编辑面板。

单击LogHub节点,在节点配置对话框中,配置各项参数。

参数

描述

数据源

选择已经配置好的LogHub(SLS)数据源,此处仅支持LogHub(SLS)数据源。

如果未配置数据源,请单击右侧的新建数据源,跳转至页面进行新建。详情请参见配置LogHub(SLS)数据源。

Logstore

选择当前数据源下需要同步的Logstore。您可以单击右侧的数据预览进行确认。

高级配置

您可以在此设置是否拆分Logstore中的数据。如果选择拆分,则需要设置拆分规则。

拆分规则:shardId % X = Y,表示shardId对X取余,其中shardId为分片任务ID,X表示分片总数,Y表示shardId任务执行的分片编号,值为[0, X-1]。例如shardId % 5 = 3,表示将源端待同步数据切分为5个任务,shardId任务被分配到分片编号为3的任务上。

输出字段

选择需要同步的字段,字段含义请参见背景信息。

单击工具栏中的

图标。

图标。