本文为您介绍如何使用数据传输迁移 PolarDB-X 1.0 数据库的数据至 OceanBase 数据库 MySQL 租户。

如果数据迁移任务长期处于非活跃状态(任务状态为 失败、已暂停 或 已完成),受增量日志保留时长等影响,任务可能无法恢复。数据传输将主动释放处于非活跃状态超过 3 天的数据迁移任务,以回收相关资源,建议您为任务配置告警并及时处理任务相关异常。

背景信息

PolarDB-X 1.0 是由阿里巴巴自主研发的云原生分布式数据库,融合分布式 SQL 引擎和分布式自研存储 X-DB,基于云原生一体化架构设计。PolarDB-X 1.0 可以支撑千万级并发规模,以及百 PB 级海量存储。详情请参见 产品概述。

PolarDB-X 1.0 数据库至 OceanBase 数据库 MySQL 租户的数据迁移任务启动成功后,该任务会自动删除。数据传输会自动创建 PolarDB-X 1.0 数据库下挂载的 MySQL 数据库至 OceanBase 数据库 MySQL 租户的数据迁移任务,其任务个数取决于 PolarDB-X 1.0 数据库底层的 MySQL 实例个数。

建议您使用标签或任务名称作为过滤条件对这些任务进行批量启动、批量暂停、批量正向切换等操作。批量操作的详情请参见 批量操作数据迁移任务。

前提条件

数据传输已具备云资源访问权限。详情请参见 数据传输迁移角色授权。

已为源端 PolarDB-X 1.0 数据库和目标端 OceanBase 数据库 MySQL 租户创建专用于数据迁移的数据库用户,并赋予其相关权限。

使用限制

源端数据库的操作限制

请勿在全量迁移阶段执行库或表结构变更的 DDL 操作,否则可能造成数据迁移任务中断。

数据传输支持 PolarDB-X 1.0 数据库 V5.2.8、V5.4.2、V5.4.9 和 V5.4.12。

数据传输支持 PolarDB-X 1.0 数据库下挂载的 RDS MySQL 兼容的 MySQL 数据库 V5.5、V5.6、V5.7 和 V8.0,以及标准 RDS 和 PolarDB MySQL 实例。

数据传输仅支持迁移库名、表名和列名为 ASCII 码且不包含特殊字符(包括换行、空格,以及 .|"'`()=;/&\)的对象。

迁移 PolarDB-X 1.0 数据库的数据至 OceanBase 数据库 MySQL 租户时,数据传输不支持以下内容:

不支持结构迁移和反向增量。

不支持源端和目标端数据库跨阿里云账号。

不支持迁移视图。

不支持 PolarDB-X 1.0 数据库下挂载的 RDS MySQL 实例的账号密码不一致。

OceanBase 数据库支持的字符集为 utf8mb4、gbk、gb18030、binary 和 utf16。

注意事项

对于无唯一键表(指具有主键或者 Not Null UK 的表)的迁移,在重启或恢复全量迁移步骤时,通常数据传输会自动清空(TRUNCATE)重启或恢复前已完成同步的目标表。但在 PolarDB-X 1.0 场景下,RDS MySQL 数据库无唯一键表至 OceanBase 数据库 MySQL 租户的数据迁移任务的全量迁移步骤在重启或恢复时,数据传输不会自动清空目标表。

如果您未配置 PolarDB-X 1.0 数据库对象的映射关系,则物理表的数据会全部同步至目标端相同名称的物理表中,即源端物理表的数量和目标端数量一致。

如果源端和目标端的表结构不完全一致,可能会出现数据不一致的情况。目前已知场景如下:

用户手动创建表结构时,可能会因超出数据传输的支持范围而产生隐式的转换问题,导致源端和目标端列的类型不一致。

目标端的数据长度小于源端的数据长度时,可能出现数据截断的情况,导致源端和目标端的数据不一致。

如果创建数据迁移任务时,您仅配置了 增量同步,数据传输要求源端数据库的本地增量日志保存 48 小时以上。

如果创建数据迁移任务时,您配置了 全量迁移+增量同步,数据传输要求源端数据库的本地增量日志至少保留 7 天以上。否则数据传输可能因为无法获取增量日志导致数据迁移任务失败,甚至导致源端和目标端数据不一致。

如果源端或目标端存在仅大小写不同的表对象,可能会因为源端或目标端大小写不敏感导致数据迁移的结果不符合预期。

支持的源端和目标端实例类型

下表中,OceanBase 数据库 MySQL 租户简称为 OB_MySQL。

源端 | 目标端 |

PolarDB-X 1.0(阿里云 PolarDB-X 1.0 实例) | OB_MySQL(OceanBase 集群实例) |

PolarDB-X 1.0(阿里云 PolarDB-X 1.0 实例) | OB_MySQL(Serverless 实例) |

操作步骤

登录 OceanBase 管理控制台,购买数据迁移任务。

详情请参见 购买数据迁移任务。

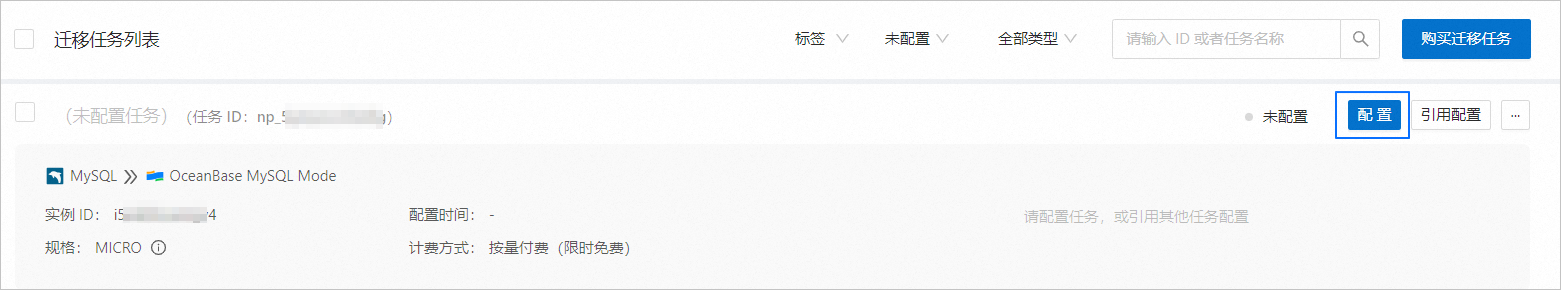

在 数据传输 > 数据迁移 页面,单击新购买的数据迁移任务后的 配置。

如果您需要引用已有的任务配置信息,可以单击 引用配置。详情请参见 引用数据迁移任务配置。

在 选择源和目标 页面,配置各项参数。

参数

描述

迁移任务名称

建议使用中文、数字和字母的组合。名称中不能包含空格,长度不得超过 64 个字符。

源端

如果您已新建 PolarDB-X 1.0 数据源,请从下拉列表中进行选择。如果未新建,请单击下拉列表中的 新建数据源,在右侧对话框进行新建。参数详情请参见 新建 PolarDB-X 1.0 数据源。

目标端

如果您已新建 OceanBase 数据库 MySQL 租户数据源,请从下拉列表中进行选择。如果未新建,请单击下拉列表中的 新建数据源,在右侧对话框进行新建。参数详情请参见 新建 OceanBase 数据源。

标签

单击文本框,在下拉列表中选择目标标签。您也可以单击 管理标签,进行新建、修改和删除。详情请参见 通过标签管理数据迁移任务。

说明PolarDB-X 1.0 数据库至 OceanBase 数据库 MySQL 租户的数据迁移任务启动成功后,该任务会自动删除,请选择合适的标签进行标记。

击 下一步。在 选择迁移类型 页面,选择当前数据迁移任务的迁移类型。

迁移类型支持 全量迁移、增量同步 和 全量校验。

迁移类型

描述

全量迁移

全量迁移任务开始后,数据传输会将源端库表的存量数据迁移至目标端数据库对应的表中。

执行数据迁移前,请评估源端和目标端的性能,建议在业务低峰期执行数据迁移。否则全量迁移期间,数据传输占用源端和目标端一定的读写资源,可能会导致数据库的负载上升。性能评估详情请参见 迁移评估的性能评估。

增量同步

增量同步任务开始后,数据传输会同步源端数据库发生变化的数据(新增、修改或删除)至目标端数据库对应的表中。

增量同步 支持的同步 DML 包括

Insert、Delete和Update,您可以根据需求进行选择。详情请参见 自定义配置 DDL/DML。全量校验

在全量迁移完成、增量数据同步至目标端并与源端基本追平后,数据传输会自动发起一轮针对源端库配置的数据表和目标表的全量数据校验任务。

如果您选择了 增量同步,且 同步 DML 选项中未选择所有的 DML,则数据传输不支持本场景下的全量数据校验。

执行数据迁移前,请评估源端和目标端的性能,建议业务低峰期执行数据迁移。否则全量校验期间,数据传输占用源端和目标端部分读资源,可能会导致数据库的负载上升。

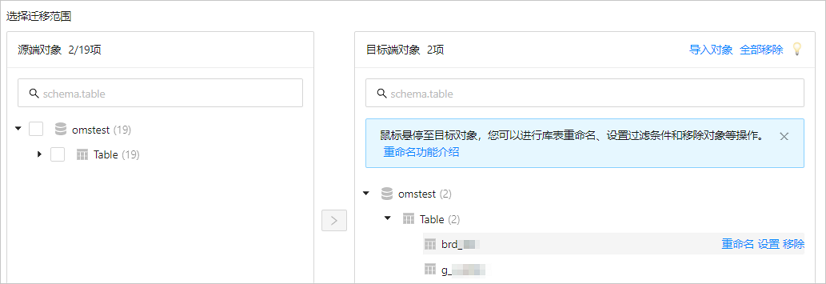

单击 下一步。在 选择迁移对象 页面,选择当前数据迁移任务的迁移对象。

目前仅支持通过 指定对象 的方式选择迁移对象。在左侧选中需要迁移的对象,单击 >,将其添加至右侧列表中。您可以选择一个或多个库的表作为迁移对象。

数据传输支持通过文本导入对象,并支持对目标端对象进行重命名、设置行过滤、查看列信息,以及移除单个或全部迁移对象等操作。

操作

描述

导入对象

在选择区域的右侧列表中,单击右上角的 导入对象。

在对话框中,单击 确定。

重要导入会覆盖之前的操作选择,请谨慎操作。

在 导入迁移对象 对话框中,导入需要迁移的对象。

您可以通过导入 CSV 文件的方式进行库表重命名、设置行过滤条件等操作。详情请参见 下载和导入迁移对象配置。

单击 检验合法性。

完成迁移对象导入后,请先检验合法性。目前暂不支持列字段映射。

通过检验后,单击 确定。

重命名

数据传输支持重命名迁移对象的名称,详情请参见 数据库库表重命名。

设置

数据传输支持

WHERE条件实现行过滤,详情请参见 SQL 条件过滤数据。您还可以在 查看列 区域,查看迁移对象的列信息。

移除/全部移除

数据传输支持在数据映射时,对暂时选中到目标端的单个或多个对象进行移除操作。

移除单个迁移对象

在选择区域的右侧列表中,鼠标悬停至目标对象,单击显示的 移除,即可移除该迁移对象。

移除全部迁移对象

在选择区域的右侧列表中,单击右上角的 全部移除。在对话框中,单击 确定,即可移除全部迁移对象。

单击 下一步。在 迁移选项 页面,配置各项参数。

全量迁移

在 选择迁移类型 页面,选中 全量迁移,才会显示下述参数。

参数

描述

读取并发配置

该参数用于配置全量迁移阶段从源端读取数据的并发数,最大限制为 512.并发数过高可能会造成源端压力过大,影响业务。

写入并发配置

该参数用于配置全量迁移阶段往目标端写入数据的并发数,最大限制为 512。并发数过高可能会造成目标端压力过大,影响业务。

全量迁移速率限制

您可以根据实际需求决定是否开启全量迁移速率限制。如果开启,请设置 RPS(全量迁移阶段每秒最多可以迁移至目标端的数据行数的最大值限制)和 BPS(全量迁移阶段每秒最多可以迁移至目标端的数据量的最大值限制)。

说明此处设置的 RPS 和 BPS 仅作为限速限流能力,全量迁移实际可以达到的性能受限于源端、目标端、实例规格配置等因素的影响。

目标端表对象存在记录时处理策略

处理策略包括 忽略 和 停止迁移:

选择 忽略:当目标端表对象存在数据时,如果原数据与写入数据冲突,数据传输采用将冲突数据记录日志,保留原数据不变的策略进行数据写入。

重要选择 忽略,全量校验将使用 IN 模式拉取数据,无法校验目标端存在源端没有的数据的场景,并且校验性能会有一定程度降级。

选择默认值 停止迁移:当目标端表对象存在数据时,全量迁移会报错不允许迁移,请处理好目标端数据后再继续迁移。

重要如果出错后单击恢复,数据传输将忽略该配置选项,继续迁移表数据,请谨慎操作。

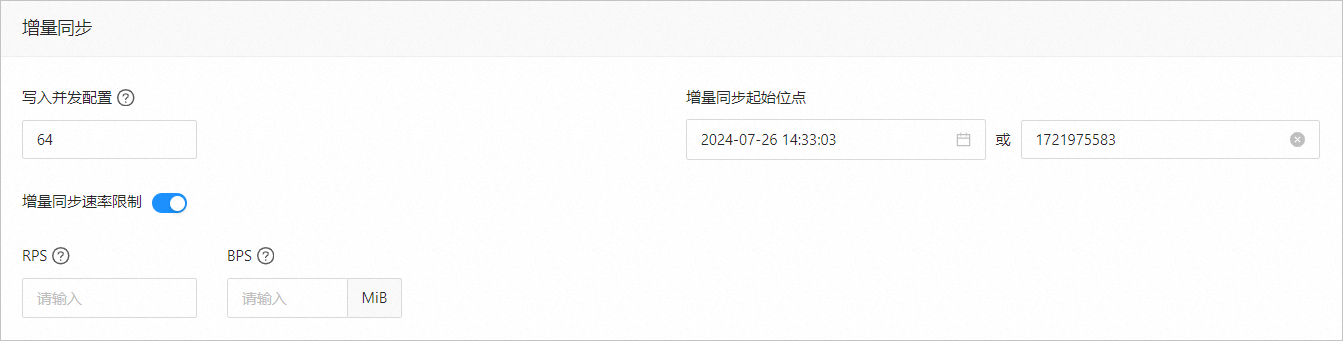

增量同步

在 选择迁移类型 页面,选中 增量同步,才会显示下述参数。

参数

描述

写入并发配置

该参数用于配置增量同步阶段往目标端写入数据的并发数,最大限制为 512。并发数过高可能会造成目标端压力过大,影响业务。

增量同步速率限制

您可以根据实际需求决定是否开启增量同步速率限制。如果开启,请设置 RPS(增量同步阶段每秒最多可以同步至目标端的数据行数的最大值限制)和 BPS(增量同步阶段每秒最多可以同步至目标端的数据量的最大值限制)。

说明此处设置的 RPS 和 BPS 仅作为限速限流能力,增量同步实际可以达到的性能受限于源端、目标端、实例规格配置等因素的影响。

增量同步起始位点

如果选择迁移类型时已选择 全量迁移,则不显示该参数。

如果选择迁移类型时未选择 全量迁移,但选择了 增量同步,请在此处指定迁移某个时间节点之后的数据,默认为当前系统时间。详情请参见 设置增量同步位点。

单击 预检查,系统对数据迁移任务进行预检查。

在 预检查 环节,数据传输会检查数据库用户的读写权限、数据库的网络连接等是否符合要求。全部检查任务均通过后才能启动数据迁移任务。如果预检查报错:

您可以在排查并处理问题后,重新执行预检查,直至预检查成功。

您也可以单击错误预检查项操作列中的 跳过,会弹出对话框提示您跳过本操作的具体影响,确认可以跳过后,请单击对话框中的 确定。

预检查成功后,单击 启动任务。

如果您暂时无需启动任务,请单击 保存。后续您只能在 迁移任务列表 页面手动启动任务或通过批量操作启动任务。批量操作的详情请参见 批量操作数据迁移任务。

任务启动成功后,PolarDB-X 1.0 数据库至 OceanBase 数据库 MySQL 租户的数据迁移任务会自动删除,数据传输会保存 PolarDB-X 1.0 数据库下挂载的数据库至 OceanBase 数据库 MySQL 租户的数据迁移任务,并自动创建相应的数据源。您可以在弹出对话框中单击 下载为文件,将相关信息保存为 CSV 文件。

单击对话框中的 确定,进入 迁移任务列表 页面,单个或批量启动 MySQL 数据库至 OceanBase 数据库 MySQL 租户的数据迁移任务。

数据传输支持在数据迁移任务运行过程中修改迁移对象,详情请参见 查看和修改迁移对象及其过滤条件。数据迁移任务启动后,会根据选择的迁移类型依次执行,详情请参见 查看迁移详情。