本文介紹如何使用即時日誌功能對使用者訪問日誌進行分析。

概述

阿里雲CDN產品的即時日誌功能是CDN產品與SLS產品聯合推出的一項功能,是一種時效性非常高(延遲在3分鐘左右)的日誌資料處理服務,能夠將CDN節點上採集到的使用者訪問日誌即時推送至SLSLog Service,然後可以通過SLS來儲存和分析使用者訪問資料。在使用阿里雲CDN產品來加速網站網域名稱訪問速度的情況下,使用者訪問網站的圖片、視頻等資源時,CDN會記錄使用者的訪問日誌,如果您需要對使用者訪問日誌進行分析來瞭解使用者構成、訪問品質或者快速定位問題,您可以使用即時日誌功能來快速實現。

前提條件

開通CDN服務:參考開通CDN服務開通了CDN產品,並且添加了加速網域名稱。

開通SLS服務:參考Log Service快速入門開通了SLSLog Service產品。

配置即時日誌推送:參考配置即時日誌推送為需要分析使用者訪問資料的CDN加速網域名稱配置即時日誌推送。

CDN提供的即時日誌與離線Log Service的區別

日誌延遲

CDN即時日誌為即時採集的日誌資料,日誌資料延遲不超過3分鐘,而離線日誌的資料延遲通常在24小時之內。

日誌分析

CDN即時日誌打通了SLSLog Service的日誌轉存和日誌分析能力,預製了CDN基礎資料、CDN錯誤分析、CDN熱門資源、CDN使用者分析這四張常用分析報表,也支援自訂日誌分析策略,可以一站式提供日誌儲存和日誌分析能力,而離線日誌目前只支援日誌轉存到OSS雲端儲存,尚未打通日誌分析能力。

即時Log Service的優勢

日誌延遲小

日誌資料延遲不超過3分鐘,可以協助您快速對訪問日誌進行分析,及時發現問題並做出應對決策。

一站式服務

傳統的離線日誌分析模式,需要使用者將日誌下載,再重新上傳至資料倉儲,然後在資料倉儲進行一系列的清洗和資料模型定義,這一系列操作處理完以後才能進行資料分析,整個過程需要的人力較多,時間較長;CDN即時日誌打通了SLSLog Service的日誌轉存和日誌分析能力,免去傳統模式下繁瑣的離線日誌分析流程。

適用情境

即時日誌可以協助您分析加速網域名稱遇到的異常問題,也可以協助您瞭解使用者的訪問情況。阿里雲CDN即時日誌在提供預製日誌分析報表的同時,還支援自訂日誌分析策略,可以滿足不同情境下的需求。

預製的日誌分析報表

日誌分析情境 | 報表作用描述 |

CDN基礎資料 | 該資料可以協助您快速瞭解到CDN整體的服務品質以及終端使用者的訪問效率(命中率、訪問延時、下載速度等),同時也可以在服務品質出現異常情況下及時進行處理。 |

CDN訪問錯誤 | 該資料可以協助您在應用訪問出現異常時,快速定位到CDN服務問題的源頭,例如:部分URI問題、來源站點出現故障、部分節點不可用、部分省份網路問題、部分電訊廠商網路問題等。 |

CDN熱門資源 | 該資料可以協助您更好地瞭解熱門資源情況,分析出熱門網域名稱、熱門URI、熱門省份、熱門電訊廠商等,您也可以從熱門資料瞭解到您的營運活動效果是否正常、熱點時間內流量的上漲是否符合預期,以協助您及時調整營運策略。 |

CDN使用者構成 | 該資料可以協助您更好地瞭解網站的使用者構成,包括使用者的用戶端類型、省份、電訊廠商等,也能夠統計出訪問量TOP使用者、下載量TOP使用者。 |

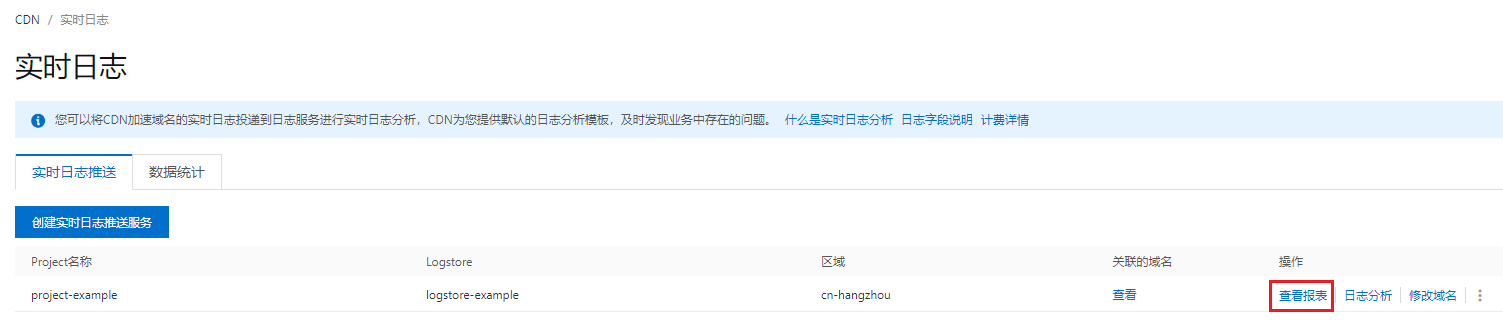

在即時日誌功能頁面找到需要分析日誌的Project名稱,然後單擊查看報表即可進入日誌分析報表範本的查看頁面。

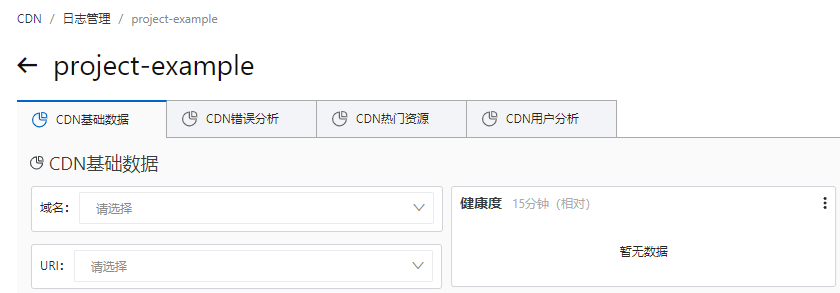

在資料查詢範本頁面,預設情況下查詢的是全量網域名稱的資料,也可以查詢指定網域名稱或者URI的資料。

具體使用方法您可以參考以下幾個章節:

自訂日誌分析

在預製的日誌分析報表無法滿足您的需求時,您可以使用SLS產品強大的日誌分析能力來實現自訂日誌分析。

例如:查看響應狀態代碼為499的網域名稱熱門排行榜、查看響應狀態代碼為502的網域名稱熱門排行榜。

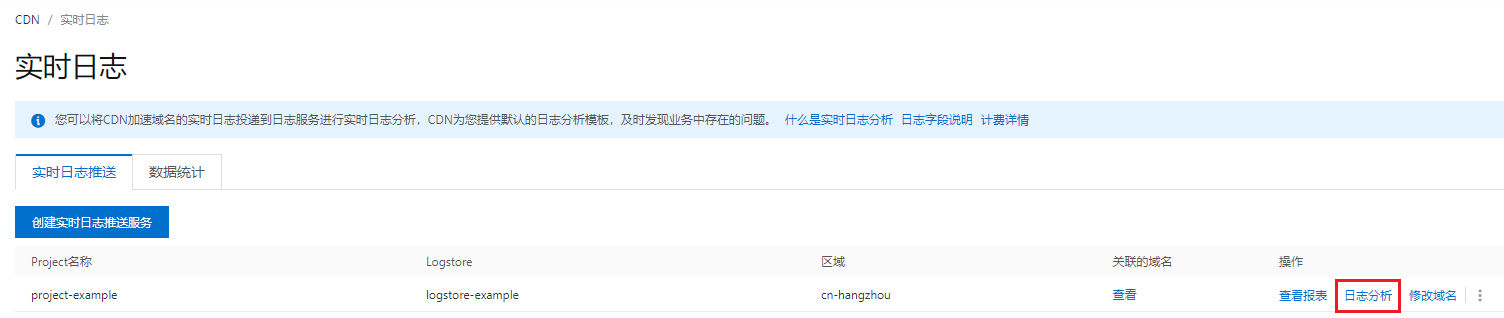

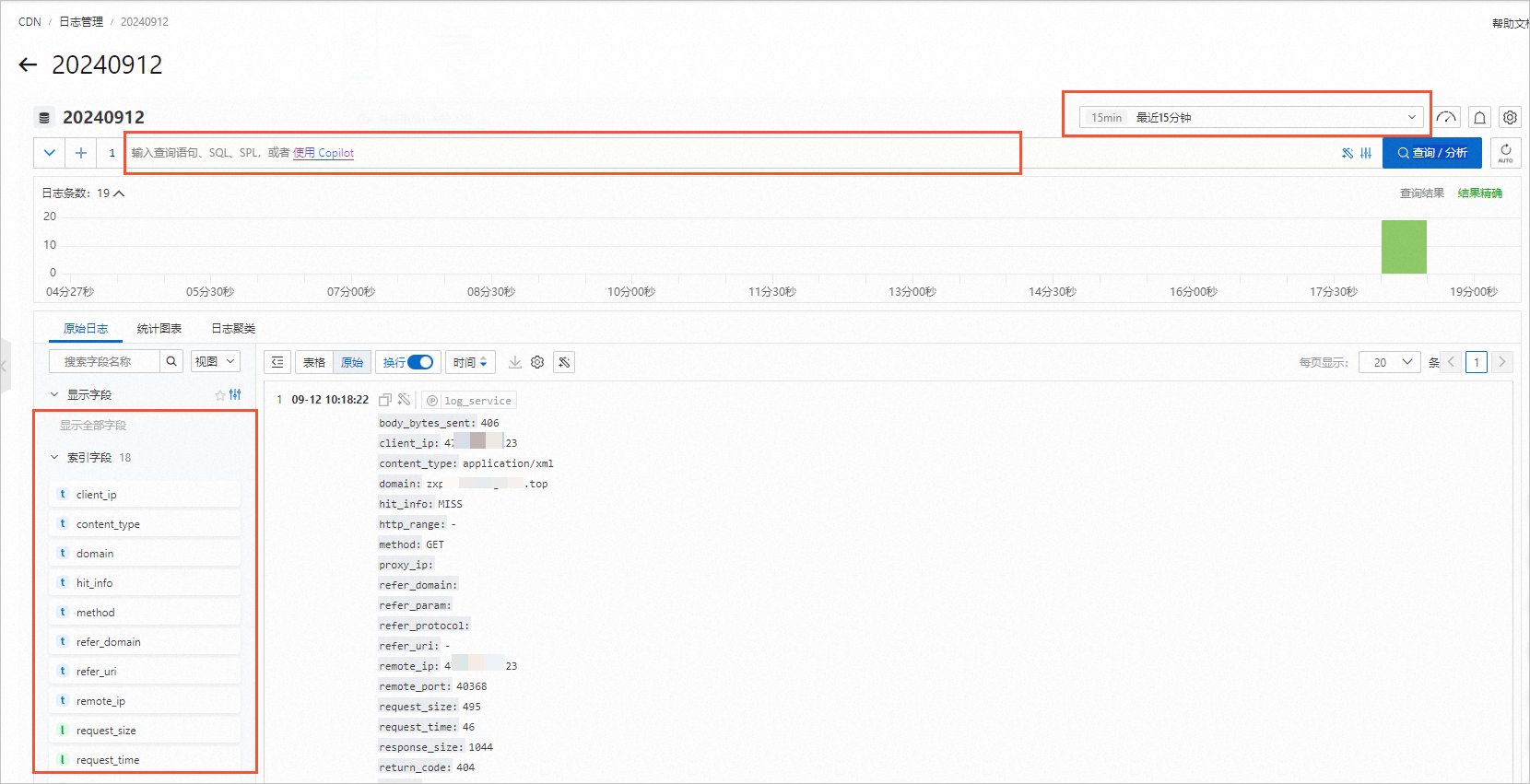

在即時日誌功能頁面找到需要分析日誌的Project名稱,然後單擊日誌分析即可進入自訂日誌分析功能的頁面。

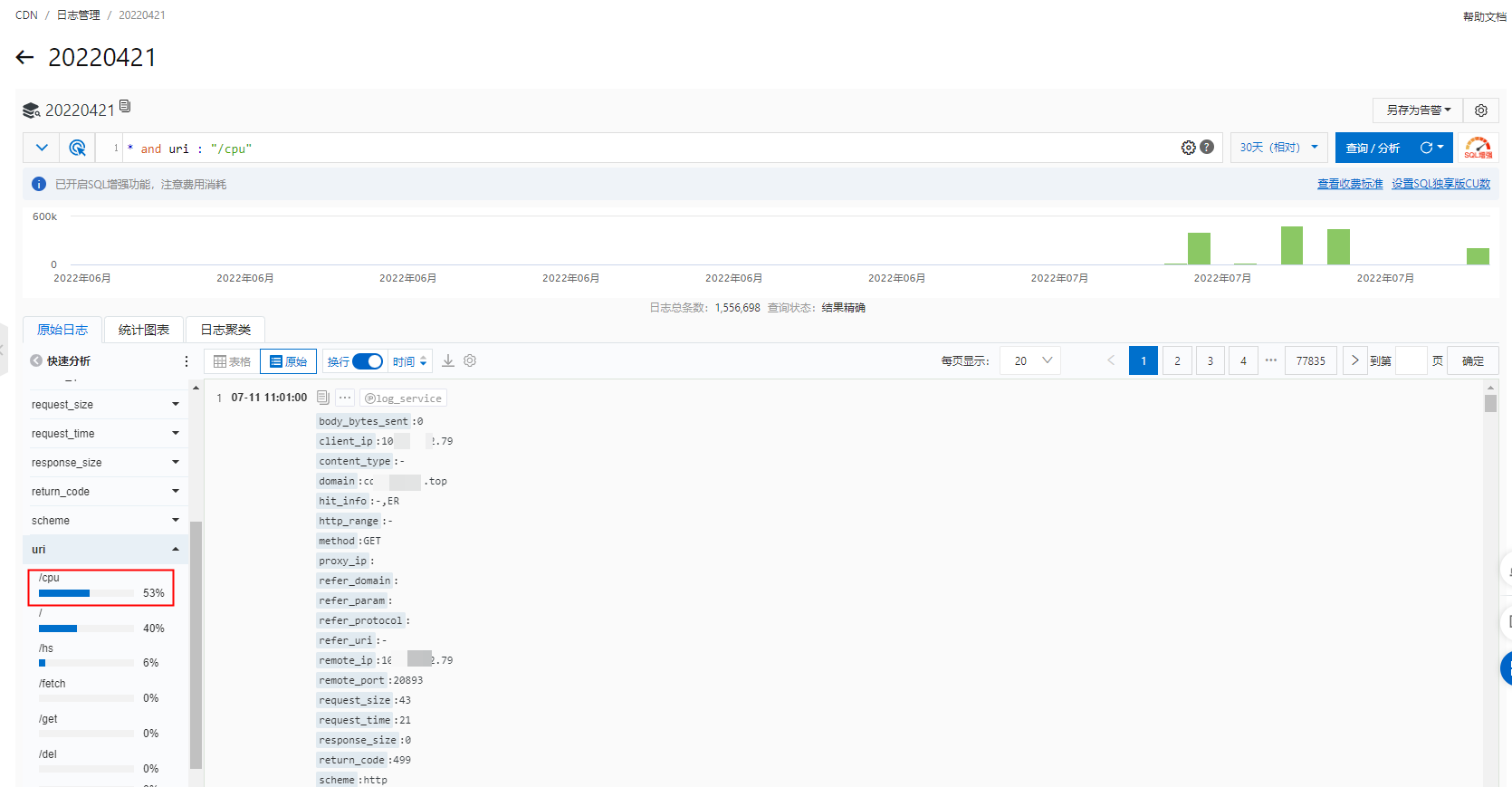

在自訂分析介面,您可以在搜尋方塊裡面輸入查詢語句直接查詢日誌資料(通常適用於比較複雜的查詢條件),也可以直接單擊左側原始日誌欄的日誌欄位來過濾日誌(通常適用於比較簡單的過濾條件)。

具體使用方法您可以參考:自訂報表

建立即時日誌推送Project

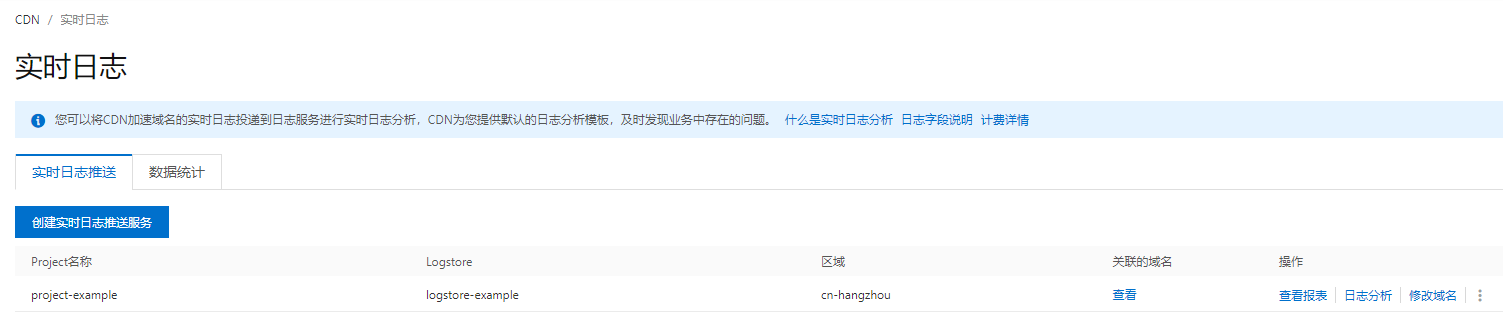

您可以參考配置即時日誌推送建立一個SLSLog Service的project,用於儲存CDN產品指定網域名稱(例如:aliyun.example.com)推送的即時日誌。

建立成功的效果如下圖,Project名稱為project-example,Logstore名稱為project-example,日誌儲存地區為cn-hangzhou(華東1-杭州)。

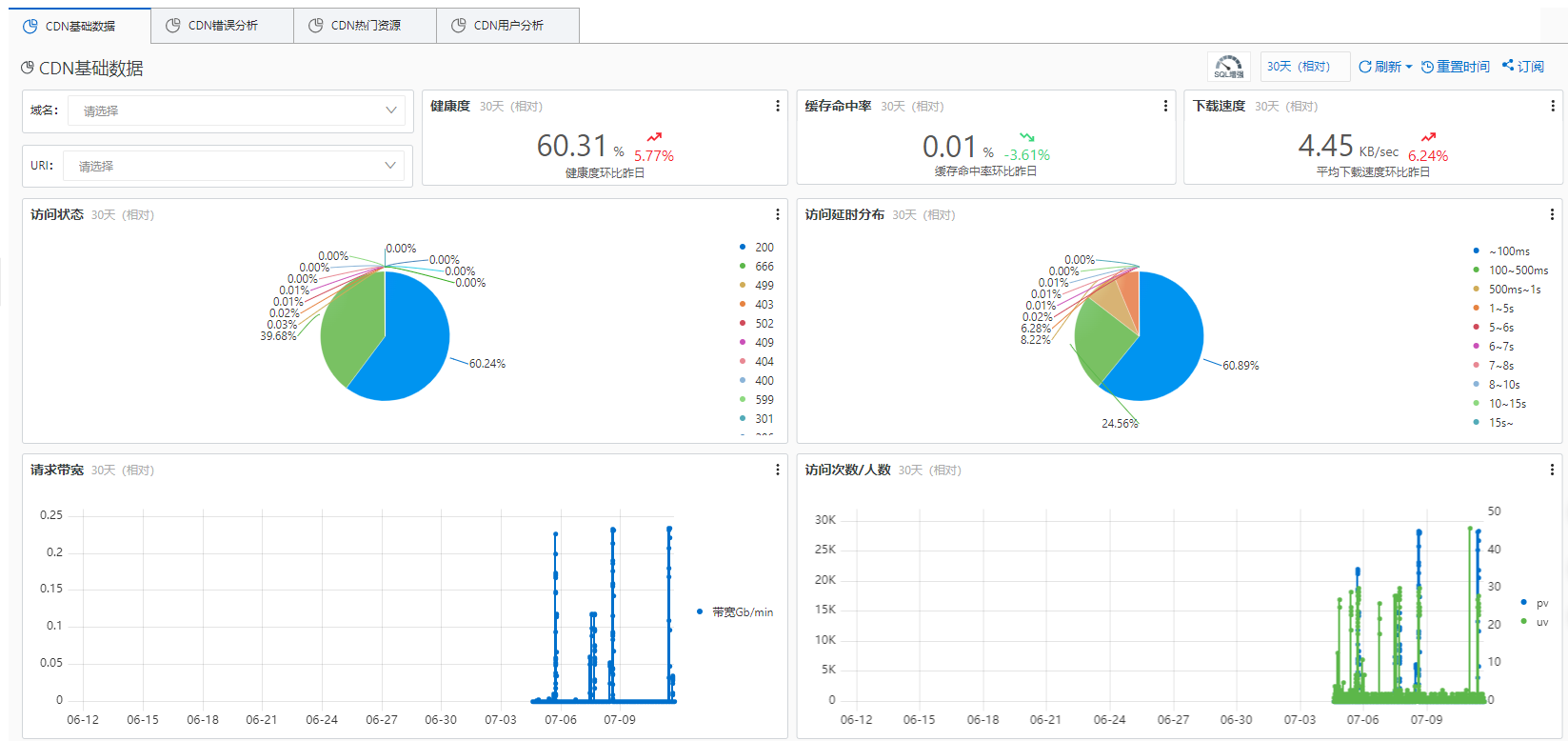

預製報表:CDN基礎資料

CDN基礎資料可以協助您快速瞭解到CDN整體的服務品質以及終端使用者的訪問效率(命中率、訪問延時、下載速度等),同時也可以在服務品質出現異常情況下及時進行處理。

包括以下資料(可以查看總的資料,也可以按網域名稱或者URI查看):

健康度:響應正常的狀態代碼總數佔比。

快取命中率:資源的平均快取命中率(按位元組數來統計的命中率)。

下載速度:資源的平均下載速度。

訪問狀態:每一種響應狀態代碼的佔比,可以用於快速查看當前異常狀態代碼的佔比。

訪問延時分布:每一個延時段的佔比。

請求頻寬:分鐘粒度的頻寬值。

訪問次數/人數:PV、UV值。

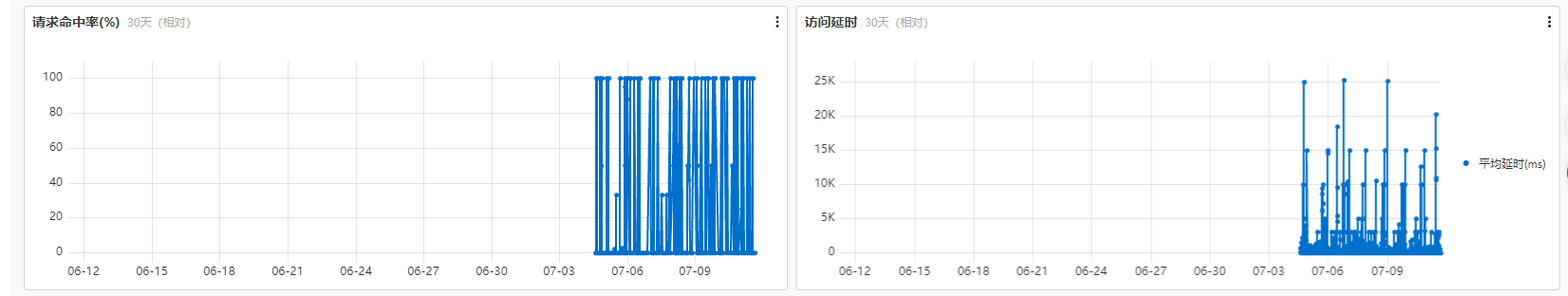

請求命中率:按請求數來統計的命中率。

訪問延時:用於下載資源的平均訪問延時。

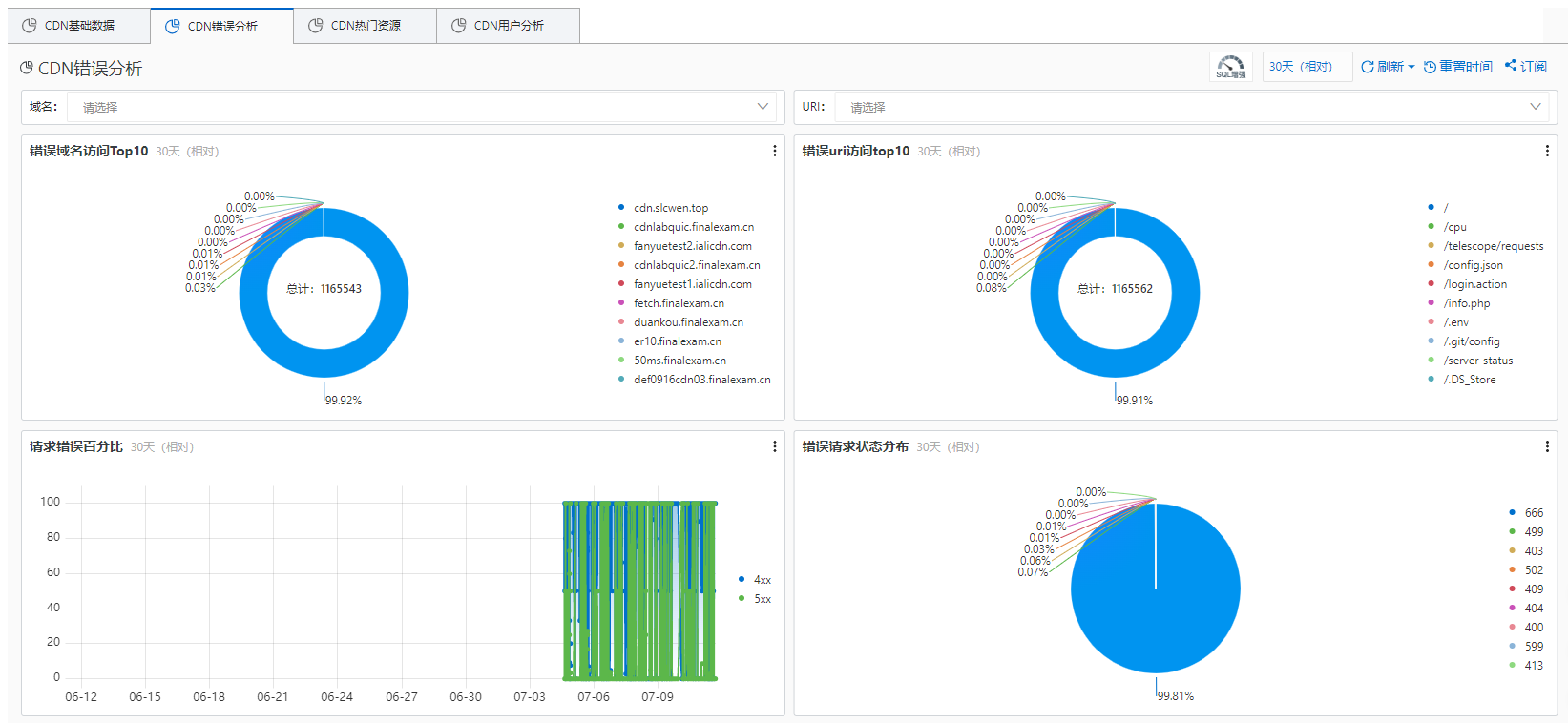

預製報表:CDN訪問錯誤

CDN訪問錯誤資料可以協助您在應用訪問出現異常時,快速定位到CDN服務問題的源頭,例如:部分URI問題、來源站點出現故障、部分節點不可用、部分省份網路問題、部分電訊廠商網路問題等。

包括以下資料(可以查看總的資料,也可以按網域名稱或者URI查看):

錯誤網域名稱訪問Top10:按不同網域名稱訪問產生的錯誤佔比統計Top網域名稱。

錯誤URI訪問Top10:按不同URI下產生的錯誤佔比統計Top URI。

請求錯誤百分比:分時間統計4xx、5xx狀態代碼的佔比。

錯誤請求狀態分布:統計各個狀態代碼的數量、佔比。

錯誤電訊廠商統計:統計不同電訊廠商的4xx、5xx狀態代碼數量。

錯誤按省份統計:統計不同省份的4xx、5xx狀態代碼數量。

錯誤詳情(4xx):統計不同省份、電訊廠商的4xx狀態代碼數量、佔比。

錯誤詳情(5xx):統計不同省份、電訊廠商的5xx狀態代碼數量、佔比。

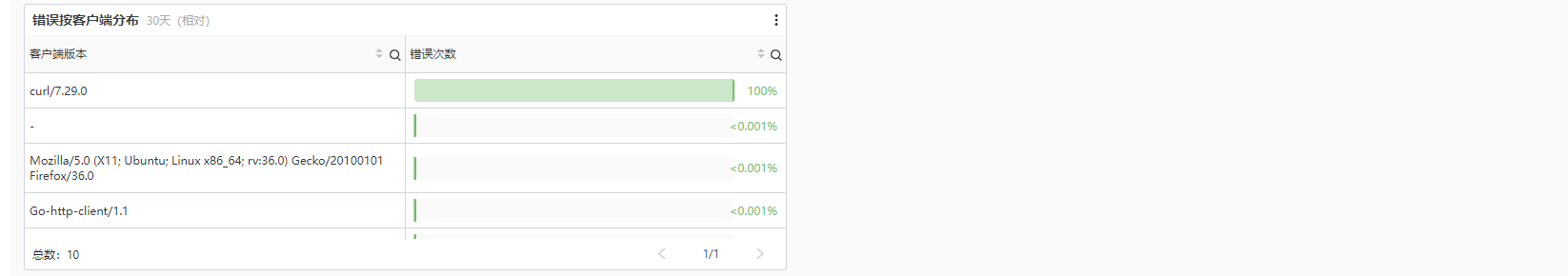

錯誤按用戶端分布:統計不同的用戶端UA(user-agent)對應的4xx、5xx狀態代碼數量及佔比。

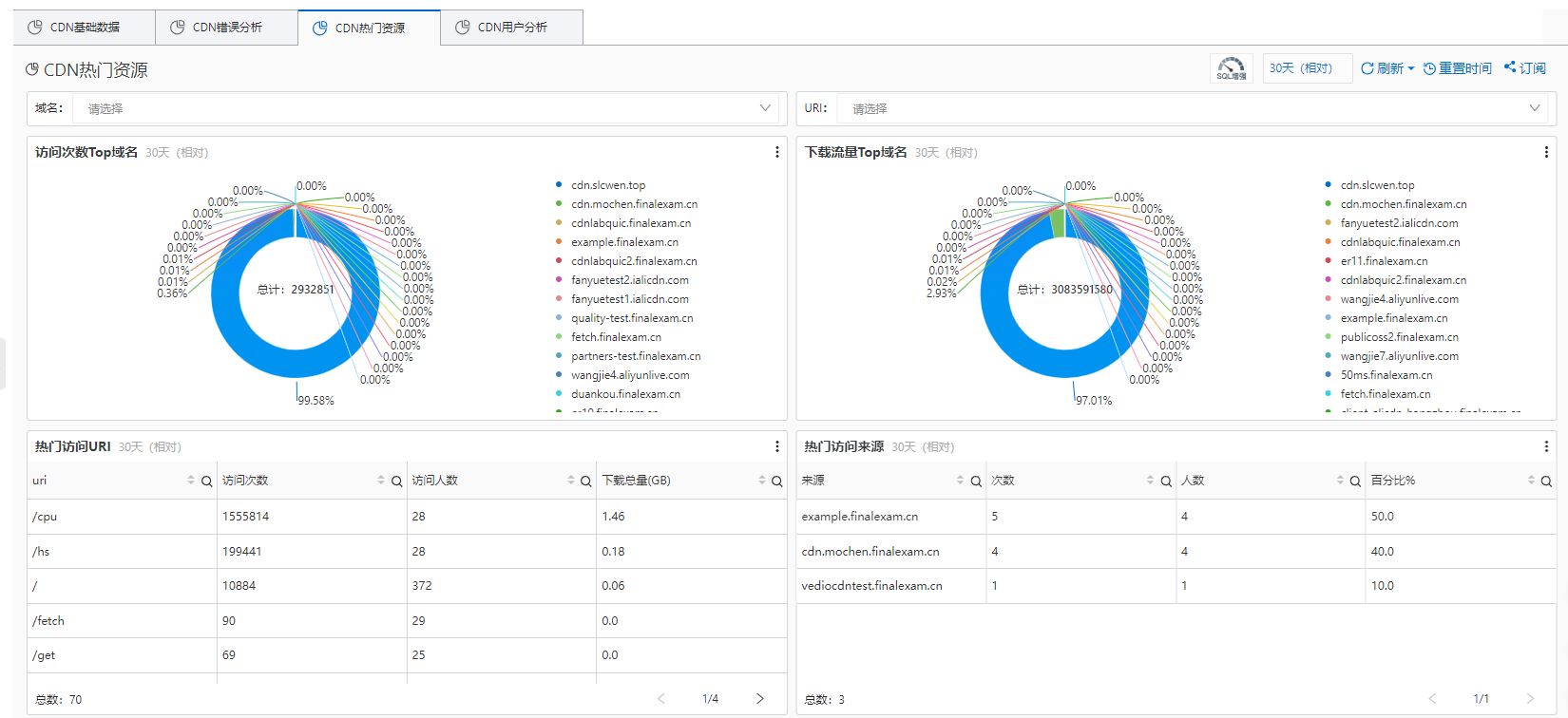

預製報表:CDN熱門資源

CDN熱門資源資料可以協助您更好地瞭解熱門資源情況,分析出熱門網域名稱、熱門URI、熱門省份、熱門電訊廠商等,您也可以從熱門資料瞭解到您的營運活動效果是否正常、熱點時間內流量的上漲是否符合預期,以協助您及時調整營運策略。

包括以下資料(可以查看總的資料,也可以按網域名稱或者URI查看):

訪問次數Top網域名稱:按總訪問次數佔比統計Top網域名稱。

下載流量Top網域名稱:按總下載流量佔比統計Top網域名稱。

熱門訪問URI:統計各個URI的訪問次數、訪問人數、下載總量。

熱門訪問來源:統計熱門Referer來源網域名稱,並且記錄訪問次數、UV、佔比。

全國訪問次數統計:分別統計各個省份的平均訪問次數。

全國下載網速:分別統計各個省份的平均下載速度。

省份統計:分別統計各個省份的總訪問次數、總下載流量、平均下載速度。

電訊廠商流量和速度:分別統計各個電訊廠商的下載總量和平均下載速度。

電訊廠商統計:分別統計各個電訊廠商的總訪問次數、總下載流量、平均下載速度。

預製報表:CDN使用者構成

CDN使用者構成資料可以協助您更好地瞭解網站的使用者構成,包括使用者的用戶端類型、省份、電訊廠商等,也能夠統計出訪問TOP使用者、下載量TOP使用者。

包括以下資料(可以查看總的資料,也可以按網域名稱或者URI查看):

訪問次數:總訪問次數,PV。

訪問人數:總訪問人數,UV。

訪問地區分布:分別統計各個省份的訪問次數、佔比。

訪問用戶端統計:分別統計各個用戶端類型的訪問次數、佔比。

電訊廠商次數統計:分別統計各個電訊廠商的總訪問次數、佔比。

下載量Top使用者:按IP統計使用者的總訪問數、錯誤訪問數、下載總量。

有效訪問Top使用者:按IP統計使用者的總訪問數、錯誤訪問數、下載總量(去掉4xx、5xx這些無效訪問)。

訂閱報表範本資料

如果您需要SLSLog Service定期將報表範本的資料發送給您,那麼您可以使用訂閱功能。

操作步驟

以CDN基礎資料頁面為例,單擊右上方的訂閱,然後單擊建立。

在側滑出現的配置視窗中輸入訂閱名稱、頻率和全域時間,然後單擊下一步。

在通知清單的下拉式功能表中選擇通知方式並填寫相關資訊後,單擊提交即可成功建立。

通知方式目前支援郵件、WebHook-DingTalk機器人、WebHook-飛書機器人、WebHook-企業微信機器人和微信。

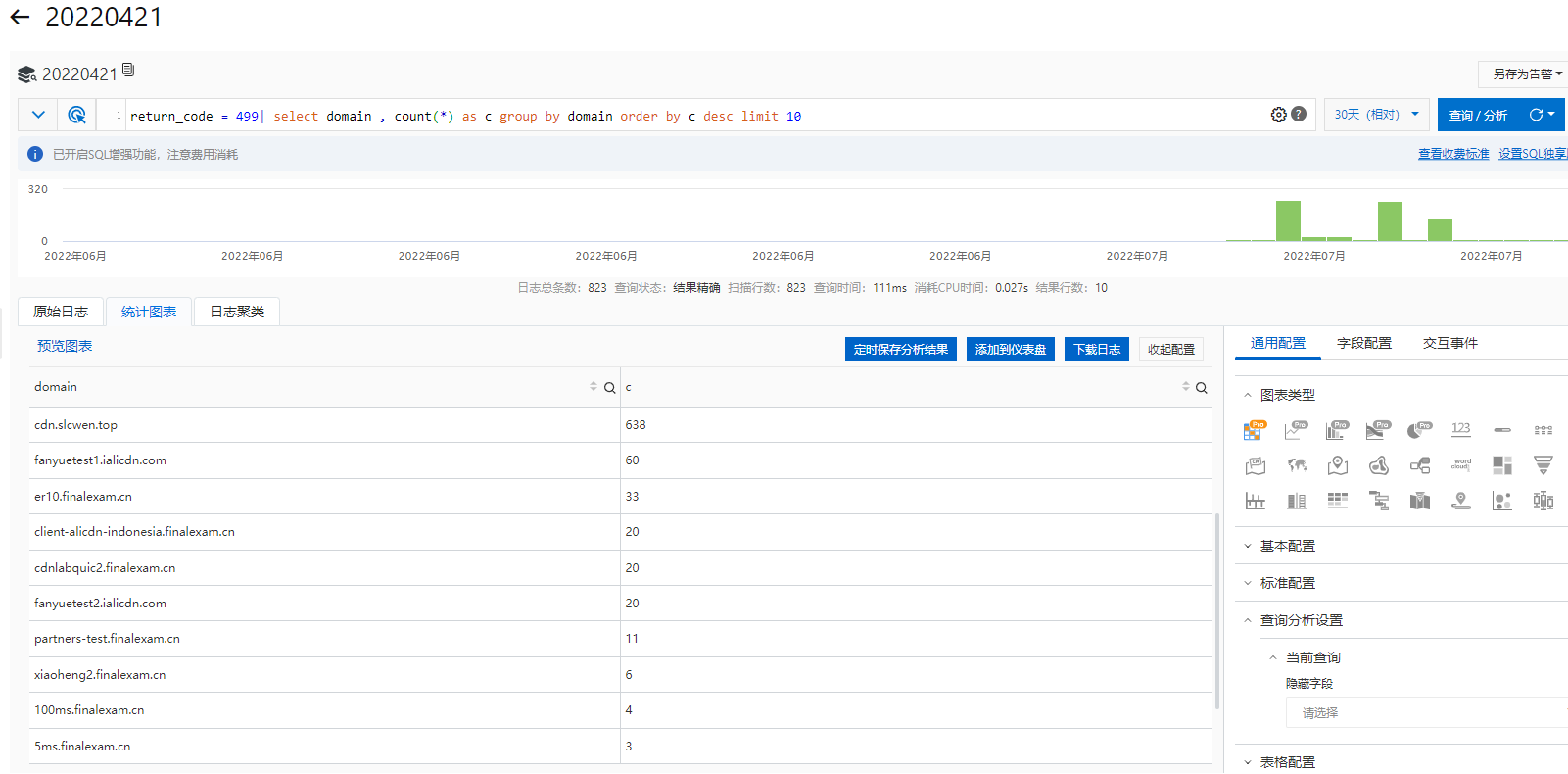

自訂報表

樣本1:查看最近30天內,響應狀態代碼為499的網域名稱熱門排行榜。

日誌分析語句:

return_code = 499| select domain , count(*) as c group by domain order by c desc limit 10

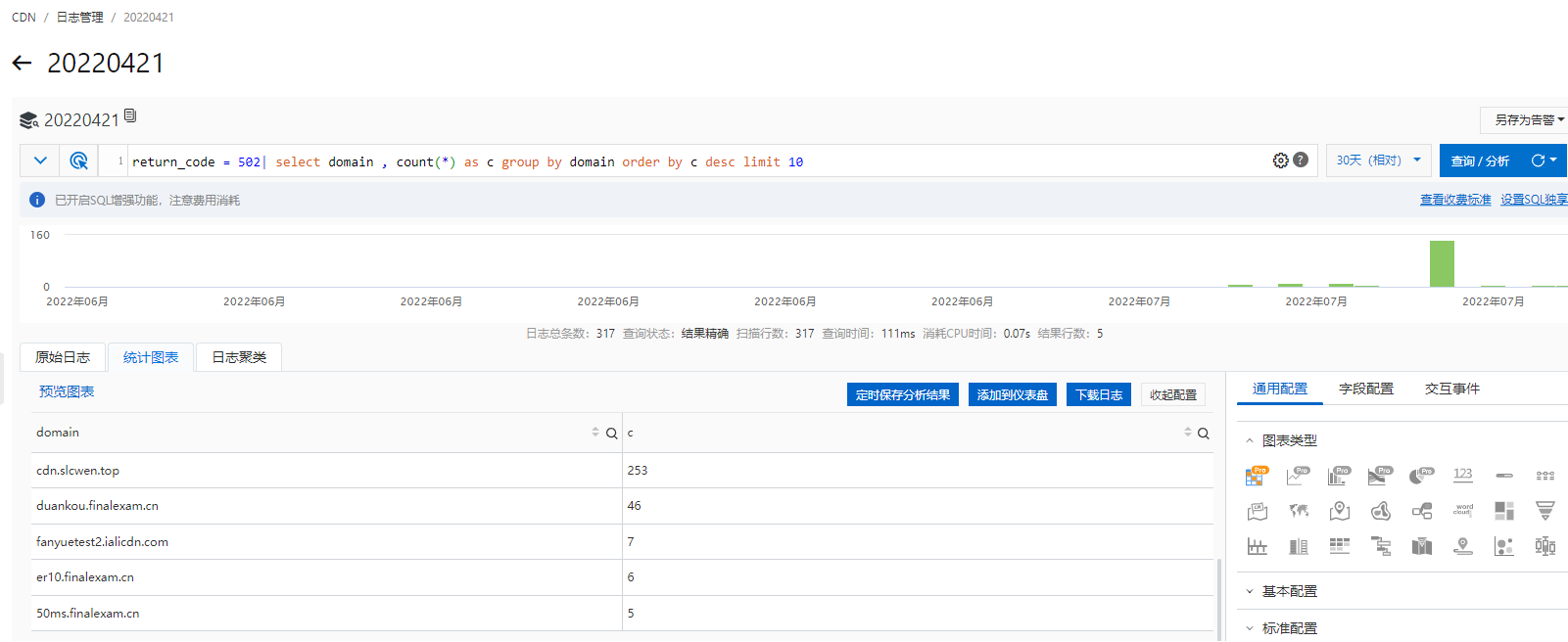

樣本2:查看最近30天內,響應狀態代碼為502的網域名稱熱門排行榜。

日誌分析語句:

return_code = 502| select domain , count(*) as c group by domain order by c desc limit 10

樣本3:查看最近30天內,訪問URI為/cpu的日誌資料。

可以直接單擊左側原始日誌欄的URI欄位,然後單擊/cpu即可過濾出需要的日誌。