DataWorks提供與CDH(Cloudera’s Distribution Including Apache Hadoop,以下簡稱CDH) 和CDP(Cloudera Data Platform,以下簡稱CDP)叢集對接的能力,您可在DataWorks中註冊CDH及CDP叢集,進行任務開發、調度、資料地圖(中繼資料管理)和資料品質等一系列的資料開發和治理操作。

背景資訊

CDH是Cloudera的開源平台發行版,提供開箱即用的叢集管理、叢集監控、叢集診斷等功能,並支援使用多種組件,助力您執行端到端的巨量資料工作流程。

CDP是跨平台收集和整合客戶資料的公用資料平台,可協助您收集即時資料,並將其構建為單獨的使用者資料使用。

您可在DataWorks中註冊CDH及CDP叢集,基於業務需求進行相關任務開發、調度、資料地圖(中繼資料管理)和資料品質等一系列的資料開發和治理操作。

前提條件

當前工作空間下,擁有以下任意權限原則或角色的使用者可註冊CDH或CDP叢集:

阿里雲主帳號。

擁有DataWorks空間管理員角色的工作空間成員。授權詳情請參見增加空間成員並管理成員角色許可權。

擁有AliyunDataWorksFullAccess權限原則的使用者,且該使用者為DataWorks工作空間成員。授權權限原則,詳情請參見RAM使用者授權、RAM角色授權;添加使用者為工作空間成員,詳情請參見增加空間成員並管理成員角色許可權。

已完成CDH或CDP叢集的相關部署,並擷取註冊叢集所需的配置資訊。詳情請參見準備工作:擷取CDH或CDP叢集資訊並配置網路連通。

使用限制

僅支援使用新版Serverless資源群組(推薦)或舊版獨享調度資源群組運行CDH或CDP叢集任務。

說明Serverless資源群組為通用型資源群組,可滿足多種任務類型(例如,資料同步、任務調度)的情境應用,購買詳情請參見使用Serverless資源群組;若您已購買過舊版獨享調度資源群組,也可使用該資源群組運行CDH或CD任務,詳情請參見使用獨享調度資源群組。

新使用者僅支援購買新版Serverless資源群組。

若使用自訂版本叢集註冊至DataWorks,僅支援使用舊版獨享調度資源群組。叢集版本介紹,請參見步驟二:註冊CDH或CDP叢集。

僅支援華北2(北京)、華東2(上海)、華東1(杭州)、華南1(深圳)、華北3(張家口)、西南1(成都)、德國(法蘭克福)地區註冊CDH或CDP叢集。

步驟一:進入叢集註冊頁面

進入管理中心頁面。

登入DataWorks控制台,切換至目標地區後,單擊左側導覽列的,在下拉框中選擇對應工作空間後單擊進入管理中心。

在左側導覽列單擊叢集管理進入叢集管理頁面,單擊註冊叢集,選擇開源叢集類型為CDH,進入叢集註冊頁面。

步驟二:註冊CDH或CDP叢集

標準模式工作空間,需分別註冊開發環境叢集和生產環境叢集。工作空間模式介紹,詳情請參見工作空間模式區別。

CDP與CDH基於DataWorks的開發操作基本一致,本文以CDH為例,為您介紹在DataWorks如何註冊CDH叢集。

配置叢集基本資料。

參數

描述

叢集顯示名稱

定義叢集在DataWorks的名稱,名稱必須唯一。

叢集版本

選擇註冊的叢集版本。

DataWorks提供的CDH 5.16.2、CDH 6.1.1、CDH 6.2.1、CDH 6.3.2、CDP 7.1.7版本您可直接選擇,該類叢集版本配套的組件版本(即叢集串連資訊中各組件的版本)固定。若該類叢集版本不滿足您的業務需要,您可選擇自訂版本,並按需配置組件版本。

說明不同叢集版本需配置的組件存在差異,具體請以實際介面為準。

使用自訂版本叢集註冊至DataWorks,僅支援使用舊版獨享調度資源群組,且註冊完成後需提交工單聯絡技術支援人員初始化相關環境。

叢集名稱

用於確定當前所註冊叢集的配置資訊來源。可選擇其他工作空間登入的叢集或建立叢集:

登入叢集:當前所註冊叢集的配置資訊,直接引用其他工作空間登入叢集的配置資訊。

建立叢集:當前註冊叢集的配置資訊需您自行配置。

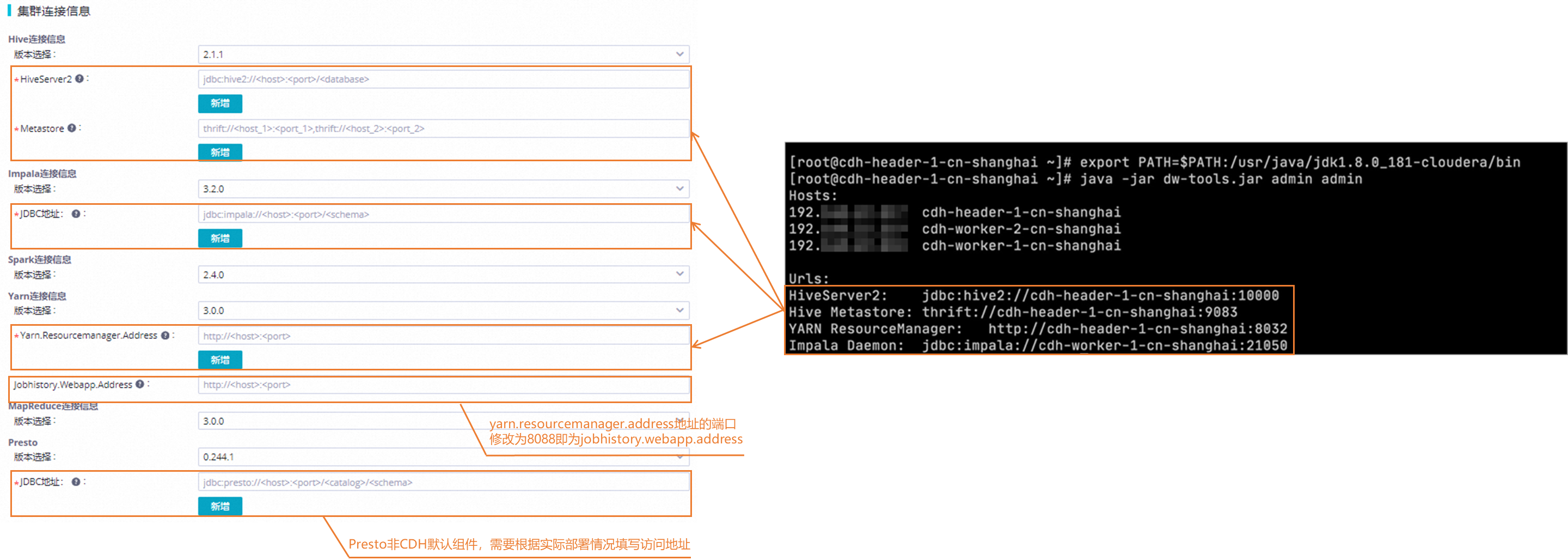

配置叢集串連資訊。

根據實際使用方式選擇對應叢集的組件版本,並輸入擷取到的組件地址資訊。擷取組件資訊,詳情請參見準備工作:擷取CDH或CDP叢集資訊並配置網路連通。

說明

說明如果在Serverless資源群組通過網域名稱訪問CDH相關組件,則需要在Alibaba Cloud DNS的內網DNS解析 (PrivateZone)中對CDH組件網域名稱進行權威解析。詳情可參見添加內建權威網域名稱、設定網域名稱生效範圍。

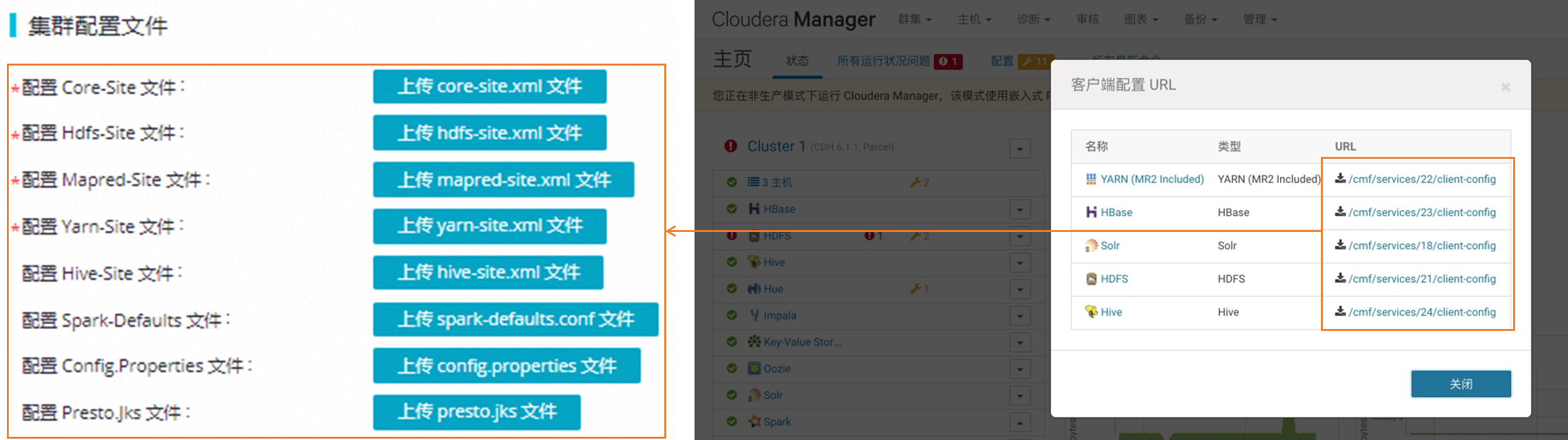

添加叢集設定檔。

您可根據需要上傳所需組件的設定檔。擷取設定檔,詳情請參見準備工作:擷取CDH或CDP叢集資訊並配置網路連通。

設定檔介紹如下。

設定檔

描述

應用情境

core-site.xml

包含Hadoop Core庫的全域配置。例如,HDFS和MapReduce常用的I/O設定。

運行Spark或MapReduce任務,需上傳該檔案。

hdfs-site.xml

包含HDFS的相關配置。例如,資料區塊大小、備份數量、路徑名稱等。

mapred-site.xml

用於配置MapReduce相關的參數。例如,配置MapReduce作業的執行方式和調度行為。

運行MapReduce任務,需上傳該檔案。

yarn-site.xml

包含了與YARN守護進程相關的所有配置。例如,資源管理員、節點管理器和應用程式運行時的環境配置。

運行Spark或MapReduce任務,或帳號映射類型選擇Kerberos時,需上傳該檔案。

hive-site.xml

包含了用於配置Hive的各項參數。例如,資料庫連接資訊、Hive Metastore的設定和執行引擎等。

帳號映射類型選擇Kerberos時,需上傳該檔案。

spark-defaults.conf

用於指定Spark作業執行時應用的預設配置。您可通過

spark-defaults.conf檔案預先設定一系列參數(例如,記憶體大小、CPU核心數),Spark應用程式在運行時將採用該參數配置。運行Spark任務,需上傳該檔案。

config.properties

包含Presto伺服器的相關配置。例如,設定Presto叢集中協調器節點和工作節點的全域屬性。

使用Presto組件,且帳號映射類型選擇OPEN LDAP或Kerberos時,需上傳該檔案。

presto.jks

用於儲存安全性憑證,包括私密金鑰和頒發給應用程式的密鑰憑證。在Presto資料庫查詢引擎中,

presto.jks檔案用於為Presto進程啟用SSL/TLS加密通訊,確保資料轉送的安全。配置叢集預設訪問身份。

用於配置在DataWorks運行CDH叢集任務時,使用什麼帳號訪問CDH叢集,不同環境支援使用的帳號存在差異,具體如下。

說明當註冊叢集時,預設訪問身份配置為非叢集帳號,若該帳號未設定帳號映射或設定的映射類型選擇無認證方式,則任務均會執行失敗。

環境

預設訪問身份

相關文檔

開發環境

叢集帳號:無論誰在DataWorks運行CDH任務(例如,阿里雲主帳號、只擁有開發許可權的子帳號),實際統一使用指定叢集帳號訪問CDH叢集。

映射帳號:使用任務執行者運行CDH任務時,需配置任務執行者帳號與叢集帳號的映射關係,配置後,運行任務時實際使用該映射帳號訪問CDH叢集。

配置帳號映射關係,詳情請參見設定叢集身份映射。

生產環境

叢集帳號:無論誰在DataWorks運行CDH任務(例如,阿里雲主帳號、只擁有開發許可權的子帳號),實際統一使用指定叢集帳號訪問CDH叢集。

映射帳號:使用任務責任人、阿里雲主帳號、阿里雲子帳號運行CDH任務時,需配置相應帳號與叢集帳號的映射關係,配置後,運行任務時實際使用該映射帳號訪問CDH叢集。

單擊完成註冊,即成功在DataWorks中註冊叢集。

步驟三:資源群組初始化

初次綁定叢集、叢集服務配置變更或組件版本升級(例如:修改core-site.xml)請初始化資源群組,確保資源群組可正常訪問CDH叢集,資源群組當前環境配置可正常執行CDH叢集任務。在叢集管理頁面,找到登入的CDH叢集,單擊右上方的資源群組初始化,選擇所需資源群組並進行初始化操作。

DataWorks僅支援使用新版Serverless資源群組(推薦)與獨享調度資源群組運行CDH叢集任務,因此,此處僅支援選擇這兩類資源群組進行初始化操作。若無可用資源群組,請根據需要建立,詳情請參見使用Serverless資源群組、使用獨享調度資源群組。

使用自訂版本叢集註冊至DataWorks,僅支援使用舊版獨享調度資源群組,且註冊完成後需提交工單聯絡技術支援人員初始化相關環境。

(可選)設定YARN資源隊列

YARN資源隊列的核心目的就是對叢集資源進行劃分和隔離,確保不同類型的任務能夠合理、公平地使用計算資源,避免互相干擾。若需為不同模組的任務設定專有的YARN資源隊列,您可在叢集管理列表頁找到您所綁定的CDH叢集,在YARN 資源隊列頁簽單擊編輯YARN 資源隊列進行設定。

(可選)設定SPARK參數

在不同模組為任務設定專有的SPARK屬性參數。

在叢集管理列表頁找到您所綁定的CDH叢集。

單擊SPARK 參數頁簽的編輯SPARK 參數按鈕,進入編輯CDH叢集的SPARK參數頁。

通過單擊模組下方的添加按鈕,輸入Spark屬性名稱和對應的Spark屬性值,設定Spark屬性資訊。