Platform for AI (PAI) のElastic Algorithm service (EAS) を使用してサービスをデプロイした後、[サービスモニタリング] タブでサービス関連のメトリックを表示して、サービスへの呼び出しとサービスの実行ステータスを確認できます。 このトピックでは、サービスモニタリング指標とサービスモニタリング情報の表示方法について説明します。

前提条件

モデルサービスがデプロイされます。 詳細については、「PAIコンソールでのモデルサービスのデプロイ」をご参照ください。

サービス監視情報の表示

Elastic Algorithm Service (EAS)ページに移動します。

PAIコンソールにログインします。

左側のナビゲーションウィンドウで、[ワークスペース] をクリックします。 [ワークスペース] ページで、管理するワークスペースの名前をクリックします。

左側のナビゲーションウィンドウで、 を選択します。 Elastic Algorithm Service (EAS) ページが表示されます。

管理するサービスを検索し、

のアイコンサービスモニタリングに移動する列サービスモニタリングタブをクリックします。

のアイコンサービスモニタリングに移動する列サービスモニタリングタブをクリックします。 サービスの監視情報を表示します。

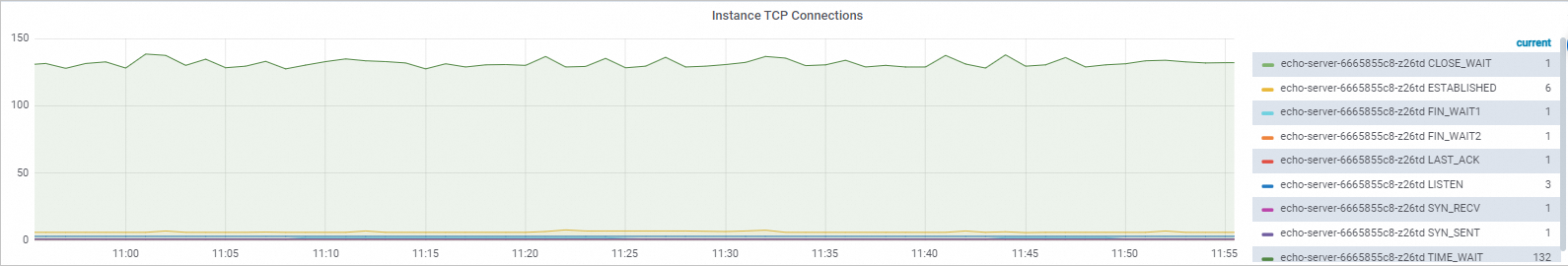

ダッシュボードを切り替えます。

サービス名: 分レベルのダッシュボード。分単位の正確な最も一般的なメトリックが含まれています。 デフォルトでは、このダッシュボードが表示されます。

サービス名 (fine): 第2レベルのダッシュボード。

サービス名 (per): インスタンスごとの分レベルのダッシュボード。

サービスをデプロイすると、次のダッシュボードが作成されます。

説明サービス名は、管理するサービスの名前です。

サービス名の右側にある

アイコンをクリックして、ダッシュボードを切り替えて関連するメトリックを表示します。 メトリクスの詳細については、このトピックの「メトリクス」をご参照ください。

アイコンをクリックして、ダッシュボードを切り替えて関連するメトリックを表示します。 メトリクスの詳細については、このトピックの「メトリクス」をご参照ください。

時間範囲を切り替えます。

[モニタリング情報] セクションの右上隅にあるをクリックし

て、時間範囲を切り替えます。

て、時間範囲を切り替えます。  重要

重要分レベルのメトリクスは最大1か月間保持でき、第2レベルのメトリクスは最大1時間保持できます。

メトリクス

分レベルのダッシュボード

このダッシュボードでは、次のメトリックを表示できます。

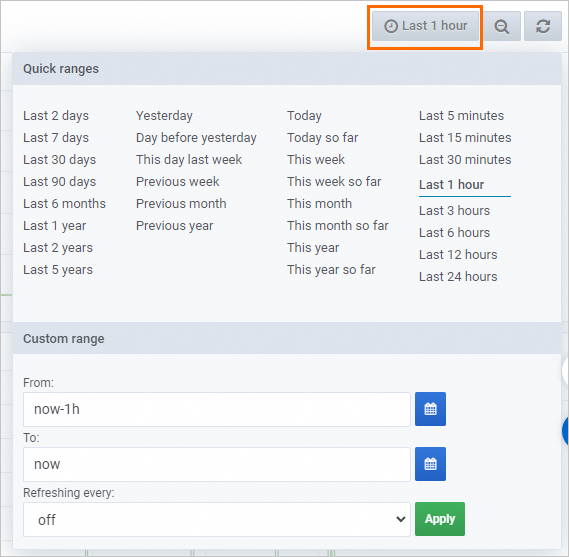

QPS 1秒あたりのクエリ数 (QPS) は、1秒あたりにサービスに送信されるリクエストの数を示します。 サービスに複数のインスタンスが含まれている場合、このメトリックはサービスのすべてのインスタンスに送信されたリクエストの数を示します。 リクエストの数は、レスポンスコードによって個別に計算されます。 | レスポンス 応答は、特定の時間範囲内にサービスに送信された要求の数を示します。 リクエストの数は、レスポンスコードによって個別に計算されます。 サービスに複数のインスタンスが含まれている場合、このメトリックはサービスのすべてのインスタンスに送信されたリクエストの数を示します。 |

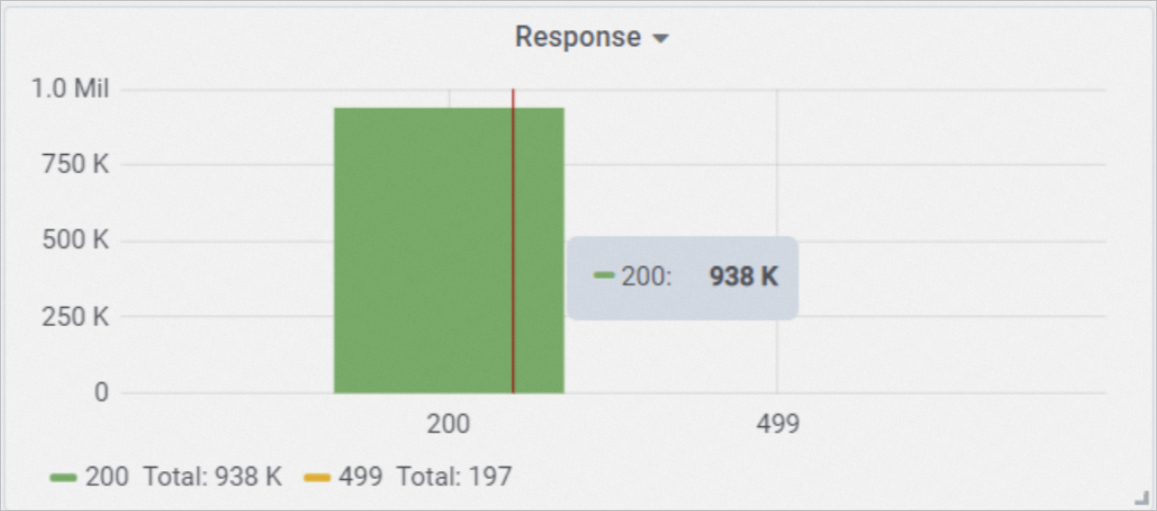

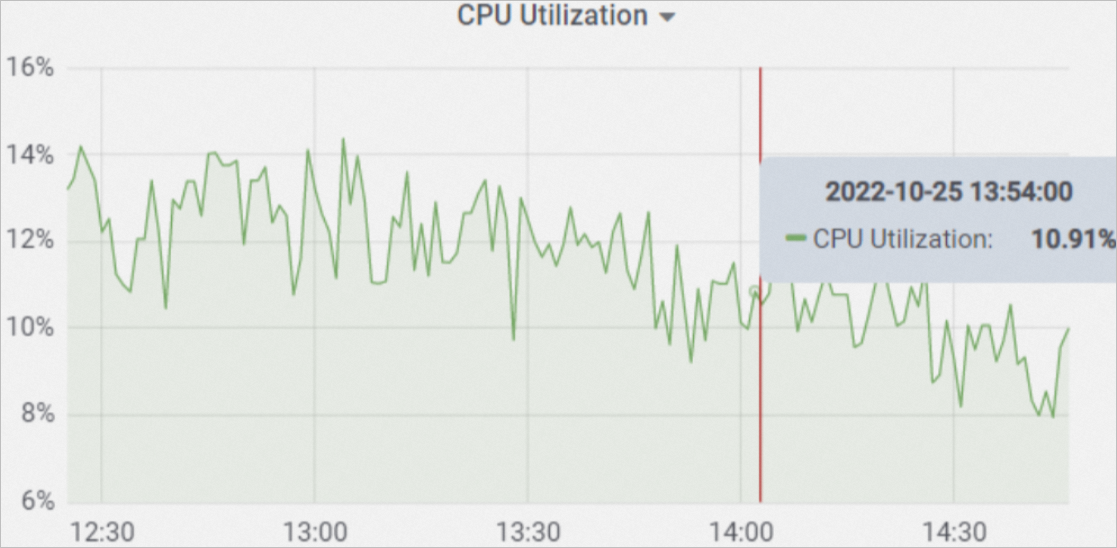

CPU CPUは、特定の時点でサービスによって使用されているCPUコアの平均数を示します。 単位: コア。 サービスに複数のインスタンスが含まれている場合、このメトリックはサービスのすべてのインスタンスで使用されているCPUコアの平均数を示します。 | CPU 使用率 CPU使用率は、特定の時点でのサービスの平均CPU使用率を示します。 計算式: CPU使用率=平均使用CPUコア数 /最大CPUコア数。 サービスに複数のインスタンスが含まれている場合、このメトリックはサービスのすべてのインスタンスの平均CPU使用率を示します。 |

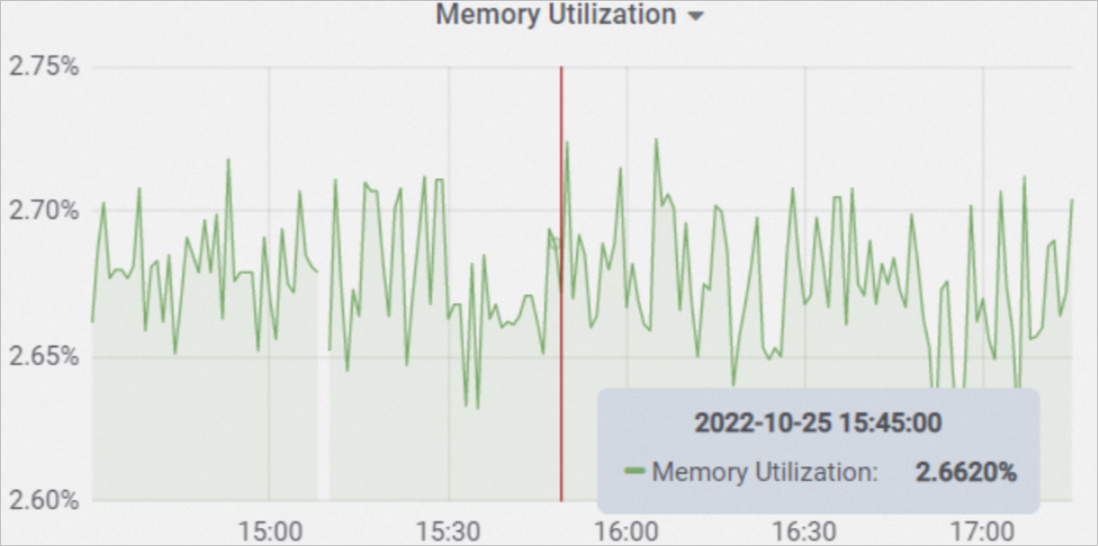

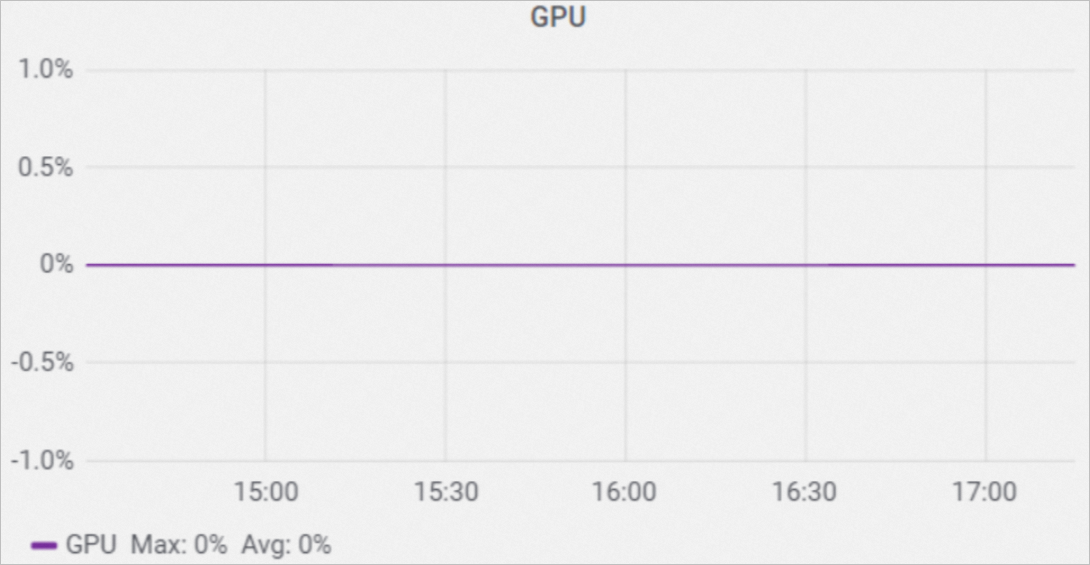

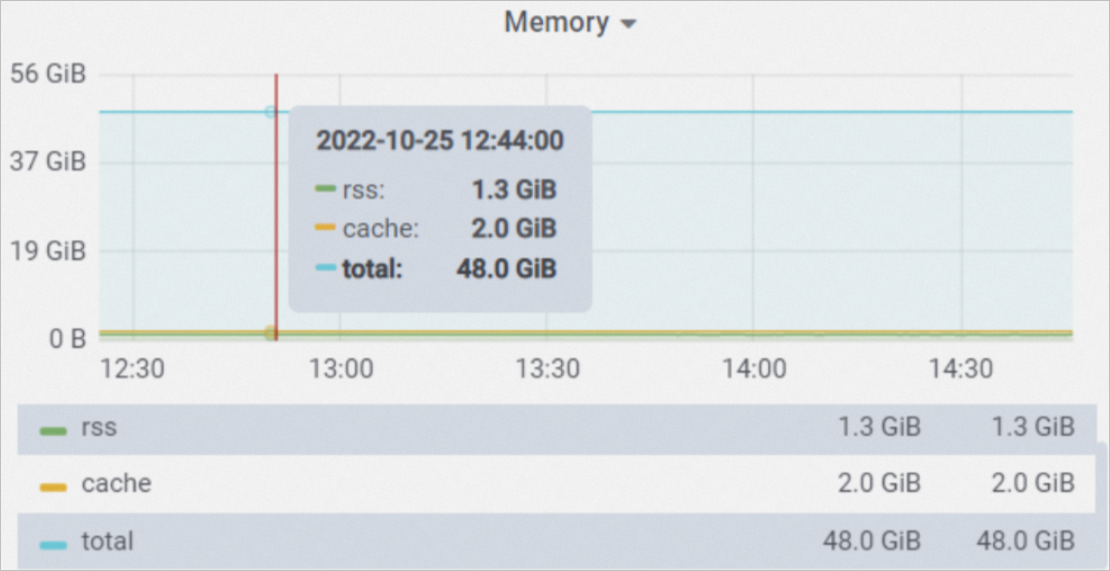

メモリ使用率 メモリ使用率は、特定の時点でのサービスの平均メモリ使用率を示します。 計算式: メモリ使用率= rss /total。 サービスに複数のインスタンスが含まれている場合、このメトリックはサービスのすべてのインスタンスの平均メモリ使用量を示します。 | GPU サービスがGPUリソースを使用する場合、このメトリックは特定の時点でのサービスの平均GPU使用率を示します。 サービスに複数のインスタンスが含まれている場合、このメトリックはサービスのすべてのインスタンスの平均GPU使用率を示します。 |

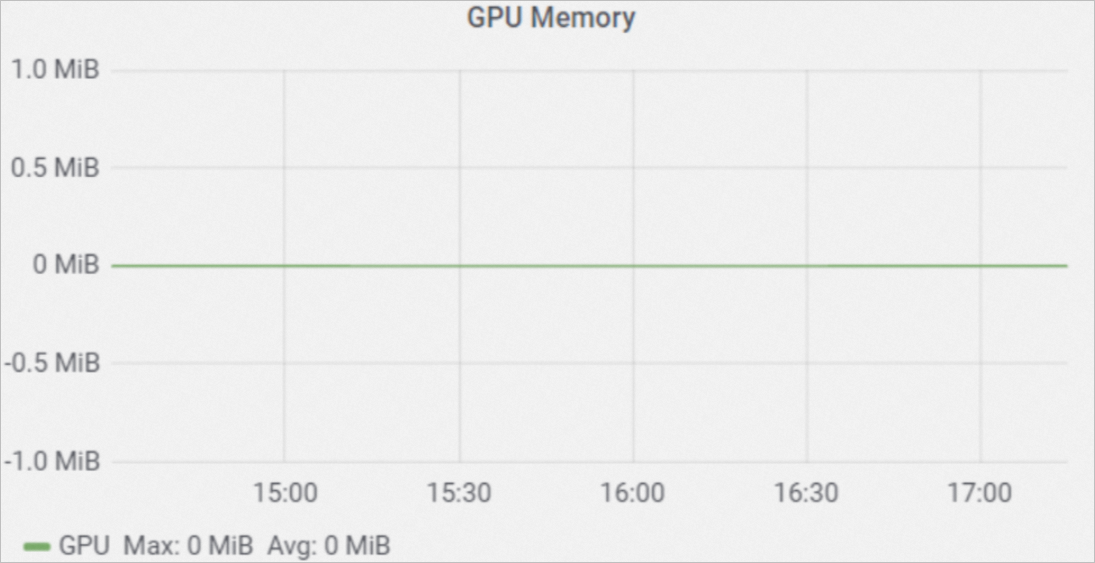

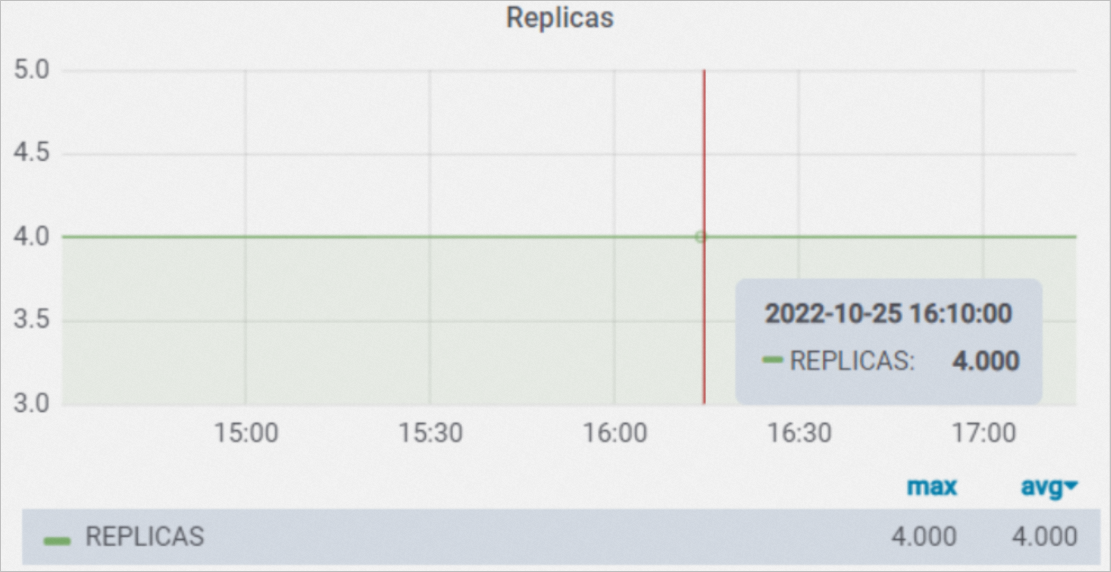

GPUメモリ サービスがGPUリソースを使用する場合、このメトリックは、特定の時点でサービスによって使用されたGPUメモリの量を示します。 サービスに複数のインスタンスが含まれている場合、このメトリックは、サービスのすべてのインスタンスで使用されているGPUメモリの平均量を示します。 | レプリカ レプリカは、特定の時点でサービスに含まれるインスタンスの数を示します。 |

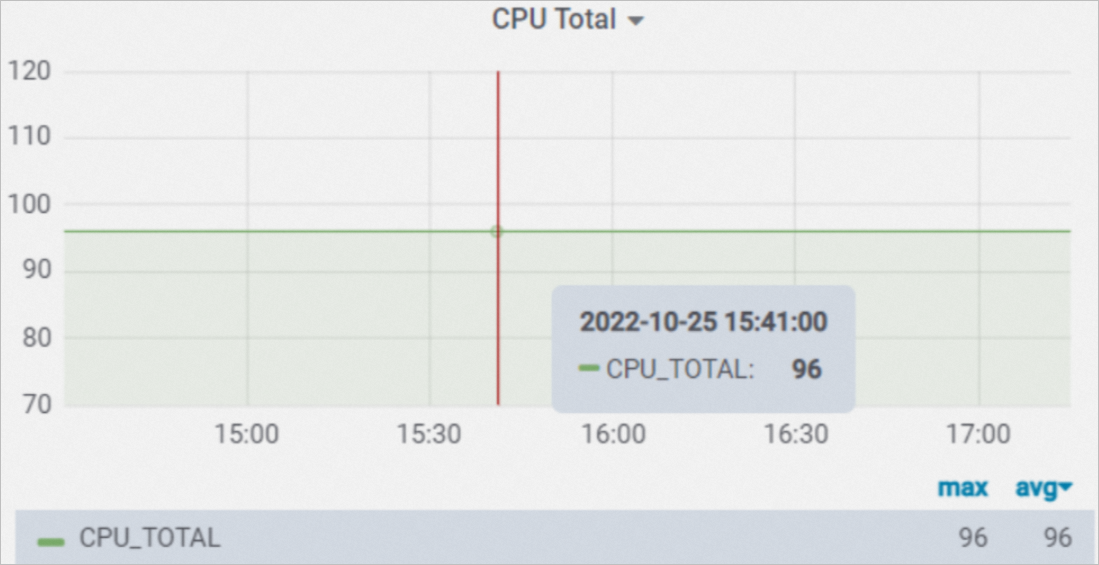

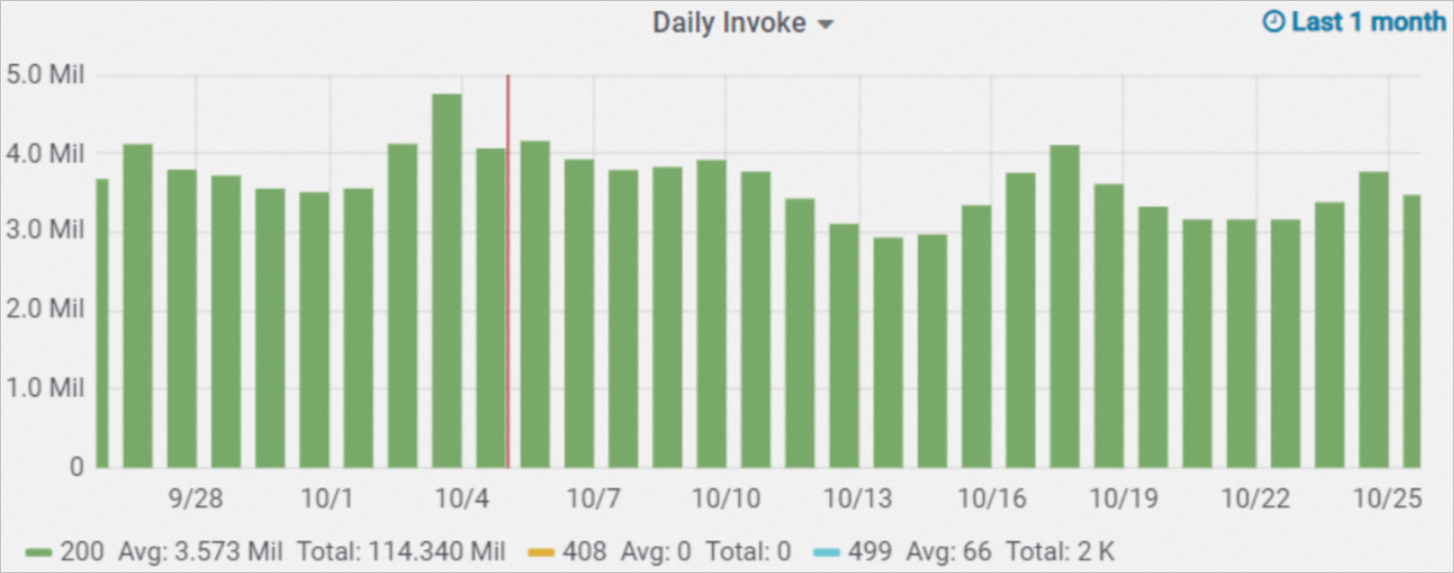

CPU合計 CPU Totalは、特定の時点でサービスで使用可能なCPUコアの総数を示します。 計算式: CPU Total=1つのインスタンスで使用可能なCPUコア数 × インスタンス数。 | 毎日の呼び出し Daily Invokeは、サービスへの呼び出しの数を示します。 呼び出しの数は、応答コードによって別々に計算されます。 |

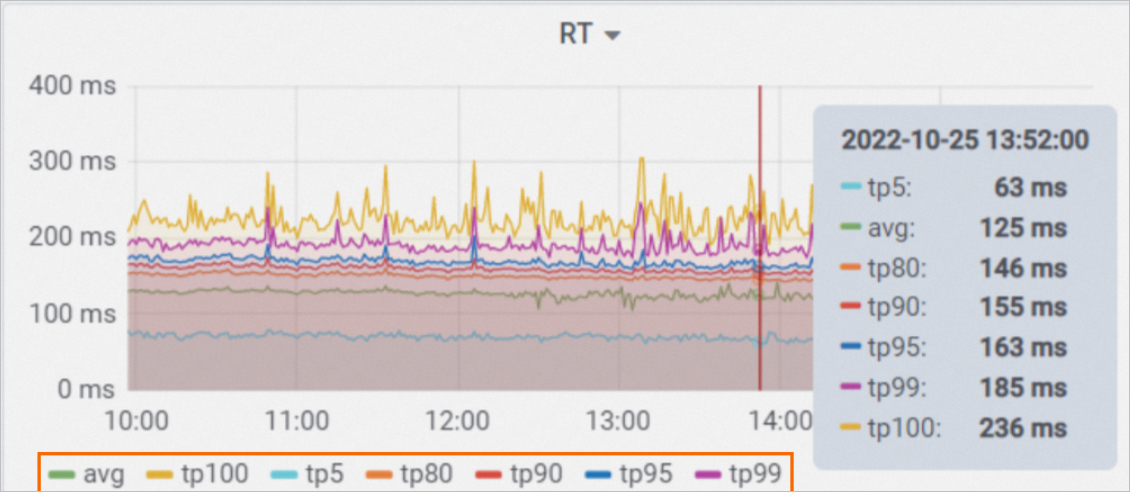

RT RTはリクエストの応答時間を示します。 サブメトリクス:

| メモリ メモリは、特定の時点でサービスによって使用されたメモリの平均量を示します。 サービスに複数のインスタンスが含まれている場合、このメトリックはサービスのすべてのインスタンスで使用されているメモリの平均量を示します。

|

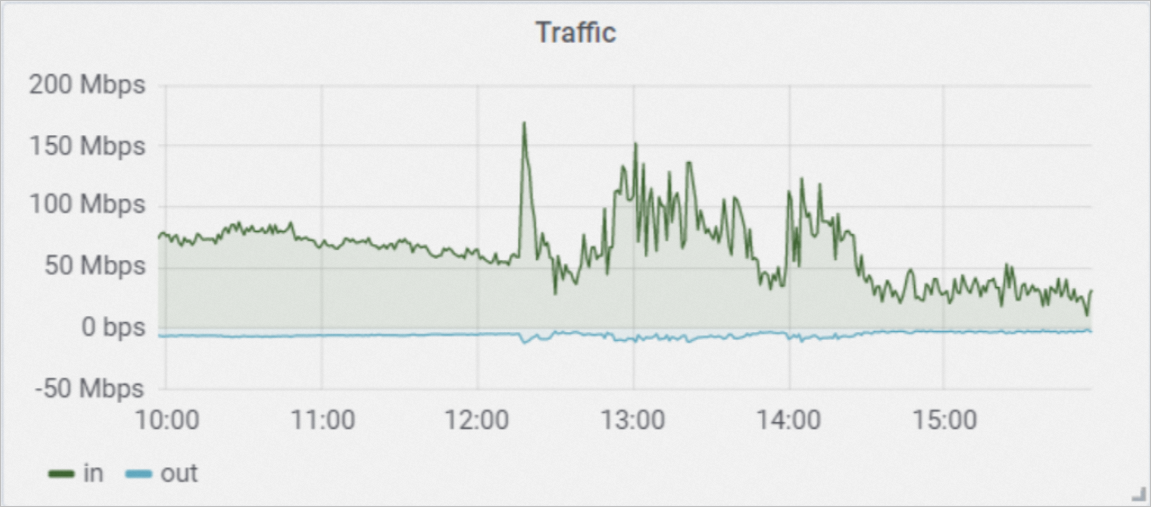

トラフィック トラフィックは、サービスによって1秒あたりに送受信されるデータの量を示します。 単位:bit/s。 サービスに複数のインスタンスが含まれている場合、このメトリックは、サービスのすべてのインスタンスが送受信するトラフィックの平均量を示します。 サブメトリクス:

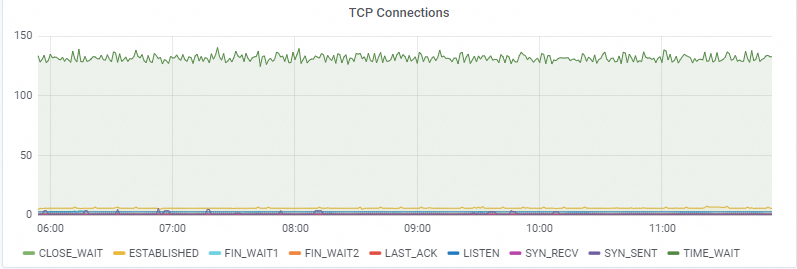

| TCP接続 TCP接続は、TCP接続の数を示します。

|

第2レベルのダッシュボード

このダッシュボードでは、次のメトリックを表示できます。

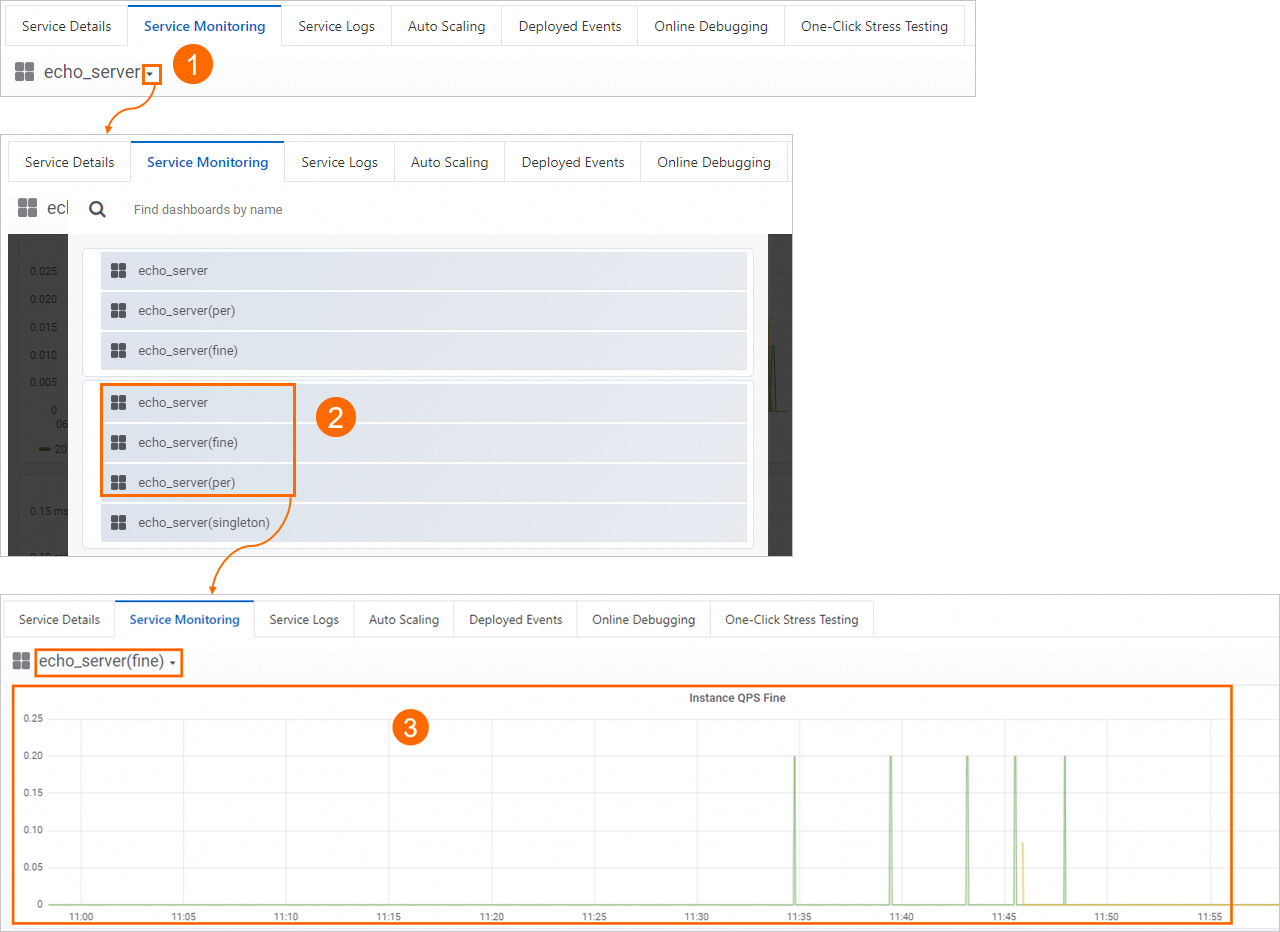

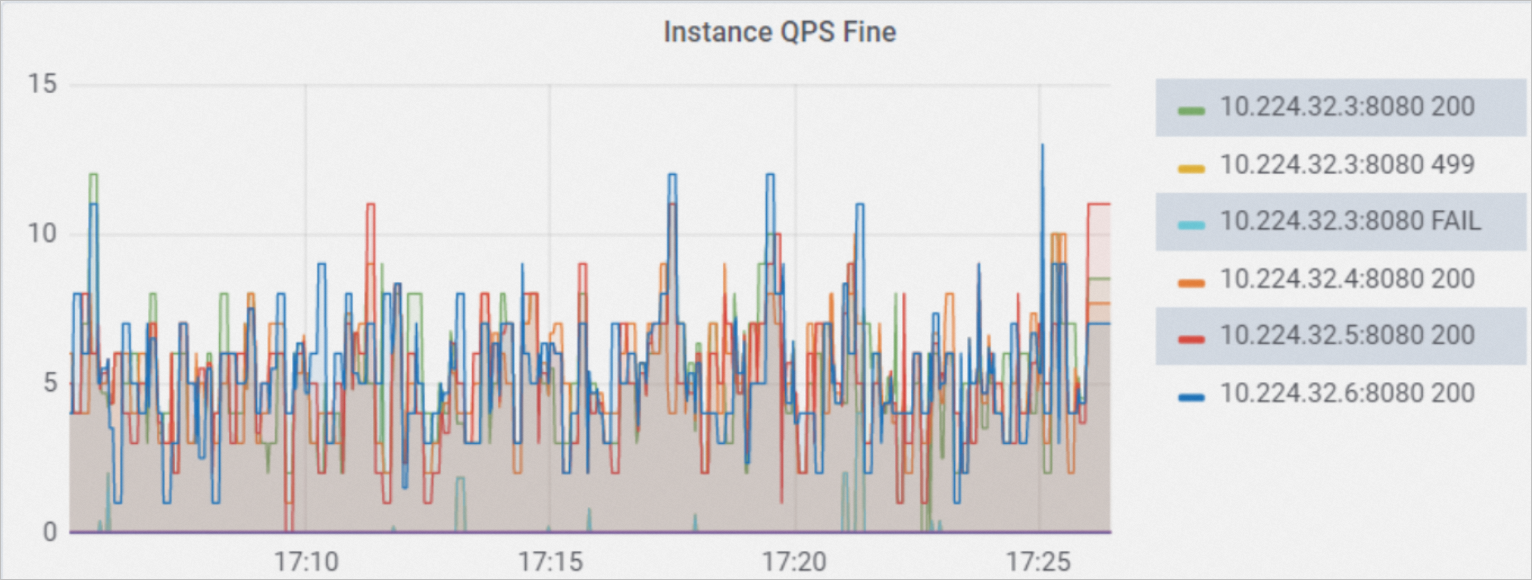

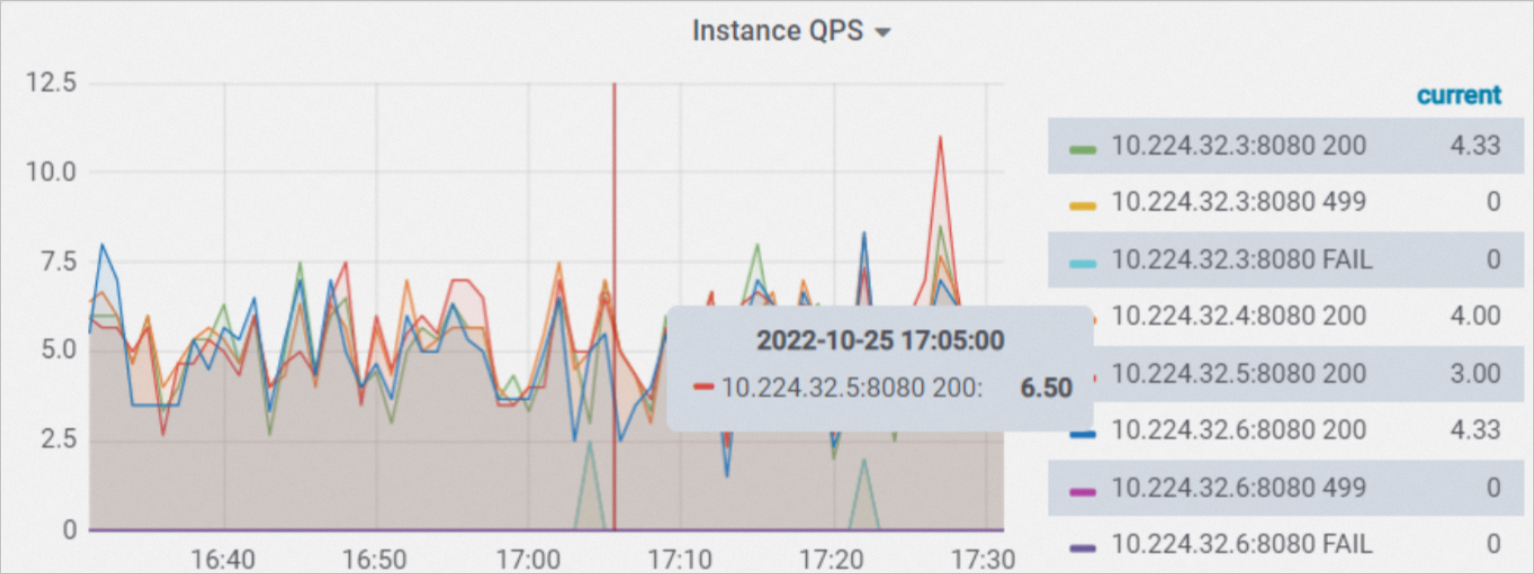

インスタンスQPSの詳細 インスタンスQPS Fineは、サービスの各インスタンスが1秒あたりに受信したリクエストの数を示します。 リクエストの数は、レスポンスコードによって個別に計算されます。 重要 データは5秒まで正確です。 最新の時間のデータのみが保持されます。

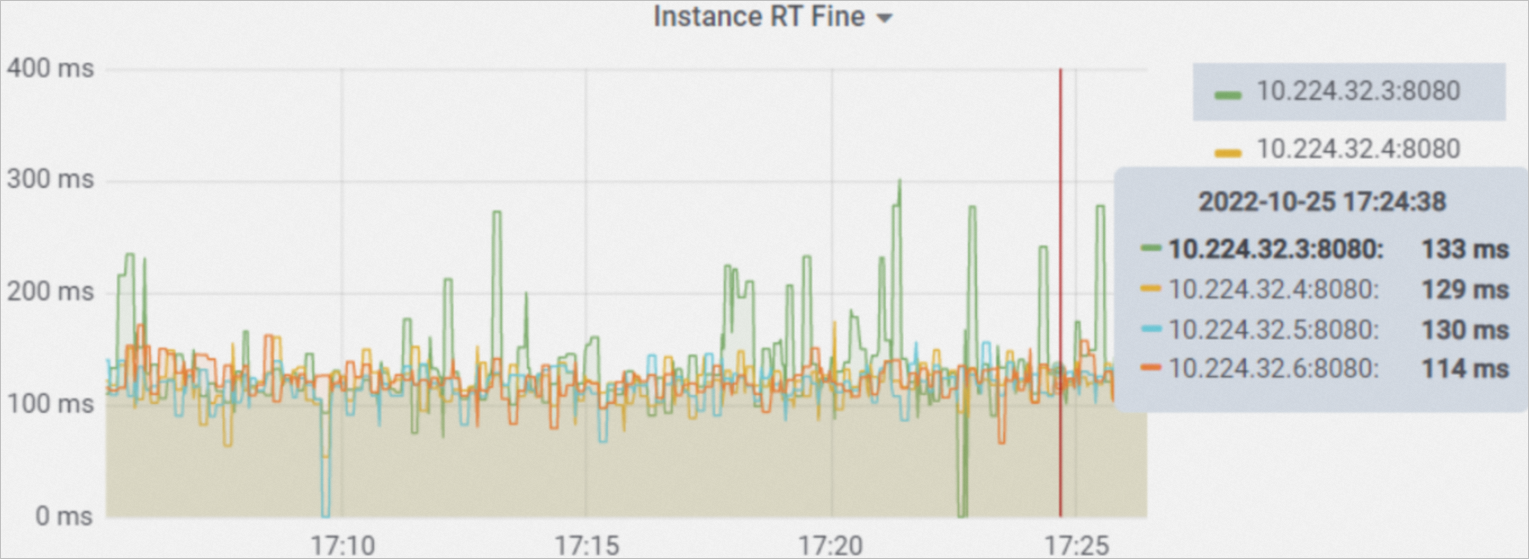

| インスタンスRT Fine インスタンスRT Fineは、サービスの各インスタンスが受信したリクエストの平均応答時間を示します。 重要 データは5秒まで正確です。 最新の時間のデータのみが保持されます。

|

インスタンスごとの分レベルのダッシュボード

このダッシュボードでは、次のメトリックを表示できます。

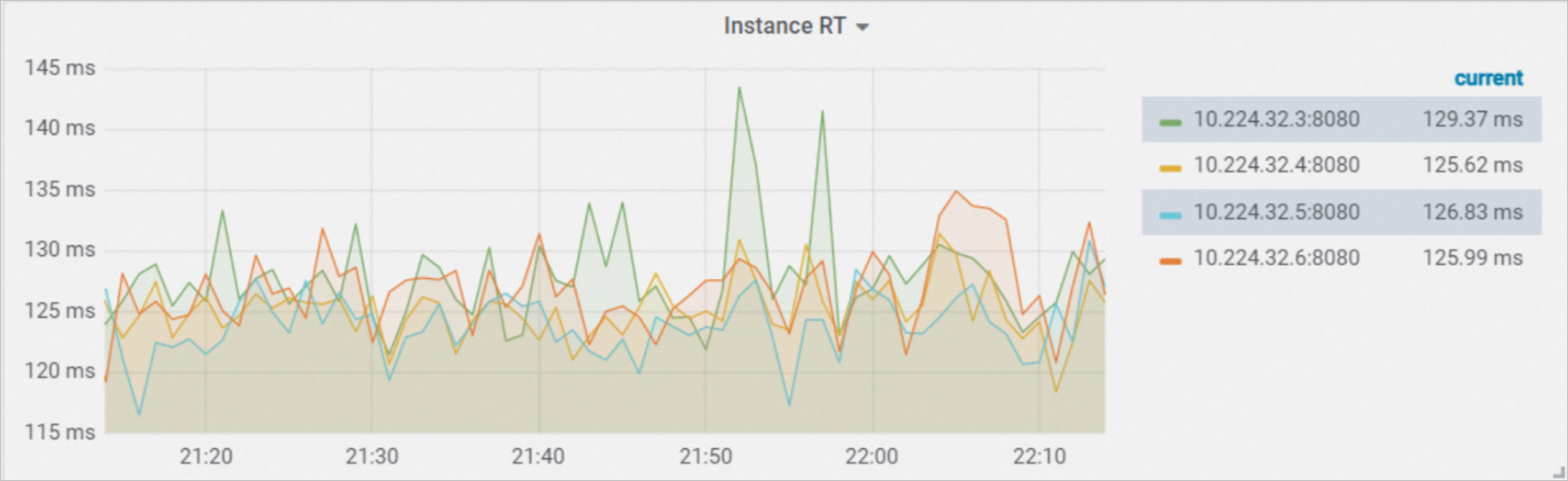

インスタンスQPS インスタンスQPSは、サービスの各インスタンスが1秒あたりに受信したリクエストの数を示します。 リクエストの数は、レスポンスコードによって個別に計算されます。 | インスタンスRT インスタンスRTは、サービスの各インスタンスの平均応答時間を示します。 |

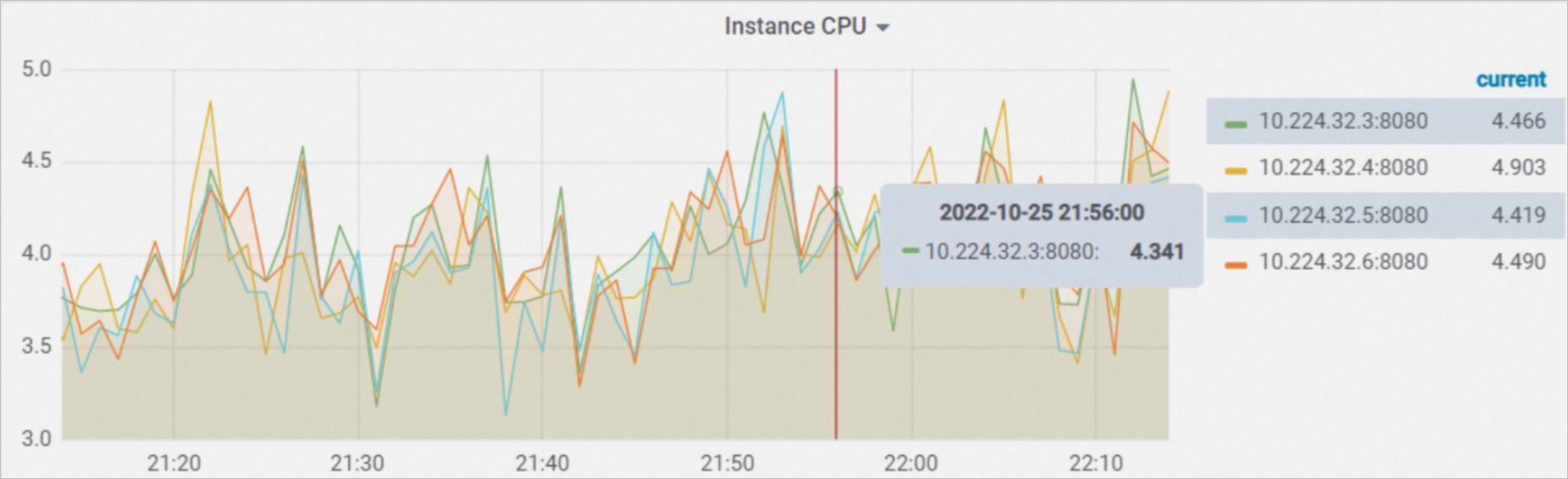

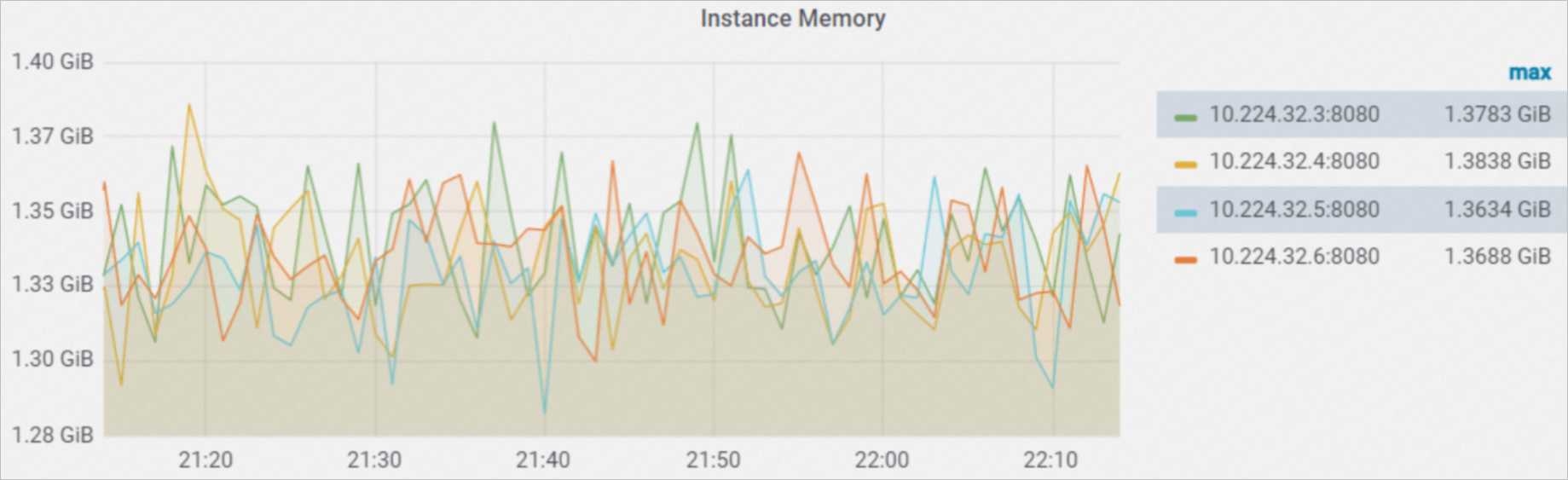

インスタンスCPU インスタンスCPUは、サービスの各インスタンスによって使用されるCPUコアの数を示します。 単位: コア。 | インスタンスメモリ インスタンスメモリは、サービスの各インスタンスによって使用されるメモリの量を示します。 |

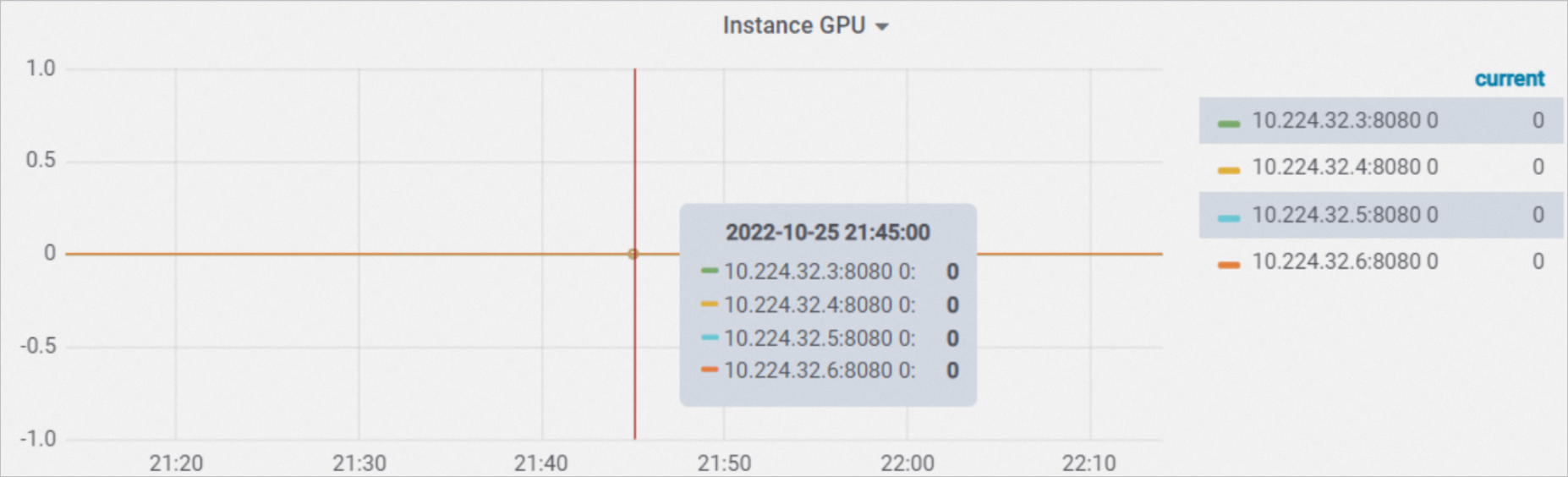

インスタンスGPU インスタンスGPUは、サービスの各インスタンスのGPU使用率を示します。 | インスタンスGPUメモリ インスタンスGPUメモリは、サービスの各インスタンスによって使用されるGPUメモリの量を示します。 |

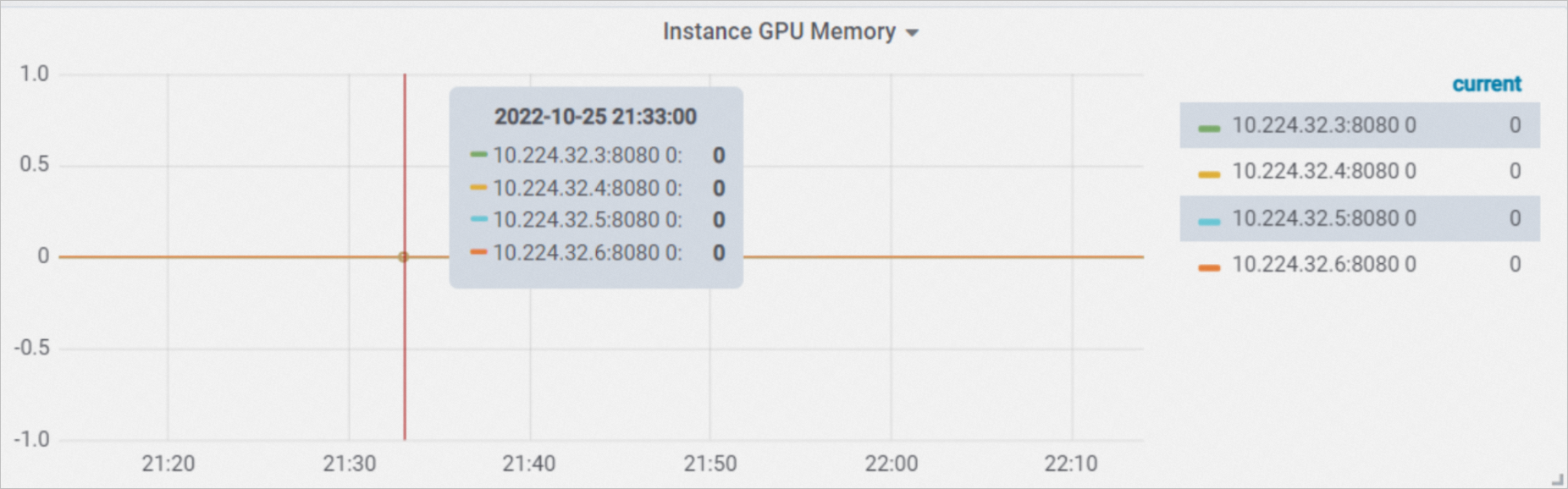

インスタンスTCP接続 インスタンスTCP接続は、1つのインスタンス上のTCP接続の数を示します。 |

参照

サービスの監視およびアラート機能を使用して、サービスのステータスを監視できます。 アラートルールで指定されたしきい値を超えた場合、アラート通知が送信されます。 詳細については、「サービスのモニタリングとアラートの有効化」をご参照ください。

CloudMonitorコンソールで、またはAPI操作を呼び出して、ServiceInstanceイベントの表示、イベントのO&Mまたは監査の実行、イベントのアラートルールの設定を行うことができます。 詳細については、「CloudMonitorでのServiceInstanceイベントの表示」をご参照ください。

ビジネス要件に基づいてカスタムモニタリングメトリックを設定し、カスタムメトリックに基づいてサービスの自動スケーリングを設定できます。 詳細については、「カスタムモニタリングおよびスケーリングメトリックの設定」をご参照ください。

サブメトリクス:

サブメトリクス:

各インスタンスのデータは、ip:portフィールドの値に基づいて識別できます。

各インスタンスのデータは、ip:portフィールドの値に基づいて識別できます。  各インスタンスのデータは、ip:portフィールドの値に基づいて識別できます。

各インスタンスのデータは、ip:portフィールドの値に基づいて識別できます。  各インスタンスのデータは、ip:portフィールドの値に基づいて識別できます。

各インスタンスのデータは、ip:portフィールドの値に基づいて識別できます。  各インスタンスのデータは、ip:portフィールドの値に基づいて識別できます。

各インスタンスのデータは、ip:portフィールドの値に基づいて識別できます。  各インスタンスのデータは、ip:portフィールドの値に基づいて識別できます。

各インスタンスのデータは、ip:portフィールドの値に基づいて識別できます。  各インスタンスのデータは、ip:portフィールドの値に基づいて識別できます。

各インスタンスのデータは、ip:portフィールドの値に基づいて識別できます。