Elastic Algorithm Service (EAS) は、EasyRec または TensorFlow でトレーニングされた推薦モデルをスコアリングサービスとしてデプロイする、組み込みの EasyRec プロセッサを提供します。このプロセッサは、特徴量エンジニアリング機能を統合し、特徴量エンジニアリングと TensorFlow モデルの両方を最適化して、パフォーマンス専有型のスコアリングを実現します。

背景情報

EasyRec プロセッサは、PAI EAS プロセッサ仕様に基づいて構築された推論サービスです。詳細については、「C または C++ を使用したカスタムプロセッサの開発」をご参照ください。以下の 2 つのシナリオをサポートしています。

特徴量生成の概要と設定 (FG) と EasyRec でトレーニングされたディープラーニングモデル。プロセッサはアイテム特徴量をメモリにキャッシュし、特徴量変換と推論を最適化してスコアリングのパフォーマンスを向上させます。FeatureStore を使用して、オンラインおよびリアルタイムの特徴量を管理できます。このソリューションは、PAI-Rec 推薦システム開発プラットフォームと統合されており、トレーニング、特徴量の変更、推論の最適化を連携させます。PAI-Rec DPI エンジンと組み合わせることで、モデルのデプロイとオンラインサービスの迅速な統合が可能になります。

EasyRec または TensorFlow でトレーニングされたモデル。Feature Generator は不要です。

EasyRec プロセッサに基づく推薦エンジンのアーキテクチャ:

EasyRec プロセッサには、以下のモジュールが含まれています。

アイテム特徴量キャッシュ:FeatureStore の特徴量をメモリにキャッシュし、ネットワークのオーバーヘッドと FeatureStore の負荷を軽減します。増分およびリアルタイムの特徴量更新をサポートします。

Feature Generator:特徴量エンジニアリングモジュール (FG) は、Taobao の特徴量エンジニアリングソリューションに基づき、オフラインとオンラインの特徴量処理の一貫性を保証します。

TFModel:EasyRec によってエクスポートされた Saved_Model ファイルをロードし、Blade を使用して CPU および GPU での推論を最適化します。

特徴量イベントトラッキングおよび増分モデル更新モジュール:リアルタイムトレーニングシナリオで使用されます。詳細については、「リアルタイムトレーニング」をご参照ください。

制限事項

CPU 推論は、Intel CPU を使用する汎用インスタンスファミリー g6、g7、および g8 でのみサポートされています。

GPU 推論は、T4、A10、GU30、L20、3090、4090 などの GPU タイプでサポートされています。P100 はサポートされていません。

詳細については、「汎用 (g シリーズ)」をご参照ください。

バージョンリスト

EasyRec プロセッサは活発に開発が進められています。より良い機能と推論パフォーマンスを得るために、最新バージョンを使用してください。リリース済みのバージョン:

ステップ 1:サービスのデプロイ

eascmd クライアントを使用して EasyRec モデルサービスをデプロイするには、プロセッサタイプを easyrec-{version} に設定します。詳細については、「サービスのデプロイ:EASCMD」をご参照ください。以下に設定例を示します。

新しい FG ライブラリを使用する例 (fg_mode=normal)

この例では、デプロイに PyOdps3 ノードタイプを使用します。このモードは、組み込みの特徴量変換オペレーターとカスタム FG オペレーターを備えた新しい FeatureGenerator をサポートします。複雑な入力タイプ (配列とマップ) および有向非巡回グラフ (DAG) モードでの特徴量依存関係をサポートします。

この例では、PAI-FeatureStore を使用して特徴量データを管理します。スクリプトでは、${fs_project},${fs_model} 変数を実際の値に置き換える必要があります。詳細については、「ステップ 2:EAS モデルサービスの作成とデプロイ」をご参照ください。

import json

import os

service_name = 'ali_rec_rnk_with_fg'

config = {

'name': service_name,

'metadata': {

"cpu": 8,

#"cuda": "11.2",

"gateway": "default",

"gpu": 0,

"memory": 32000,

"rolling_strategy": {

"max_unavailable": 1

},

"rpc": {

"enable_jemalloc": 1,

"max_queue_size": 256

}

},

"processor_envs": [

{

"name": "ADAPTE_FG_CONFIG",

"value": "true"

}

],

"model_path": "",

"processor": "easyrec-2.9",

"storage": [

{

"mount_path": "/home/admin/docker_ml/workspace/model/",

"oss": {

"path": "oss://easyrec/ali_rec_sln_acc_rnk/20250722/export/final_with_fg"

}

}

],

# fg_mode を変更する場合は、対応する呼び出しメソッドも変更する必要があります。

# fg_mode が normal または tf の場合は、EasyRecRequest SDK を使用して呼び出します。

# fg_mode が bypass の場合は、TFRequest SDK を使用して呼び出します。

'model_config': {

'outputs': 'probs_ctr,probs_cvr',

'fg_mode': 'normal',

'steady_mode': True,

'period': 2880,

'access_key_id': f'{o.account.access_id}',

'access_key_secret': f'{o.account.secret_access_key}',

"load_feature_from_offlinestore": True,

'region': 'cn-shanghai',

'fs_project': '${fs_project}',

'fs_model': '${fs_model}',

'fs_entity': 'item',

'featuredb_username': 'guest',

'featuredb_password': '123456',

'log_iterate_time_threshold': 100,

'iterate_featuredb_interval': 5,

'mc_thread_pool_num': 1,

}

}

with open('echo.json', 'w') as output_file:

json.dump(config, output_file)

os.system(f'/home/admin/usertools/tools/eascmd -i {o.account.access_id} -k {o.account.secret_access_key} -e pai-eas.cn-shanghai.aliyuncs.com create echo.json')

# os.system(f'/home/admin/usertools/tools/eascmd -i {o.account.access_id} -k {o.account.secret_access_key} -e pai-eas.cn-shanghai.aliyuncs.com modify {service_name} -s echo.json')FG の TF OP バージョンを使用する例 (fg_mode=tf)

注意:FG の TF OP バージョンは、これらの組み込み特徴量のみをサポートします:id_feature, raw_feature, combo_feature, lookup_feature, match_feature, and sequence_feature。カスタム FG オペレーターはサポートされていません。

以下の例では、デプロイにシェルスクリプトを使用します。このスクリプトには、AccessKey ID と AccessKey Secret がプレーンテキストで含まれています。この方法はシンプルで理解しやすいですが、PAI-FeatureStore を含まず、Hologres の負荷を軽減するために MaxCompute からテーブルデータをロードする方法も説明していません。PAI-FeatureStore の使用と MaxCompute からのデータロードについては、「ステップ 2:EAS モデルサービスの作成とデプロイ」をご参照ください。参照されているドキュメントでは、デプロイに Python スクリプトを使用しており、セキュリティを向上させるために DataWorks の組み込みオブジェクト o と一時的な Security Token Service (STS) トークンを使用し、load_feature_from_offlinestore を True に設定していることに注意してください。

bizdate=$1

# fg_mode を変更する場合は、対応する呼び出しメソッドも変更する必要があります。fg_mode が normal または tf の場合は、EasyRecRequest SDK を使用します。fg_mode が bypass の場合は、TFRequest SDK を使用します。

cat << EOF > echo.json

{

"name":"ali_rec_rnk_with_fg",

"metadata": {

"instance": 2,

"rpc": {

"enable_jemalloc": 1,

"max_queue_size": 100

}

},

"cloud": {

"computing": {

"instance_type": "ecs.g7.large",

"instances": null

}

},

"model_config": {

"remote_type": "hologres",

"url": "postgresql://<AccessKeyID>:<AccessKeySecret>@<domain name>:<port>/<database>",

"tables": [{"name":"<schema>.<table_name>","key":"<index_column_name>","value": "<column_name>"}],

"period": 2880,

"fg_mode": "tf",

"outputs":"probs_ctr,probs_cvr",

},

"model_path": "",

"processor": "easyrec-3.1",

"storage": [

{

"mount_path": "/home/admin/docker_ml/workspace/model/",

"oss": {

"path": "oss://easyrec/ali_rec_sln_acc_rnk/20221122/export/final_with_fg"

}

}

]

}

EOF

# デプロイコマンドを実行します。

eascmd create echo.json

# eascmd -i <AccessKeyID> -k <AccessKeySecret> -e <endpoint> create echo.json

# 更新コマンドを実行します。

eascmd update ali_rec_rnk_with_fg -s echo.jsonFG を使用しない例 (fg_mode=bypass)

bizdate=$1

# fg_mode を変更する場合は、対応する呼び出しメソッドも変更する必要があります。fg_mode が normal または tf の場合は、EasyRecRequest SDK を使用します。fg_mode が bypass の場合は、TFRequest SDK を使用します。

cat << EOF > echo.json

{

"name":"ali_rec_rnk_no_fg",

"metadata": {

"instance": 2,

"rpc": {

"enable_jemalloc": 1,

"max_queue_size": 100

}

},

"cloud": {

"computing": {

"instance_type": "ecs.g7.large",

"instances": null

}

},

"model_config": {

"fg_mode": "bypass"

},

"processor": "easyrec-3.1",

"processor_envs": [

{

"name": "INPUT_TILE",

"value": "2"

}

],

"storage": [

{

"mount_path": "/home/admin/docker_ml/workspace/model/",

"oss": {

"path": "oss://easyrec/ali_rec_sln_acc_rnk/20221122/export/final/"

}

}

],

"warm_up_data_path": "oss://easyrec/ali_rec_sln_acc_rnk/rnk_warm_up.bin"

}

EOF

# デプロイコマンドを実行します。

eascmd create echo.json

# eascmd -i <AccessKeyID> -k <AccessKeySecret> -e <endpoint> create echo.json

# 更新コマンドを実行します。

eascmd update ali_rec_rnk_no_fg -s echo.json主要なパラメーター。その他のパラメーターについては、「JSON デプロイメント」をご参照ください。

パラメーター | 必須 | 説明 | 例 |

processor | はい | EasyRec プロセッサ。 |

|

fg_mode | はい | 特徴量エンジニアリングモード。モードに基づいて、対応する SDK とリクエストメソッドを選択してください。

|

|

outputs | はい | TensorFlow モデルの出力変数名 (例: | "outputs":"probs_ctr,probs_cvr" |

save_req | いいえ | ウォームアップやパフォーマンステストのために、リクエストデータをモデルディレクトリに保存します。有効値:

| "save_req": "false" |

アイテム特徴量キャッシュに関連するパラメーター | |||

period | はい | アイテム特徴量の定期的な更新間隔 (分単位)。日次更新の場合は、1 日より大きい値を設定します (例:2880 = 2 日)。特徴量は、日常の定期的なサービス更新中に更新されます。 |

|

remote_type | はい | アイテム特徴量のデータソース。サポートされているタイプ:

|

|

tables | いいえ | アイテム特徴量テーブル。remote_type が hologres の場合に必須です。パラメーター:

複数のテーブルから入力アイテムデータを読み取ることができます。設定フォーマットは次のとおりです。

複数のテーブルに重複する列がある場合、後のテーブルの列が前のテーブルの列を上書きします。 |

|

url | いいえ | Hologres のエンドポイント。 |

|

プロセッサの FeatureStore へのアクセスに関するパラメーター | |||

fs_project | いいえ | FeatureStore プロジェクトの名前。FeatureStore を使用する場合は、このフィールドを指定します。詳細については、「FeatureStore プロジェクトの設定」をご参照ください。 | "fs_project": "fs_demo" |

fs_model | いいえ | FeatureStore 内のモデル特徴量の名前。 | "fs_model": "fs_rank_v1" |

fs_entity | いいえ | FeatureStore 内のエンティティの名前。 | "fs_entity": "item" |

region | いいえ | FeatureStore プロダクトが配置されているリージョン。 | "region": "cn-beijing" |

access_key_id | いいえ | FeatureStore プロダクトの AccessKey ID。 | "access_key_id": "xxxxx" |

access_key_secret | いいえ | FeatureStore プロダクトの AccessKey Secret。 | "access_key_secret": "xxxxx" |

featuredb_username | いいえ | FeatureDB のユーザー名。 | "featuredb_username": "xxxxx" |

featuredb_password | いいえ | FeatureDB のパスワード。 | "featuredb_password": "xxxxx" |

load_feature_from_offlinestore | いいえ | オフライン特徴量を FeatureStore OfflineStore から直接取得するかどうかを指定します。有効値:

| "load_feature_from_offlinestore": True |

iterate_featuredb_interval | いいえ | リアルタイム統計特徴量を更新する間隔 (秒単位)。 間隔が短いほど特徴量の適時性は向上しますが、リアルタイム特徴量が頻繁に変更される場合、読み取りコストが増加する可能性があります。必要に応じて、精度とコストのバランスを取ってください。 | "iterate_featuredb_interval": 5 |

input_tile:自動特徴量拡張に関連するパラメーター | |||

INPUT_TILE | いいえ | アイテム特徴量の自動ブロードキャストをサポートします。単一のリクエスト内で同じ値を持つ特徴量 (例:user_id) については、値を一度だけ渡すことができます。

説明

| "processor_envs": [ { "name": "INPUT_TILE", "value": "2" } ] |

ADAPTE_FG_CONFIG | いいえ | 古い FG バージョンに基づくトレーニングサンプルからエクスポートされたモデルとの互換性を確保するために、この変数を有効にして適応させることができます。 | "processor_envs": [ { "name": "ADAPTE_FG_CONFIG", "value": "true" } ] |

DISABLE_FG_PRECISION | いいえ | 古い FG バージョンに基づくトレーニングサンプルからエクスポートされたモデルとの互換性を確保するために、この変数を無効にすることができます。古い FG バージョンは、デフォルトで浮動小数点特徴量を有効数字 6 桁に制限しますが、新しいバージョンではこの制限がなくなります。 | "processor_envs": [ { "name": "DISABLE_FG_PRECISION", "value": "false" } ] |

EasyRecProcessor の推論最適化パラメーター

パラメーター | 必須 | 説明 | 例 |

TF_XLA_FLAGS | いいえ | GPU を使用する場合、XLA を使用してモデルをコンパイルおよび最適化し、オペレーターを自動的に融合します。 | "processor_envs": [ { "name": "TF_XLA_FLAGS", "value": "--tf_xla_auto_jit=2" }, { "name": "XLA_FLAGS", "value": "--xla_gpu_cuda_data_dir=/usr/local/cuda/" }, { "name": "XLA_ALIGN_SIZE", "value": "64" } ] |

TF スケジューリングパラメーター | いいえ | inter_op_parallelism_threads:異なる操作を実行するためのスレッド数を制御します。 intra_op_parallelism_threads:単一の操作内で使用されるスレッド数を制御します。 32 コアの CPU の場合、これを 16 に設定すると一般的に高いパフォーマンスが得られます。注意:2 つのスレッド数の合計が CPU コア数を超えないようにしてください。 | "model_config": { "inter_op_parallelism_threads": 16, "intra_op_parallelism_threads": 16, } |

rpc.worker_threads | いいえ | PAI EAS のメタデータ内のパラメーター。これをインスタンスの CPU コア数に設定します。たとえば、インスタンスに 15 個の CPU コアがある場合、worker_threads を 15 に設定します。 | "metadata": { "rpc": { "worker_threads": 15 } |

ステップ 2:サービスの呼び出し

2.1 ネットワーク設定

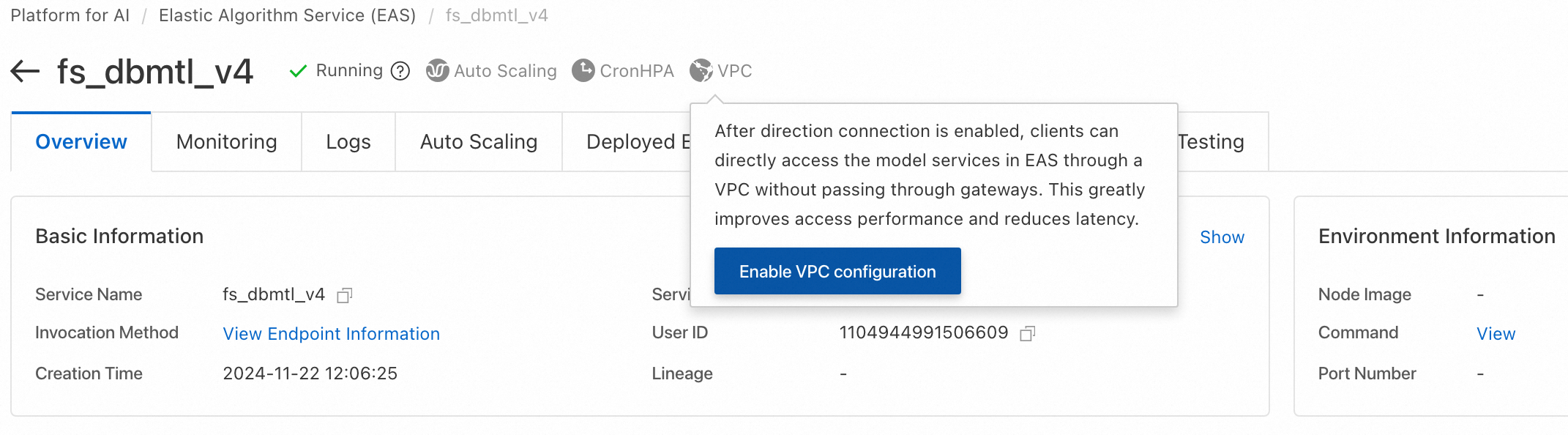

PAI-Rec エンジンとモデルスコアリングサービスは両方とも PAI EAS 上にデプロイされます。したがって、プロダクトは直接ネットワーク接続用に設定する必要があります。PAI EAS インスタンスページで、次の図に示すように、右上隅の VPC をクリックします。同じ VPC、vSwitch、およびセキュリティグループを設定します。詳細については、「EAS がインターネットおよびプライベートリソースにアクセスできるようにする」をご参照ください。Hologres を使用する場合は、同じ VPC 情報も設定する必要があります。

2.2 サービス情報の取得

EasyRec モデルサービスをデプロイした後、Elastic Algorithm Service (EAS) ページに移動します。[サービスメソッド] 列で、呼び出したいサービスを見つけ、[呼び出しメソッド] をクリックして、そのエンドポイントとトークン情報を表示します。

2.3 呼び出し用の SDK コード例

EasyRec モデルサービスの入力および出力フォーマットは両方とも protobuf です。したがって、PAI EAS プロダクトページでサービスをテストすることはできません。

サービスを呼び出す前に、ステップ 1 のデプロイ時に model_config で設定された fg_mode を特定する必要があります。モードが異なると、クライアントの呼び出しメソッドも異なります。

デプロイモード (fg_mode) | 使用する SDK リクエストクラス |

normal または tf (組み込みの特徴量エンジニアリングを含む) | EasyRecRequest |

bypass (組み込みの特徴量エンジニアリングを含まない) | TFRequest |

FG あり:fg_mode=normal または tf

Java

Maven 環境構成については、「Java SDK の説明」をご参照ください。次のコードは、ali_rec_rnk_with_fg サービスをリクエストする方法の例です。

import com.aliyun.openservices.eas.predict.http.*;

import com.aliyun.openservices.eas.predict.request.EasyRecRequest;

PredictClient client = new PredictClient(new HttpConfig());

// パブリックゲートウェイ経由でアクセスする場合、ユーザー UID で始まるエンドポイントを使用します。この情報は EAS コンソールのサービスの呼び出し詳細から取得できます。

client.setEndpoint("xxxxxxx.vpc.cn-hangzhou.pai-eas.aliyuncs.com");

client.setModelName("ali_rec_rnk_with_fg");

// サービストークン情報に置き換えます。

client.setToken("******");

EasyRecRequest easyrecRequest = new EasyRecRequest(separator);

// userFeatures: ユーザー特徴量。特徴量は \u0002 (CTRL_B) で区切られます。特徴量名と値はコロン (:) で区切られます。

// user_fea0:user_fea0_val\u0002user_fea1:user_fea1_val

// 特徴量の値のフォーマットについては、https://easyrec.readthedocs.io/en/latest/feature/rtp_fg.html をご参照ください。

easyrecRequest.appendUserFeatureString(userFeatures);

// ユーザー特徴量を一度に 1 つずつ追加することもできます:

// easyrecRequest.addUserFeature(String userFeaName, T userFeaValue).

// 特徴量の値の型 T は、String、float、long、int のいずれかです。

// contextFeatures: コンテキスト特徴量。特徴量は \u0002 (CTRL_B) で区切られます。特徴量名と値はコロン (:) で区切られます。複数の特徴量の値はコロン (:) で区切られます。

// ctxt_fea0:ctxt_fea0_ival0:ctxt_fea0_ival1:ctxt_fea0_ival2\u0002ctxt_fea1:ctxt_fea1_ival0:ctxt_fea1_ival1:ctxt_fea1_ival2

easyrecRequest.appendContextFeatureString(contextFeatures);

// コンテキスト特徴量を一度に 1 つずつ追加することもできます:

// easyrecRequest.addContextFeature(String ctxtFeaName, List<Object> ctxtFeaValue).

// ctxtFeaValue の型は、String、Float、Long、Integer のいずれかです。

// itemIdStr: 予測する itemId のリスト。カンマ (,) で区切られます。

easyrecRequest.appendItemStr(itemIdStr, ",");

// itemId を一度に 1 つずつ追加することもできます:

// easyrecRequest.appendItemId(String itemId)

PredictProtos.PBResponse response = client.predict(easyrecRequest);

for (Map.Entry<String, PredictProtos.Results> entry : response.getResultsMap().entrySet()) {

String key = entry.getKey();

PredictProtos.Results value = entry.getValue();

System.out.print("key: " + key);

for (int i = 0; i < value.getScoresCount(); i++) {

System.out.format("value: %.6g\n", value.getScores(i));

}

}

// FG 処理後の特徴量を取得し、オフライン特徴量との一貫性を比較します。

// DebugLevel を 1 に設定すると、生成された特徴量が返されます。

easyrecRequest.setDebugLevel(1);

PredictProtos.PBResponse response = client.predict(easyrecRequest);

Map<String, String> genFeas = response.getGenerateFeaturesMap();

for(String itemId: genFeas.keySet()) {

System.out.println(itemId);

System.out.println(genFeas.get(itemId));

}Python

環境構成については、「Python SDK の説明」をご参照ください。本番環境では Java クライアントの使用を推奨します。以下にコードの例を示します。

from eas_prediction import PredictClient

from eas_prediction.easyrec_request import EasyRecRequest

from eas_prediction.easyrec_predict_pb2 import PBFeature

from eas_prediction.easyrec_predict_pb2 import PBRequest

if __name__ == '__main__':

endpoint = 'http://xxxxxxx.vpc.cn-hangzhou.pai-eas.aliyuncs.com'

service_name = 'ali_rec_rnk_with_fg'

token = '******'

client = PredictClient(endpoint, service_name)

client.set_token(token)

client.init()

req = PBRequest()

uid = PBFeature()

uid.string_feature = 'u0001'

req.user_features['user_id'] = uid

age = PBFeature()

age.int_feature = 12

req.user_features['age'] = age

weight = PBFeature()

weight.float_feature = 129.8

req.user_features['weight'] = weight

req.item_ids.extend(['item_0001', 'item_0002', 'item_0003'])

easyrec_req = EasyRecRequest()

easyrec_req.add_feed(req, debug_level=0)

res = client.predict(easyrec_req)

print(res)ここで:

endpoint:サービスのエンドポイント。ユーザー ID (UID) で始まります。この情報は、PAI EAS オンラインモデルサービスページで、サービスの[サービスメソッド]列にある[呼び出しメソッド]をクリックして取得できます。

service_name:サービスの名前。サービス名は PAI EAS オンラインモデルサービスページから取得できます。

token:サービストークンです。[呼び出し方法] ダイアログボックスから取得できます。

FG なし:fg_mode=bypass

Java

Maven 環境構成については、「Java SDK の説明」をご参照ください。次のコードは、ali_rec_rnk_no_fg サービスをリクエストする方法の例です。

import java.util.List;

import com.aliyun.openservices.eas.predict.http.PredictClient;

import com.aliyun.openservices.eas.predict.http.HttpConfig;

import com.aliyun.openservices.eas.predict.request.TFDataType;

import com.aliyun.openservices.eas.predict.request.TFRequest;

import com.aliyun.openservices.eas.predict.response.TFResponse;

public class TestEasyRec {

public static TFRequest buildPredictRequest() {

TFRequest request = new TFRequest();

request.addFeed("user_id", TFDataType.DT_STRING,

new long[]{3}, new String []{ "u0001", "u0001", "u0001"});

request.addFeed("age", TFDataType.DT_FLOAT,

new long[]{3}, new float []{ 18.0f, 18.0f, 18.0f});

// 注意:INPUT_TILE=2 を設定した場合、特徴量に同じ値を一度だけ渡すことができます:

// request.addFeed("user_id", TFDataType.DT_STRING,

// new long[]{1}, new String []{ "u0001" });

// request.addFeed("age", TFDataType.DT_FLOAT,

// new long[]{1}, new float []{ 18.0f});

request.addFeed("item_id", TFDataType.DT_STRING,

new long[]{3}, new String []{ "i0001", "i0002", "i0003"});

request.addFetch("probs");

return request;

}

public static void main(String[] args) throws Exception {

PredictClient client = new PredictClient(new HttpConfig());

// 直接ネットワーク接続機能を使用するには、setDirectEndpoint メソッドを使用します。例:

// client.setDirectEndpoint("pai-eas-vpc.cn-shanghai.aliyuncs.com");

// EAS コンソールで直接ネットワーク接続を有効にする必要があります。EAS サービスにアクセスするためのソース vSwitch を提供してください。

// 直接ネットワーク接続は、より良い安定性とパフォーマンスを提供します。

client.setEndpoint("xxxxxxx.vpc.cn-hangzhou.pai-eas.aliyuncs.com");

client.setModelName("ali_rec_rnk_no_fg");

client.setToken("");

long startTime = System.currentTimeMillis();

for (int i = 0; i < 100; i++) {

try {

TFResponse response = client.predict(buildPredictRequest());

// probs はモデルの出力フィールド名です。curl コマンドを使用してモデルの入出力を表示できます:

// curl xxxxxxx.vpc.cn-hangzhou.pai-eas.aliyuncs.com -H "Authorization:{token}"

List<Float> result = response.getFloatVals("probs");

System.out.print("Predict Result: [");

for (int j = 0; j < result.size(); j++) {

System.out.print(result.get(j).floatValue());

if (j != result.size() - 1) {

System.out.print(", ");

}

}

System.out.print("]\n");

} catch (Exception e) {

e.printStackTrace();

}

}

long endTime = System.currentTimeMillis();

System.out.println("Spend Time: " + (endTime - startTime) + "ms");

client.shutdown();

}

}Python

詳細については、「Python SDK の説明」をご参照ください。Python はパフォーマンスが低いため、サービスのデバッグにのみ使用することを推奨します。本番環境では、Java SDK を使用してください。次のコードは、ali_rec_rnk_no_fg サービスをリクエストする方法の例です。

#!/usr/bin/env python

from eas_prediction import PredictClient

from eas_prediction import StringRequest

from eas_prediction import TFRequest

if __name__ == '__main__':

client = PredictClient('http://xxxxxxx.vpc.cn-hangzhou.pai-eas.aliyuncs.com', 'ali_rec_rnk_no_fg')

client.set_token('')

client.init()

# 注意:server_default をモデルの実際の signature_name に置き換えてください。詳細については、上記の SDK の説明をご参照ください。

req = TFRequest('server_default')

req.add_feed('user_id', [3], TFRequest.DT_STRING, ['u0001'] * 3)

req.add_feed('age', [3], TFRequest.DT_FLOAT, [18.0] * 3)

# 注意:INPUT_TILE=2 の最適化を有効にした後、上記の特徴量の値を一度だけ渡すことができます。

# req.add_feed('user_id', [1], TFRequest.DT_STRING, ['u0001'])

# req.add_feed('age', [1], TFRequest.DT_FLOAT, [18.0])

req.add_feed('item_id', [3], TFRequest.DT_STRING,

['i0001', 'i0002', 'i0003'])

for x in range(0, 100):

resp = client.predict(req)

print(resp)2.4 カスタムサービスリクエストの構築

他の言語については、.proto ファイルから手動で予測リクエストコードを生成します。次の protobuf 定義を使用します。

tf_predict.proto:TensorFlow モデルのリクエスト定義syntax = "proto3"; option cc_enable_arenas = true; option go_package = ".;tf"; option java_package = "com.aliyun.openservices.eas.predict.proto"; option java_outer_classname = "PredictProtos"; enum ArrayDataType { // DataType の有効な値ではありません。DataType フィールドが // 設定されていないことを示すために使用されます。 DT_INVALID = 0; // すべての計算デバイスがサポートすることが期待される // データ型。 DT_FLOAT = 1; DT_DOUBLE = 2; DT_INT32 = 3; DT_UINT8 = 4; DT_INT16 = 5; DT_INT8 = 6; DT_STRING = 7; DT_COMPLEX64 = 8; // 単精度複素数 DT_INT64 = 9; DT_BOOL = 10; DT_QINT8 = 11; // 量子化 int8 DT_QUINT8 = 12; // 量子化 uint8 DT_QINT32 = 13; // 量子化 int32 DT_BFLOAT16 = 14; // 16 ビットに切り捨てられた Float32。キャスト操作のみ。 DT_QINT16 = 15; // 量子化 int16 DT_QUINT16 = 16; // 量子化 uint16 DT_UINT16 = 17; DT_COMPLEX128 = 18; // 倍精度複素数 DT_HALF = 19; DT_RESOURCE = 20; DT_VARIANT = 21; // 任意の C++ データ型 } // 配列の次元 message ArrayShape { repeated int64 dim = 1 [packed = true]; } // 配列を表すプロトコルバッファ message ArrayProto { // データ型。 ArrayDataType dtype = 1; // 配列の形状。 ArrayShape array_shape = 2; // DT_FLOAT。 repeated float float_val = 3 [packed = true]; // DT_DOUBLE。 repeated double double_val = 4 [packed = true]; // DT_INT32, DT_INT16, DT_INT8, DT_UINT8。 repeated int32 int_val = 5 [packed = true]; // DT_STRING。 repeated bytes string_val = 6; // DT_INT64。 repeated int64 int64_val = 7 [packed = true]; // DT_BOOL。 repeated bool bool_val = 8 [packed = true]; } // PredictRequest は、実行する TensorFlow モデル、 // 入力がテンソルにどのようにマッピングされるか、およびユーザーに返す前に // 出力がどのようにフィルタリングされるかを指定します。 message PredictRequest { // 評価する名前付き署名。指定しない場合、デフォルトの署名が // 使用されます string signature_name = 1; // 入力テンソル。 // 入力テンソルの名前はエイリアス名です。エイリアスから実際の // 入力テンソル名へのマッピングは、モデルエクスポートのキー "inputs" の下に // 名前付きジェネリック署名として保存されることが期待されます。 // "inputs" という名前のジェネリック署名にリストされている各エイリアスは、 // 予測を実行するために正確に一度提供される必要があります。 map<string, ArrayProto> inputs = 2; // 出力フィルター。 // 指定された名前はエイリアス名です。エイリアスから実際の出力 // テンソル名へのマッピングは、モデルエクスポートのキー "outputs" の下に // 名前付きジェネリック署名として保存されることが期待されます。 // ここで指定されたテンソルのみが実行/フェッチされ、返されます。 // ただし、何も指定されていない場合は、 // 名前付き署名で指定されたすべてのテンソルが実行/フェッチされ、返されます。 repeated string output_filter = 3; // デバッグフラグ // 0: 予測結果のみを返し、デバッグ情報は返さない // 100: 予測結果を返し、リクエストを model_dir に保存する // 101: タイムラインを model_dir に保存する int32 debug_level = 100; } // 正常に実行された場合の PredictRequest への応答。 message PredictResponse { // 出力テンソル。 map<string, ArrayProto> outputs = 1; }easyrec_predict.proto:FG を持つ TensorFlow モデルのリクエスト定義syntax = "proto3"; option cc_enable_arenas = true; option go_package = ".;easyrec"; option java_package = "com.aliyun.openservices.eas.predict.proto"; option java_outer_classname = "EasyRecPredictProtos"; import "tf_predict.proto"; // コンテキスト特徴量 message ContextFeatures { repeated PBFeature features = 1; } message PBFeature { oneof value { int32 int_feature = 1; int64 long_feature = 2; string string_feature = 3; float float_feature = 4; } } // PBRequest はアグリゲーターへのリクエストを指定します message PBRequest { // デバッグフラグ // 0: 予測結果のみを返し、デバッグ情報は返さない // 3: FG モジュールによって生成された特徴量を文字列形式で返す。特徴量の値は \u0002 で区切られる。 // 特徴量の一貫性チェックやオンラインディープラーニングサンプルの生成に使用できる // 100: 予測結果を返し、リクエストを model_dir に保存する // 101: タイムラインを model_dir に保存する // 102: DSSM や MIND などのリコールモデルの場合、Faiss で取得した結果だけでなく、 // ユーザーの埋め込みベクトルも返す。 int32 debug_level = 1; // ユーザー特徴量 map<string, PBFeature> user_features = 2; // アイテム ID、静的 (日次更新) アイテム特徴量 // は、各プロセッサノードにある特徴量キャッシュから // item_ids によってフェッチされる repeated string item_ids = 3; // 各アイテムのコンテキスト特徴量、リアルタイムアイテム特徴量 // はコンテキスト特徴量として渡すことができる。 map<string, ContextFeatures> context_features = 4; // 埋め込み取得の近傍数。 int32 faiss_neigh_num = 5; } // 結果を返す message Results { repeated double scores = 1 [packed = true]; } enum StatusCode { OK = 0; INPUT_EMPTY = 1; EXCEPTION = 2; } // PBResponse はアグリゲーターへの応答を指定します message PBResponse { // 結果 map<string, Results> results = 1; // アイテム特徴量 map<string, string> item_features = 2; // fg が生成した特徴量 map<string, string> generate_features = 3; // コンテキスト特徴量 map<string, ContextFeatures> context_features = 4; string error_msg = 5; StatusCode status_code = 6; // アイテム ID repeated string item_ids = 7; repeated string outputs = 8; // すべての fg 入力特徴量 map<string, string> raw_features = 9; // 出力テンソル map<string, ArrayProto> tf_outputs = 10; }