このトピックでは、オンライン予測サービスに関するよくある質問 (FAQ) について説明します。

サービスの異常状態

1. サービスが長時間「待機中」状態のままです。どうすれば解決できますか?

デプロイメント後、サービスはリソースのスケジューリングとサービスインスタンスの起動を待つ間、「待機中」状態になります。すべてのサービスインスタンスが正常に起動すると、サービスは「実行中」状態になります。サービスが長期間「待機中」状態のままである場合、通常は [概要] ページの [サービスインスタンス] リストでサービスインスタンスのステータスとログを確認することで、原因を特定できます。考えられる原因は次のとおりです。

1. リソース不足:サービスインスタンスリストのすべてまたは一部のインスタンスが「保留中」状態です。

この問題は通常、専用リソースグループのアイドルリソースが不足しているためにインスタンスをスケジューリングできない場合に発生します。次の図に例を示します。

この場合、専用リソースグループのマシンノードに CPU、メモリ、GPU を含む十分なアイドルリソースがあるかどうかを確認してください。インスタンスが 3 コアと 4 GB のリソースを必要とする場合、専用リソースグループ内の少なくとも 1 つのマシンノードに 3 コアと 4 GB のアイドルリソースが必要です。

高負荷時のシステム障害を防ぐため、各マシンノードはシステムコンポーネント用に 1 つの CPU コアを予約します。スケジューリング可能なリソースは、総リソースからこの予約済みコアを差し引いたものです。

次の図は、専用リソースグループのノードリストを示しています。リソースグループの詳細を表示する方法については、「EAS リソースグループの使用」をご参照ください。

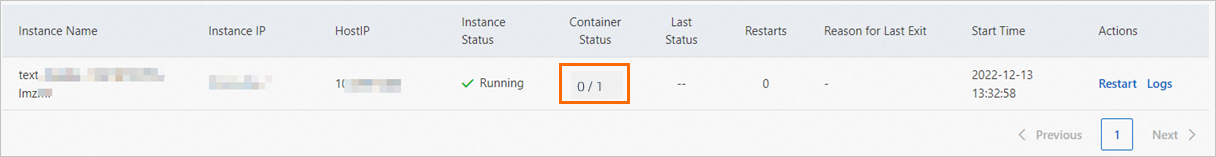

2. インスタンスのヘルスチェックが完了していません:サービスインスタンスは「実行中」状態ですが、コンテナーのステータスは通常 [0/1] または [1/2] です。

スラッシュ (/) の前の数字は正常に起動したコンテナーの数を示します。スラッシュ (/) の後の数字はコンテナーの総数を示します。カスタムイメージを使用してサービスをデプロイすると、トラフィックシェーピングやモニタリングなどのタスクのためにサイドカーコンテナーが自動的にインスタンスに挿入されます。このコンテナーを管理する必要はありません。コンソールでは、コンテナーの総数が 2 であることがわかります。これには、カスタムコンテナーとエンジンのサイドカーコンテナーが含まれます。この場合、両方のコンテナーが準備完了状態になった後にのみ、サービスインスタンスは起動したと見なされ、トラフィックの受信を開始します。

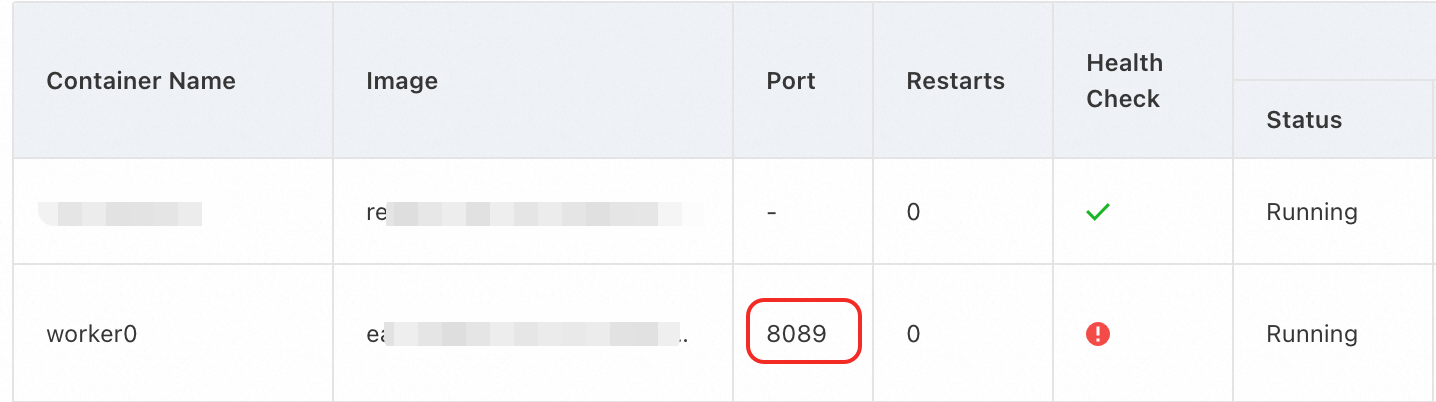

3. インスタンスのヘルスチェックの失敗:EAS サービスに設定されたポートがコードで設定されたポートと一致していません。

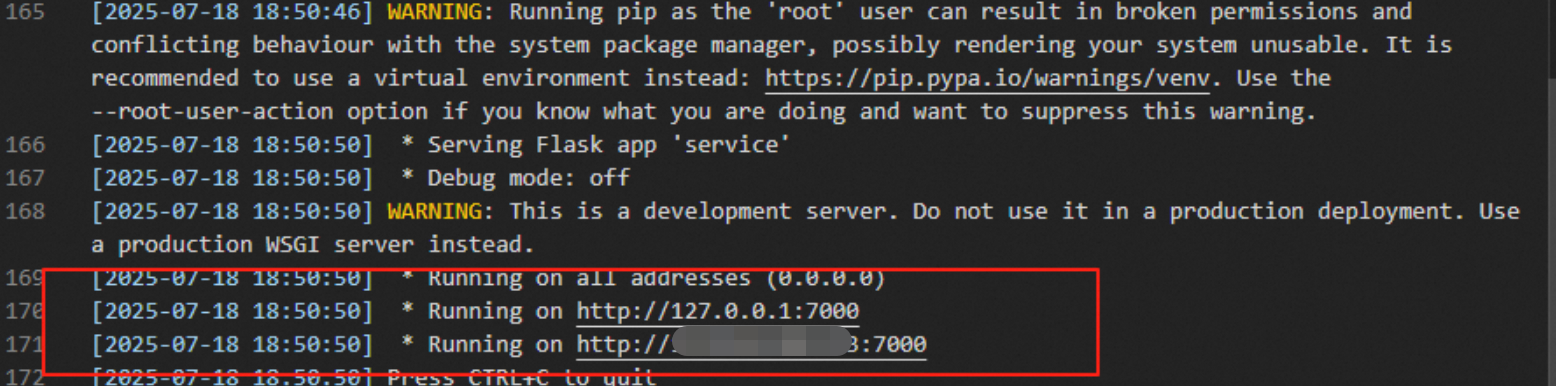

問題の説明:Flask (または FastAPI、Sanic、Django などの他の Web フレームワーク) を使用して API 操作を提供する EAS サービスがデプロイされています。ログには Running on http://127.0.0.1:7000 と表示されます。

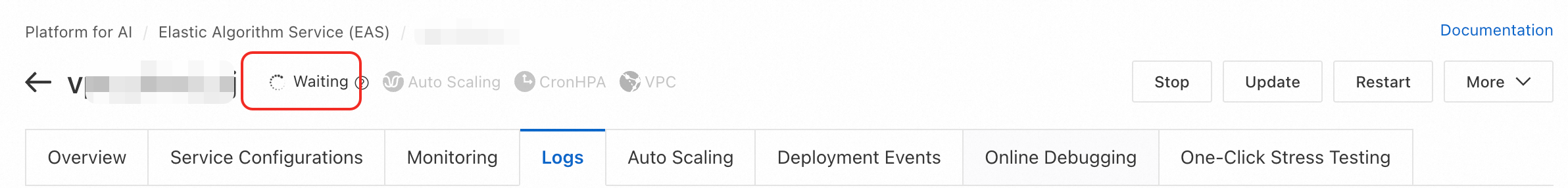

しかし、PAI コンソールでは、EAS サービスがまだ待機中状態であることが示されています。

原因:EAS サービスのワーカーがヘルスチェックに失敗しました。ワーカーによって公開されているポートは 8089 ですが、Flask はポート 7000 でサービスを提供しています。

ソリューション:EAS サービスに設定されているポート番号をコード内のポートと一致するように変更し、サービスを再起動します。

2. サービスが「失敗」状態です。どうすれば解決できますか?

サービスは次の 2 つのシナリオで失敗状態になります。

サービスデプロイ中:デプロイ中にモデルアドレスなどの指定されたリソースが存在しない場合、エラーの原因がサービスの現在のステータス情報に表示されます。通常、このエラーメッセージからデプロイメントの失敗原因を特定できます。

サービス起動中:サービスがデプロイされ、リソースにスケジューリングされた後に起動に失敗します。この場合、ステータスメッセージ

Instance <network-test-5ff76448fd-h9dsn> not healthy: Instance crashed, please inspect instance log.が表示されます。このステータスメッセージは、サービスインスタンスの起動に失敗したことを示します。具体的な原因を特定するには、サービスの [概要] ページの [サービスインスタンス] リストで失敗したステータスを確認する必要があります。インスタンスの失敗の考えられる原因は次のとおりです。

起動中にメモリ不足 (OOM) エラーが発生したため、サービスインスタンスがシステムによって終了されました。この場合、サービスのメモリを増やしてサービスを再デプロイする必要があります。次の図はインスタンスのステータスを示しています。

起動時にコードエラーが原因で、サービスがクラッシュすることがあります。この場合、[最終ステータス]はエラー(エラーコード)になります。インスタンスの[アクション]列の[ログ]ボタンをクリックして、サービスログを確認し、障害の原因を特定します。次の図は、インスタンスのステータスを示しています。

サービスイメージのプルに失敗しました。詳細については、「イメージのプルに失敗した場合 (ImagePullBackOff)、どうすればよいですか?」をご参照ください。

3. EAS サービスが停止後に自動的に再起動します

問題の説明:EAS サービスが停止してからしばらくすると自動的に再起動します。

原因:

これは、サービスに Auto Scaling が設定されており、インスタンスの最小数が 0 に設定されているために発生します。トラフィックがない期間が続くと、インスタンス数は自動的に 0 にスケールインされます。インスタンスが利用できないときにリクエストが到着すると、設定されたスケールアウトのメトリクスのしきい値に達していなくても、スケールアウトが自動的にトリガーされます。

デプロイイベントの Auto Scaling の説明に基づいて、スケールアウトが自動的にトリガーされたかどうかを判断できます。

ソリューション:

サービスが不要になった場合は、削除できます。

サービスを削除したくない場合は、コンソールで [停止] をクリックするか、

StopServiceAPI 操作を呼び出すことで手動で停止できます。手動で停止したサービスは、トラフィックによってスケールアウトすることはできません。弾性スケーリングによってサービスが自動的に停止されないようにするには、インスタンスの最小数を 0 に設定しないでください。

予期しないトラフィックがスケールアウトをトリガーするのを防ぐために、必要に応じて Auto Scaling を無効にすることもできます。

4. PAI-EAS 起動エラー:IoError(Os { code: 28, kind: StorageFull, message: "No space left on device" })

問題の説明:

PAI-EAS は起動時に次のエラーを報告します。

[2024-10-21 20:59:33] serialize_file(_flatten(tensors), filename, metadata=metadata)

[2024-10-21 20:59:33] safetensors_rust.SafetensorError: Error while serializing: IoError(Os { code: 28, kind: StorageFull, message: "No space left on device" })

[2024-10-21 20:59:35] time="2024-10-21T12:59:35Z" level=info msg="program stopped with status:exit status 1" program=/bin/sh

原因:モデルファイルが多すぎるため、EAS インスタンスのシステムディスクがいっぱいになり、サービスが正常に起動できなくなっています。

ソリューション:

ソリューション 1:EAS インスタンスのシステムディスクをスケールアウトします。

ソリューション 2:モデルファイルが大きすぎる場合は、OSS や NAS などの外部ストレージに保存し、ストレージマウントを使用して読み取ることができます。

5. デプロイエラー:fail to start program with error: fork/exec /bin/sh: exec format error

exec format error は、オペレーティングシステムがターゲットの実行可能ファイルを実行できないことを示します。最も一般的な原因は、実行可能ファイルまたはコンテナーイメージの CPU アーキテクチャがホストシステムのアーキテクチャと互換性がないことです。

別のリソース仕様に切り替えてみてください。

6. エラー: GPU 数 6 は無効です。サポートされているのは [0 1 2 4 8 16] のみです。

複数の GPU 間の通信効率を最大化するために、単一のサービスに指定する GPU の数は 2 のべき乗である必要があります。

0、1、2、4、8、または 16 個の GPU を割り当てることができます。

イメージに関する問題

1. イメージのプルに失敗した場合 (ImagePullBackOff)、どうすればよいですか?

サービスインスタンスリストの [最後の終了理由] に ImagePullBackOff が表示されている場合、イメージのプルに失敗した可能性があります。[ステータス] 列に次のアイコンが表示されている場合は、そのアイコンをクリックして具体的な原因を表示できます。

イメージのプルに失敗する一般的な原因は次のとおりです。

失敗原因 | 考えられるエラー | ソリューション |

システムディスクの容量不足 |

| システムディスクをスケールアウトします。 |

ACR のアクセスの制御が設定されていない |

| イメージのパブリックエンドポイントを使用する場合は、ACR のパブリックアクセスを有効にする必要があります。 イメージの内部エンドポイントを使用する場合:

|

EAS ネットワーク構成の問題 |

| イメージのパブリックエンドポイントを使用する場合は、EAS のインターネットアクセスを設定する必要があります。 |

認証情報がない、または正しくない |

| ACR Enterprise Edition インスタンスがパブリックな匿名プル用に設定されておらず、インターネット経由で別のリージョンからイメージをプルする場合は、デプロイ時にイメージリポジトリのユーザー名とパスワードを設定する必要があります。認証情報を取得する方法の詳細については、「アクセス認証情報の設定」をご参照ください。 |

イメージサービスと EAS のリージョンに基づいて、次の推奨事項に従ってください。

同じリージョン:内部 URL を使用してイメージをプルします。

異なるリージョン:ACR Personal Edition の場合、パブリックイメージ URL を使用する必要があります。ACR Enterprise Edition の場合、次のいずれかのオプションを選択します。

セキュリティと安定性に対する要件が高い場合は、内部イメージ URL を使用します。Cloud Enterprise Network (CEN) を使用して VPC を接続する必要があります。詳細については、「異なるリージョンまたは IDC から ACR Enterprise Edition インスタンスにアクセスする」をご参照ください。

ビジネスシナリオが単純であるか、内部ネットワークをすぐに接続できない場合は、一時的な解決策としてパブリックイメージ URL を使用します。インターネット経由のダウンロードは遅くなることに注意してください。

ACR Enterprise Edition インスタンスに関する次の点に注意してください。

必要に応じて、VPC とインターネットのアクセスの制御を設定します。

リポジトリが匿名でのイメージプルを許可していない場合、インターネット経由で異なるリージョンからイメージをプルするときに、EAS でイメージリポジトリのユーザー名とパスワードを提供する必要があります。

2. インターネットから EAS 公式イメージをダウンロードできますか?

いいえ。PAI 公式イメージは内部プラットフォームイメージです。PAI プラットフォーム上でのみ使用できます。プラットフォームのコンテナー外でダウンロードすることはできません。

コンピューティングリソースの使用量

1. 専用リソースグループが常にスケールアウトしています

これは通常、現在のリージョンでリソースが不足しているために発生します。

サブスクリプションのマシンインスタンスの場合、リソース不足により作成が失敗すると、システムは自動的に返金注文を作成します。支払われた金額はアカウントに返金されます。

2. 専用リソースグループからサブスクリプションインスタンスを削除するにはどうすればよいですか?

Alibaba Cloud のサブスクリプション解除ページに移動して、未使用の EAS サブスクリプション専用マシンのサブスクリプションを解除できます。ページで、次の手順を実行します。

[タイプ] には、[部分返金] を選択します。

製品名には、[EAS Dedicated Machine Subscription] を選択します。

[検索] をクリックして、サブスクライブを解除したいリソースを検索します。次に、[アクション] 列の [リソースのサブスクライブ解除] をクリックし、コンソールの指示に従ってプロセスを完了します。

3. EAS リソースグループマシンのサブスクリプションを解除した後、サービスインスタンスのデータは保持されますか?

いいえ、サービスインスタンスのデータは保持されません。

4. EAS サービスをデプロイするときに、1 コア、2 GB のリソース構成を選択できないのはなぜですか?

問題を回避するため、1 コア、2 GB のリソース仕様は利用できなくなりました。EAS は各マシンノードにシステムコンポーネントをデプロイし、これらのコンポーネントは一部のマシンリソースを消費します。マシンの仕様が小さすぎると、システムコンポーネントが占めるリソースの割合が高くなりすぎ、利用可能なリソースの割合が減少します。

5. EAS でデプロイできるサービスの最大数はいくつですか?

EAS でデプロイできるサービスインスタンスの最大数は、残りのリソース使用量によって異なります。コンソールのリソースグループのマシンリストで残りの使用量を確認できます。詳細については、「EAS リソースグループの使用」をご参照ください。

CPU コアの数に基づいてタスクを割り当てる場合、デプロイできるインスタンスの最大数は (CPU コア数 - 1) / 各インスタンスが使用するコア数です。

6. 4090 グラフィックカードと同等の計算能力を持つ EAS の仕様は何ですか?

ecs.gn8ia-2x.8xlarge 仕様は、4090 グラフィックカードと同様のパフォーマンスを持っています。

7. 特定のリソース構成でデプロイされたモデルの最大同時実行数はどのくらいですか?

モデルサービスの最大同時実行数は、モデル、シナリオ、リソース構成など、複数の要因に依存します。詳細については、「サービスの自動ストレステスト」をご参照ください。

サービス管理

1. SSH を使用して EAS インスタンスに接続できますか?

いいえ。EAS はリモート SSH 接続をサポートしていません。コンテナーに入ってデバッグすることはできません。コマンドを実行するには、実行コマンドで設定することをお勧めします。

2. EAS のサービスステータスには何がありますか?

EAS サービスには次のステータスがあります。Elastic Algorithm Service (EAS) ページに移動し、[サービスステータス] 列を表示することもできます。

作成中:サービスが作成されています。

待機中:サービスはインスタンスの起動を待っています。

停止済み:サービスは停止しています。

失敗:サービスは失敗しました。

更新中:サービスが更新されています。インスタンスが更新されます。

停止中:サービスが停止されています。

ホットアップデート:サービスが更新されています。これはホットアップデートであり、インスタンスは更新されません。

起動中:サービスが起動しています。

削除失敗:サービスの削除に失敗しました。

実行中:サービスが実行中です。

スケーリング中:サービスが更新されています。インスタンスがスケーリングされています。

保留中:サービスは特定のアクションを待っています。

削除中:サービスが削除されています。

完了:タスクは完了しました。

準備中:サービスが準備されています。

3. どの RAM ユーザーがサービスを作成したかを確認する方法

ActionTrail を使用してこの情報をクエリできます。詳細については、「ActionTrail コンソールでイベントをクエリする」をご参照ください。

サービスの呼び出し

1. サービスの呼び出しエラーが発生し、404、401、504 などのステータスコードが返されます。

404 Not Found

404 エラーは通常、無効なリクエストパス、不正なリクエストボディ、またはサービスがサポートしていない API を示します。受け取った特定のエラーメッセージに基づいて、次のシナリオを使用してトラブルシューティングを行ってください。

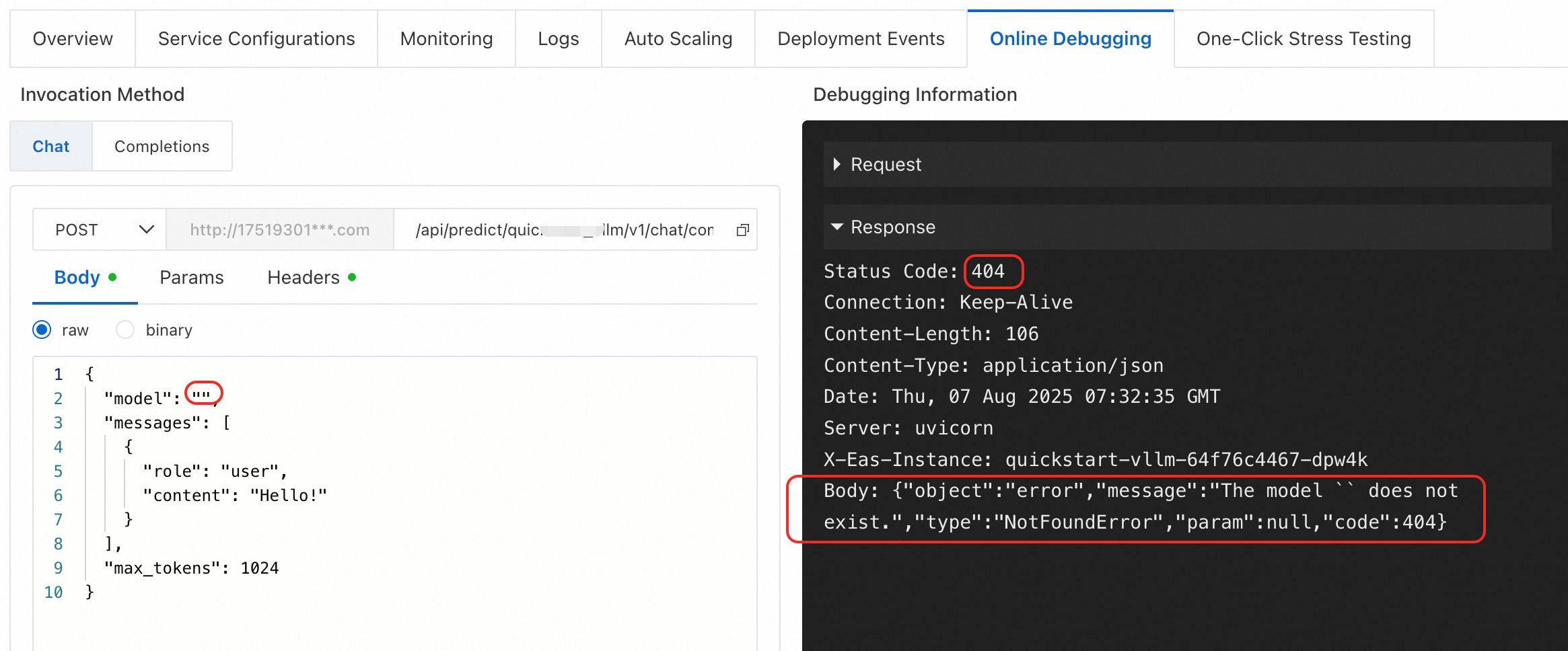

エラータイプ 1:{"object":"error","message":"The model `` does not exist.","type":"NotFoundError","param":null,"code":404}

原因:vLLM でデプロイされたサービスの /v1/chat/completions エンドポイントを呼び出す際、リクエストボディの model パラメーターが空または無効です。

ソリューション:model パラメーターの値は有効なモデル名でなければなりません。v1/models エンドポイントを使用して有効なモデル名をクエリしてください。

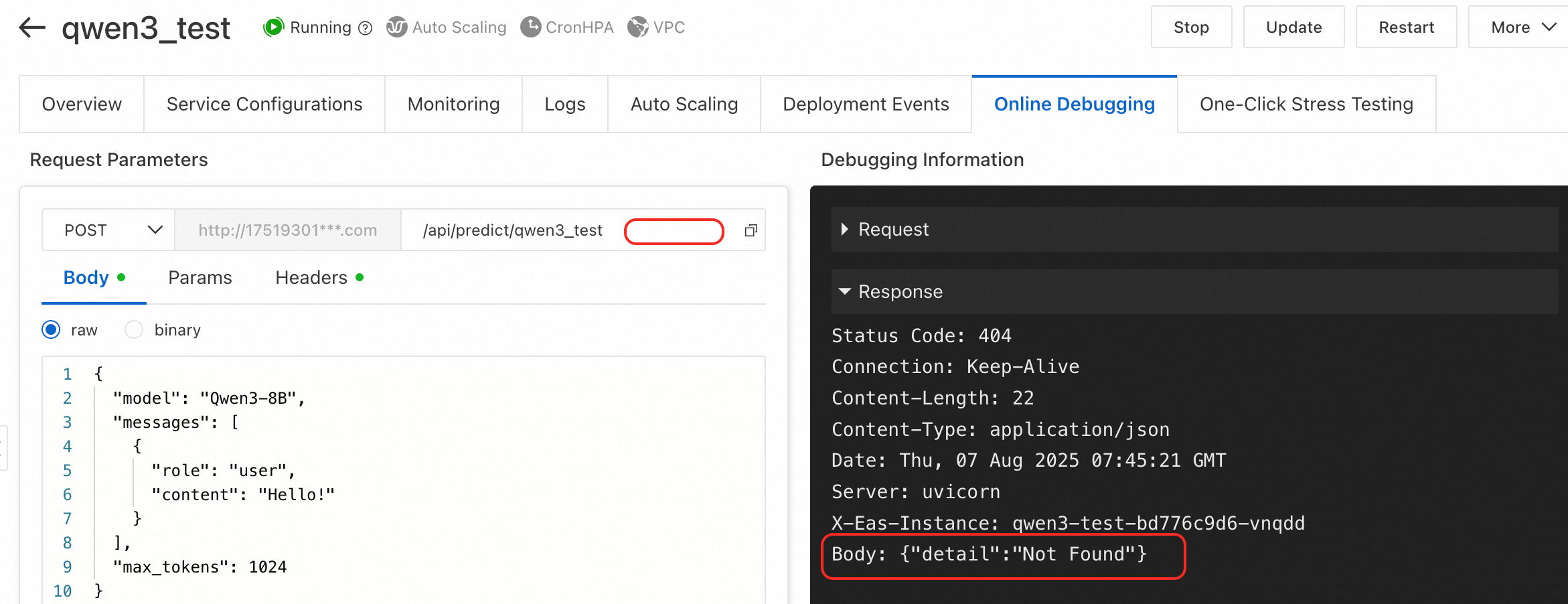

エラータイプ 2:{"detail":"Not Found"}

原因:リクエストパスが不完全または正しくありません。たとえば、LLM サービスのチャットエンドポイントを呼び出す際に、ベース URL に v1/chat/completions パスを追加していません。

ソリューション:API リクエストパスが完全で正しいことを確認してください。LLM サービスについては、「LLM サービスの呼び出し」をご参照ください。

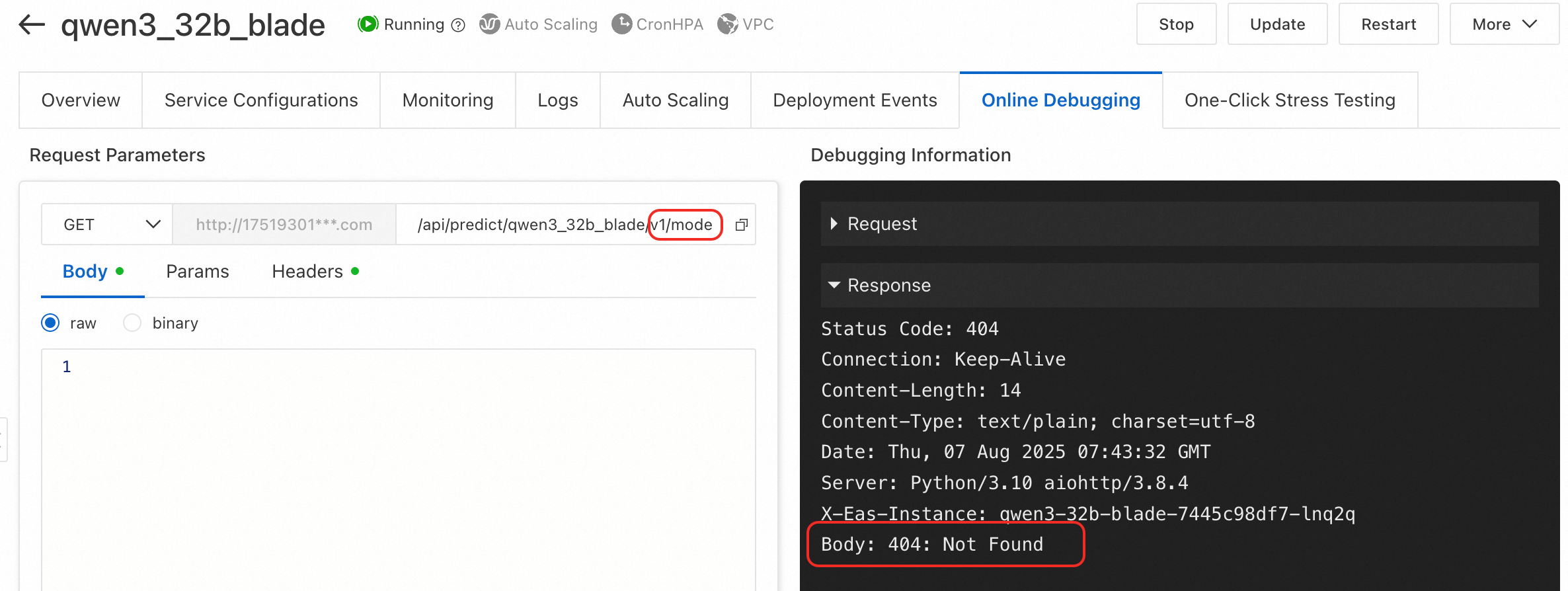

エラータイプ 3:BladeLLM の /v1/models エンドポイントを呼び出すと 404: Not Found が返されます。

原因:BladeLLM でデプロイされたサービスは v1/models エンドポイントをサポートしていません。

ソリューション:サポートされている API のリストについては、「BladeLLM サービス呼び出しパラメーターの構成」をご参照ください。

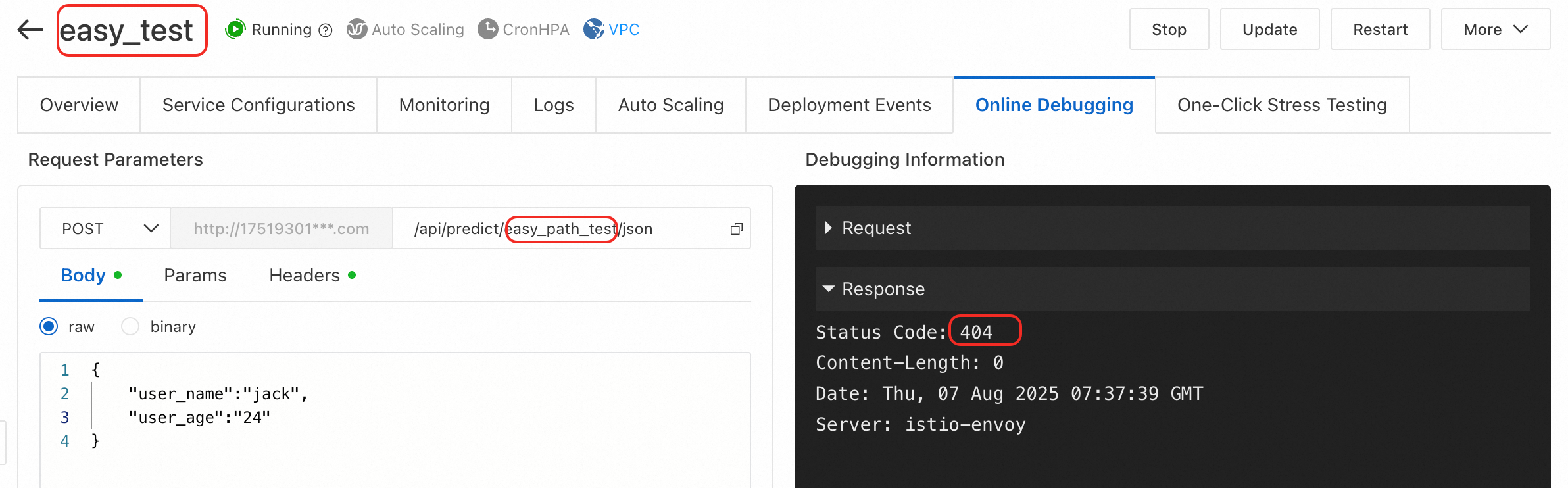

エラータイプ 4:オンラインデバッグページで、他の情報なしで 404 エラーが返されます。

原因:リクエストパスが正しくありません。オンラインデバッグを使用する場合、ベース URL は通常 http://123***.cn-hangzhou.pai-eas.aliyuncs.com/predict/service_name です。URL のサービス名部分を誤って変更または削除すると、404 エラーが発生します。

ソリューション:オンラインデバッグを使用する場合、通常はデフォルトの URL を変更または削除する必要はありません。呼び出す必要がある特定の API パスを追加してください。

エラータイプ 5:ComfyUI への API 呼び出しで "404 not found page" が返されます。

原因:API を介して ComfyUI サービスの Serverless バージョンを呼び出そうとしています。このバージョンは API 呼び出しをサポートしていません。

ソリューション:Standard または API Edition をデプロイしてください。詳細については、「AI ビデオ生成のための ComfyUI のデプロイ」をご参照ください。

401 Authorization Failed が返される

認証トークンがない、正しくない、または不適切に使用されています。以下を確認してください。

トークンが正しいか確認します。サービスの [概要] ページで、[基本情報] セクションの [呼び出し情報を表示] をクリックします。

説明デフォルトでは、サービスは自動的に認証トークンを生成します。カスタムトークンを指定し、サービスの更新中に更新することもできます。

トークンが正しく設定されているか確認します。

curlコマンドを使用する場合、HTTP ヘッダーのAuthorizationフィールドにトークンを追加します。例:curl -H 'Authorization: NWMyN2UzNjBiZmI2YT***' http:// xxx.cn-shanghai.aliyuncs.com/api/predict/echo。SDK を使用してサービスにアクセスする場合、対応する

SetToken()関数を呼び出します。詳細については、「Java SDK の使用方法」をご参照ください。

リクエストが長時間応答せず、最終的にタイムアウトする (timeout / 504)

ゲートウェイまたはプロキシとして機能しているサーバーが、アップストリームサーバーから時間内に応答を受信しませんでした。これは通常、モデルの推論に時間がかかりすぎていることを意味します。この問題を解決するには、次のようにします。

クライアントコードで、HTTP リクエストのタイムアウトを増やします。

長時間実行されるタスクには、バッチまたは長時間実行される推論タスクを処理するように設計された EAS キューサービス (非同期呼び出し) モードを使用します。

ステータスコードの詳細については、「付録:サービスステータスコードと一般的なエラー」をご参照ください。

2. PAI-EAS サービスは HTTPS 呼び出しをサポートしていますか?

はい、サポートしています。http を https に置き換えるだけで、より安全な暗号化された伝送が可能です。呼び出し元の環境が HTTPS 証明書の検証をサポートしていることを確認してください。クライアントで SSL 証明書検証エラー (Python requests など) が発生した場合、これは通常、EAS サービスの問題ではなく、クライアント環境の構成の問題です。

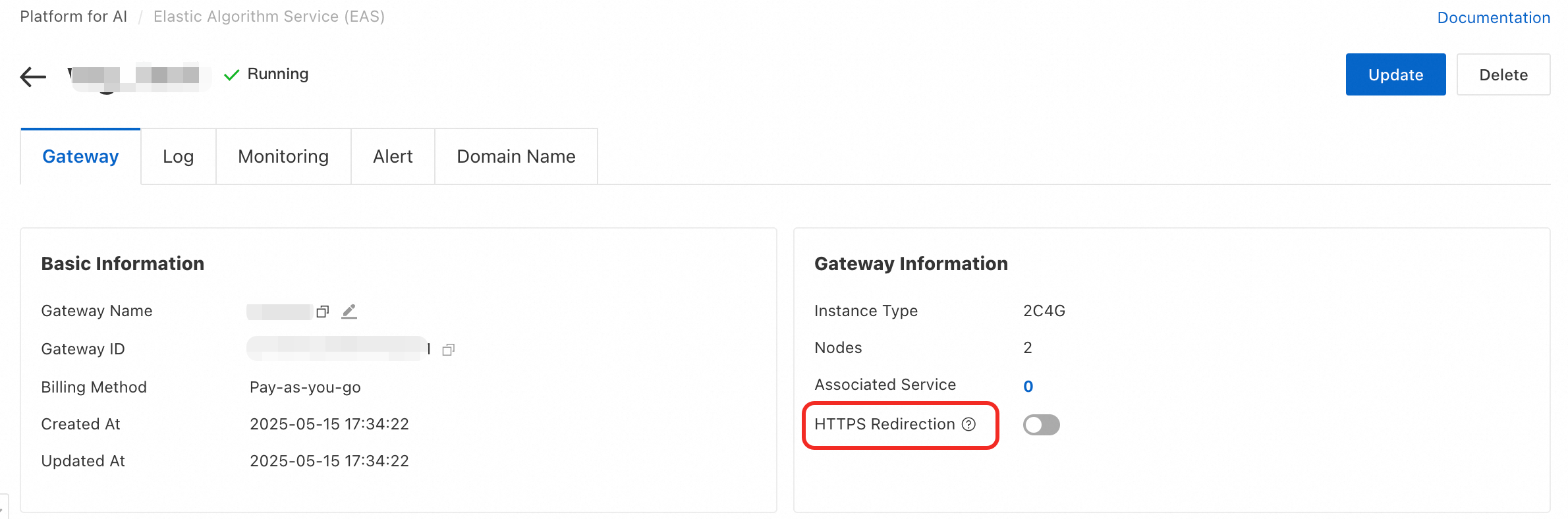

3. HTTP アクセスをブロックし、HTTPS アクセスのみを許可するにはどうすればよいですか?

共有ゲートウェイでは HTTP アクセスをブロックできません。専用ゲートウェイの場合は、[HTTPS リダイレクト] を有効にできます。これにより、すべての HTTP リクエストが HTTPS プロトコルにリダイレクトされます。

4. 独自のドメイン名で呼び出すことはできますか?

はい、できます。専用ゲートウェイを使用する必要があります。詳細については、「専用ゲートウェイを使用したサービスの呼び出し」をご参照ください。

5. トークンは有効期限が切れたり、変更されたりしますか?

いいえ、そうではありません。サービスがデプロイされると、トークンは長期間有効です。サービスを再起動してもトークンは変更されません。トークンは、カスタム認証で手動でリセットするか、サービスを削除した場合にのみ変更されます。

6. 1 つのサービスに対して複数のトークンを作成できますか?

いいえ、できません。EAS サービスインスタンスは 1 つの固定認証トークンのみをサポートします。アクセスの制御や個別の計測のために、単一のサービスに対して複数のトークンを作成することはできません。マルチユーザー認証管理を実装するには、Alibaba Cloud RAM 認証などのより複雑なソリューションを使用することをお勧めします。

7. デプロイされた LLM サービスのストリーミング応答を有効にするにはどうすればよいですか?

EAS サービス自体は、デプロイ時にデフォルトのストリーミング応答用に設定することはできません。各 API 呼び出しリクエストの本文で、ストリーミング出力を希望することを明示的に指定する必要があります。

たとえば、LLM サービスを呼び出すときに、JSON リクエストボディに "stream": true パラメーターを追加できます。

8. VPC エンドポイント呼び出しと VPC 直接接続呼び出しの違いは何ですか?

VPC エンドポイント呼び出し:このメソッドは、プライベート向け SLB とゲートウェイを使用します。これは古典的なリクエストモデルです。このモデルでは、リクエストは SLB のレイヤー 4 とゲートウェイのレイヤー 7 を介して転送され、サービスインスタンスに到達します。高トラフィックおよび高同時実行のシナリオでは、この転送によりパフォーマンスのオーバーヘッドが発生します。ゲートウェイには帯域幅制限もあり、デフォルトでは 1 Gbps です。

VPC 直接接続:EAS は、追加費用なしでパフォーマンスと拡張性の問題を解決する高速直接接続アクセスモードを提供します。VPC 直接接続を有効にすると、ご利用の VPC と EAS サービス VPC の間にネットワークパスが確立されます。リクエストは、EAS が提供するサービスディスカバリ機能を使用してサービスを特定し、クライアントコードで負荷分散されたサービスリクエストを開始します。このプロセスでは、EAS が提供する SDK を使用し、endpoint_type を DIRECT に設定する必要があります。

たとえば、「Python SDK の使用方法」で説明されているシナリオでは、次のコード行を追加してゲートウェイ呼び出しから直接接続に切り替えることができます。

client = PredictClient('http://pai-eas-vpc.cn-hangzhou.aliyuncs.com', 'mnist_saved_model_example') client.set_token('<your_token>') client.set_endpoint_type(ENDPOINT_TYPE_DIRECT) # Direct link client.init()

9. curl コマンドを使用して EAS オンラインサービスを呼び出すにはどうすればよいですか?

EAS オンラインサービスが正常にデプロイされた後、curl コマンドを使用して、パブリックまたは VPC エンドポイントを使用してサービスを呼び出すことができます。手順は次のとおりです。

サービスのエンドポイントとトークンを取得します。

[Elastic Algorithm Service][ (EAS)] ページで、対象のサービスをクリックして、その概要ページに移動します。

[基本情報] セクションで、[呼び出し情報を表示] をクリックします。

[呼び出し情報] ダイアログボックスの [パブリックエンドポイント呼び出し] または [VPC エンドポイント呼び出し] タブで、サービスエンドポイントとトークンを取得します。

curl コマンドを使用してサービスを呼び出します。

例:

$ curl <service_url> -H 'Authorization: <service_token>' -d '[{"sex":0,"cp":0,"fbs":0,"restecg":0,"exang":0,"slop":0,"thal":0,"age":0,"trestbps":0,"chol":0,"thalach":0,"oldpeak":0,"ca":0}]'各項目は次のとおりです。

<service_url>: 取得したサービスエンドポイントに置き換えます。

<service_token>: 取得したトークンと置き換えます。

-d: サービスリクエストデータを設定します。

その他

システムディスク

システムディスクを拡張する方法

システムディスクは、[リソース情報] > [システムディスクの構成] で構成するか、サービスの JSON 構成ファイルを次のように直接変更できます。

"metadata": {"disk": "40Gi"}専用リソースを使用する場合、必要なシステムディスクサイズが利用可能なシステムディスク容量よりも大きい場合は、現在のリソースを削除し、必要なサイズの新しいリソースを購入する必要があります。

ネットワークに関する問題

EAS サービスはサービス内からどのようにインターネットにアクセスしますか?

デフォルトでは、EAS サービスはパブリックインターネットにアクセスできません。パブリックインターネットにアクセスするには、EAS サービスにインターネットアクセス機能を備えた VPC を設定する必要があります。詳細については、「ネットワーク構成」をご参照ください。

サービスストレージマウント

EAS サービスをデプロイするときに OSS バケットを選択できないのはなぜですか?

EAS サービスをデプロイするときに、マウントを使用してモデルとコードを設定できます。使用する OSS バケットと NAS ファイルシステムが EAS サービスと同じリージョンにあることを確認してください。そうでない場合、それらを選択することはできません。

権限

RAM ユーザーが EAS サービスリンクロールを自動的に作成または削除できないのはなぜですか?

指定された権限を持つユーザーのみが AliyunServiceRoleForPaiEas を自動的に作成または削除できます。したがって、RAM ユーザーが AliyunServiceRoleForPaiEas を自動的に作成または削除できない場合は、RAM ユーザーに対応するアクセスポリシーを追加する必要があります。手順は次のとおりです。

次のポリシースクリプトを使用してカスタムポリシーを作成します。詳細については、「カスタムアクセスポリシーの作成」をご参照ください。

サービスリンクロールを作成または削除するためのアクセスポリシー

{ "Statement": [ { "Action": "ram:CreateServiceLinkedRole", "Resource": "*", "Effect": "Allow", "Condition": { "StringEquals": { "ram:ServiceName": "eas.pai.aliyuncs.com" } } } ], "Version": "1" }前のステップで作成したカスタムポリシーをターゲットの RAM ユーザーに付与します。詳細については、「方法 1:RAM ユーザーページで RAM ユーザーに権限を付与する」をご参照ください。

TensorFlow に関する問題

詳細については、「TensorFlow よくある質問」をご参照ください。