このトピックでは、MaxComputeクライアントでTunnel Uploadコマンドを実行して、コンピューター上のデータファイルからMaxComputeテーブルにデータをインポートする方法について説明します。

前提条件

データをインポートするテーブルが作成されます。

テーブルの作成方法の詳細については、「テーブルの作成」をご参照ください。

データをインポートするCSVまたはTXTデータファイルがコンピュータにダウンロードされます。

このトピックでは、次のサンプルファイルを使用します。

非パーティションテーブルにデータをインポートするファイル: banking.txt

パーティションテーブルにデータをインポートするファイル: banking_nocreditcard.csv、banking_uncreditcard.csv、およびbanking_yescreditcard.csv

ステップ1: データのインポート

Tunnel Uploadコマンドを実行して、コンピューター上のデータファイルからMaxComputeテーブルにデータをインポートします。 トンネル操作の詳細については、「トンネルコマンド」をご参照ください。

データファイルの格納パスを取得します。

MaxComputeクライアントの

binディレクトリにファイルを保存できます。 この場合、インポートコマンドでFile name.File name extension形式でストレージパスを指定する必要があります。 ドライブDのテストフォルダなど、別のディレクトリにファイルを保存することもできます。この場合、インポートコマンドでD:\test\File name.File name extension形式でストレージパスを指定する必要があります。この例では、

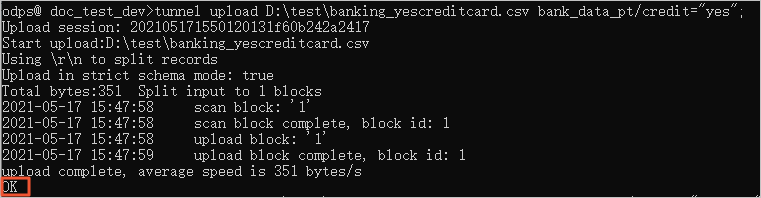

banking.txtはMaxComputeクライアントのbinディレクトリに格納され、banking_yescreditcard.csv、banking_uncreditcard.csv、およびbanking_notcreditcard. csvはドライブDのtestフォルダーに格納されます。MaxComputeクライアントで、次のTunnel Uploadコマンドを実行してデータをインポートします。

tunnel upload banking.txt bank_data; tunnel upload D:\test\banking_yescreditcard.csv bank_data_pt/credit="yes"; tunnel upload D:\test\banking_uncreditcard.csv bank_data_pt/credit="unknown"; tunnel upload D:\test\banking_nocreditcard.csv bank_data_pt/credit="no";OKが返されると、データがインポートされます。

ステップ2: インポート結果を確認する

テーブルまたはパーティションにデータをインポートした後、テーブルまたはパーティション内のデータレコードの数がデータファイル内のデータレコードの数と一致しているかどうかを確認する必要があります。 数値に矛盾がある場合、データは完全にはインポートされません。

この例では、banking.txtは41,188レコード、banking_yescreditcard.csvは3レコード、banking_uncriditcard. csvは8,597レコード、banking_nocreditcard.csvは32,588レコードを含みます。 以下のコマンドを実行します。

select count(*) as num1 from bank_data;

select count(*) as num2 from bank_data_pt where credit="yes";

select count(*) as num3 from bank_data_pt where credit="unknown";

select count(*) as num4 from bank_data_pt where credit="no";次の情報が返されます。

-- The number of data records in bank_data.

+------------+

| num1 |

+------------+

| 41188 |

+------------+

-- The number of data records in the partition for which the value of credit is yes in bank_data_pt.

+------------+

| num2 |

+------------+

| 3 |

+------------+

-- The number of data records in the partition for which the value of credit is unknown in bank_data_pt.

+------------+

| num3 |

+------------+

| 8597 |

+------------+

-- The number of data records in the partition for which the value of credit is no in bank_data_pt.

+------------+

| num4 |

+------------+

| 32588 |

+------------+返される番号は、サンプルファイル内のデータレコードの数と一致します。 これは、サンプルファイルのデータがテーブルに完全にインポートされたことを示します。

次のステップ

データがMaxComputeテーブルにインポートされた後、MaxComputeクライアントでSQL文を実行してデータを処理し、コマンドを実行して結果データをエクスポートできます。 SQL文の実行方法と結果データのエクスポート方法の詳細については、「SQL文の実行と結果データのエクスポート」をご参照ください。