概要

AI サービス向け機械学習テクノロジーの開発には、データ、アルゴリズム、および計算能力が必要です。 Alibaba Cloud AI Acceleration ソリューションは、先進のデータセットと GPU アクセラレータを活用して、データ集約型アプリケーションのオーケストレーション、GPU インスタンス利用率の最適化、AI モデルのトレーニングと推論タスクの高速化を実現します。 Alibaba Cloud のカスタマイズ可能なクラウドネイティブ AI トレーニングプラットフォームを使用して、ビジネスニーズに合わせて AI インフラストラクチャと日常の O&M 作業の効率化を図ることもできます。

ホワイトペーパーのダウンロードソリューションの特長

-

コスト効率の高いアトミックな高速化

超高速の GPU アクセラレータ AIACC で AI モデルのトレーニングと推論を高速化し、コストを削減します。Stanford DAWN Deep Learning Benchmark によると、AI トレーニングモデルは 70%、推論は 2~3 倍高速化されています。

-

高効率で GPU を使用

同じ GPU のリソースを共有する GPU クラスタースケジューリングにより、クラスター内のすべての GPU の使用率を改善し、GPU 分離メカニズムによりアプリケーション間の干渉を解消します。

-

CNCF 公認のデータセットアクセラレータ

データ集約型アプリケーション向けの分散データセットオーケストレータおよびアクセラレータである Fluid を使用して、AI トレーニング中に発生するアクセス遅延、複数のデータソースによる複雑な並列アクセス、貧弱なデータ分離の問題を解決します。

-

カスタマイズ可能な AI トレーニングプラットフォーム

Alibaba cloud-native AI Suite を使用して、開発および O&M 用コンソールでクラウドネイティブ AI トレーニングプラットフォームを構築、カスタマイズし、深層学習のすべての段階で AI エンジニアリングの効率を向上できます。

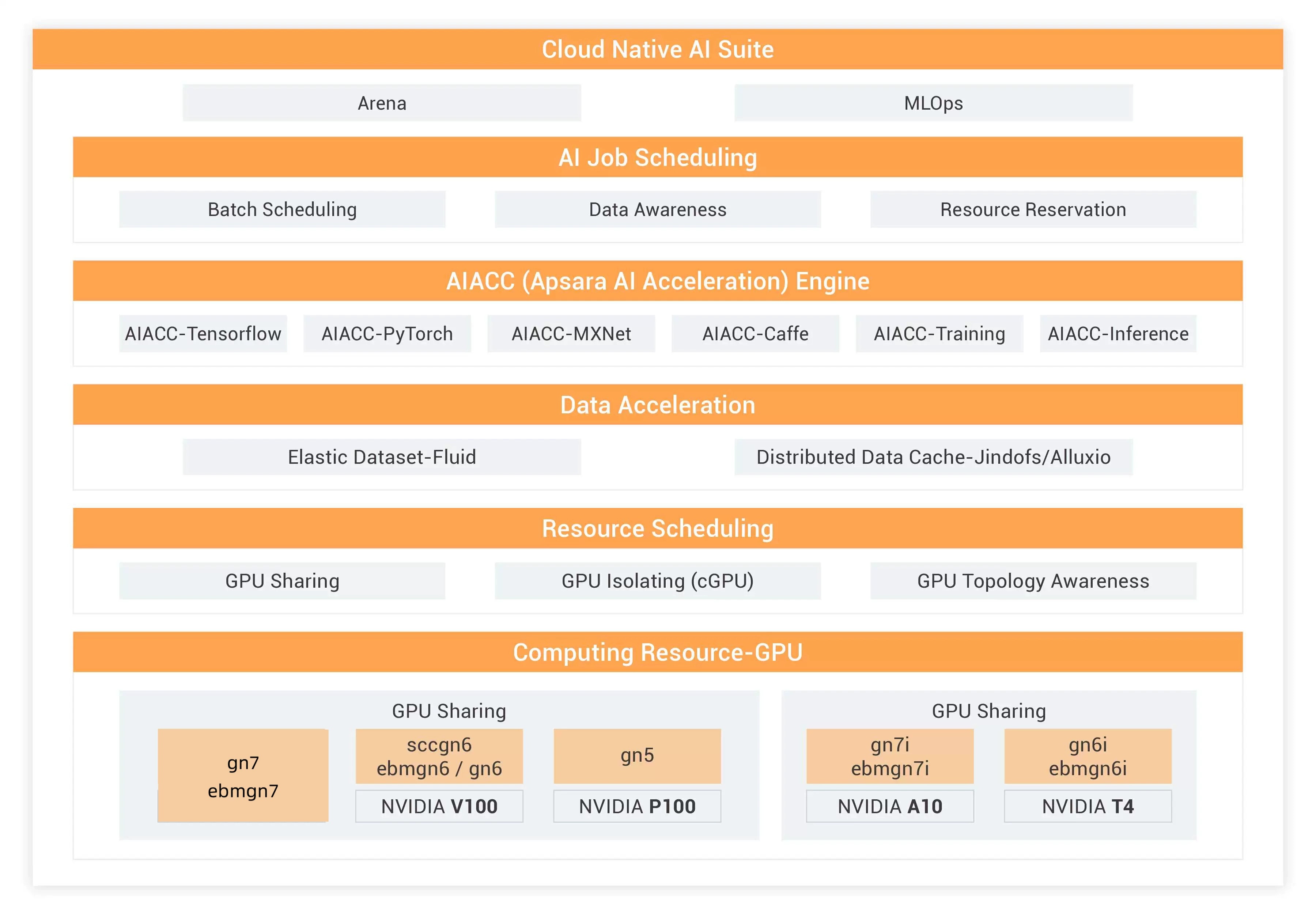

仕組み

Alibaba AI Acceleration ソリューションは、Cloud-Native AI Suiteレイヤー、AI Job Scheduling レイヤー、AI Data Acceleration レイヤー、AI Computing Acceleration Engine レイヤー、Resource Scheduling レイヤー、Computing Resource レイヤーで構成されています。 各レイヤーは、さまざまなシナリオの AI アプリケーション特性に基づいた特定のアクセラレーションソリューションに対応します。

Cloud-Native AI Suite:基盤となるサービスとコンポーネントで操作を簡素化し、GPUリソース使用率をモニタリングし、AI ジョブのログを収集および分析します。 コマンドラインを使用して AI ジョブを送信し、モデルトレーニングのスケジュールを確認できます。

AI Job Scheduling:AI ジョブをスケジュールして、モデルトレーニングを高速化し、GPU 使用率を高め、コストを削減します。

AIACC:Tensoflow、PyTorch、MXNet、Caffe などの深層学習フレームワークを活用して、画像の分類、画像認識、クリックスルー率予測、神経言語プログラミング、音声認識、顔認識などを実現します。

Data Acceleration: オンプレミスとは異なるデバイスにデータを保存し、モデルトレーニングを Alibaba Cloud で実行する、ストレージと計算リソースを分離したアーキテクチャを採用しています。 データは小さなファイルに保存され、送信とトレーニング効率を向上させるため、モデルトレーニングの前にウォームアップされます。

Resource Scheduling:GPU リソースを複数の AI ジョブで共有し、分散モデルトレーニングで単一の AI ジョブを複数の GPU で実行することで GPU の使用率を高め、コストを削減します。

Computing Resource - GPU:cGPU で GPU メモリと計算能力をコンテナとして管理およびスケジュールし、AI のトレーニングと推論を加速します。

ユースケース

画像認識

MXNet + SyncBN の分散トレーニング。 パフォーマンスが 50% 向上しました。

NLP

自然言語処理の分散トレーニング。 パフォーマンスは 6 倍になりました。

音声認識

音声の文字起こし。 生徒に送信され、生徒が話しているときに画面に表示されるテキスト。

CTR (クリックスルー率)

分散トレーニング。 パフォーマンスは 6.6 倍になりました。

特別オファー

File Storage NAS

ECS インスタンス、HPC、コンテナーサービスで使用するための、シンプルで拡張性が高く、オンデマンドで信頼性の高いネットワーク接続ストレージ

25 % オフ

• 従量課金

• 容量タイプ NAS ファイルシステム

• パフォーマンスタイプ NAS ファイルシステム

Container Registry

コンテナーイメージの安全な管理と効率的な配布を実現するエンタープライズクラスのプラットフォーム

• ACR EE Advanced Edition

• エンタープライズレベルのセキュリティ

• グローバルで配布を高速化

Platform for AI

データマイニングと分析のためのエンドツーエンドのプラットフォーム

• 視覚化されたインターフェース

• 100 を超えるアルゴリズムコンポーネント

• パワフルな計算能力

セキュリティとコンプライアンス

-

CSA STAR

CSA STAR -

ISO 27001

ISO 27001 -

SOC2 Type II Report

SOC2 Type II Report -

C5

C5 -

MLPS 2.0

MLPS 2.0 -

MTCS

MTCS

関連リソース

ホワイトペーパー

AI アクセラレーションホワイトペーパー

このホワイトペーパーでは、AI インフラストラクチャレイヤーのメカニズムと AI アクセラレーションのサポート方法のすべてについて解説します。

詳細を見る >ベストプラクティス

AI アクセラレーションのデモ - AIACC + ACK (Tensorflow)

このデモでは、TensorFlow 2.4 で ImageNet をトレーニングする際に ACK (K8s) で動作する AI アクセラレーションエンジンである AIACC を活用して AI トレーニングを高速化します。

詳細を見る >ベストプラクティス

AI アクセラレーションのデモ - AIACC (TensorFlow)

このソリューションは、TensorFlow 2.4 で ImageNet をトレーニングする際に AI アクセラレーションエンジンである AIACC を活用して AI トレーニングを高速化します。

詳細を見る >ベストプラクティス

AI アクセラレーションのデモ - AIACC + ACK (Pytorch)

このソリューションは、Pytorch 1.9 で ImageNet データをトレーニングする際に ACK (K8s) で動作する AI アクセラレーションエンジンである AIACC を活用して AI トレーニングを高速化します。

詳細を見る >オンラインコース

AIACC による深層学習タスクの高速化

このデモでは、既存の TensorFlow コードを一切変更せずに 18~74% の高速化を達成した例をご紹介します。標準的な MNIST の手書き数字のデータセットおよび新型コロナウイルスの胸部 X 線検査という 2 つの例から、AIACC の強みを見ていきます。

詳細を見る >